- 《算法》四学习——1.1节

进阶的Farmer

算法算法笔记

前言买了一本算法4,每天看一点,对每个小结来个学习总结,输出驱动输入。本篇笔记针对第一章基础1.1基础编程模型1.1节总结了相关的语法、语言特性和书中将会用到的库。笔记自己在编码中容易遗漏的点&&优先级比||高在开发中习惯了加括号,所以没注意到这点,教材上也有但是忘记了二分查找中计算mid=left+(right-left)/2这样计算可以有效避免(left+right)/2溢出答疑java无穷大

- 网关gateway学习总结

猪猪365

学习总结学习总结

一微服务概述:微服务网关就是一个系统!通过暴露该微服务的网关系统,方便我们进行相关的鉴权,安全控制,日志的统一处理,易于监控的相关功能!实现微服务网关技术都有哪些呢?1nginx:nginx是一个高性能的http和反向代理web的服务器,同事也提供了IMAP/POP3/SMTP服务.他可以支撑5万并发链接,并且cpu,内存等资源消耗非常的低,运行非常的稳定!2Zuul:Zuul是Netflix公司

- document获取元素的方法

小成语

js平时js

js学习总结----DOM获取元素的方法(8个)DOM:documentobjectmodel文档对象模型DOM就是描述整个html页面中节点关系的图谱,可以如下图理解在DOM中,提供了很多的获取元素的方法和之间关系的属性以及操作这些元素的方法。1、获取页面中元素的方法1)、document.getElementById('元素的ID')在整个文档中,通过元素的ID获取到这个元素对象(获取的是一个

- 10/24 每周学习总结5

木木ainiks

1024程序员节

1RecordingtheMoolympicsS#include#includeusingnamespacestd;typedeflonglongint_1;intn;structnode{int_1begin_b;int_1end_e;}a[300];boolcmp(nodea,nodeb){if(a.end_e==b.end_e)returna.begin_b>b.begin_b;return

- Day25_0.1基础学习MATLAB学习小技巧总结(25)——四维图形的可视化

非常规定义M

0.1基础学习MATLAB学习matlab开发语言SIMULINK数学建模

利用空闲时间把碎片化的MATLAB知识重新系统的学习一遍,为了在这个过程中加深印象,也为了能够有所足迹,我会把自己的学习总结发在专栏中,以便学习交流。参考书目:1、《MATLAB基础教程(第三版)(薛山)》2、《MATLABR2020a完全自学一本通》之前的章节都是基础的数据运算用法,对于功课来说更加重要的内容是建模、绘图、观察数据趋势,接下来我会结合自己的使用经验,来为大家分享绘图、建模使用的小

- 幸福感恩日记第15篇

豫豫妈

2018.7.3豫豫妈早课心得:1、这个世界外面没有别人,只有自己。一切都是自己的问题。2、每个人都不是完美的,学会转念,高效沟通。3、讲好每句话也是阴阳并存的,一阴一阳之谓道。4、坚持读经,早起学习,记笔记及时内化,学以致用才能正确的引导孩子。5、一个工具,二个方法,一个核心;五个步骤,僵化学习、固化学习、内化学习、优化学习、变化学习运用易经思维进行学习总结。方法:如果----那么----有点像

- 【驻村】费晓琴2020.04.10工作日志和学习总结

aaf247918939

工作日志1、5:20好视通唱班歌签到传家书2、读经典小打卡,驻村群读小村大道3、练八锻锦,练习4、下午宋书记、尹老师、小村大道作者郑旺盛和村两位来看望回村的志愿者学习感悟生活中的纷纷扰扰,可归结为一个字,争!这个世界的吵门市,喧嚣,摩擦,抱怨,勾心斗角,尔虞我诈,都源自争!在日常生活中,心胸开阔一点,就争不起来,得失看轻一点,就争不起来,功利心淡一点,就争不起来,为他人考虑略多一点,就更争不起来,

- 机器学习 VS 表示学习 VS 深度学习

Efred.D

人工智能机器学习深度学习人工智能

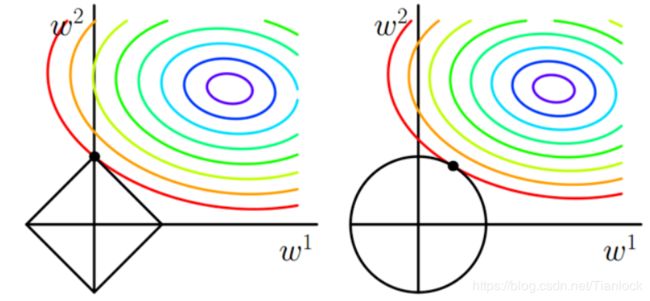

文章目录前言一、机器学习是什么?二、表示学习三、深度学习总结前言本文主要阐述机器学习,表示学习和深度学习的原理和区别.一、机器学习是什么?机器学习(machinelearning),是从有限的数据集中学习到一定的规律,再把学到的规律应用到一些相似的样本集中做预测.机器学习的历史可以追溯到20世纪40年代McCulloch提出的人工神经元网络,目前学界大致把机器学习分为传统机器学习和机器学习两个类别

- Docker部署单点es

Javaismymorning

ES学习笔记dockerelasticsearch

前言该笔记是根据B站上黑马SpringCloud学习总结的一、ES是什么?Elasticsearch是一个分布式、高扩展、高实时的搜索与数据分析引擎。它能很方便的使大量数据具有搜索、分析和探索的能力。充分利用Elasticsearch的水平伸缩性,能使数据在生产环境变得更有价值二、Docker部署ES步骤1.创建网络因为还要部署Kibana,实现es和Kibana关联,创建一个网络Kibana是为

- 数据结构 顺序表学习总结

sumandavg

数据结构数据结构1024程序员节

数据结构是计算机存储、组织数据的方式。数据结构是指相互之间存在一种或多种特定关系的数据元素的集合。通常情况下,精心选择的数据结构可以带来更高的运行或者存储效率。目录前言1.顺序表介绍1.1什么是顺序表1.2顺序表的性质1.3顺序表的构成1.4顺序表的框架代码(C++版)2.顺序表的操作2.1初始化顺序表2.1.1步骤2.1.2代码展示2.2顺序表的插入2.2.1步骤2.2.2代码展示2.3顺序表的

- 绘本讲师训练营【48期】1/21阅读原创《学习总结》

优丫漫绘本馆丹丹

48005王亚丹——2019年11月中旬第一次听到有绘本讲师培训班的时候就依然决定报名,于是就有了2020年1月1日的相遇。3天的时间又长又很短,长的是身体不佳,短的是学习时间太短。第一日上午首先是幽默的班班组织大家自我介绍。其次帅气智慧的阿渡老师从《如何阅读图画书》开始给我们分享了绘本基础理论知识:由最早的绘本到图画书进入大陆的历程;如何读绘本;如何选绘本;如何创作绘本剧及设计绘本活动、延伸等。

- (学习总结15)C++11小语法与拷贝问题

瞌睡不来

学习c++c++STL

C++11小语法与拷贝问题auto关键字范围forinitializer_list深拷贝与浅拷贝写时拷贝以下代码环境为VS2022C++。auto关键字在早期C/C++中auto的含义是:使用auto修饰的变量,是具有自动存储器的局部变量,不过一般都会隐藏,导致后来不重要了。C++11中,标准委员会赋予了auto全新的含义,即:auto不再是一个存储类型指示符,而是作为一个新的类型指示符来指示编译

- 【战盟第二期智家集训班】

房康

沈阳-有住-浑南店-房康12月6日一、学习总结:1.今天的主要学习内容是上午刘总给我们讲解了未来的发展方向和一些未来的机遇,让我对做海尔智家更有信心,山丽丽老师讲解的企业文化也让我讲解到我们海尔是一个非常诚信的企业和为用户着想的企业只有这样企业才能做的更大更强走的更长远。蒋老师讲的卡萨帝品牌也让我了解到卡萨帝不单单是一件电器也是一件艺术品。2.通过下午的系统学习让我懂得了如何做一个合格的智家设计师

- 我们在进行前后端联调的时候 如何避免数据丢失 拿不到返回数据 查看不了状态信息等问题?

朱道阳

底层原理面试八股回归前端npmgitpython

最近在进行前后端联调开发的全栈开发工作但是这时候会出现很多问题比如说前端拿不到数据获得的状态码可能是正确的传的值却是null我进行了学习总结出一下几点一、数据校验前端程序员必须对后端提供的数据进行严格的数据校验。数据校验的目的是确保接收到的数据符合预期的格式和类型。在JavaScript中,可以使用typeof操作符或Array.isArray()方法进行基本的类型检查。更复杂的数据结构,可以使用

- JavaScript之OOP基础概念学习总结一:scopes

gaoshu883

这个系列的文章是去年在搭架完静态博客后撰写的(博客已经不再维护啦,哦还能访问)↓最近在探究JavaScript中的scopes概念。经过一番研究,我觉得要从Interpreter的角度,才能更好地理解这个概念。毕竟程序员主要是编写指令,而Interpreter则是把程序员编写的代码一行一行读下去并翻译出来(执行出来),最终结果就会直接反映在Web浏览器的页面上。不过还要注意的是,并不是所有的sco

- 《分科学习总结暨学员分享会》之感

肖丽好

图片发自App今晚,很荣幸可以在线上跟全国各地的青椒伙伴们分享自己的学习心得。很兴奋,也很紧张。图片发自App这,是一份认可,是一种荣誉,同时也是一股压力。还是有些许遗憾吧,因为紧张导致多处卡壳、口误。虽然老师们都给予了极大的鼓励与支持,但是这并不能作为自己准备不够充分的心安理得的托辞。看到那么多第一次视屏分享的伙伴们在镜头前是那么的从容不迫,再反观自己的手足无措,这才真的发现了自己跟真正的“优秀

- Python暑假学习总结

小龙夏

python学习

通过系统地学习Python基础知识、函数、高级特性、函数式编程、模块和面向对象编程等方面,我对Python有了更深入的理解和掌握。在这篇学习总结中,我将分享我在学习Python过程中的体会和经验。一、python基础1、输出print(),输入input(),#注释;2、了解了数据类型和变量(and,or,not)、字符串和编码、使用list和tuple、条件判断(if...elif...else

- 浏览器渲染流程解析

dqqbl

前言大家可能经常会听到css动画比js动画性能更好这样的论断,或者是“硬件加速”,“层提升”这样的字眼;要了解这些内容就需要对浏览器的渲染流程有个大致的了解,本文就是我个人对这些内容的一个总结梳理需要注意的是:本文仅个人学习总结梳理,如有错漏,望指正本文以谷歌浏览器Blink内核为例,参考内容链接大多需要科学上网随着谷歌浏览器的更新迭代,有些渲染流程或对象名词可能发生变化(如,RenderObje

- 学会总结

Fiona张芳

昨晚在区域经理面前做了场分享,结束后主任要求写篇学习总结,这样我的机会便来了,我在肯德基边啃汉堡,边一手拿着手机敲字,学习总结很快的时间便完成了,本想修改下的,手一滑发送出去了,算了就发出去吧,长舒一口气,又完成了一件事项。后面看到主任留言总结写的很好,继续加油。今天早晨八点钟周例会,主任特意说了我们去恒隆学习的情况,说我们的学习总结写的非常好,特别是张芳的,还把我的学习总结读了出来,例外说了句,

- Python自动化:Python操作Excel的多种方式Pandas+openpyxl+xlrd

长风清留扬

Pythonexcelpythonpandas自动化Python办公自动化数据分析开发语言

在Python中,操作Excel数据通常可以通过几个流行的库来实现,比如pandas、openpyxl、xlrd等。下面会分别介绍这三个流行库来实现对Excel的操作。博客主页:长风清留扬-CSDN博客每天更新大数据相关方面的技术,分享自己的实战工作经验和学习总结,尽量帮助大家解决更多问题和学习更多新知识,欢迎评论区分享自己的看法感谢大家点赞收藏⭐评论推荐阅读:Python入门最全基础Python

- 6月14日关于条文11.73至11.76讲解及天门冬的药性一学习总结(韦爱琪)

韦爱琪

当归四逆汤的主证抓法:1.有没有血虚,有当归四逆汤证的话,血循环一定很差,尤其末梢,会有嘴唇惨白,脸色不红润。2.体质是冷的,也有例外是发炎的情况,什么红斑狼疮,硬皮病。3.抓痛。4.推扩用法:坐骨神经痛,腰痛不能弯腰,肝病到水肿,以及各类循环到末梢的问题,什么皮肤病,起疹子,水肿。过敏,淋巴坨拉。厥阴篇条文11.73至11.76讲解1.脉忽然沉掉,手脚发冷,下利清谷,发高烧脉沉用四逆汤。2.高烧

- Maxwell 学习总结

暮色里de白雪檐

#maxwellbinlogmaxwell数据库mysqlkafka

修改my.cnf文件,配置binlog修改/etc/my.cnf文件,在[mysqld]模块下添加如下内容:[mysqld]server_id=1#binlog文件前缀log-bin=mysql-bin#binlog模式binlog_format=row#需要生成binlog的库,有几个库需要生成binlog则添加几行,如果不做该配置,则所有库都会生成binlogbinlog-do-db=sys_

- 数学建模之插值算法

阿米诺s

数学建模数学建模算法

注:本文面向应用,参考了清风大大的资料以及司守奎老师的《数学建模算法与应用》,属作者的个人学习总结。一.算法应用背景当已知函数点非常少的时候,我们经常要模拟产生一些新的函数值来支撑后续数据分析。这就是插值算法的应用目的。*插值算法还可以用来实现短期预测,但我们往往使用拟合算法以及时间序列算法来实现预测。二.插值问题的分类插值问题一般分为一维插值问题和多维插值问题。三.插值法(一)数学定义设函数f(

- Django----Form的来龙去脉(-)使用篇

墨痕_777

python

Django----Form的来龙去脉(-)使用篇(注:个人学习总结,仅供参考)####Form表单的功能自动生成HTML表单元素检查表单数据的合法性如果验证错误,重新显示表单(数据不会重置)数据类型转换(字符类型的数据转换成相应的Python类型)####Form相关的对象包括Widget:用来渲染成HTML元素的工具,如:forms.Textarea对应HTML中的标签Field:Form对象

- FPGA学习总结1 - 电源引脚

那小妞好白

fpga开发学习笔记fpga

FPGA学习总结1-电源引脚文章目录前言1.VCCINT:内核电压2.VCCBRAM:BlockRAM电压3.VCCAUX:辅助电压4.VCCAUX_IO_G#:辅助IO电压5.VCCO_#:IO电压6.VCCBATT_0:BatteryBackupSupply7.MGTAVCC_G#:8.MGTAVTT_G#:9.MGTVCCAUX_G#:10.RSVDGND:IO电压11.VREF:12.Su

- 小晓智慧连载3《养成好习惯之――助人为乐》

小晓智慧会发光

帮助他人,是快速成长的捷径。晚上下班,00后小朋友发来信息,实名感谢,并与我分享收获。学习总结规划目标改变习惯立马行动自从有了利他思维,就改变了我事不关己的态度。做人,有格局,有大爱,才能有所成就。

- Vue3学习总结-v-if与v-show的使用案例和区别

风清扬雨

前端Vue3学习vue.js前端前端框架

Vue3实战:v-if与v-show在用户界面切换中的应用在Vue.js中,v-if和v-show是两种常用的条件渲染指令,它们允许我们根据表达式的值来动态地显示或隐藏DOM元素。这两种指令虽然看起来相似,但在内部实现和性能方面有所不同。下面我们将通过一个具体的案例来演示如何在Vue3中合理使用v-if和v-show,并探讨它们在实际项目中的应用。案例背景假设我们需要构建一个简单的待办事项列表应用

- golang学习总结--函数

小罗tongxue

golanggolang

1.go函数声明语法:func函数名(参数列表)(返回值列表){}funcadd()(){}2.golang函数特点(1)不支持重载:一个包中不能有两个函数名称一样的函数,即使参数列表不同(2)多返回值(3)匿名函数(4)函数是一种类型,也可以赋值给一个变量(5)函数名大小写敏感,函数名首字母表示该函数可跨包调用,小写表示不可跨包调用packagemainimport("fmt")typeop_f

- 内蒙古王顺莲参加湾柳树网络学院第四期文化自信与乡村振兴网络学习班学习总结!

73b6cb599636

内蒙古王顺莲参加湾柳树网络学院第四期文化自信与乡村振兴网络学习班学习总结!尊敬的宋瑞书记!尊敬赵宗瑞老师一家!尊敬的尹子文老师!王国霞老师!尊敬的湾柳树的所有义工老师!尊敬的第四期网络学习班的所有老师大家好!首先我要感恩宋瑞书记!感恩尹子文老师!感恩王国霞老师!是你们的大爱付出!为我们大家搭建了这么好的网络学习平台。引领大家共同学习共同成长,使很多家人们有了转变和收获。通过这些日子的网络学习使自己

- CSAPP全书学习总结

%d%d2

体系结构学习

CSAPP(1.计算机系统漫游)学习笔记-CSDN博客CSAPP(第二章信息的表示和处理,附上datalab解析_datalab调整数据位置-CSDN博客CSAPP(第三章:程序的机器级表示-CSDN博客

- VMware Workstation 11 或者 VMware Player 7安装MAC OS X 10.10 Yosemite

iwindyforest

vmwaremac os10.10workstationplayer

最近尝试了下VMware下安装MacOS 系统,

安装过程中发现网上可供参考的文章都是VMware Workstation 10以下, MacOS X 10.9以下的文章,

只能提供大概的思路, 但是实际安装起来由于版本问题, 走了不少弯路, 所以我尝试写以下总结, 希望能给有兴趣安装OSX的人提供一点帮助。

写在前面的话:

其实安装好后发现, 由于我的th

- 关于《基于模型驱动的B/S在线开发平台》源代码开源的疑虑?

deathwknight

JavaScriptjava框架

本人从学习Java开发到现在已有10年整,从一个要自学 java买成javascript的小菜鸟,成长为只会java和javascript语言的老菜鸟(个人邮箱:

[email protected])

一路走来,跌跌撞撞。用自己的三年多业余时间,瞎搞一个小东西(基于模型驱动的B/S在线开发平台,非MVC框架、非代码生成)。希望与大家一起分享,同时有许些疑虑,希望有人可以交流下

平台

- 如何把maven项目转成web项目

Kai_Ge

mavenMyEclipse

创建Web工程,使用eclipse ee创建maven web工程 1.右键项目,选择Project Facets,点击Convert to faceted from 2.更改Dynamic Web Module的Version为2.5.(3.0为Java7的,Tomcat6不支持). 如果提示错误,可能需要在Java Compiler设置Compiler compl

- 主管???

Array_06

工作

转载:http://www.blogjava.net/fastzch/archive/2010/11/25/339054.html

很久以前跟同事参加的培训,同事整理得很详细,必须得转!

前段时间,公司有组织中高阶主管及其培养干部进行了为期三天的管理训练培训。三天的课程下来,虽然内容较多,因对老师三天来的课程内容深有感触,故借着整理学习心得的机会,将三天来的培训课程做了一个

- python内置函数大全

2002wmj

python

最近一直在看python的document,打算在基础方面重点看一下python的keyword、Build-in Function、Build-in Constants、Build-in Types、Build-in Exception这四个方面,其实在看的时候发现整个《The Python Standard Library》章节都是很不错的,其中描述了很多不错的主题。先把Build-in Fu

- JSP页面通过JQUERY合并行

357029540

JavaScriptjquery

在写程序的过程中我们难免会遇到在页面上合并单元行的情况,如图所示

如果对于会的同学可能很简单,但是对没有思路的同学来说还是比较麻烦的,提供一下用JQUERY实现的参考代码

function mergeCell(){

var trs = $("#table tr");

&nb

- Java基础

冰天百华

java基础

学习函数式编程

package base;

import java.text.DecimalFormat;

public class Main {

public static void main(String[] args) {

// Integer a = 4;

// Double aa = (double)a / 100000;

// Decimal

- unix时间戳相互转换

adminjun

转换unix时间戳

如何在不同编程语言中获取现在的Unix时间戳(Unix timestamp)? Java time JavaScript Math.round(new Date().getTime()/1000)

getTime()返回数值的单位是毫秒 Microsoft .NET / C# epoch = (DateTime.Now.ToUniversalTime().Ticks - 62135

- 作为一个合格程序员该做的事

aijuans

程序员

作为一个合格程序员每天该做的事 1、总结自己一天任务的完成情况 最好的方式是写工作日志,把自己今天完成了什么事情,遇见了什么问题都记录下来,日后翻看好处多多

2、考虑自己明天应该做的主要工作 把明天要做的事情列出来,并按照优先级排列,第二天应该把自己效率最高的时间分配给最重要的工作

3、考虑自己一天工作中失误的地方,并想出避免下一次再犯的方法 出错不要紧,最重

- 由html5视频播放引发的总结

ayaoxinchao

html5视频video

前言

项目中存在视频播放的功能,前期设计是以flash播放器播放视频的。但是现在由于需要兼容苹果的设备,必须采用html5的方式来播放视频。我就出于兴趣对html5播放视频做了简单的了解,不了解不知道,水真是很深。本文所记录的知识一些浅尝辄止的知识,说起来很惭愧。

视频结构

本该直接介绍html5的<video>的,但鉴于本人对视频

- 解决httpclient访问自签名https报javax.net.ssl.SSLHandshakeException: sun.security.validat

bewithme

httpclient

如果你构建了一个https协议的站点,而此站点的安全证书并不是合法的第三方证书颁发机构所签发,那么你用httpclient去访问此站点会报如下错误

javax.net.ssl.SSLHandshakeException: sun.security.validator.ValidatorException: PKIX path bu

- Jedis连接池的入门级使用

bijian1013

redisredis数据库jedis

Jedis连接池操作步骤如下:

a.获取Jedis实例需要从JedisPool中获取;

b.用完Jedis实例需要返还给JedisPool;

c.如果Jedis在使用过程中出错,则也需要还给JedisPool;

packag

- 变与不变

bingyingao

不变变亲情永恒

变与不变

周末骑车转到了五年前租住的小区,曾经最爱吃的西北面馆、江西水饺、手工拉面早已不在,

各种店铺都换了好几茬,这些是变的。

三年前还很流行的一款手机在今天看起来已经落后的不像样子。

三年前还运行的好好的一家公司,今天也已经不复存在。

一座座高楼拔地而起,

- 【Scala十】Scala核心四:集合框架之List

bit1129

scala

Spark的RDD作为一个分布式不可变的数据集合,它提供的转换操作,很多是借鉴于Scala的集合框架提供的一些函数,因此,有必要对Scala的集合进行详细的了解

1. 泛型集合都是协变的,对于List而言,如果B是A的子类,那么List[B]也是List[A]的子类,即可以把List[B]的实例赋值给List[A]变量

2. 给变量赋值(注意val关键字,a,b

- Nested Functions in C

bookjovi

cclosure

Nested Functions 又称closure,属于functional language中的概念,一直以为C中是不支持closure的,现在看来我错了,不过C标准中是不支持的,而GCC支持。

既然GCC支持了closure,那么 lexical scoping自然也支持了,同时在C中label也是可以在nested functions中自由跳转的

- Java-Collections Framework学习与总结-WeakHashMap

BrokenDreams

Collections

总结这个类之前,首先看一下Java引用的相关知识。Java的引用分为四种:强引用、软引用、弱引用和虚引用。

强引用:就是常见的代码中的引用,如Object o = new Object();存在强引用的对象不会被垃圾收集

- 读《研磨设计模式》-代码笔记-解释器模式-Interpret

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

package design.pattern;

/*

* 解释器(Interpreter)模式的意图是可以按照自己定义的组合规则集合来组合可执行对象

*

* 代码示例实现XML里面1.读取单个元素的值 2.读取单个属性的值

* 多

- After Effects操作&快捷键

cherishLC

After Effects

1、快捷键官方文档

中文版:https://helpx.adobe.com/cn/after-effects/using/keyboard-shortcuts-reference.html

英文版:https://helpx.adobe.com/after-effects/using/keyboard-shortcuts-reference.html

2、常用快捷键

- Maven 常用命令

crabdave

maven

Maven 常用命令

mvn archetype:generate

mvn install

mvn clean

mvn clean complie

mvn clean test

mvn clean install

mvn clean package

mvn test

mvn package

mvn site

mvn dependency:res

- shell bad substitution

daizj

shell脚本

#!/bin/sh

/data/script/common/run_cmd.exp 192.168.13.168 "impala-shell -islave4 -q 'insert OVERWRITE table imeis.${tableName} select ${selectFields}, ds, fnv_hash(concat(cast(ds as string), im

- Java SE 第二讲(原生数据类型 Primitive Data Type)

dcj3sjt126com

java

Java SE 第二讲:

1. Windows: notepad, editplus, ultraedit, gvim

Linux: vi, vim, gedit

2. Java 中的数据类型分为两大类:

1)原生数据类型 (Primitive Data Type)

2)引用类型(对象类型) (R

- CGridView中实现批量删除

dcj3sjt126com

PHPyii

1,CGridView中的columns添加

array(

'selectableRows' => 2,

'footer' => '<button type="button" onclick="GetCheckbox();" style=&

- Java中泛型的各种使用

dyy_gusi

java泛型

Java中的泛型的使用:1.普通的泛型使用

在使用类的时候后面的<>中的类型就是我们确定的类型。

public class MyClass1<T> {//此处定义的泛型是T

private T var;

public T getVar() {

return var;

}

public void setVa

- Web开发技术十年发展历程

gcq511120594

Web浏览器数据挖掘

回顾web开发技术这十年发展历程:

Ajax

03年的时候我上六年级,那时候网吧刚在小县城的角落萌生。传奇,大话西游第一代网游一时风靡。我抱着试一试的心态给了网吧老板两块钱想申请个号玩玩,然后接下来的一个小时我一直在,注,册,账,号。

彼时网吧用的512k的带宽,注册的时候,填了一堆信息,提交,页面跳转,嘣,”您填写的信息有误,请重填”。然后跳转回注册页面,以此循环。我现在时常想,如果当时a

- openSession()与getCurrentSession()区别:

hetongfei

javaDAOHibernate

来自 http://blog.csdn.net/dy511/article/details/6166134

1.getCurrentSession创建的session会和绑定到当前线程,而openSession不会。

2. getCurrentSession创建的线程会在事务回滚或事物提交后自动关闭,而openSession必须手动关闭。

这里getCurrentSession本地事务(本地

- 第一章 安装Nginx+Lua开发环境

jinnianshilongnian

nginxluaopenresty

首先我们选择使用OpenResty,其是由Nginx核心加很多第三方模块组成,其最大的亮点是默认集成了Lua开发环境,使得Nginx可以作为一个Web Server使用。借助于Nginx的事件驱动模型和非阻塞IO,可以实现高性能的Web应用程序。而且OpenResty提供了大量组件如Mysql、Redis、Memcached等等,使在Nginx上开发Web应用更方便更简单。目前在京东如实时价格、秒

- HSQLDB In-Process方式访问内存数据库

liyonghui160com

HSQLDB一大特色就是能够在内存中建立数据库,当然它也能将这些内存数据库保存到文件中以便实现真正的持久化。

先睹为快!

下面是一个In-Process方式访问内存数据库的代码示例:

下面代码需要引入hsqldb.jar包 (hsqldb-2.2.8)

import java.s

- Java线程的5个使用技巧

pda158

java数据结构

Java线程有哪些不太为人所知的技巧与用法? 萝卜白菜各有所爱。像我就喜欢Java。学无止境,这也是我喜欢它的一个原因。日常

工作中你所用到的工具,通常都有些你从来没有了解过的东西,比方说某个方法或者是一些有趣的用法。比如说线程。没错,就是线程。或者确切说是Thread这个类。当我们在构建高可扩展性系统的时候,通常会面临各种各样的并发编程的问题,不过我们现在所要讲的可能会略有不同。

- 开发资源大整合:编程语言篇——JavaScript(1)

shoothao

JavaScript

概述:本系列的资源整合来自于github中各个领域的大牛,来收藏你感兴趣的东西吧。

程序包管理器

管理javascript库并提供对这些库的快速使用与打包的服务。

Bower - 用于web的程序包管理。

component - 用于客户端的程序包管理,构建更好的web应用程序。

spm - 全新的静态的文件包管

- 避免使用终结函数

vahoa.ma

javajvmC++

终结函数(finalizer)通常是不可预测的,常常也是很危险的,一般情况下不是必要的。使用终结函数会导致不稳定的行为、更差的性能,以及带来移植性问题。不要把终结函数当做C++中的析构函数(destructors)的对应物。

我自己总结了一下这一条的综合性结论是这样的:

1)在涉及使用资源,使用完毕后要释放资源的情形下,首先要用一个显示的方