机器学习-SVM

SVM(Support Vector Machine)指的是支持向量机,是常见的一种判别方法。在机器学习领域,是一个有监督的学习模型,通常用来进行模式识别、分类以及回归分析。它在解决小样本、非线性及高维模式识别中表现出许多特有的优势,并能够推广应用到函数拟合等其他其他问题中。

- 线性可分的情况

最简单的情况,线性可分的SVM。对于二分类问题,线性分类器用一个超平面将两类样本分开,对于二维平面,这个超平面是一条直线。线性分类器的判别函数为:

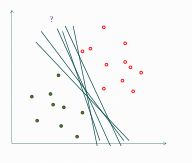

其中,w为权重向量,b为偏置项,是一个标量。一般情况下,给定一组训练样本可以得到不止一个线性分类器,下图就是一个例子:

为了得到最好的超平面,对训练数据集找到几何间隔最大的超平面,意味着以充分大的确信度对训练数据分类。

对于给定的训练数据T和超平面(w,b),对于样本点(x,y)到超平面的距离为:

其中y只取{+1,-1}这两个值,代表着分类标签。为了得到最好的超平面,距离越小越好,对所有的数据(i=1,2,3...N),则有:

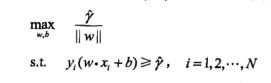

所以SVM的优化目标函数可以表示为:

对上式进行变换可以写成:

对齐进行归一化处理,则最终可以表示为:

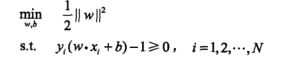

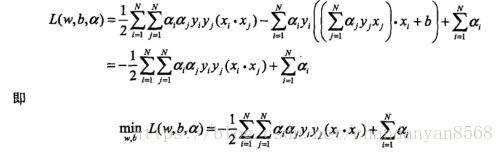

为了求上式的最优解,可以将上市表示为拉格朗日的方式为:

将上面的结果代入![]() ,有:

,有:

对上求得![]() ,从而得到w,b进而得到分离超平面w*x+b=0

,从而得到w,b进而得到分离超平面w*x+b=0

分类决策函数:![]()

2. SVM的软间隔及核函数

SVM的软间隔和核函数主要解决训练数据不是线性可分的情况,软间隔最大化指的在每个训练样本中引入一个松弛变量对约束进行更改;核函数通过函数映射到一个高维的空间,从而原来在低维度不是线性可分的数据在高维下是线性可分的。

3. SVM的应用举例

使用sklearn中的包对iris数据进行分类

http://scikit-learn.org/dev/modules/svm.html#svm-classification

#!/usr/bin/python

# -*- coding:utf-8 -*-

import numpy as np

import pandas as pd

import matplotlib as mpl

import matplotlib.pyplot as plt

from sklearn import svm

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

if __name__ == "__main__":

iris_feature = '花萼长度', '花萼宽度', '花瓣长度', '花瓣宽度'

path = './iris.data' # 数据文件路径

data = pd.read_csv(path, header=None)

x, y = data[[0, 1]], pd.Categorical(data[4]).codes

x_train, x_test, y_train, y_test = train_test_split(x, y, random_state=1, train_size=0.6)

# 分类器

clf = svm.SVC(C=0.1, kernel='linear', decision_function_shape='ovr')

# clf = svm.SVC(C=0.8, kernel='rbf', gamma=20, decision_function_shape='ovr')

clf.fit(x_train, y_train.ravel())

# 准确率

print(clf.score(x_train, y_train)) # 精度

print('训练集准确率:', accuracy_score(y_train, clf.predict(x_train)))

print(clf.score(x_test, y_test))

print('测试集准确率:', accuracy_score(y_test, clf.predict(x_test)))

# decision_function

print(x_train[:5])

print('decision_function:\n', clf.decision_function(x_train))

print('\npredict:\n', clf.predict(x_train))

# 画图

x1_min, x2_min = x.min()

x1_max, x2_max = x.max()

x1, x2 = np.mgrid[x1_min:x1_max:500j, x2_min:x2_max:500j] # 生成网格采样点

grid_test = np.stack((x1.flat, x2.flat), axis=1) # 测试点

grid_hat = clf.predict(grid_test) # 预测分类值

grid_hat = grid_hat.reshape(x1.shape) # 使之与输入的形状相同

mpl.rcParams['font.sans-serif'] = ['SimHei']

mpl.rcParams['axes.unicode_minus'] = False

cm_light = mpl.colors.ListedColormap(['#A0FFA0', '#FFA0A0', '#A0A0FF'])

cm_dark = mpl.colors.ListedColormap(['g', 'r', 'b'])

plt.figure(facecolor='w')

plt.pcolormesh(x1, x2, grid_hat, cmap=cm_light)

plt.scatter(x[0], x[1], c=y, edgecolors='k', s=50, cmap=cm_dark) # 样本

plt.scatter(x_test[0], x_test[1], s=120, facecolors='none', zorder=10) # 圈中测试集样本

plt.xlabel(iris_feature[0], fontsize=13)

plt.ylabel(iris_feature[1], fontsize=13)

plt.xlim(x1_min, x1_max)

plt.ylim(x2_min, x2_max)

plt.title('鸢尾花SVM二特征分类', fontsize=16)

plt.grid(b=True, ls=':')

plt.tight_layout(pad=1.5)

plt.show()