- DataWhale 二月组队学习-深入浅出pytorch-Task04

-273.15K

DataWhale组队学习学习pytorch人工智能

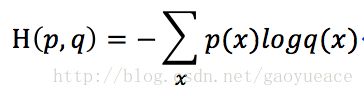

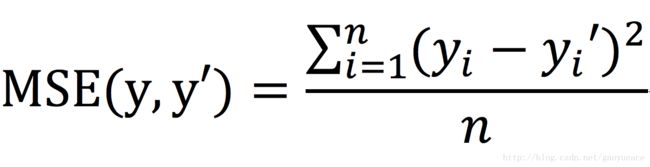

一、自定义损失函数1.损失函数的作用与自定义意义在深度学习中,损失函数(LossFunction)用于衡量模型预测结果与真实标签之间的差异,是模型优化的目标。PyTorch内置了多种常用损失函数(如交叉熵损失nn.CrossEntropyLoss、均方误差nn.MSELoss等)。但在实际任务中,可能需要针对特定问题设计自定义损失函数,例如:处理类别不平衡问题(如加权交叉熵)实现特殊业务需求(如对

- 大模型核心概念 | 嵌入模型(Embedding)、向量模型(Vector Model)

一、核心概念解析1.1嵌入模型(Embedding)作为AI领域的核心基础技术,嵌入模型通过将非结构化数据映射为低维稠密向量,实现语义特征的深度捕捉:文本嵌入:如将语句转换为1536维向量,使"机器学习"与"深度学习"的向量余弦相似度达0.92跨模态嵌入:支持图像与文本的联合向量空间映射,如CLIP模型实现文图互搜1.2向量模型(VectorModel)作为嵌入技术的下游应用体系,主要包含两大方向

- Python实现神经网络算法指南

代码编织匠人

python神经网络算法

Python实现神经网络算法指南神经网络是一种模拟人脑神经元结构进行信息处理的机器学习算法。在深度学习领域中,神经网络是最为强大的算法之一。Python作为一门简单易学的编程语言,也成为了许多人选择实现神经网络算法的首选语言。在本篇文章中,我们将通过Python代码来实现神经网络算法。导入必要的库为了实现神经网络算法,我们需要导入一些必要的Python库,包括numpy和matplotlib。其中

- 用Python实现神经网络(四)

使用多层神经网络我们展示如何用TensorFlow构建多层神经网络###低出生率数据LowBirthratedata:#Columns Variable Abbreviation#---------------------------------------------------------------------#Lo

- 基于DTLC-AEC与DTLN的轻量级实时语音增强系统设计与实现

神经网络15044

仿真模型神经网络机器学习图像处理cnn人工智能机器人

基于DTLC-AEC与DTLN的轻量级实时语音增强系统设计与实现前些天发现了一个巨牛的人工智能学习网站,通俗易懂,风趣幽默,忍不住分享一下给大家。点击跳转到网站。1.引言在当今的互联网通信时代,实时语音通信已成为人们日常生活中不可或缺的一部分。然而,语音通信质量常常受到回声、背景噪声等因素的严重影响。为了解决这些问题,我们需要高效的语音增强技术。本文将详细介绍如何将DTLC-AEC(深度学习回声消

- 第 20 课时:GPU 管理和 Device Plugin 工作机制(车漾)

阿里云云原生

CNCFX阿里巴巴云原生技术公开课阿里云KubernetesCNCF专家团队CNCF专家团队CNCF专家团队Kubernetes

本文将主要分享以下几个方面的内容:需求来源GPU的容器化Kubernetes的GPU管理工作原理课后思考与实践需求来源2016年,随着AlphaGo的走红和TensorFlow项目的异军突起,一场名为AI的技术革命迅速从学术圈蔓延到了工业界,所谓AI革命从此拉开了帷幕。经过三年的发展,AI有了许许多多的落地场景,包括智能客服、人脸识别、机器翻译、以图搜图等功能。其实机器学习或者说是人工智能,并不是

- 目标检测-YOLOv5

wydxry

深度学习目标检测YOLO人工智能深度学习

YOLOv5介绍YOLOv5是YOLO系列的第五个版本,由Ultralytics团队发布。虽然YOLOv5并非JosephRedmon原团队发布,但它在YOLOv4的基础上进行了重要的优化和改进,成为了深度学习目标检测领域中的热门模型之一。YOLOv5的优势不仅体现在其性能上,还包括其简洁易用、部署便捷的特点。相较于YOLOv4,YOLOv5对于代码框架的重构、推理速度的提升,以及模型的轻量化等方

- 【DW11月-深度学习】Task03前馈神经网络

沫2021

参考链接:https://datawhalechina.github.io/unusual-deep-learning/#/4.%E5%89%8D%E9%A6%88%E7%A5%9E%E7%BB%8F%E7%BD%91%E7%BB%9C一、神经元模型2.1神经元1943年,美国神经生理学家沃伦·麦卡洛克(WarrenMcCulloch)和数学家沃尔特·皮茨(WalterPitts)对生物神经元进行

- 主流编程语言全景图:从Python到Rust的深度解析

万能小贤哥

pythonrust开发语言

2024年编程语言生态报告显示,全球开发者使用的语言数量已达260+,但真正主导行业的不到20种。本文带你穿透技术迷雾,掌握8大核心语言的本质差异。一、选择编程语言的黄金标准图表代码二、八大主流语言对比解析1.Python-通用胶水语言特性:动态类型+缩进语法丰富的库生态(20万+包)GIL全局锁限制并发适用场景:python#机器学习示例(TensorFlow)importtensorflowa

- 仓库货物检测:基于YOLOv5的深度学习应用与UI界面开发

YOLO实战营

YOLO深度学习ui目标跟踪目标检测人工智能

一、引言随着电商和物流行业的快速发展,仓库货物管理已经成为企业运营中至关重要的环节。为了提高仓库管理的效率和准确性,越来越多的企业开始应用自动化技术来完成货物的盘点、分类、分拣等任务。传统的货物管理方式通常依赖人工检查,不仅效率低下,而且容易出现误差。为了克服这些问题,利用计算机视觉和深度学习技术来实现仓库货物的自动化检测成为了一种有效的解决方案。本博客将介绍如何使用YOLOv5进行仓库货物检测,

- Transformer:自注意力驱动的神经网络革命引擎

大千AI助手

人工智能Python#OTHERtransformer神经网络深度学习google人工智能机器学习大模型

本文由「大千AI助手」原创发布,专注用真话讲AI,回归技术本质。拒绝神话或妖魔化。搜索「大千AI助手」关注我,一起撕掉过度包装,学习真实的AI技术!从语言理解到多模态智能的通用架构基石⚙️一、核心定义与历史意义Transformer是由Google团队在2017年论文《AttentionIsAllYouNeed》中提出的深度学习架构,其颠覆性创新在于:完全摒弃RNN/CNN:仅依赖自注意力机制(S

- [特殊字符] LLM(大型语言模型):智能时代的语言引擎与通用推理基座

大千AI助手

人工智能Python#OTHER语言模型人工智能自然语言处理LLM大模型Transformer

本文由「大千AI助手」原创发布,专注用真话讲AI,回归技术本质。拒绝神话或妖魔化。搜索「大千AI助手」关注我,一起撕掉过度包装,学习真实的AI技术!从千亿参数到人类认知的AI革命一、核心定义与核心特征LLM(LargeLanguageModel)是基于海量文本数据训练的深度学习模型,通过神经网络架构(尤其是Transformer)模拟人类语言的复杂规律,实现文本理解、生成与推理任务。其核心特征可概

- 深度学习模型开发部署全流程:以YOLOv11目标检测任务为例

你喜欢喝可乐吗?

deeplearningdeploy深度学习YOLO目标检测

深度学习模型开发部署全流程:以YOLOv11目标检测任务为例深度学习模型从开发到部署的完整流程包含需求分析、数据准备、模型训练、模型优化、模型测试和部署运行六大核心环节。YOLOv11作为新一代目标检测模型,不仅延续了YOLO系列的高效实时性能,还在检测精度和泛化能力上取得显著突破,使其成为工业质检、安防监控、自动驾驶等领域的理想选择。本文将详细阐述这一完整流程,并结合YOLOv11的具体实现,提

- 预测导管原位癌浸润性复发的深度学习:利用组织病理学图像和临床特征

浪漫的诗人

论文深度学习人工智能

文章目录研究内容目的方法数据集模型开发模型训练与评估外部验证统计分析研究结果模型性能风险分层外部验证特征重要性原文链接原文献:Deeplearningforpredictinginvasiverecurrenceofductalcarcinomainsitu:leveraginghistopathologyimagesandclinicalfeatures研究背景【DCIS与IBC的关联】乳腺导管

- 深度学习:让 AI 拥有 “思考” 能力的核心技术

田园Coder

人工智能科普人工智能科普

1.深度学习:突破传统的AI“进阶版”1.1什么是深度学习?深度学习是机器学习的一个分支,它通过模拟人脑神经网络的多层结构,让AI能够自动学习数据中的复杂特征,从而完成更高级的认知任务。例如,传统机器学习需要人类手动提取“猫有尖耳朵、胡须”等特征,而深度学习能直接从原始图片中,自主学习从像素到轮廓、再到整体形态的多层特征,最终实现更精准的识别。这种“自主提取特征”的能力,让深度学习突破了传统AI的

- PyTorch torch.no_grad() 指南(笔记)

拉拉拉拉拉拉拉马

pytorch人工智能python笔记深度学习

PyTorchtorch.no_grad()权威在PyTorch深度学习框架中,高效的显存管理对于训练复杂模型和执行大规模推理任务至关重要。显存不足(OutOfMemory,OOM)错误是开发者经常面临的挑战之一。torch.no_grad()作为PyTorch提供的一个核心工具,能够在推理(inference)和验证(validation)阶段显著优化显存使用并提升计算速度。本报告旨在全面、深入

- 【深度学习基础】PyTorch中model.eval()与with torch.no_grad()以及detach的区别与联系?

目录1.核心功能对比2.使用场景对比3.区别与联系4.典型代码示例(1)模型评估阶段(2)GAN训练中的判别器更新(3)提取中间特征5.关键区别总结6.常见问题与解决方案(1)问题:推理阶段显存爆掉(2)问题:Dropout/BatchNorm行为异常(3)问题:中间张量意外参与梯度计算7.最佳实践8.总结以下是PyTorch中model.eval()、withtorch.no_grad()和.d

- 探索OpenCV 3.2源码:计算机视觉的架构与实现

轩辕姐姐

本文还有配套的精品资源,点击获取简介:OpenCV是一个全面的计算机视觉库,提供广泛的功能如图像处理、对象检测和深度学习支持。OpenCV3.2版本包含了改进的深度学习和GPU加速特性,以及丰富的示例程序。本压缩包文件提供了完整的OpenCV3.2源代码,对于深入学习计算机视觉算法和库实现机制十分宝贵。源码的模块化设计、C++接口、算法实现、多平台支持和性能优化等方面的深入理解,都将有助于开发者的

- 院级医疗AI管理流程—基于数据共享、算法开发与工具链治理的系统化框架

Allen_Lyb

医疗高效编程研发人工智能算法时序数据库经验分享健康医疗

医疗AI:从“单打独斗”到“协同共进”在科技飞速发展的今天,医疗人工智能(AI)正以前所未有的速度改变着传统医疗模式。从最初在影像诊断、临床决策支持、药物发现等单一领域的“单点突破”,医疗AI如今已迈向“系统级协同”的新阶段。曾经,医疗AI的应用多集中在某一特定环节,比如利用深度学习算法分析医学影像,辅助医生进行疾病诊断。这种单点突破式的应用虽然在一定程度上提高了医疗效率,但随着医疗行业对AI技术

- 大型语言模型的智能本质是什么

ZhangJiQun&MXP

教学2021论文2024大模型以及算力语言模型人工智能自然语言处理

大型语言模型的智能本质是什么基于海量数据的统计模式识别与生成系统,数据驱动的语言模拟系统,其价值在于高效处理文本任务(如写作、翻译、代码生成),而非真正的理解与创造大型语言模型(如GPT-4、Claude等)的智能本质可概括为基于海量数据的统计模式识别与生成系统,其核心能力源于对语言规律的深度学习,但缺乏真正的理解与意识。以下从本质特征、技术机制、典型案例及争议点展开分析:一、智能本质的核心特征统

- 深度学习超参数优化(HPO)终极指南:从入门到前沿

摘要:在深度学习的实践中,模型性能的好坏不仅取决于算法和数据,更在一半程度上取决于超参数的精妙设置。本文是一篇关于超参数优化(HyperparameterOptimization,HPO)的综合性指南,旨在带领读者从最基础的概念出发,系统性地梳理从经典到前沿的各类优化方法,并最终落地于实用策略和现代工具。无论您是初学者还是资深从业者,都能从中获得宝贵的见解。第一部分:夯实基础——HPO的核心概念1

- 天文图像处理:星系分类与天体定位

xcLeigh

计算机视觉CV图像处理分类人工智能AI计算机视觉

天文图像处理:星系分类与天体定位一、前言二、天文图像处理基础2.1天文图像的获取2.2天文图像的格式2.3天文图像处理的基本流程三、天文图像预处理3.1去噪处理3.2平场校正3.3偏置校正四、星系分类4.1星系的分类体系4.2基于特征提取的星系分类方法4.3基于深度学习的星系分类方法五、天体定位5.1天体坐标系统5.2基于星图匹配的天体定位方法5.3基于深度学习的天体定位方法六、总结与展望致读者一

- 深度学习——CNN(3)

飘涯

前言:前面介绍了最基本的Lenet,下面介绍几种其他的网络结构CNN-AlexNet网络结构如下图:从图中可以看出,采用双gpu训练增加LRN归一化层:本质上,这个层也是为了防止激活函数的饱和的。采用dropout防止过拟合基于AlexNet进行微调,诞生了ZF-netCNN-GoogleNetGoogLeNet借鉴了NIN的特性,在原先的卷积过程中附加了11的卷积核加上ReLU激活。这不仅仅提升

- 微算法科技技术突破:用于前馈神经网络的量子算法技术助力神经网络变革

MicroTech2025

量子计算算法神经网络

随着量子计算和机器学习的迅猛发展,企业界正逐步迈向融合这两大领域的新时代。在这一背景下,微算法科技(NASDAQ:MLGO)成功研发出一套用于前馈神经网络的量子算法,突破了传统神经网络在训练和评估中的性能瓶颈。这一创新性的量子算法以经典的前馈和反向传播算法为基础,借助量子计算的强大算力,极大提升了网络训练和评估效率,并带来了对过拟合的天然抗性。前馈神经网络是深度学习的核心架构,广泛应用于图像分类、

- 英伟达Triton 推理服务详解

leo0308

基础知识机器人Triton人工智能

1.TritonInferenceServer简介TritonInferenceServer(简称Triton,原名NVIDIATensorRTInferenceServer)是英伟达推出的一个开源、高性能的推理服务器,专为AI模型的部署和推理服务而设计。它支持多种深度学习框架和硬件平台,能够帮助开发者和企业高效地将AI模型部署到生产环境中。Triton主要用于模型推理服务化,即将训练好的模型通过

- Java NLP炼金术:从词袋到深度学习,构建AI时代的语言魔方

墨夶

Java学习资料人工智能java自然语言处理

一、JavaNLP的“三剑客”:框架与工具链1.1ApacheOpenNLP:传统NLP的“瑞士军刀”目标:用词袋模型实现文本分类与实体识别代码实战:文档分类器的“炼成术”//OpenNLP文档分类器(基于词袋模型)importopennlp.tools.doccat.*;importopennlp.tools.util.*;publicclassDocumentClassifier{//训练模型

- PyTorch & TensorFlow速成复习:从基础语法到模型部署实战(附FPGA移植衔接)

阿牛的药铺

算法移植部署pytorchtensorflowfpga开发

PyTorch&TensorFlow速成复习:从基础语法到模型部署实战(附FPGA移植衔接)引言:为什么算法移植工程师必须掌握框架基础?针对光学类产品算法FPGA移植岗位需求(如可见光/红外图像处理),深度学习框架是算法落地的"桥梁"——既要用PyTorch/TensorFlow验证算法可行性,又要将训练好的模型(如CNN、目标检测)转换为FPGA可部署的格式(ONNX、TFLite)。本文采用"

- 深度学习模型表征提取全解析

ZhangJiQun&MXP

教学2024大模型以及算力2021AIpython深度学习人工智能pythonembedding语言模型

模型内部进行表征提取的方法在自然语言处理(NLP)中,“表征(Representation)”指将文本(词、短语、句子、文档等)转化为计算机可理解的数值形式(如向量、矩阵),核心目标是捕捉语言的语义、语法、上下文依赖等信息。自然语言表征技术可按“静态/动态”“有无上下文”“是否融入知识”等维度划分一、传统静态表征(无上下文,词级为主)这类方法为每个词分配固定向量,不考虑其在具体语境中的含义(无法解

- 【Qualcomm】高通SNPE框架简介、下载与使用

Jackilina_Stone

人工智能QualcommSNPE

目录一高通SNPE框架1SNPE简介2QNN与SNPE3Capabilities4工作流程二SNPE的安装与使用1下载2Setup3SNPE的使用概述一高通SNPE框架1SNPE简介SNPE(SnapdragonNeuralProcessingEngine),是高通公司推出的面向移动端和物联网设备的深度学习推理框架。SNPE提供了一套完整的深度学习推理框架,能够支持多种深度学习模型,包括Pytor

- Python的科学计算库NumPy(一)

linlin_1998

pythonnumpy开发语言

NumPy(NumericalPython)是Python中最基础、最重要的科学计算库之一,提供了高性能的多维数组(ndarray)对象和大量数学函数,是许多数据科学、机器学习库(如Pandas、SciPy、TensorFlow等)的基础依赖。1.创建一个numpy里面的一维数组importnumpyasnp###通过array方法创建一个ndarrayarray1=np.array([1,2,3

- Dom

周华华

JavaScripthtml

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/1999/xhtml&q

- 【Spark九十六】RDD API之combineByKey

bit1129

spark

1. combineByKey函数的运行机制

RDD提供了很多针对元素类型为(K,V)的API,这些API封装在PairRDDFunctions类中,通过Scala隐式转换使用。这些API实现上是借助于combineByKey实现的。combineByKey函数本身也是RDD开放给Spark开发人员使用的API之一

首先看一下combineByKey的方法说明:

- msyql设置密码报错:ERROR 1372 (HY000): 解决方法详解

daizj

mysql设置密码

MySql给用户设置权限同时指定访问密码时,会提示如下错误:

ERROR 1372 (HY000): Password hash should be a 41-digit hexadecimal number;

问题原因:你输入的密码是明文。不允许这么输入。

解决办法:用select password('你想输入的密码');查询出你的密码对应的字符串,

然后

- 路漫漫其修远兮 吾将上下而求索

周凡杨

学习 思索

王国维在他的《人间词话》中曾经概括了为学的三种境界古今之成大事业、大学问者,罔不经过三种之境界。“昨夜西风凋碧树。独上高楼,望尽天涯路。”此第一境界也。“衣带渐宽终不悔,为伊消得人憔悴。”此第二境界也。“众里寻他千百度,蓦然回首,那人却在灯火阑珊处。”此第三境界也。学习技术,这也是你必须经历的三种境界。第一层境界是说,学习的路是漫漫的,你必须做好充分的思想准备,如果半途而废还不如不要开始。这里,注

- Hadoop(二)对话单的操作

朱辉辉33

hadoop

Debug:

1、

A = LOAD '/user/hue/task.txt' USING PigStorage(' ')

AS (col1,col2,col3);

DUMP A;

//输出结果前几行示例:

(>ggsnPDPRecord(21),,)

(-->recordType(0),,)

(-->networkInitiation(1),,)

- web报表工具FineReport常用函数的用法总结(日期和时间函数)

老A不折腾

finereport报表工具web开发

web报表工具FineReport常用函数的用法总结(日期和时间函数)

说明:凡函数中以日期作为参数因子的,其中日期的形式都必须是yy/mm/dd。而且必须用英文环境下双引号(" ")引用。

DATE

DATE(year,month,day):返回一个表示某一特定日期的系列数。

Year:代表年,可为一到四位数。

Month:代表月份。

- c++ 宏定义中的##操作符

墙头上一根草

C++

#与##在宏定义中的--宏展开 #include <stdio.h> #define f(a,b) a##b #define g(a) #a #define h(a) g(a) int main() { &nbs

- 分析Spring源代码之,DI的实现

aijuans

springDI现源代码

(转)

分析Spring源代码之,DI的实现

2012/1/3 by tony

接着上次的讲,以下这个sample

[java]

view plain

copy

print

- for循环的进化

alxw4616

JavaScript

// for循环的进化

// 菜鸟

for (var i = 0; i < Things.length ; i++) {

// Things[i]

}

// 老鸟

for (var i = 0, len = Things.length; i < len; i++) {

// Things[i]

}

// 大师

for (var i = Things.le

- 网络编程Socket和ServerSocket简单的使用

百合不是茶

网络编程基础IP地址端口

网络编程;TCP/IP协议

网络:实现计算机之间的信息共享,数据资源的交换

协议:数据交换需要遵守的一种协议,按照约定的数据格式等写出去

端口:用于计算机之间的通信

每运行一个程序,系统会分配一个编号给该程序,作为和外界交换数据的唯一标识

0~65535

查看被使用的

- JDK1.5 生产消费者

bijian1013

javathread生产消费者java多线程

ArrayBlockingQueue:

一个由数组支持的有界阻塞队列。此队列按 FIFO(先进先出)原则对元素进行排序。队列的头部 是在队列中存在时间最长的元素。队列的尾部 是在队列中存在时间最短的元素。新元素插入到队列的尾部,队列检索操作则是从队列头部开始获得元素。

ArrayBlockingQueue的常用方法:

- JAVA版身份证获取性别、出生日期及年龄

bijian1013

java性别出生日期年龄

工作中需要根据身份证获取性别、出生日期及年龄,且要还要支持15位长度的身份证号码,网上搜索了一下,经过测试好像多少存在点问题,干脆自已写一个。

CertificateNo.java

package com.bijian.study;

import java.util.Calendar;

import

- 【Java范型六】范型与枚举

bit1129

java

首先,枚举类型的定义不能带有类型参数,所以,不能把枚举类型定义为范型枚举类,例如下面的枚举类定义是有编译错的

public enum EnumGenerics<T> { //编译错,提示枚举不能带有范型参数

OK, ERROR;

public <T> T get(T type) {

return null;

- 【Nginx五】Nginx常用日志格式含义

bit1129

nginx

1. log_format

1.1 log_format指令用于指定日志的格式,格式:

log_format name(格式名称) type(格式样式)

1.2 如下是一个常用的Nginx日志格式:

log_format main '[$time_local]|$request_time|$status|$body_bytes

- Lua 语言 15 分钟快速入门

ronin47

lua 基础

-

-

单行注释

-

-

[[

[多行注释]

-

-

]]

-

-

-

-

-

-

-

-

-

-

-

1.

变量 & 控制流

-

-

-

-

-

-

-

-

-

-

num

=

23

-

-

数字都是双精度

str

=

'aspythonstring'

- java-35.求一个矩阵中最大的二维矩阵 ( 元素和最大 )

bylijinnan

java

the idea is from:

http://blog.csdn.net/zhanxinhang/article/details/6731134

public class MaxSubMatrix {

/**see http://blog.csdn.net/zhanxinhang/article/details/6731134

* Q35

求一个矩阵中最大的二维

- mongoDB文档型数据库特点

开窍的石头

mongoDB文档型数据库特点

MongoDD: 文档型数据库存储的是Bson文档-->json的二进制

特点:内部是执行引擎是js解释器,把文档转成Bson结构,在查询时转换成js对象。

mongoDB传统型数据库对比

传统类型数据库:结构化数据,定好了表结构后每一个内容符合表结构的。也就是说每一行每一列的数据都是一样的

文档型数据库:不用定好数据结构,

- [毕业季节]欢迎广大毕业生加入JAVA程序员的行列

comsci

java

一年一度的毕业季来临了。。。。。。。。

正在投简历的学弟学妹们。。。如果觉得学校推荐的单位和公司不适合自己的兴趣和专业,可以考虑来我们软件行业,做一名职业程序员。。。

软件行业的开发工具中,对初学者最友好的就是JAVA语言了,网络上不仅仅有大量的

- PHP操作Excel – PHPExcel 基本用法详解

cuiyadll

PHPExcel

导出excel属性设置//Include classrequire_once('Classes/PHPExcel.php');require_once('Classes/PHPExcel/Writer/Excel2007.php');$objPHPExcel = new PHPExcel();//Set properties 设置文件属性$objPHPExcel->getProperties

- IBM Webshpere MQ Client User Issue (MCAUSER)

darrenzhu

IBMjmsuserMQMCAUSER

IBM MQ JMS Client去连接远端MQ Server的时候,需要提供User和Password吗?

答案是根据情况而定,取决于所定义的Channel里面的属性Message channel agent user identifier (MCAUSER)的设置。

http://stackoverflow.com/questions/20209429/how-mca-user-i

- 网线的接法

dcj3sjt126com

一、PC连HUB (直连线)A端:(标准568B):白橙,橙,白绿,蓝,白蓝,绿,白棕,棕。 B端:(标准568B):白橙,橙,白绿,蓝,白蓝,绿,白棕,棕。 二、PC连PC (交叉线)A端:(568A): 白绿,绿,白橙,蓝,白蓝,橙,白棕,棕; B端:(标准568B):白橙,橙,白绿,蓝,白蓝,绿,白棕,棕。 三、HUB连HUB&nb

- Vimium插件让键盘党像操作Vim一样操作Chrome

dcj3sjt126com

chromevim

什么是键盘党?

键盘党是指尽可能将所有电脑操作用键盘来完成,而不去动鼠标的人。鼠标应该说是新手们的最爱,很直观,指哪点哪,很听话!不过常常使用电脑的人,如果一直使用鼠标的话,手会发酸,因为操作鼠标的时候,手臂不是在一个自然的状态,臂肌会处于绷紧状态。而使用键盘则双手是放松状态,只有手指在动。而且尽量少的从鼠标移动到键盘来回操作,也省不少事。

在chrome里安装 vimium 插件

- MongoDB查询(2)——数组查询[六]

eksliang

mongodbMongoDB查询数组

MongoDB查询数组

转载请出自出处:http://eksliang.iteye.com/blog/2177292 一、概述

MongoDB查询数组与查询标量值是一样的,例如,有一个水果列表,如下所示:

> db.food.find()

{ "_id" : "001", "fruits" : [ "苹

- cordova读写文件(1)

gundumw100

JavaScriptCordova

使用cordova可以很方便的在手机sdcard中读写文件。

首先需要安装cordova插件:file

命令为:

cordova plugin add org.apache.cordova.file

然后就可以读写文件了,这里我先是写入一个文件,具体的JS代码为:

var datas=null;//datas need write

var directory=&

- HTML5 FormData 进行文件jquery ajax 上传 到又拍云

ileson

jqueryAjaxhtml5FormData

html5 新东西:FormData 可以提交二进制数据。

页面test.html

<!DOCTYPE>

<html>

<head>

<title> formdata file jquery ajax upload</title>

</head>

<body>

<

- swift appearanceWhenContainedIn:(version1.2 xcode6.4)

啸笑天

version

swift1.2中没有oc中对应的方法:

+ (instancetype)appearanceWhenContainedIn:(Class <UIAppearanceContainer>)ContainerClass, ... NS_REQUIRES_NIL_TERMINATION;

解决方法:

在swift项目中新建oc类如下:

#import &

- java实现SMTP邮件服务器

macroli

java编程

电子邮件传递可以由多种协议来实现。目前,在Internet 网上最流行的三种电子邮件协议是SMTP、POP3 和 IMAP,下面分别简单介绍。

◆ SMTP 协议

简单邮件传输协议(Simple Mail Transfer Protocol,SMTP)是一个运行在TCP/IP之上的协议,用它发送和接收电子邮件。SMTP 服务器在默认端口25上监听。SMTP客户使用一组简单的、基于文本的

- mongodb group by having where 查询sql

qiaolevip

每天进步一点点学习永无止境mongo纵观千象

SELECT cust_id,

SUM(price) as total

FROM orders

WHERE status = 'A'

GROUP BY cust_id

HAVING total > 250

db.orders.aggregate( [

{ $match: { status: 'A' } },

{

$group: {

- Struts2 Pojo(六)

Luob.

POJOstrust2

注意:附件中有完整案例

1.采用POJO对象的方法进行赋值和传值

2.web配置

<?xml version="1.0" encoding="UTF-8"?>

<web-app version="2.5"

xmlns="http://java.sun.com/xml/ns/javaee&q

- struts2步骤

wuai

struts

1、添加jar包

2、在web.xml中配置过滤器

<filter>

<filter-name>struts2</filter-name>

<filter-class>org.apache.st