【AI初识境】从3次人工智能潮起潮落说起

文章首发于微信公众号《有三AI》

【AI初识境】从3次人工智能潮起潮落说起

专栏《AI白身境》已经完结,今天开始这个系列的第二个专栏《AI初识境》。所谓初识,就是对相关技术有基本了解,掌握了基本的使用方法。

第一篇,我们就来说说人工智能的简单历史,通常来说业界公认包括三个重要的历史阶段。

作者&编辑 | 言有三

01 什么是智能

智能,即Intelligence,那什么是智能呢?按照中国古代思想家荀子在《荀子·正名篇》的说法:“所以知之在人者谓之知,知有所合谓之智。所以能之在人者谓之能,能有所合谓之能”。

其中的“智”指进行认识活动的某些心理特点,“能”则指进行实际活动的某些心理特点。我的理解就是,能是智的具体表达形式,当然也有学者将智和能作为一个整体的,《论衡·实知篇》中就认为人才就是具有一定智能水平的人。

更加科学的定义是在霍华德·加德纳的多元智能理论中,它将人类的智能分成七种能力:

-

(1) 语言 (Verbal/Linguistic)

-

(2) 逻辑 (Logical/Mathematical)

-

(3) 空间 (Visual/Spatial)

-

(4) 肢体运作 (Bodily/Kinesthetic)

-

(5) 音乐 (Musical/Rhythmic)

-

(6) 人际 (Inter-personal/Social)

-

(7) 内省 (Intra-personal/Introspective)

这基本覆盖了现在人工智能的研究领域,包括计算机视觉,语音识别,自然语言处理等。

从生物学上来说智能体是有两种的,有生命的和没有生命的,人显然就是有生命的,而人工智能,自然研究的是没有生命体的,但是能够表现出生命体的智能的,因此才叫“人工”智能,或者理解为人造智能吧。

02 图灵与机器智能

科技发展到一个节点后,就有人思考如何用真正的生命体外的东西来模拟人类的智能,从模拟大脑的运作方式开始显然是最合适的。

在1943年的时候麦卡洛克-皮茨(MuCulloch和Pitts)就提出了MP模型,即最早的基于阈值逻辑的神经网络模型,用于模拟人脑神经元,它已经是感知器的原型了,开创了人工神经网络研究的时代。

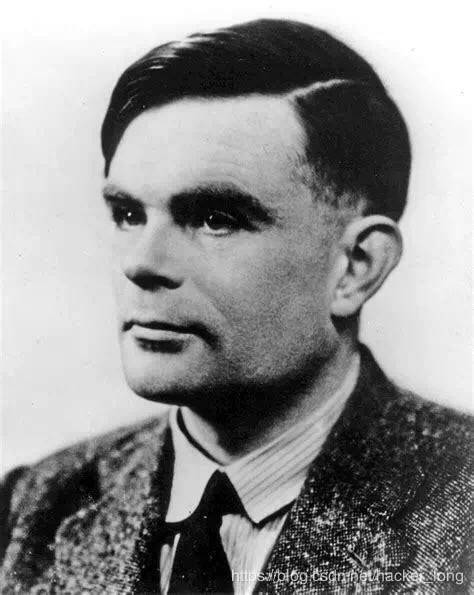

当然,人工智能是一个比神经网络更广的范畴,它的理论先驱代表性人物是天才科学家图灵。

艾伦·图灵在1950年的论文《Computing Machinery and Intelligence》中提出了图灵测试,在图灵测试中,人类测试者与一台机器被隔开,一个人类测试员通过文字向被测试者随意提问。进行多次测试后,如果测试者不能确定出被测试者是人还是机器,那么这台机器就通过了测试,并被认为具有人类智能,它在数十年间被当作机器智能的测试标准,深刻影响了人工智能的发展。

当然图灵测试不需要限于对话,其他的一些人类活动也可以。目前在很多的领域里机器已经通过图灵测试,比如下棋。

很多学者认为,图灵在1948年的时候在英国国家物理实验室内部做过的一个题为“智能机器”的报告是更早的机器智能的源头,在这个报告中提出了“embodied intelligence”和 “disembobied intelligence”,即肉体智能和无肉体智能。肉体智能指的是需要身体来完成活动的,比如人形机器人,而无肉体智能则可以脱离形体,比如下棋,进行语言对话等。但是由于报告是保密的,因此我们还是认为1950年的图灵测试是真正意义上提出机器智能概念。

为了纪念图灵的贡献,美国计算机协会在1966年设立了图灵奖,这成为了计算机科学领域的“诺贝尔奖”,图灵也被称为计算机科学之父、人工智能之父。

3冯诺伊曼与类脑计算

图灵提出了机器智能的概念,那怎么实现呢?现在大家都知道了,使用计算机,或者更通用的说法是电脑。

冯·诺依曼(John von Neumann)正是计算机之父。在智能这个研究课题上,图灵走理论路线,而冯·诺伊曼更偏重工程路线,它们在普林斯顿大学期间有接触,比图灵大10岁的冯诺伊曼对前者还有一定的知遇之恩。

冯诺伊曼的贡献很多,这里我们只说其在计算机方面的贡献,它对世界上第一台电子计算机ENIAC(电子数字积分计算机)的设计提出过建议,这体现在1945年他牵头起草的EDVAC(Electronic Discrete Variable AutomaticComputer)中,翻译过来是“存储程序通用电子计算机方案”。这对计算机的设计有决定性的影响,特别是计算机的结构,包括存储程序以及二进制编码等。这个报告中最核心的概念是“存储程序(Stored Program)”,老冯将其原创给予了图灵,认为存储程序其实就是通用图灵机,可见老冯不止是研究做得好,人品更是棒。

所谓存储程序:就是把运算程序存在机器的存储器中,程序设计员只需要在存储器中寻找运算指令,机器就会自行完成计算,这样,就不必对每个问题都重新编程,从而加快了程序设计的流程。

当然在EDVAC中还包括了随机寻址以及寄存器等原创思想。鉴于冯·诺依曼在发明电子计算机中所起的关键性作用,他被誉为“计算机之父”。冯诺伊曼的研究被整理在《计算机和人脑》中,感兴趣的读者可以去读中译本。

4达特茅斯会议

图灵和冯·诺伊曼为机器智能奠基,而人工智能正式成为一个学科被广泛研究,应该起源于1956年的达特茅斯会议,会议的参与者包括了达特茅斯学院的约翰·麦卡锡(John McCarthy)、哈佛大学的马文·闵斯基(MarvinMinsky,人工智能与认知学专家)、贝尔电话实验室的克劳德·香农(Claude Shannon,信息论的创始人)、艾伦·纽厄尔(Allen Newell,计算机科学家)、赫伯特·西蒙(Herbert Simon,诺贝尔经济学奖得主),塞弗里奇(Oliver Selfridge)等科学家,在两个多月的会议中它们讨论了用机器来模仿人类学习以及其他方面的智能这个课题。

虽然会议最后没有什么实质性的结论,但是会议正式提出了一个新学科, 即“Artificial Intelligence”,翻译过来就是人工智能。可以说一个学科的正式诞生,才是为公众所知的开始。

我们再来说一下参会的这些人和人工智能的关系。

1. 约翰·麦卡锡(John McCarthy),开发了程序语言Lisp(List Processing language),成为第一个最流行的AI研究程序语言,他还提出了计算机分时(time-sharing)的概念。正是约翰·麦卡锡提出了“Artificial Intelligence”这个概念(虽然他自己老年说是听来的但是最后也无法证实来源),因此也被称为“人工智能之父”(我觉得人工智能之母更加合适,毕竟图灵才是思想之源,而麦卡锡同志是一个养育者),他在1971年获得了图灵奖。

2. 马文·闵斯基,他在1951年24岁的时候和迪恩·埃德蒙(Dean Edmunds)在普林斯顿大学建立了第一个神经网络机器SNARC(Stochastic Neural Analog ReinforcementCalculator),这是第一个人工神经网络,用3000个真空管模拟出40个神经元的神经信号传递,由于他的一系列奠基贡献,在1969年获得了图灵奖。

3. 克劳德·香农(Claude Shannon),在1950年发表了《Programming a Computer for Playing Chess》,这篇论文第一次开始关注计算机象棋程序的开发。作为信息科学领域的鼻祖,与图灵并驾齐驱的香农自然是不需要图灵奖了,毕竟还有通讯领域的最高奖香农奖。

4. 赫伯特·西蒙(Herbert Simon)和艾伦·纽厄尔(Allen Newell),他们在1956年开发了"LogicTheorist",是世界上第一个AI项目,证明了在罗素和怀特海的数学教科书《数学原理》第二章的52个定理中的38个,并找到了比教材中更加优美的证明,这开创了名为“搜索推理”的方法,这是人工智能的符号派的代表性成果。他们在1975年一起获得了图灵奖。

之后研究AI的一些科学家也获得了图灵奖,1994年Edward Feigenbaum)和Raj Reddy、2010年Leslie Valiant、2011年Judea Pearl。正是有了这些科学家的头脑风暴,才有了今天的这门学科,改变了人类的生活方式,向他们致敬。

5第一次浪潮(1956-1974)

在人工智能学科诞生后,赫伯特·西蒙(Herbert Simon)乐观地预测20年内诞生完全智能的机器,当然这没有发生,但是带来了第一个人工智能的研究热潮。

1963年,美国国防部高级研究计划局(DARPA)给麻省理工学院、卡内基梅隆大学的人工智能研究組投入了200万美元的研究经费,开启了Project MAC(Mathematics and Computation),这个项目是麻省理工学院计算机科学与人工智能实验室的前身,培养了最早期的计算机科学与人工智能人才,也有了一些成果。

在1964~1966年间约瑟夫·维森班(loseph Weizenbaum )开发了ELIZA,这是第一个自然语言对话程序,通过简单的模式匹配和对话规则进行任何主题的英文对话。不过他开发程序只是为了证明机器与人的交流很肤浅,后来成为了批判人工智能研究大军的一员。

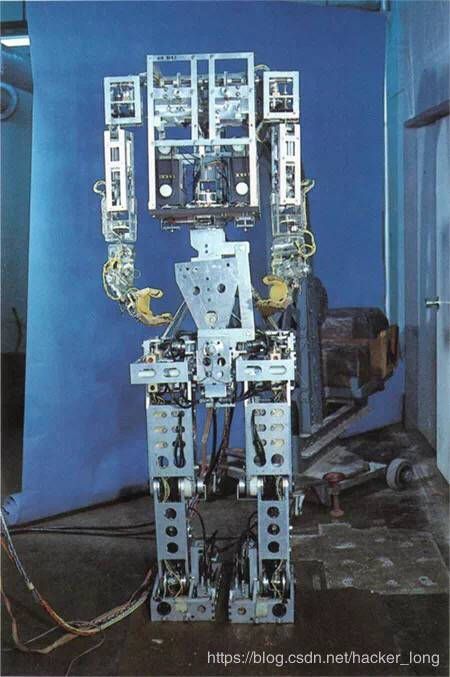

早稻田大学在1967年到1972年间则发明了第一个人形机器人Wabot-1,不仅可以进行简单的对话,还能够完成在室内走动和抓取物体的动作,这就涉及到了计算机视觉的研究。并且在1980年更新到了二代版本Wabot-2,增加了阅读乐谱和演奏普通难度的电子琴的功能。研发该机器人的加藤一郎也被赋予“人形机器人之父”。

从70年代开始,由于计算能力有限,而科学家一开始的预测又过于乐观,导致研究和期望产生了巨大的落差,公众热情和投资削减,70年代中期进入第一次人工智能的研究进入低谷。

06第二次浪潮(1980-1987)

专家系统和人工神经网络的兴起,带来了第二波浪潮。

所谓专家系统,即基于特定的规则来回答特定领域的问题的程序,在1964年费根鲍姆(Edward Feigenbaum)等人在斯坦福大学研究了第一个专家系统DENDRAL,能够自动做决策,解决有机化学问题,因此他也被成为“专家系统之父”。

在1970年,斯坦福大学的科学家们开发了专家系统MYCIN,通过600多条人工编写的规则识别引发严重传染病的细菌,推荐抗生素。

在1980年,卡内基梅隆大学开发了XCON程序,这是一套基于规则开发的专家系统,帮助迪吉多公司的客户自动选择计算机组件,为其每年节省了4000万美元。

在巨大的商业价值的刺激下,工业界又兴起了对人工智能的热情。在这样的背景下,1982年日本通商产业省启动了“第五代计算机”计划,期望通过大规模的并行计算来建造通用人工智能平台,不过10年间耗资500亿日元后还是未能达到预期目标。休伊特(Carl Hewitt)认为大部分五代机的工作只是试着用逻辑程序去解决其他手段已经解决的问题。

1984在年度AAAI会议上,罗杰·单克(Roger Schank)和马文·明斯基(Marvin Minsky) 发出警告,认为“Al寒冬”已经来临,Al泡沫很快就会破灭,与此同时AI投资与研究资金也减少,正如70年代出现的事情一样。

但是另一方面,深度学习的前身,人工神经网络却取得了革命性的进展,在1986年戴维·鲁梅哈特(DavidRumelhart),杰弗里·辛顿(Geoffrey Hinton) 等人推广了由保罗·韦尔博斯(Paul Werbos) 发明的反向传播算法(BP算法),使得大规模神经网络训练成为可能。反向传播算法的出现,使得神经网络隐藏层可以学习到数据输入的有效表达,这就是神经网络乃至深度学习的核心思想。那时候的神经网络就好比上个世纪90年代的互联网,是一种时尚潮流。

虽然因为当时的计算机性能的限制,未能取得工业级的应用,但是这一次的蓄力,为第三次的兴起和爆发奠定了基础。

07第二次浪潮后的蓄力

在第二次低谷之后,科学家们显然更加理智,当然也是因为其他学科暂时吸引了他们的注意力,包括统计学习理论,支持向量机,概率图模型等,这些方法带来了传统的机器学习方法的理论研究和应用,虽然机器学习在1957年就被阿瑟·萨缪尔(Arthur Samuel)提出。

在这一段时间里,统计学习类的机器学习算法就是人工智能的代表,但是由于它本身是一门数据驱动的应用学科,没有达到人工智能那样的广泛,因此大家不再叫人工智能,也降低了对它的期望,利用这些方法来做一些更加实际的问题,研究和应用方向也覆盖了计算机视觉到语音等等。

不过,在以SVM为代表的传统机器学习方法数十年间光芒的背后,却仍然有一股力量在蓄力。

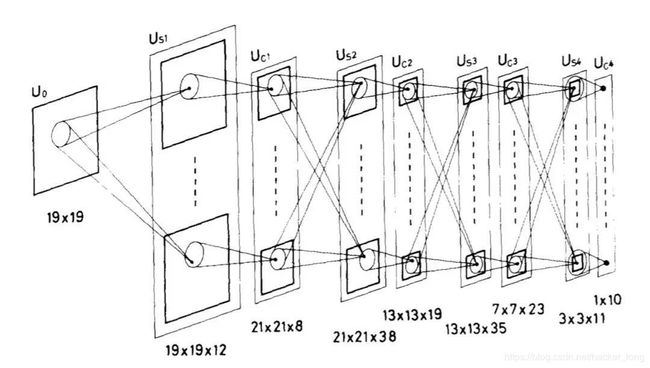

在1980年neocognitron被提出,这是第一个真正意义上的级联卷积神经网络,虽然具体的卷积方式和今天的CNN还有一定的区别。

同一时期RNN也被提出并使用。

1989年Yann LeCun与AT&T贝尔实验室的其它研究人员将反向传播算法应用于多层神经网络,并在1998年提出了稳定可商业应用的卷积神经网络模型LeNet-5,成为了深层卷积神经网络模型的“Hello World”。虽然它不是第一次使用卷积神经网络,但是它的出现意味着将神经网络商用的可能性被验证。

1997年赛普·霍克赖特(Sepp Hochrei ter))和于尔根·施密德胡伯(JurgenSchmidhuber)提出了LSTM(长短期记忆),用于识别手写笔迹和语音。

2001年斯皮尔伯格拍摄的电影《人工智能》上映,这是一部非常具有里程碑意义的人工智能启蒙电影,所以我也将其放在这里讲述。

2006年杰弗里·辛顿(Geoffrey Hinton)等人在science期刊上发表了论文“Reducing the dimensionality of datawith neural networks”,揭开了新的训练深层神经网络算法的序幕,通常这被认为是第三次浪潮的发源,但其实彼时还远远没有引起学界的重视,至少工业界几乎全然不知。

很快斯坦福的李飞飞等人开始研究Image Net项目,这是一个大型的开源数据库,在2009年正式发布,超过1000万数据,两万多个类别。2010年Image Net大规模视觉识别挑战赛(ILSVCR)开始举办,从此揭开了计算机视觉研究的新序幕。

08第三次浪潮

虽然2006年Hinton在science上发表的文章有足够的学术意义,但是第三次浪潮的兴起还是要从工业界发生的具有足够震撼力的标志性事件开始算起。

验证新技术是否足够好的最好方法就是和其他方法以及人类进行PK。

2011年IBM开发的自然语言问答计算机“沃森”在益智类综艺节目“危险边缘”中击败两名前人类冠军。前两轮与对手打平,而最后一集沃森打败了最高奖金得主布拉德·鲁特尔和连胜纪录保持者肯·詹宁斯,人们惊呼,机器也会思考了吗?

2012年,在计算机视觉领域的竞赛Image Net中,新一代卷积神经网络AlexNet,以提升10%的错误率的进步力压第二名以SIFT+FV, LBP+FV, GIST+FV, CSIFT+FV等组合特征的算法。从此人类设计的特征再也不是机器自主学习特征的对手。虽然在此之前语音识别以及取得了足够大的进展,但是彼时语音识别仍然未能商用而没有那么被人所知。

2016年Google的AlphaGo以4:1的成绩战胜了世界围棋冠军李世石。一年后,AlphaGoMaster与人类实时排名第一的棋手柯洁对决,最终连胜三盘。而新一代AlphaGo Zero利用自我对抗迅速自学围棋,并以100:0的成绩完胜前代版本。自此AI下棋再无敌手。

此后,以深度学习为代表的技术,引领了当下的热潮。此所谓第三次潮起,会不会潮落不知道,我知道的是现在正在潮中。

最后发一个通知,2019年有三AI培养计划出炉了,一个季度一期。

总结

所谓读史使人明智,在正式开始学习之前,认真了解一下关键性的技术节点,了解符号派和统计派之争,了解前辈们的故事是很有必要的,建议读一读相关的书籍资料。

转载文章请后台联系

侵权必究

比如网络loss不正常,怎么调都不管用。

比如训练好好的,测试就是结果不对。

bug天天有,深度学习算法工程师遇到的特别多,如果你想交流更多,就来有三AI知识星球实时提问交流吧,大咖众多,总有能解决你问题的。

初识境界到此基本就结束了,这一系列是为大家奠定扎实的深度学习基础,希望学习完后大家能有收获。

AI白身境系列完整阅读:

第一期:【AI白身境】深度学习从弃用windows开始

第二期:【AI白身境】Linux干活三板斧,shell、vim和git

第三期:【AI白身境】学AI必备的python基础

第四期:【AI白身境】深度学习必备图像基础

第五期:【AI白身境】搞计算机视觉必备的OpenCV入门基础

第六期:【AI白身境】只会用Python?g++,CMake和Makefile了解一下

第七期:【AI白身境】学深度学习你不得不知的爬虫基础

第八期: 【AI白身境】深度学习中的数据可视化

第九期:【AI白身境】入行AI需要什么数学基础:左手矩阵论,右手微积分

第十期:【AI白身境】一文览尽计算机视觉研究方向

第十一期:【AI白身境】AI+,都加在哪些应用领域了

第十二期:【AI白身境】究竟谁是paper之王,全球前10的计算机科学家

AI初识境系列完整阅读

第一期:【AI初识境】从3次人工智能潮起潮落说起

第二期:【AI初识境】从头理解神经网络-内行与外行的分水岭

第三期:【AI初识境】近20年深度学习在图像领域的重要进展节点

第四期:【AI初识境】激活函数:从人工设计到自动搜索

第五期:【AI初识境】什么是深度学习成功的开始?参数初始化

第六期:【AI初识境】深度学习模型中的Normalization,你懂了多少?

第七期:【AI初识境】为了围剿SGD大家这些年想过的那十几招

第八期:【AI初识境】被Hinton,DeepMind和斯坦福嫌弃的池化,到底是什么?

第九期:【AI初识境】如何增加深度学习模型的泛化能力

第十期:【AI初识境】深度学习模型评估,从图像分类到生成模型

第十一期:【AI初识境】深度学习中常用的损失函数有哪些?

第十二期:【AI初识境】给深度学习新手开始项目时的10条建议