MySQL Cluste(入门篇)—分布式数据库集群搭建

目录

前言

1 概述

1.1 分布式数据库集群

1.2 数据库的分布式和主从的区别

2 环境说明

2.1 系统环境

2.2 软件环境

3 安装MySQL Cluster

4 配置安装管理节点

4.1 拷贝命令

4.2 配置文件

4.3 启动管理节点

5 配置安装数据节点

5.1 配置my.cnf文件

5.2 安装mysql数据库

5.2.1 更改权限

5.2.2 执行安装脚本

5.2.3 设置mysql服务开机自启动

5.2.4 修改数据库密码

5.3 启动数据节点

6 配置安装sql节点

6.1 配置my.cnf文件

6.2 安装mysql数据库

6.3 启动sql节点

7 测试

7.1 用管理节点查看

7.2 测试数据

8 启动和停止集群

8.1 停止管理节点

8.2 停止sql节点

9 总结

前言

之前写了一篇mysql数据库的主从同步,实现读写分离,主要以replication方式实现数据库主从备份和读写分离,以减轻数据库的负载和避免数据的丢失。但是,这种实现务必要保证主从数据库的数据一致性,否则,一旦有一条数据复制失败,则会导致后面的数据同步都无法继续进行,即出现主从不同步的情形。因此,在这里再写一篇文章,分布式数据库集群,来补充这一缺点。

1 概述

1.1 分布式数据库集群

Mysql cluster是适用于分布式计算环境的高可用、高冗余版本的mysql,其技术在分布式系统中为mysql数据提供了冗余特性,增强了安全性,使得单个mysql服务器故障不会对系统产生巨大的负面效应,系统的稳定性得到保障。Mysql cluster采用shared-nothing(无共享)架构,主要利用了NDB存储引擎来实现,NDB存储引擎是一个内存式存储引擎,要求数据必须全部加载到内存之中,具有自动分片(分区)功能。数据被自动分布在集群中的不同存储节点上,每个存储节点只保存完整数据的一个分片(fragment)。同时,用户可以设置同一份数据保存在多个不同的存储节点上,以保证单点故障不会造成数据丢失。

Mysql cluster需要一组计算机,用到mysql cluster安装包,在集群中的每台计算机上安装,只是每台计算机的角色可能是不一样的。Mysql cluster按照节点类型可以分为3类:管理节点(对其他节点进行管理)、数据节点(存放cluster中的数据,可以有多个)和mysql节点(存放表结构,可以有多个)。Cluster中的某计算机可以是某一种节点,也可以是2种或3种节点的集合。这3种节点只是在逻辑上划分,所以他们不一定和物理计算机是一一对应的关系。多个节点之间可以分布在不同的地理位置,因此也是一个实现分布式数据库的方案。

管理节点(MGM):这类节点的作用是管理MySQL Cluster内的其他节点,如提供配置数据,并停止节点,运行备份等。由于这类节点负责管理其他节点的配置,应该在启动其他节点之前启动这类节点。MGM节点是用命令“ndb_mgmd”启动的。

数据节点(NDB):这类节点用于保存Cluster的数据,数据节点的数目与副本的数目相关,是片段的倍数。例如,对于两个副本,每个副本有两个片段,那么就有4个数据节点,没有必要设定过多的副本,在NDB中数据会尽量的保存在内存中。数据节点使用命令“ndbd”(单线程)或"ndbmtd"(多线程)启动的。

SQL节点:这是用来访问Cluster数据的节点,对于MySQL Cluster,客户端节点是使用NDB Cluster存储引擎的传统MySQL服务器。通常,SQL节点是使用命令“mysqld –ndbcluster”启动的,或将“ndbcluster”添加到“my.cnf”后使用“mysqld”启动。

Mysql cluster的数据更新使用读已提交隔离级别(read-committedisolation)来保证所有节点数据的一致性,使用两阶段提交机制(two-phasedcommit)保证所有节点都有相同的数据(如果任何一个写操作失败,则更新失败)。

Mysql cluster具体的同步复制步骤,如下所示:

1.Master执行提交语句时,事务被发送到slave,slave开始准备事务的提交。

2.每个slave都要准备事务,然后向master发送OK(或ABORT)消息,表明事务已经准备好(或者无法准备该事务)。

3.Master等待所有Slave发送OK或ABORT消息,如果Master收到所有 Slave的OK消息,它就会向所有Slave发送提交消息,告诉Slave提交该事务;如果 Master收到来自任何一个Slave的ABORT消息,它就向所有 Slave发送ABORT消息,告诉Slave去中止事务。

4.每个Slave等待来自Master的OK或ABORT消息。如果Slave收到提交请求,它们就会提交事务,并向Master发送事务已提交 的确认;如果Slave收到取消请求,它们就会撤销所有改变并释放所占有的资源,从而中止事务,然后向Masterv送事务已中止的确认。

5.Master收到来自所有Slave的确认后,就会报告该事务被提交(或中止),然后继续进行下一个事务处理。

由于同步复制一共需要4次消息传递,故mysql cluster的数据更新速度比单机mysql要慢。所以mysql cluster要求运行在千兆以上的局域网内,节点可以采用双网卡,节点组之间采用直连方式。

1.2 数据库的分布式和主从的区别

主从(Master-Slave): 主从机器上安装mysql community(普通版)就可以。

主从并没有像集群那样分三种节点,只有主和从两种,而且主从之间是通过mysql的replication方式来保证数据的一致性。相对mysql cluster的数据同步方式来讲是异步的。

主从复制的过程中,若从数据库中出现其中一条数据同步失败(即relay log中的语句有其中一条写操作语句执行失败),则后面的数据无法继续同步(relay log中后面的写操作语句无法继续执行下去),必须得解决掉或跳过这个执行失败的语句(需要人为去操作),这样就不能保证所有的从数据库的数据一致了。而mysql cluster则不然,若其中只要有一个节点的写操作失败,则其他所有节点针对这一同步均会更新失败,以保证所有节点的数据一致性。

2 环境说明

2.1 系统环境

| 服务器 | 角色 | 说明 |

| 192.168.17.130 | 管理节点(MGM) | 系统 centos 7 64位 |

| 192.168.17.131 | 数据节点(NDB) | 系统 centos 7 64位 |

| 192.168.17.132 | 数据节点(NDB) | 系统 centos 7 64位 |

| 192.168.17.133 | SQL节点 | 系统 centos 7 64位 |

| 192.168.17.134 | SQL节点 | 系统 centos 7 64位 |

2.2 软件环境

mysql cluster 集群版本:

mysql-cluster-gpl-7.6.7-linux-glibc2.12-x86_64.tar.gz

可到官网下载:https://dev.mysql.com/downloads/cluster/

3 安装MySQL Cluster

所有服务器均需执行执行以下操作。

注意:在安装mysql cluster之前,必须得先检查该服务器上是否已安装了普通mysql,若安装了则需先把mysql删除干净,因为mysql cluster就包括了普通版mysql;

在安装管理节点、数据节点和sql节点时,最好以root用户登录执行,否则有一些步骤需要用到sudo命令来执行。

#上传到服务器目录/usr/softwares并解压

tar -xzvf mysql-cluster-gpl-7.6.7-linux-glibc2.12-x86_64.tar.gz

#将解压的文件重命名为mysql,并放到/usr/local/目录下

mv mysql-cluster-gpl-7.6.7-linux-glibc2.12-x86_64 /usr/local/mysql

4 配置安装管理节点

在服务器192.168.17.130上执行以下操作。

注意,管理节点的防火墙端口开放,默认是1186。

4.1 拷贝命令

#将文件ndb_mgm和ndb_mgmd拷贝到/usr/local/bin/目录下

cp /usr/local/mysql/bin/ndb_mgm* /usr/local/bin/

#ndb_mgm,ndb客户端命令

#ndb_mgmd,ndb管理节点启动命令

#ndb_mgm是ndb_mgmd(MySQL Cluster Server)的客户端管理工具,通过它可以方便的检查Cluster的状态、启动备份、关闭Cluster等功能。

4.2 配置文件

#创建数据库集群配置文件的目录

mkdir /var/lib/mysql-cluster

#创建并编辑配置文件

vim /var/lib/mysql-cluster/config.ini

[ndbd default]

NoOfReplicas=1

DataMemory=200M

IndexMemory=64M

[ndb_mgmd]

NodeId=1

hostname=192.168.17.130

datadir=/var/lib/mysql-cluster/

[ndbd]

NodeId=2

hostname=192.168.17.131

datadir=/usr/local/mysql/data/

[ndbd]

NodeId=3

hostname=192.168.17.132

datadir=/usr/local/mysql/data/

[mysqld]

NodeId=4

hostname=192.168.17.133

[mysqld]

NodeId=5

hostname=192.168.17.134

[NDBD DEFAULT]:表示每个数据节点的默认配置,在每个节点的[NDBD]中不用再写这些选项,只能有一个。

NoOfReplicas:副本数量,数据节点数必须是副本数的整数倍。

[NDB_MGMD]:表示管理节点的配置,只有一个,默认的对其他节点的端口是1186,故服务器需要开放1186端口。

[NDBD]:表示每个数据节点的配置,可以有多个,分别写上不同数据节点的IP地址。

[MYSQLD]:表示SQL节点的配置,可以有多个,分别写上不同SQL节点的IP地址。

4.3 启动管理节点

ndb_mgmd -f /var/lib/mysql-cluster/config.ini --initialndb_mgmd是mysql cluster的管理服务器,后面的-f表示后面的参数是启动的参数配置文件。如果在启动后过了几天又添加了一个数据节点,这时修改了配置文件启动时就必须加上--initial参数,不然添加的节点不会作用在mysql cluster中。

5 配置安装数据节点

分别在服务器192.168.17.131和192.168.17.132上执行以下操作。

注意,数据节点的端口开放问题,最好把防火墙关闭,虽然之前版本的默认端口号时2202,但是好像时5.1之后的端口号就没有限制(看哪个端口空闲就用哪个端口),即与sql节点通信的端口号会随机变换。若没有关闭防火墙,后面在管理节点查看集群状态的时候,可能会出现mysql节点老是连接不上的问题。

5.1 配置my.cnf文件

mysql服务启动时会默认加载/etc/my.cnf作为其配置文件,故需要修改/etc/my.cnf配置文件。

[mysqld]

datadir=/usr/local/mysql/data

basedir=/usr/local/mysql

character_set_server=utf8

[mysqld_safe]

log-error=/var/log/mysqld.log

pid-file=/var/run/mysqld/mysqld.pid

[mysql_cluster]

ndb-connectstring=192.168.17.130:1186

5.2 安装mysql数据库

5.2.1 更改权限

#分别添加mysql组和mysql用户

groupadd mysql

useradd mysql -g mysql

#进入mysql目录

cd /usr/local/mysql/

#把mysql的目录设置成所有者为root

chown -R root .

#创建data目录,并把data目录设置所有者为mysql

mkdir data

chown -R mysql data

#把mysql的目录改成所属组为mysql

chgrp -R mysql .

5.2.2 执行安装脚本

初始化数据库(这里要注意,如果你安装的版本和我的不同,数据库初始化的命令使不同的,很多之前的版本会使用:scripts/mysql_install_db --user=mysql来初始化,这个已经被mysql在新的版本中废弃了,所以需要使用下面的命令安装,如果你需要安装别的版本请参考mysql官网的对应版本的安装命令。)

#执行安装脚本,初始化数据库

./bin/mysqld --initialize --user=mysql --basedir=/usr/local/mysql/ --datadir=/usr/local/mysql/data/

#注意其中用户为mysql的名称需要跟配置文件my.cnf中的user=mysql相同

#另外,这里一定要把--basedir=/usr/local/mysql/ --datadir=/usr/local/mysql/data/ 加上,

#否则会最后启动MySQL服务的时候会出现"table mysql.plugin doesn't exist","Can\'t open the mysql.plugin table. Please run mysql_upgrade to create it."错误,以及"PID"获取失败的错误

5.2.3 设置mysql服务开机自启动

#加入到service服务

cp support-files/mysql.server /etc/init.d/mysqld

chmod +x /etc/init.d/mysqld

#加入到开机自启动列表

chkconfig --add mysqld

查询是否启动成功

chkconfig --list

5.2.4 修改数据库密码

#启动数据库

[root@localhost bin]# service mysqld start

#进入客户端

[root@localhost bin]# ./mysql -uroot -p

Enter password:这里输入之前的临时密码

#修改密码

mysql> set password=password('新密码');

#注意此密码必须要与其他服务器上的数据库设置的密码相同

5.3 启动数据节点

cd /usr/local/mysql

./bin/ndbd --initial

#非第一次启动,命令如下

./bin/ndbd安装后第一次启动数据节点时要加上--initial参数。在以后的启动过程中,则是不能添加该参数的,否则ndbd程序会清除在之前建立的所有用于恢复的数据文件和日志文件。

6 配置安装sql节点

分别在服务器192.168.17.133和192.168.17.134上执行以下操作。

6.1 配置my.cnf文件

mysql服务启动时会默认加载/etc/my.cnf作为其配置文件,故需要修改/etc/my.cnf配置文件。

[mysqld]

ndbcluster

datadir=/usr/local/mysql/data

basedir=/usr/local/mysql

character_set_server=utf8

default-storage-engine=ndbcluster

port=3306

[mysqld_safe]

log-error=/var/log/mysqld.log

pid-file=/var/run/mysqld/mysqld.pid

[mysql_cluster]

ndb-connectstring=192.168.17.130:1186default-storage-engine,数据库建表时的默认引擎为ndbcluster,否则数据会同步失败。

6.2 安装mysql数据库

详见 5.2 安装mysql数据库

6.3 启动sql节点

其实就是启动mysql服务。

service mysqld start

7 测试

7.1 用管理节点查看

ndb_mgm

ndb_mgm> show

Cluster Configuration

---------------------

[ndbd(NDB)] 2 node(s)

id=2 @192.168.17.131 (mysql-5.7.23 ndb-7.6.7, Nodegroup: 0, *)

id=3 @192.168.17.132 (mysql-5.7.23 ndb-7.6.7, Nodegroup: 1)

[ndb_mgmd(MGM)] 1 node(s)

id=1 @192.168.17.130 (mysql-5.7.23 ndb-7.6.7)

[mysqld(API)] 2 node(s)

id=4 @192.168.17.133 (mysql-5.7.23 ndb-7.6.7)

id=5 @192.168.17.134 (mysql-5.7.23 ndb-7.6.7)

证明,mysql cluster启动成功!

7.2 测试数据

连接任何一个sql节点,在此sql节点上操作,创建数据库、创建表结构、增删改等操作,在其他的sql节点上也会同步这些操作,使数据保持一致。

(1)这里在sql节点192.168.17.134上操作。

#登陆数据库

cd /usr/local/mysql

./bin/mysql -uroot -p

Enter password:输入密码

#创建数据库mytest

mysql> create database mytest;

#切换到mytest数据库

mysql> use mytest;

#创建表结构sys_myfirst

mysql> create table sys_myfirst(id varchar(36) primary key, name varchar(100), memo varchar(255));

#在sys_myfirst中添加几条数据

mysql> insert into sys_myfirst(id, name, memo) values('1','test1','hello world!');

mysql> insert into sys_myfirst(id, name, memo) values('2','test2','hello world haha!');

mysql> insert into sys_myfirst(id, name, memo) values('3','test3','hello world hehe!');

#查看数据

mysql> select * from sys_myfirst;

+----+-------+-------------------+

| id | name | memo |

+----+-------+-------------------+

| 2 | test2 | hello world haha! |

| 1 | test1 | hello world! |

| 3 | test3 | hello world hehe! |

+----+-------+-------------------+

3 rows in set (0.00 sec)

(2)在sql节点192.168.17.133上查看数据

#这里就省去登陆mysql客户端的步骤了

#查看数据

mysql> select * from sys_myfirst;

+----+-------+-------------------+

| id | name | memo |

+----+-------+-------------------+

| 1 | test1 | hello world! |

| 3 | test3 | hello world hehe! |

| 2 | test2 | hello world haha! |

+----+-------+-------------------+

3 rows in set (0.00 sec)

测试成功!这里每次查找出来的数据顺序不一样,其原因不难想到是,查找的数据是两个数据库来回切换导致的。

8 启动和停止集群

启动顺序:管理节点—数据节点—sql节点

停止顺序:管理节点(会同时停止管理节点和数据节点)—sql节点

以上是看网上的人都是这么说的,但是根据我的实践,其实sql节点可以一直保持启动状态(即使管理节点停止了也没关系,下次启动的时候会自动连接上此sql节点),只要第一次启动的时候遵循上面的顺序即可。

8.1 停止管理节点

停止管理节点的同时,会把其管理的所有数据节点也停止掉。

#第一种方法

ndb_mgm -e shutdown

#第二种方法

ndb_mgm

ndb_mgm> shutdown;

8.2 停止sql节点

其实就是停止mysql服务。

service mysqld stop

9 总结

到这里,mysql cluster的简单搭建就完成了。不知读者有没发现这么一个问题,因为我这里把管理节点、数据节点和sql节点都是分开的,所以在部署数据节点的时候,其实并不用去安装mysql数据库和开启mysql服务都可以。然而,这里的问题是,怎么确定在sql节点上操作的数据并不是sql节点上的数据,而是数据节点上的数据呢?

之前看到了很多网上的资料,都是自以为的数据就是存在数据节点,但是我到数据节点上找那些我曾在sql节点上操作的数据,均没有找到,反而是在sql节点上找到了那些数据库(但是没有表数据)。因此,我就在想数据库集群的数据到底是存在哪里的呢?

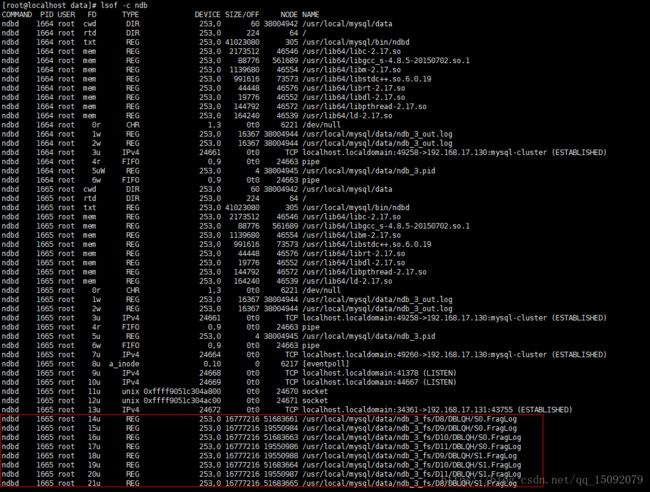

在网上找了很多资料,终于不负有心人,让我找到了,数据确实是存在数据节点上的,原来可以在数据节点上通过lsof -c ndb命令(以root身份运行)来找出包含ndb进程所有打开的文件,发现其真正存储数据的位置在mysql/data/ndb_3_fs/下面(3数字是config.ini的节点id),各个文件夹中的文件是以16.7M为单位存储的,临时文件达到16.7M后就另起一个,如图: