深度学习 10. cifar-10 介绍

本文为原创文章转载必须注明本文出处以及附上 本文地址超链接 以及 博主博客地址:http://blog.csdn.NET/qq_20259459 和 作者邮箱( [email protected] )。

(如果喜欢本文,欢迎大家关注我的博客或者动手点个赞,有需要可以邮件联系我)

今天介绍一下Dataset届元老级别的cifar-10。因为下一篇会介绍如何自己构造模型来训练cifar。

cifar-10数据集和cifar-100数据集的官方网址为:https://www.cs.toronto.edu/~kriz/cifar.html

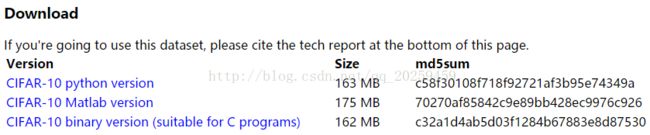

下载的地方为:

这里提供了python版本和matlab版本和C语音的版本。

其中python版本需要另行修改,matlab下载即可。

cifar-10dataset介绍:

首先我们必须要感谢提供者:Alex Krizhevsky, Vinod Nair, and Geoffrey Hinton,这几位都是深度学习的鼻祖和真正的大佬级人物,再次不仅仅要感谢他们提供cifar数据集,更要感谢他们在深度学习为我们铺好的大道。

cifar-10:

image的个数:60000

image的大小:32*32*3

class的个数:10 (飞机;汽车;鸟;猫;鹿;狗;青蛙;马;船;卡车)

注:卡车的类中只存在卡车,皮卡和suv都不在此类中。

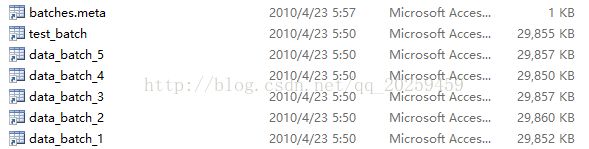

cifar-10 dataset的组成:

train batch有5个

test batch有1个

batches.meta为class的名字

每个batch的有10000个data和相对应的label

label从0到9

每一个data的大小为3073个字节,等于32*32*3。

CNN中得到训练的input:imdb的code(包含下载部分):

unpackPath = fullfile(opts.dataDir, 'cifar-10-batches-mat');

files = [arrayfun(@(n) sprintf('data_batch_%d.mat', n), 1:5, 'UniformOutput', false) ...

{'test_batch.mat'}]; %打开相应的dataset文件,包含data_batch和一个test_batch

files = cellfun(@(fn) fullfile(unpackPath, fn), files, 'UniformOutput', false);

file_set = uint8([ones(1, 5), 3]);

if any(cellfun(@(fn) ~exist(fn, 'file'), files)) %如果不存在相应文件则进行下载

url = 'http://www.cs.toronto.edu/~kriz/cifar-10-matlab.tar.gz' ;

fprintf('downloading %s\n', url) ;

untar(url, opts.dataDir) ;

end

data = cell(1, numel(files));

labels = cell(1, numel(files));

sets = cell(1, numel(files));

for fi = 1:numel(files)

fd = load(files{fi}) ;

data{fi} = permute(reshape(fd.data',32,32,3,[]),[2 1 3 4]) ;

labels{fi} = fd.labels' + 1; % Index from 1

sets{fi} = repmat(file_set(fi), size(labels{fi}));

end

set = cat(2, sets{:});

data = single(cat(4, data{:}));

% remove mean in any case

dataMean = mean(data(:,:,:,set == 1), 4);

data = bsxfun(@minus, data, dataMean);

% normalize by image mean and std as suggested in `An Analysis of

% Single-Layer Networks in Unsupervised Feature Learning` Adam

% Coates, Honglak Lee, Andrew Y. Ng

if opts.contrastNormalization

z = reshape(data,[],60000) ;

z = bsxfun(@minus, z, mean(z,1)) ;

n = std(z,0,1) ;

z = bsxfun(@times, z, mean(n) ./ max(n, 40)) ;

data = reshape(z, 32, 32, 3, []) ;

end

if opts.whitenData

z = reshape(data,[],60000) ;

W = z(:,set == 1)*z(:,set == 1)'/60000 ;

[V,D] = eig(W) ;

% the scale is selected to approximately preserve the norm of W

d2 = diag(D) ;

en = sqrt(mean(d2)) ;

z = V*diag(en./max(sqrt(d2), 10))*V'*z ;

data = reshape(z, 32, 32, 3, []) ;

end

clNames = load(fullfile(unpackPath, 'batches.meta.mat'));

imdb.images.data = data ;

imdb.images.labels = single(cat(2, labels{:})) ;

imdb.images.set = set;

imdb.meta.sets = {'train', 'val', 'test'} ;

imdb.meta.classes = clNames.label_names;

这个code在MatConvNet的cifar里面有提供,大家可以读一下,理解一下。

下一篇会用cifar来训练自己的NN。

本文为原创文章转载必须注明本文出处以及附上 本文地址超链接 以及 博主博客地址:http://blog.csdn.NET/qq_20259459 和 作者邮箱( [email protected] )。

(如果喜欢本文,欢迎大家关注我的博客或者动手点个赞,有需要可以邮件联系我)