yolov--12--YOLOv3的原理深度剖析和关键点讲解

Yolov-1-TX2上用YOLOv3训练自己数据集的流程(VOC2007-TX2-GPU)

Yolov--2--一文全面了解深度学习性能优化加速引擎---TensorRT

Yolov--3--TensorRT中yolov3性能优化加速(基于caffe)

yolov-5-目标检测:YOLOv2算法原理详解

yolov--8--Tensorflow实现YOLO v3

yolov--9--YOLO v3的剪枝优化

yolov--10--目标检测模型的参数评估指标详解、概念解析

yolov--11--YOLO v3的原版训练记录、mAP、AP、recall、precision、time等评价指标计算

yolov--12--YOLOv3的原理深度剖析和关键点讲解

yolo-v3原理深度剖析

问题

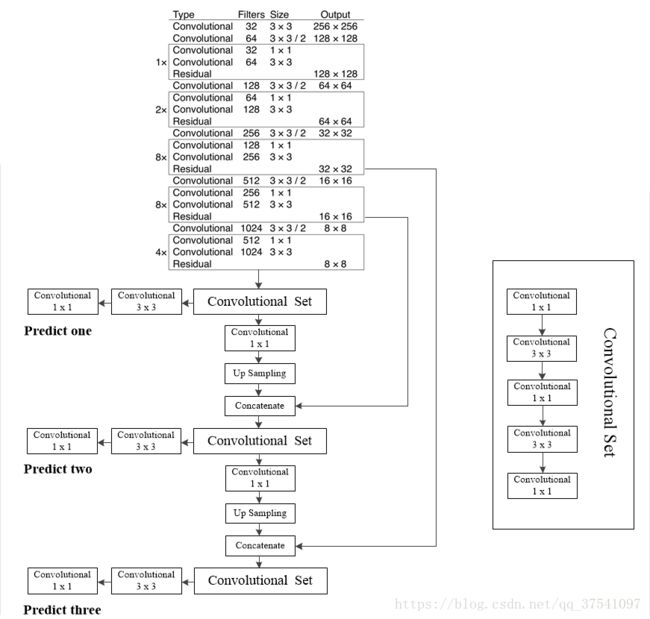

1、yolo-v3的架构是什么?

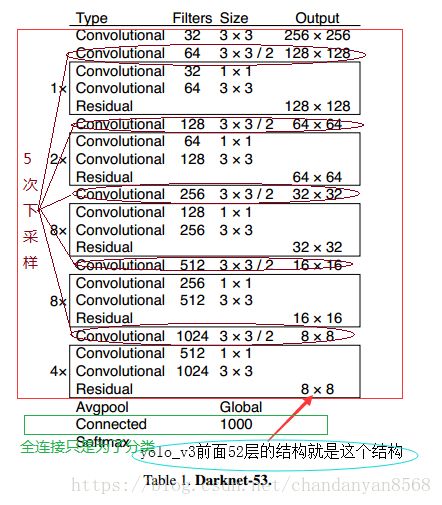

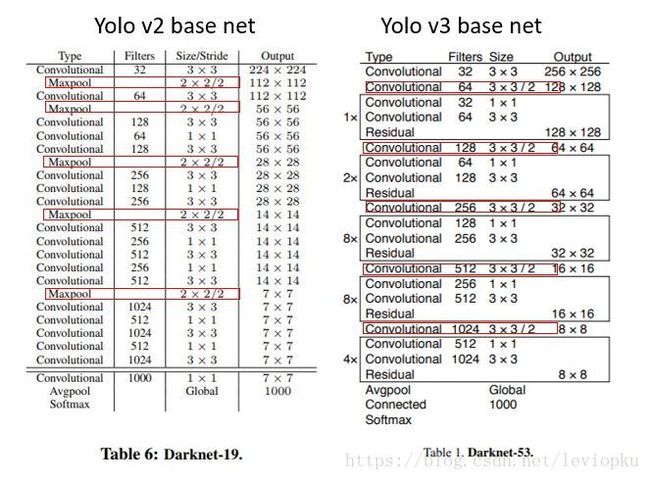

- darknet-53、顾名思义有53个卷积层

-

DarkNet_53= Conv3x3 + Sum_(下采样 Conv3x3_步长为2 + N x DarkNetBlock) ---N为下采样次数

DarkNetBlock(含2层卷积)= Conv1x1 + Conv3x3 + Residual

所以我们可以发现DarkNet-53一共有1 + (1 + 1 x 2 ) + (1 + 2 x2) + (1 + 8 x 2) + (1 + 8 x 2) + (1 + 4 x 2) +全连接= 53个卷积层。

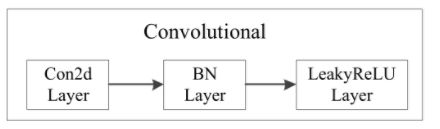

2、 每个Convolutional是什么结构?

- 与YOLO V2相同,每个Conv后面是Batch Normalization和Leaky ReLU操作,具体如图:

什么是Batch Normalization?

- 顾名思义,batch normalization就是“批规范化”。

- 作用:在深度神经网络训练过程中使每一层神经网络的输入保持相同分布。使得结果(输出信号各个维度)的均值为0,方差为1. https://www.bilibili.com/video/av16000304?from=search&seid=5165122783808131928

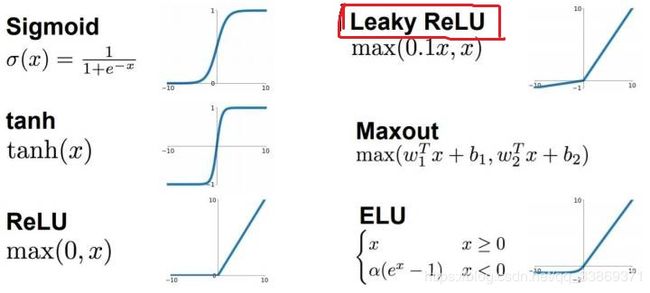

什么是Leaky ReLU?

- 见https://blog.csdn.net/qq_33869371/article/details/87885294

2、YOLO V3和YOLO V2的 backbone有什么区别和相同点?

- 整个v3结构里面,是没有池化层和全连接层的。

- 前向传播过程中,张量的尺寸变换是通过改变卷积核的步长来实现的,比如stride=(2, 2),这就等于将图像边长缩小了一半(即面积缩小到原来的1/4)。在yolo_v2中,要经历5次缩小,会将特征图缩小到原输入尺寸的1/32。若输入为416x416,则输出为13x13(416/32=13)。

- yolo_v3也和v2一样,backbone都会将输出特征图缩小到输入的1/32。所以,通常都要求输入图片是32的倍数。

可以对比v2和v3的backbone看看:(DarkNet-19 与 DarkNet-53)

- yolo_v2中对于前向过程中张量尺寸变换,都是通过最大池化来进行,一共有5次。而v3是通过卷积核增大步长来进行,也是5次。(darknet-53最后面有一个全局平均池化,在yolo-v3里面没有这一层,所以张量维度变化只考虑前面那5次)。这也是416x416输入得到13x13输出的原因。

- darknet-19是不存在残差结构(resblock,从resnet上借鉴过来)的,和VGG是同类型的backbone(属于上一代CNN结构),而darknet-53是可以和resnet-152正面刚的backbone。

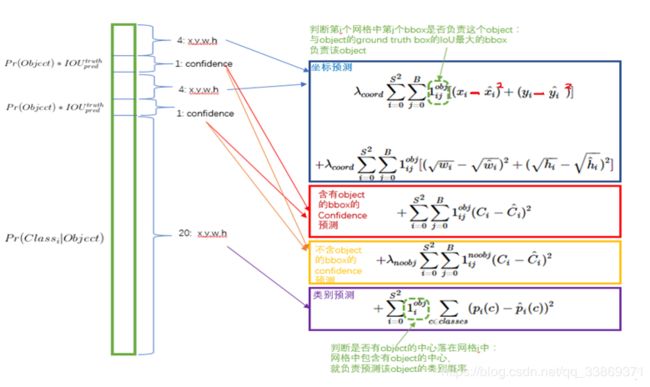

3、YOLO V1误差函数图更改

有些博客YOLO V1误差函数图有误,在此更改并强调!

https://blog.csdn.net/qq_33869371/article/details/87706617

https://blog.csdn.net/qq_33869371/article/details/90438256

https://blog.csdn.net/qq_33869371/article/details/89416062

有问题交流的小伙伴,请加微信:hy1786591,请注明 姓名_专业_学校/公司,同意后请写清楚问题 哈~,多谢!

参考:

https://blog.csdn.net/leviopku/article/details/82660381#commentBox

https://blog.csdn.net/chandanyan8568/article/details/81089083

https://www.cnblogs.com/CJT-blog/p/10457438.html

https://blog.csdn.net/qq_27825451/article/details/88971395