【视觉测量】视觉测量标定部分

1 相机标定目的

【1】进行摄像机标定的目的:求出相机的内、外参数,以及畸变参数。

【2】标定相机后通常是想做两件事:一个是由于每个镜头的畸变程度各不相同,通过相机标定可以校正这种镜头畸变矫正畸变,生成矫正后的图像;另一个是根据获得的图像重构三维场景。

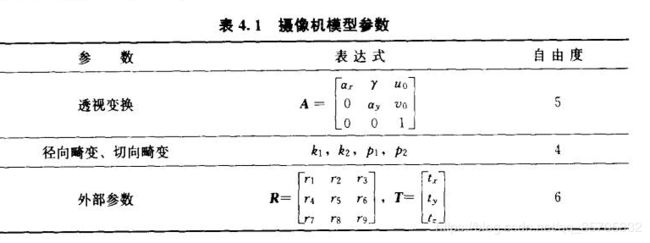

2 参数模型

为什么外部参数自由度是6? 3个旋转角度+3个平移量

内部参数为什么是8个自由度? 因为r表示u轴与v轴不垂直因子,一般为0

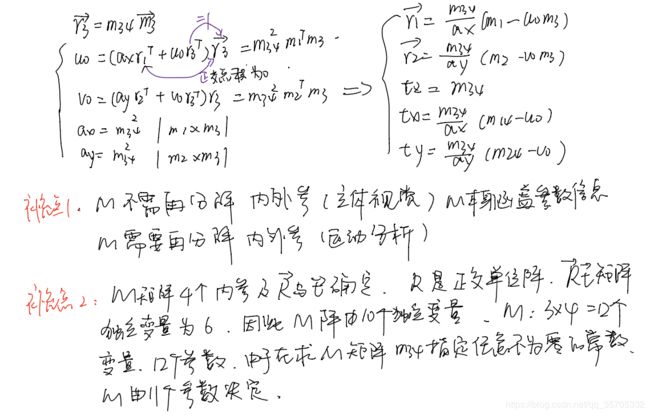

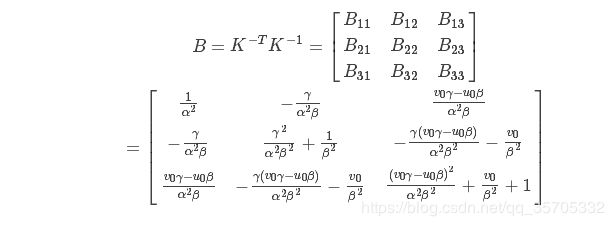

1.1 线性模型:其中A称之为内参矩阵,ax,ay是x,y的尺度因子,或称为有效焦距(ax=f/dx,ay=f/dy,f相机焦距)u0,v0相机中心。其中R,T为外参矩阵。dx,dy像元尺寸。

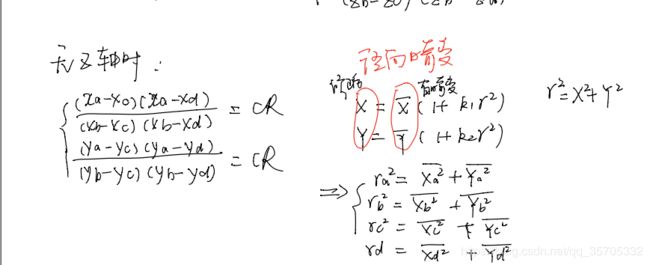

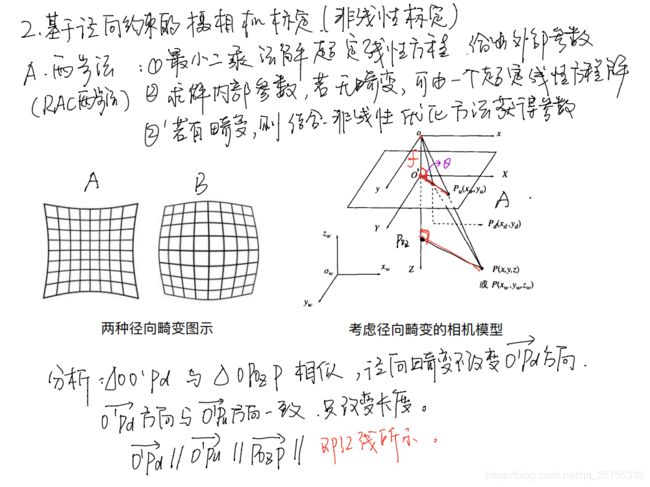

1.2非线性模型:除了线性模型的内参矩阵之外,还包括径向畸变参数和切向畸变参数。(径向畸变发生在相机坐标系转像物理坐标系的过程中。产生的原因是透镜不完全平行于图像。 )

1.3基本概念:世界坐标系-相机坐标系(以相机为光心)-物理坐标系(以图像平面中心为光心,图像坐标)-像素坐标系(以图像左顶点为中心)

1.4 旋转矩阵的特性:旋转矩阵是一个完美的矩阵——正交矩阵。正交矩阵每一列都是单位矩阵,并且两两正交。最简单的正交矩阵就是单位阵。正交矩阵的逆(inverse)等于正交矩阵的转置(transpose)。同时可以推论出正交矩阵的行列式的值肯定为正负1的。正交矩阵满足很多矩阵性质,比如可以相似于对角矩阵等等。

3 相机标定(线性与非线性)

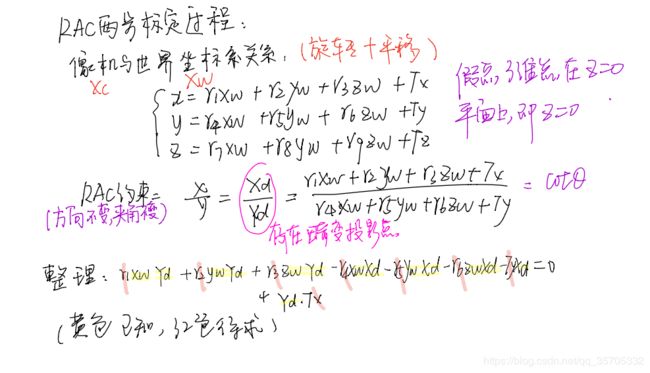

2.2非线性标定法(考虑畸变)

当镜头畸变明显时必须引入畸变模型,将线性标定模型转化为非线性标定模型。

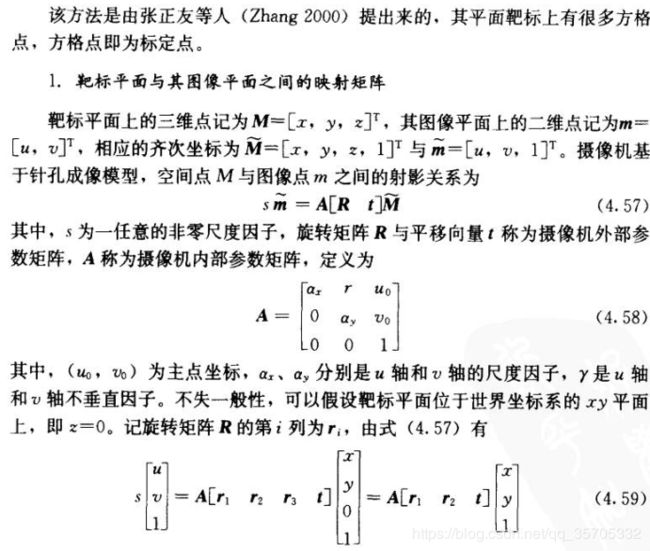

2.2.1张正友标定法: 2D平面靶

标定需要条件:从此标定可以不需要特殊的标定物,只需要一张打印出来的棋盘格。

要求:需要相机在两个以上的方位拍摄一个平面靶,相机和平面可以随意移动,不需要知道运动参数。

)

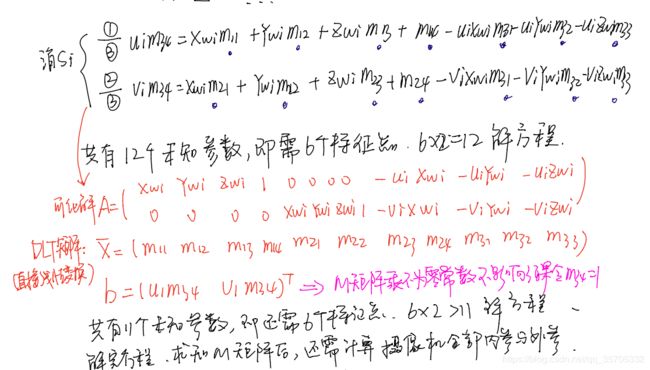

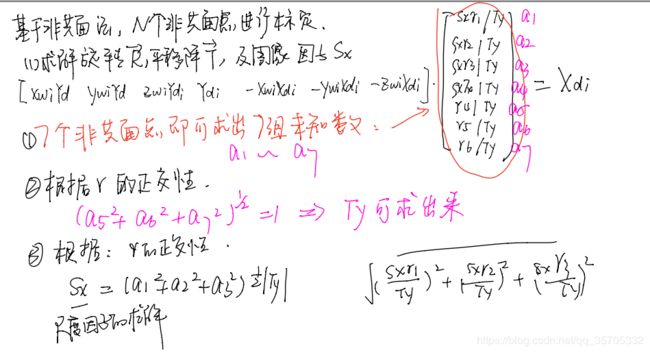

【1】求解H映射矩阵,转换矩阵

假设标定板在世界坐标系下Z平面

简化为:![]()

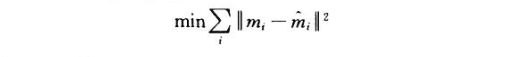

H计算的目标函数:通过RT矩阵求得的图像坐标与实际图像坐标的差值最小。

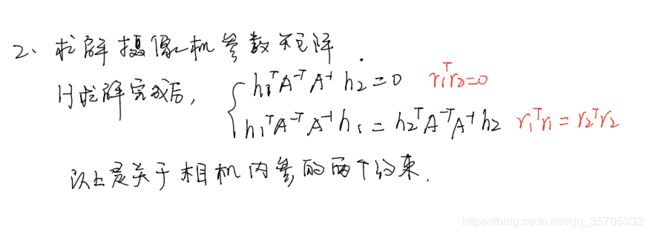

【2】求解相机参数矩阵

H矩阵是一个3*3的矩阵(其次矩阵),因为假设在Z平面,H包含16个未知数(ax,ay,r,u0,v0,r11,r12,r21,r22,t1,t2,k1,k2,k3,k4),每个点对应两个方程,总共需要4个点;因此我们至少需要8幅棋盘格平面进行标定。

基于交比不变性求解径向畸变系数(张广军)

也有论文提出采用交比不变性求得相机内参,也改变了传统的棋格标定板,采用扇形或者其他,我没有深究了。

opencv 实现标定也很简单,有对应的函数,可以直接使用。

// zhang's method.cpp: 定义控制台应用程序的入口点。

//

#include "opencv2/core/core.hpp"

#include "opencv2/imgproc/imgproc.hpp"

#include "opencv2/calib3d/calib3d.hpp"

#include "opencv2/highgui/highgui.hpp"

#include

#include

#include

using namespace cv;

using namespace std;

void main()

{

ifstream fin("calibdata.txt"); /* 标定所用图像文件的路径 */

ofstream fout("caliberation_result.txt"); /* 保存标定结果的文件 */

//读取每一幅图像,从中提取出角点,然后对角点进行亚像素精确化

cout << "开始提取角点………………";

int image_count = 0; /* 图像数量 */

Size image_size; /* 图像的尺寸 */

Size board_size = Size(9, 6); /* 标定板上每行、列的角点数 */

vector image_points_buf; /* 缓存每幅图像上检测到的角点 */

vector> image_points_seq; /* 保存检测到的所有角点 */

string filename;

int count = 0;//用于存储角点个数。

while (getline(fin, filename))

{

image_count++;

// 用于观察检验输出

cout << "image_count = " << image_count << endl;

//cout << "-->count = " << count< 第 " << j << "图片的数据 --> : " << endl;

}

if (0 == ii % 3) // 此判断语句,格式化输出,便于控制台查看

{

cout << endl;

}

else

{

cout.width(10);

}

//输出所有的角点

cout << " -->" << image_points_seq[ii][0].x;

cout << " -->" << image_points_seq[ii][0].y;

}

cout << "角点提取完成!\n";

//以下是摄像机标定

cout << "开始标定………………";

/*棋盘三维信息*/

Size square_size = Size(10, 10); /* 实际测量得到的标定板上每个棋盘格的大小 */

vector> object_points; /* 保存标定板上角点的三维坐标 */

/*内外参数*/

Mat cameraMatrix = Mat(3, 3, CV_32FC1, Scalar::all(0)); /* 摄像机内参数矩阵 */

vector point_counts; // 每幅图像中角点的数量

Mat distCoeffs = Mat(1, 5, CV_32FC1, Scalar::all(0)); /* 摄像机的5个畸变系数:k1,k2,p1,p2 */

vector tvecsMat; /* 每幅图像的旋转向量 */

vector rvecsMat; /* 每幅图像的平移向量 */

/* 初始化标定板上角点的三维坐标 */

int i, j, t;

for (t = 0; t tempPointSet;

for (i = 0; i image_points2; /* 保存重新计算得到的投影点 */

cout << "\t每幅图像的标定误差:\n";

fout << "每幅图像的标定误差:\n";

for (i = 0; i tempPointSet = object_points[i];

/* 通过得到的摄像机内外参数,对空间的三维点进行重新投影计算,得到新的投影点 */

projectPoints(tempPointSet, rvecsMat[i], tvecsMat[i], cameraMatrix, distCoeffs, image_points2);

/* 计算新的投影点和旧的投影点之间的误差*/

vector tempImagePoint = image_points_seq[i];

Mat tempImagePointMat = Mat(1, tempImagePoint.size(), CV_32FC2);

Mat image_points2Mat = Mat(1, image_points2.size(), CV_32FC2);

for (int j = 0; j < tempImagePoint.size(); j++)

{

image_points2Mat.at(0, j) = Vec2f(image_points2[j].x, image_points2[j].y);

tempImagePointMat.at(0, j) = Vec2f(tempImagePoint[j].x, tempImagePoint[j].y);

}

err = norm(image_points2Mat, tempImagePointMat, NORM_L2);

total_err += err /= point_counts[i];

std::cout << "第" << i + 1 << "幅图像的平均误差:" << err << "像素" << endl;

fout << "第" << i + 1 << "幅图像的平均误差:" << err << "像素" << endl;

}

std::cout << "总体平均误差:" << total_err / image_count << "像素" << endl;

fout << "总体平均误差:" << total_err / image_count << "像素" << endl << endl;

std::cout << "评价完成!" << endl;

//保存定标结果

std::cout << "开始保存定标结果………………" << endl;

Mat rotation_matrix = Mat(3, 3, CV_32FC1, Scalar::all(0)); /* 保存每幅图像的旋转矩阵 */

fout << "相机内参数矩阵:" << endl;

fout << cameraMatrix << endl << endl;

fout << "畸变系数:\n";

fout << distCoeffs << endl << endl << endl;

for (int i = 0; i> imageFileName;

filePath += imageFileName;

filePath += ".jpg";

//获取图片路径

Mat imageSource = imread(filePath);//读取图像

Mat newimage = imageSource.clone();//拷贝图像

remap(imageSource, newimage, mapx, mapy, INTER_LINEAR);//把求得的映射应用到图像上

//与initUndistortRectifyMap结合使用,为矫正方法之一

//undistort(imageSource,newimage,cameraMatrix,distCoeffs);//矫正方法二

//第五个参数newCameraMatrix=noArray(),默认跟cameraMatrix保持一致,故可省

imageFileName += "_d.jpg";//矫正后图片命名

imwrite(imageFileName, newimage);//保存矫正后的图片

imshow("Original Image", imageSource);

waitKey(500);//暂停0.5s

imshow("Undistorted Image", newimage);

waitKey(500);

}

fin.close();

fout.close();

getchar();//等待输入以退出

return;

}