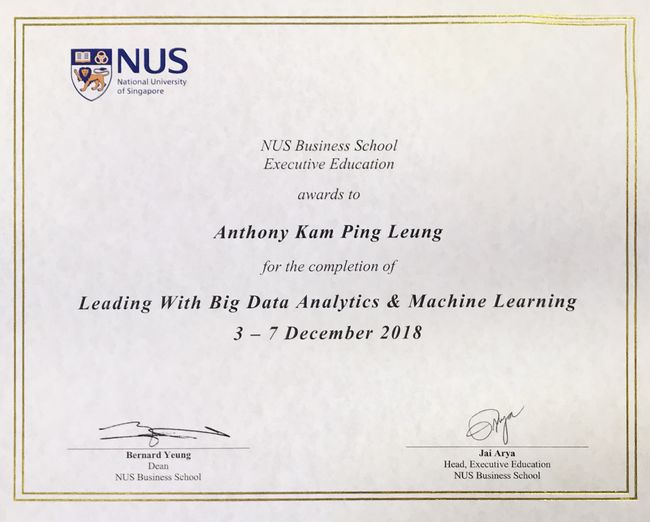

继上月到新加坡管理大学(SMU)参加 Fintech & Innovation 的课程后,上周重返校园行动再下一城,到新加坡国立大学(NUS) 参加一个为期五天的Leading with Big Data Analytics & Machine Learning 课程。

跟上次一样,这課程也得到新加坡政府90%資助,再加上可以动用五百元的 Skills Future Credit, 结果原来五千多新元的课程我只需付二百多元便可以了。算是狠狠的享受一下新加坡的国民福利!

雖然都是大学课程,但兩者在多方面都有明显不同。SMU 的课程是外包给培训公司, 导师主要是 practitioners 而不是大学教授。組織上也比較自由松散,人数很少,课程比較像workshop, 小組讨論和活动比較多,学員之间和講师都可以作較深入的交流。

NUS 的课程是由NUS Business School 主办的, 有較強的行政后勤支援,所以办得比较高规格和大规模,对学员的要求也較高。学员在上课之前已收到通知,要登入大学的網站提供个人资料,还有大量的课前阅读,都是一些著名机构如Harvard Business Review, McKinsey 等的硏究報告。开课第一天要穿西裝打領帶,因为要拍大合照,和晚上有欢迎晚宴。课程的講師都是大学教授,而且都有在世界各地私人机構工作,或从事硏究或做顧问项目,故此整个课程可以说是理論与实践並重。

感到意外的事,这次课程总共有近五十名学员,而且来源非常多元化。除了新加坡附近的国家外,粗略估計最少有十多个国藉人士,还包括不丹,厄瓜多尔,和阿联酋等冷门国家!行业方面也很多元化,有银行,医药,医療,本地及海外的政府部门,及十多个其他不同行业。比如坐在我左边的是來自体育活动推广公司,前面的是化妝品牌公司,在右边的是腦神经科專家!職位方面有毕业不久的年轻工程師及Data scientist,有 CEO, CFO, COO, 人力資源总監,市場推广总監等等,但退休人士就好像只有我一个!从学員的背景來看,可以说是达到 diversity 的極至,这也反映出大数据分析已經在全世界各行各業,各种职級等都受到了相当大程度的重视!

课程也有其懐舊之处。首先在课程和阅读資料中看到了久違了的统计学算式,如 linear regression, correlation, t-test, p-score, conditional probability 等等,其次是那个有四,五層梯級,弧形的大講室,四十年前的回忆一下子湧上來,真是百般滋味在心頭!

好了,言帰正傳!究竟課程学到了什么?什么是大数据?数据分析应怎样做?可以分享給小伙伴们吗?

老实说,五天课程只是蜻蜒点水,学了点皮毛而已,就不要班门弄斧了。但为了证明这五天不是白过的,在此便分享一下几点心得。

1. 什么是大数据?

在眾多的定义中,最有代表性的应該是大数据的4个V 了!

Volume 大量, Velocity 高速, Variety 多样化 和 Veracity 真实性 !以下一张图便可解释,我也不再作详述了。

大数据近年发展的主要动力来自电脑运算速度的不断增強,打个简单的比喻: 如果从50年代起,汽车的车速增长能跟电脑运算增速一样,那我们现在已经可以在比光速快八百万倍下飞行了!其他科技的发展如移动網絡,物联網,各种微型感应器等对数据產生的量,速度和多元花也有很大的推动,从90%的数据是在最近兩年才產生便知一二。另外云计算的普及,各种不同数据分析模型的出现,和人工智能的发展也大幅提升了分析大量数据的能力。

但專家们認为現正只是个开始,因为目前只有对极少量的数据进行分析。数据的質量和可信性,尢其是对那些unstructured data 如 文字,图片,視頻还是有待加強。

2. 企业的大数据分析是怎么进行?

简單来说有以下步驟:

1. 设定要解決的问題

2.收集数据

3. 数据清洗和預先处理

4. 选择数据分析模型

5. 反复证实分析結果,调整模型

6. 应用模型作为解決问題的方案

看來容易,但所有在课程中的講者都異口同聲說在現实中,有百分之八十到九十的大数据分析項目都是以失敗收場的!我们常听到的只是少数的成功例子。

为什么?

大部分的原因是第一步已經走錯了!很多企业根本不懂问題在那里: trying to solve the wrong problem ! 原因是企业这些大型项目大多是从上至下的(top-down), 没有从基層及客戶的角度先了解清楚问题便“追上潮流”搅大数据!

教授在課堂上舉了一个简單的超級市場例子:

在超市里,每天白菜的銷售是十五斤,芥蘭是十斤。高層们从数据看白菜比芥蘭受欢迎,所以認定应多进货白菜,决定对白菜进行市場分析硏究。但从超市售貨员和客戶的角度看,其实芥蘭每天都在早上便售罄,下午缺貨,所以他们更希望多进货芥蘭!如果一开始对问題的設定已有偏差,那么接下去的分析也是白費的。雖然這是一个极度简化的例子,但現实中有多少企业領导在決定那些大規模的項目前会先走访一下基層和客戶呢?

第二个原因是選擇了错誤的模型。

分析模型大致分为 predictive (預测性的,比如銷售需求,壞账机会率等)和 prescriptive (对策性的,比如改变策略对銷售的影响,市場推广的有效性等等)。前者重点是相关性(correlation),后者重点是因果性(causality)。 兩者有很大的分別,不可以混在一起。

舉个較有趣的例子:比如有数据分析显示穿厚衣服的人駕车失事率較高,原因不明,可能是因为冷天要穿厚衣服,而冷天路面比較濕滑,所以兩者便有某程度的相关性。但如果因为这分析結果而限制穿厚衣服來減低失事率,你想会成功嗎?

第三个原因是数据質量问题。这是整个项目中花时間最多的部分,佔大約百分之八十到九十。

最普遍的数据質量问题是人为錯誤,数据不全(missing data)和 数据偏倚(data/sample bias)。

第一项要用流程管理來解決,

第二项可以放入預設值(default value), 但如果不全的是重要数据或是有系統性的数据不全,那可能是某程度上的数据偏倚。

数据偏倚是比較嚴重的问題,直接影響到模型的效果,但是在现实里又非常普遍。比如貸款公司用自身客戶的数据分析來預測潜在新客戶的壞账率,这便是典型的 sample bias。因为自身客户只是在公司信贷審查下的成功个案,而沒有包含那些不成功申请的人的壞账率。最后的结果是模型可能排除了那些没有成功申请但又没有壞账的潜在客户,白白损失了业务机会。Sample bias 不容易解决,通常是引入外来数据補充,或在业务发展初期时以隨机的形式,用来收集足够的数据后再建立模型。

第四个原因是模型的確認和调整没有得到业务上的支持,和企业內部壁壘分明导致。

Data Scientist (通常是顧问公司或外聘员工)建好数据模型,得出的结果要交给业务部门確認和 sign-off。 但业务部门就是不賣账,“我就不認识这些,看不懂那些專业统计報告”。 于是很多项目在模型確認上遭遇到瓶頸,面对无了期的延误而导致胎死腹中。

这过程不僅需要懂得数据分析模型的data scientist, 还需要專业的业务知识才能確認和調整模型直到可以付諸应用。两者中间需要有“translator” 来協调溝通。

正因为此,市面上能同时擁有业务知识和数据分析的 Business Analyst 將会门庭若市。教授们也说他们未來课程发展的方向是结合 business, computer science 和 data science 的範畴, 企业也应该把重点放在现有员工在这几方面的综合培训上,破除壁壘,break down the silos ! 小伙伴们好好把握这个机会吧!

相比之下,收集数据和数据模型运算反而是較容易的一步。

在课程中教授也介紹了不少現成的Data Warehouse Automation tool, 还放了一个示範視頻。雖然有点technical 和大量專业名词我不太懂,但看来也真是很简單的,几乎不需要什么computer coding。听说比起傳統的建立 Data Warehouse 的流程要快上十倍!

同样地,教授也即場示範了从網站上的Data Robot 做一个数据分析。从上傳分析数据,到初步运算分析結果出來只是几分钟的时间。Robot 还提供了多达三十个的数学模型选择,还可以微调各项参数,及輸入分析数据以外的新数据来反复验证。可以預計的是,將來这些平台会越來越多,可能跟現在的excel spreadsheet 一样普及呢!

还有现在有些網站可以提供平台给企业上傳数据和註明要解决的问题,然后公开懸赏给網上的専家比賽寻找解决方案!有些奖金还高达几十万美元!

看来大数据分析这範畴將会越来越普及,越来越精彩有趣!

课程的另一部分集中在大数据在各行业的应用,和对新的商业模式的影響。另外还請來一位專业黑客講述一下網絡安全。但为了避免文章篇幅太長,决定暫且停筆,留待以后再分享。

抱歉要小伙伴们耐心等待一下!