一、前言

ConcurrentHashMap是线程安全并且高效的HashMap,其它的类似容器有以下缺点:

-

HashMap在并发执行put操作时,会导致Entry链表形成环形数据结构,就会产生死循环获取Entry,参考文章 HashMap并发导致死循环 -

HashTable使用synchronized来保证线程安全,但在线程竞争激烈的情况下HashTable的效率非常低下。

ConcurrentHashMap高效的原因在于它采用 锁分段技术,首先将数据分成一段一段地存储,然后给每段数据配一把锁,当一个线程占用锁并且访问一段数据的时候,其他段的数据也能被其他线程访问。

二、 ConcurrentHashMap 的结构

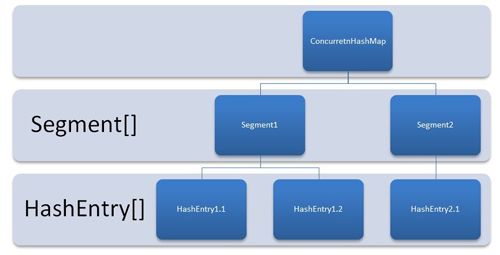

ConcurrentHashMap是由Segment数组结构和HashEntry数组结构组成:

-

Segment是一种可重入锁,在ConcurrentHashMap里面扮演锁的角色。 -

HashEntry则用于存储键值对数据。

一个ConcurrentHashMap里包含一个Segment数组,它的结构和HashMap类似,是一种数组和链表结构。

一个

Segment里包含一个

HashEntry数组,每个

HashEntry是一个链表结构的元素,每个

Segment守护着一个

HashEntry里的元素,当对

HashEntry数组的数据进行修改时,必须首先获得与它对应的

Segment锁。

Segment 结构

static final class Segment extends ReentrantLock implements Serializable {

transient volatile int count;

transient int modCount;

transient int threshold;

transient volatile HashEntry[] table;

final float loadFactor;

}

-

count:Segment中元素的数量 -

modCount:对table的大小造成影响的操作的数量 -

threshold:阈值,Segment里面元素的数量超过这个值依旧就会对Segment进行扩容 -

table:链表数组,数组中的每一个元素代表了一个链表的头部 -

loadFactor:负载因子,用于确定threshold

HashEntry 结构

static final class HashEntry {

final K key;

final int hash;

volatile V value;

final HashEntry next;

}

2.1 初始化

ConcurrentHashMap的初始化方法是通过initialCapacity、loadFactor和concurrencyLevel等几个参数来初始化segment数组、段偏移量segmentShift、段掩码segmentMask和每个segment里的HashEntry来实现的。

2.1.1 初始化 segment 数组

初始化segment的源代码如下,它会计算出:

-

ssize:segment数组的长度 -

segmentShift:sshift等于ssize从1向左移位的次数,segmentShift等于32-sshift,segmentShift用于 定位参与散列运算的位数 -

segmentMask:散列运算的掩码,等于ssize-1

if (concurrencyLevel > MAX_SEGMENTS)

concurrencyLevel = MAX_SEGMENTS;

int sshift = 0;

int ssize = 1;

//计算 segments 数组的长度,它是大于等于 concurrencyLevel 的最小的 2 的 N 次方。

while (ssize < concurrencyLevel) {

++sshift;

ssize <<= 1;

}

segmentShift = 32 - sshift;

segmentMask = ssize - 1;

this.segments = Segment.newArray(ssize);

2.1.2 初始化每个 segment

输入参数initialCapacity是ConcurrentHashMap的初始化容量,loadFactor是每个segment的负载因子,在构造方法里通过这两个参数来初始化数组中的每个segment。

if (initialCapacity < MAXIMUM_CAPACITY) {

initialCapacity = MAXIMUM_CAPACITY;

}

int c = initialCapacity / ssize;

if (c * ssize < initialCapacity) {

++c;

}

int cap = 1;

while (cap < c) {

cap <<= 1;

}

for (int i = 0; i < this.segments.length; i++) {

this.segments[i] = new Segment(cap, loadFactor);

}

cap 是 segment 里 HashEntry 数组的长度,它等于initialCapacity / ssize,如果c大于1,就会取大于等于c的2的N次方。segment的容量threshold等于(int) cap * loadFactor,默认情况下initialCapacity等于16,ssize等于16,loadFactor等于0.75,因此cap等于1,threshold等于0。

2.2 定位 segment

在插入和获取元素的时候,必须先通过散列算法定位到Segment,ConcurrentHashMap会首先对元素的hashCode()进行一次再散列。

private static int hash(int h) {

h += (h << 15) ^ 0xffffcd7d;

h ^= (h >>> 10);

h += (h << 3);

h ^= (h >>> 6);

h += (h << 2) + (h << 14);

return h ^ (h >>> 16);

}

再散列的目的是减少散列冲突,使元素能够均匀地分布在不同的Segment上,从而提高容器的存取效率。

2.3 操作

2.3.1 get 操作

segment的get操作过程为:先进行一次再散列,然后使用这个散列值通过散列运算定位到Segment,再通过散列算法定位到元素。

public V get(Object key) {

int hash = hash(key.hashCode());

return segmentFor(hash).get(key, hash);

}

get操作的高效之处在于整个get过程不需要加锁,除非读到的值为空才加锁重读。在它的get方法里,将要使用的共享变量都定义成volatile类型,如用于统计当前segment大小的count字段和用于存储值的HashEntry的value,定义成volatile的变量,能够在线程之间保持可见性,能够被多线程同时读,并且保证不会读到过期的值,在get操作里,只需要读而不需要写共享变量count和value,所以可以不用加锁。

transient volatile int count;

volatile V value;

2.3.2 put 操作

由于put方法需要对共享变量进行写入,所以为了线程安全,在操作共享变量时必须加锁。put方法首先定位到Segment,然后在Segment里进行插入操作。插入操作需要经历两个步骤:

- 判断是否需要对

Segment里的HashEntry数组进行扩容 - 定位添加元素的位置,然后将其放在

HashEntry数组里

2.3.3 size 操作

如果要统计整个ConcurrentHashMap里元素的大小,就必须统计所有Segment元素的大小后求和,虽然每个Segment的全局变量count是一个volatile变量,在相加时可以获取最新值,但是不能保证之前累加过的Segment大小不发生变化。

因此,ConcurrentHashMap会先尝试2次通过不锁住Segment的方式来统计各个Segment大小,如果统计的过程中,容器的count发生了变化,则再采用加锁的方式来统计所有Segment的大小。

检测容器大小是否发生变化的原理为:在put、remove和clean方法里操作元素前会将变量modCount进行加1,那么在统计size前后比较modCount是否发生变化,从而得知容器的大小是否发生变化。

三、参考文献

<<Java并发编程的艺术>> - Java并发容器和框架