添加iSCSI设备比较简单,在主机-》配置-》存储适配器-》iSCSI SoftwareAdapter下的vmbaxx的属性

在打开的窗口里点击动态发现,iSCSI服务器里填入192.168.100.10,保证这个IP和VMware主机可以通信即可,md3200i有8个IP地址,当你添加后,会在静态发现里面显示出md3200i所有的8个IP。如果不是所有的IP都可以和VMware主机通信,不必担心,MD3200i自己会做出判断,形成路径的时候只会显示可以成功连接的路径。

添加完成之后会提示是否扫描磁盘,如果在前面MD3200i里通过拷贝VMware的WWN值,新建主机端口标识符进行添加万主机的就可以让它扫描磁盘,如果还没有添加,而是如提示的那样等待,那么这时候在回到MD3200i添加主机的操作界面,点击上面的通过选择已知的无关联主机端口标识符进行添加,通过下拉菜单就会看见新的值,对比一下VMware里面iSCSI SoftwareAdapter下的vmbaxx的属性的值是否一致。然后完成主机的添加。

回到VMware界面。扫描磁盘,会出现在MD3200i里面定义的那2个虚拟磁盘,那两个磁盘一定要分开做成两个盘,绝不能把那两个盘合并成一个,为了手动冗余嘛,不然在md3200i里何必做两个虚拟盘呢。

稍后一些时间,就会在存储器里看到做成的两个盘。

C0和C1分别对应的就是控制器0和1,远程的iscsi存储一般要开启Storage I/O Control,点击磁盘,属性,选择已启用,高级里面的拥堵阀值默认就好,除非是网络响应慢再修改。

C0和C1分别对应的就是控制器0和1,远程的iscsi存储一般要开启Storage I/O Control,点击磁盘,属性,选择已启用,高级里面的拥堵阀值默认就好,除非是网络响应慢再修改。

这样就有了可以用的网络存储了。但是这还没完,这样默认配置是无法实现负载平衡的。

点击右下角的管理路径,出现一个新窗口

我这个图是已经修改过的,路径选择默认值固定,这时候应该看到只有一个活动(I/O),当所有4个都是活动的时候才去修改路径选择为循环,就是所谓的轮询Round-Robin,修改过后能看见多了一个活动(I/O),这时候才是两个网卡负载平衡通信了。

下面截个图能看见详细的图。

ESXi03vmnic1网络接口 192.168.100.31/26 vlan200,当通过iSCSI发现存储的IP和其同一网段有两个IP192.168.100.10和192.168.100.11的时候,IP都是可以到达的,但这两个网卡是分属于两个控制器,由于md3200i是强制磁盘绑定控制器,这时md3200i只在IP192.168.100.10响应I/O通信,在VMware里面虽然192.168.100.11可以通信(就是些探知死活的通信),但是不走数据,同样另外一个活动的I/O是在192.168.100.70上,这个IP也是在控制器0上,查看(一)里有IP和控制器的列表。只有当控制器0死了,才会调迁移192.168.100.11和192.168.100.71,当一个网线断了,会只有一个网卡通信,而不会发生虚拟磁盘的绑定从0控制器迁移到1控制器,变成双网卡通信的情况。

从交换机的配置就可以看出,控制器0的网线接着两个交换机上。MD3200i的白皮书(见powervault-md3200i_Setup Guide_zh-cn第29页),该书描述一个控制器的4个网卡,两两分别接到两个交换机上。这个接续方法考虑良久。以下为该书截图。

原来考虑了一个方案,就是控制的所有接口集中接在一个交换机上。服务器为了冗余,双网卡必须分别接续在两个交换机上,这样两个交换机必须能通信,接到一个交换机上的网卡,而活动的控制器接续在另外一个交换机上,就需要通过中继线到另外一个交换机上,效率不高,占用中继线的带宽;另外如果一个交换机死了,必然会发生虚拟磁盘从一个控制器迁移到另外一个上,不利于稳定,这样迁移也不会换来带宽增加,因为肯定有一个网卡由于交换机的死而不能用,没意义。放弃该方案。

而控制器的接口两两接续到两个交换机,那么一个交换机死了,另外一个交换机还能继续原通信控制器的数据收发,这样虚拟磁盘就不会发生控制器迁移。两个网卡分别接续到两个交换机,也实现流量分别在两个交换机上转发,分散了流量压力,不然都集中到一个交换机上了。

下面说一下只有两个网卡的VMware的接续方法。

本例VMware使用了vcenter里的vSphere Distributed Switch,两个网卡为了冗余均加入vSphere Distributed Switch,对于这样只有两个网卡的机器,使用vlan 202 name SAN2、vlan 203 name SAN3作为存储网段,这个主机的网卡也接在这两个交换机上,已经做了vlan202和203,并在switchport trunk allowed vlan加入202和203

interface GigabitEthernet0/15

description ESXi01vmnic0

switchport trunk encapsulation dot1q

switchport trunk allowed vlan 5-12,100,101,202,203

switchport mode trunk

storm-control broadcast level 10.00

storm-control multicast level 5.00

storm-control action shutdown

spanning-tree portfast trunk

使VMware的分布式交换机可以访问到存储的vlan网段。

下面是要VMware的分布式交换机可以有与之对应的分布式端口组。

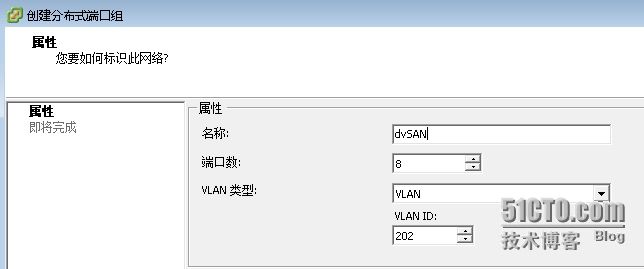

打开VMware vcenter管理的 主页-》网络-》创建新的端口组,

创建两个,一个vlan202,一个vlan203.

在主机-》配置-》网络里,看到vSphere标准交换机内容是空的,点击打开vSphere Distributed Switch,点击管理虚拟适配器,应该最少已经存在一个vmk*了。

添加,新建虚拟适配器,只有vmkernel可以选,下一步,选择端口组的下拉菜单里找到刚才做的dvSAN2

同样这里也不能选择vMotion和FT,也不能用于管理流量,配上IP地址:192.168.100.141/26

继续做一个vmk,端口组选vlan203的,配上IP地址:192.168.100.211/26

然后和刚才exsi03机一样在存储适配器里,用动态发现192.168.100.141,完成添加,不要忘了在MD3200i里也要加上esxi01的主机哦。

由于是vcenter在进行全局管理,这时候在存储器里直接就能看见在esxi03上做的那两个虚拟磁盘,不要配置了,自动出现。

虽然esxi03是用IP192.168.100.10和70访问的,esxi01使用192.168.100.130和200访问,但是vcenter自动就辨识它们是一个。什么原因,可以流量存储内容,看见一个.naa.6c81f66000ccc02500000960555464ff这样一个文件夹,里面有一个slotsfile的文件,.naa.6c81f66000ccc02500000960555464ff其实就是存储的虚拟磁盘全局标识符:6c:81:f6:60:00:cc:c0:25:00:00:09:60:55:54:64:ff,.naa后面的值和md3200i里虚拟磁盘全局标识符相同。依靠这个确定是同一块磁盘,虽然访问的途径不同。

虽然两个虚拟磁盘不用配置,那么配置是不是一定和esxi03配置的时候完全一样,不是。在是否采用轮询的负载平衡方式上,是各自主机独立配置的。

由于采用了分布式交换机,做了两个vmk网卡,又不让其做管理用,那么VMware的智能分配就起作用了,两个网卡分别连接到两个物理网卡上。

例证:

SW3560G-A#sh mac address-table | in 0050.566e.e54a

202 0050.566e.e54a DYNAMIC Gi0/15

SW3560G-B#sh mac address-table | in 0050.566f.291a

203 0050.566f.291a DYNAMIC Gi0/15

这样给我们使用负载平衡提供了基本要件,不过要不要使用还是仁者见仁智者见智,毕竟是由VMware动态分配的,万一它一糊涂分配到了一个物理网卡上哪就没啥意思了。本人就没有启用负载动态平衡。

VMware的网络部分进行动态负载平衡,md3200i只能在控制器0和1之间进行手动的负载平衡。

通过建立客户机(guestos)的磁盘位置,分布在两个磁盘上进行平衡流量压力。那么能不能这个工作让系统自动做呢。VMware提供了数据存储和数据存储集群就可以提供这样一个服务。

在VMware管理的 主页-》数据存储和数据存储集群-》某数据中心 右击-》新建数据存储集群

自动化级别,一般还是不要搞全自动,自己还能控制些。

这些默认就好。都是人家经过N次试验的结论,没有特殊要求就不要变了。

这些默认就好。都是人家经过N次试验的结论,没有特殊要求就不要变了。

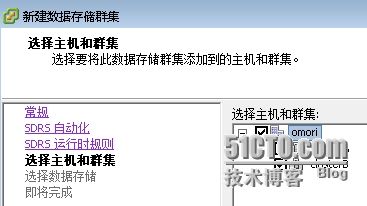

所有都要选,所有主机都可以服务。

因为我已经添加了,所以那两个md3200ic0和c1的磁盘没有显示出来,选中那两个磁盘。

因为我已经添加了,所以那两个md3200ic0和c1的磁盘没有显示出来,选中那两个磁盘。

下一个画面就是完成。

建成后,在数据存储里能看见那两个盘。

这之后,在VMware主机的存储器里只能看见实际的md3200i的两个磁盘,但是客户机不仅仅可以使用磁盘,也可以使用数据存储集群。

这之后,在VMware主机的存储器里只能看见实际的md3200i的两个磁盘,但是客户机不仅仅可以使用磁盘,也可以使用数据存储集群。