本篇文章是对Python爬虫入门学习视频:Python网络爬虫实战第5,6,7节内容的归纳。

在这里,你会看到如何使用BeautifulSoup——select语句提取标签内文本,以及取得有特定css属性的元素,学会这些,你就可以开始爬取简单的静态网页了

事先声明,本段BeautifulSoup用法介绍基于此代码

html_sample = '\

\

\

Hello World

\

This is link1 \

This is link2 \

\

'

而我,将从Python爬虫学习事前所需准备,BeautifulSoup代码基础用法和运行结果2个部分,进行本次介绍。

1.事前准备:初学BeautifulSoup,你需要些什么?

假定你是一位,懂一点基础的代码语言逻辑,但是对爬虫学习还一无所知的Python小白用户。

那么,在刚开始学习Python爬虫的时候,你需要准备以下事情

1.准备一个编辑器:比如Jupyter notebook

2.准备一个Python软件:本文用的是Anaconda,里面的python是3.6版本(P.S.:Windows用户的话,使用Anaconda最好,因为它会自带很多库)

3.准备一个BeautifulSoup4库:如果你使用的是Anaconda,那么系统会自带这个库,你也无需为这个烦心。当然,如果你使用的是原生python,请使用pip install beautifulsoup4 语句进行安装

4.了解一些基础的网页结构知识

当然,如果你和我一样,是一位之前对网页结构一点也不懂的人,那么你可以通过右边视频进行补充,只要看第一节内容就够了Python学习之认识网页的构成

以上这些,都是你在Python爬虫学习中一定会用到的,最基础的学习设施。

如果已经确认你电脑中有了那些东西,那么请往下看~

2.开始学习:BeautifulSoup代码基础用法和运行结果

恭喜,你开始了自己学习Python爬虫的第一步。

在这里,你会知道以下3件事情,1.BeautifulSoup能用来干嘛,2.如何选择特定标签里的内容?3.如何取得具有css属性的元素?

先介绍第一个,BeautifulSoup能干嘛。BeautifulSoup 是用Python写的一个HTML/XML的解析器,你可以用其来提取网页中的文本内容,来感受下它的具体操作方法。

首先你要导入bs库,代码如下

from bs4 import BeautifulSoup

#从bs4中导入BeautifulSoup

接着,创建一个beautifulsoup 对象

soup = BeautifulSoup(html_sample,'html.parser')

在这时候,打印输出文本内容

print(soup.text)

结果是这样的

这就输出了代码里的全部文本

当然如果你觉得,这样做太笼统,你想选择特定的标签内容

做法也很简单,用select语句即可,完整的代码示例如下

from bs4 import BeautifulSoup

html_sample = '\

\

\

Hello World

\

This is link1 \

This is link2 \

\

'

soup = BeautifulSoup(html_sample,"html.parser")

header = soup.select("h1") #用select语句选择h1标签内容

接着,输出header

print(header)

此时的结果是一串完整的h1标签列表

[ Hello World

]

如果想把列表里的内容取出,那么输入列表下标

print(header[0])

此时的结果显示如下

Hello World

如果只想获取标签里的文本内容,那么使用text属性即可~

print(header[0].text)

结果如下Hello World

a标签的大概用法和h1标签相同

区别在于,a标签是有2条标签语句,需要使用for循环打印出来。

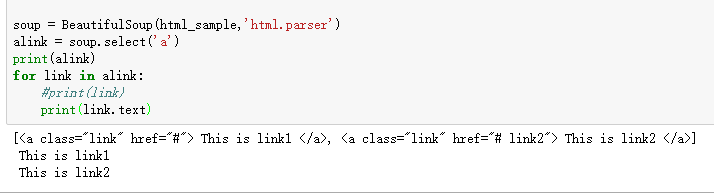

soup = BeautifulSoup(html_sample,'html.parser')

alink = soup.select('a')

print(alink)

for link in alink:

print(link)

在这里,如果想获取文本内容,直接在a标签后加入text属性

3.如何取得具有CSS属性的元素

在以上代码里,具有css属性的标签如下

Hello World

\

This is link1 \

This is link2 \

而在这些标签中,我们可以利用id值和class值取获取标签内容

用法和查找a标签,以及h1标签类似,只是需要在属性值前加入特殊符号

示例

1.查找所有id为title的元素(id前加#号)

soup = BeautifulSoup(html_sample,'html.parser')

alink = soup.select('#title')

print(alink)

输出结果和h1标签查找结果相同

2.查找所有class为link的元素(class前加.)

soup = BeautifulSoup(html_sample,'html.parser')

alink = soup.select('.link')

for link in alink:

print(link)

输出结果和查找a标签结果相同~

最后,BeautifulSoup的基础用法暂时讲到这

学会以上基础内容,你就具备了最基础的网页爬取能力了

建议找新闻网站,或者普通论坛试试手