Adversarial Camouflage: Hiding Physical-World Attacks with Natural Styles

组员:张荣华 黎君玉 杨根

1问题描述

神经网络(DNNS)是一类功能强大的模型,在各种人工智能系统中得到了广泛的应用,但其易受到对抗例子的攻击。

未来我们的社会必定是一个自动化的环境,比如智能家居,智能安防,自动驾驶等,很多的岗位通过一个传感器,摄像头、扫描仪就可以直接完成,而不需要人来干预。神经网络技术目前在占据重要的地位,如果目标检测,人脸识别中,有不怀好心之人入侵你的系统中,利用神经网络的特点,将非法的输入进行一些伪装,从而骗过网络得到被网络认为是合法的输出,那带来的损失和危害也会是巨大的。

2 解决方案

本文作者,提出一种新的方法,称为“对抗伪装”(AdvCam),将物理世界中对抗的例子加工和伪装成自然的风格,使之在人们观察者看来是合理的,并以此来测试DNN的鲁棒性。

3相观技术概念

对抗攻击:我们先用最直观的方式认识一下什么是对抗攻击?如下图,左边是一张能够被GoogLeNet正常分类为熊猫的图片,在添加一定的噪音后变成右图,在人的肉眼看来,它还是熊猫,但GoogLeNet会判定为长臂猿。这种被修改后人类无法明显察觉,却被机器识别错误的数据即为对抗样本,而这整个过程就可以理解为对抗攻击

物理世界攻击:现实世界中具有较大且不太现实的失真(很容易被人类观察者识别)创建的对抗示例。

数字攻击:通过较小的和不易察觉的扰动创建的数字对抗示例。

4设计理念

4.1 相关说明

- 可以使用三种特性来表征对抗性攻击:

- 1)对抗性,它代表愚弄DNN的能力;

- 2)对抗性的隐秘性,即观察者是否可以检测到对抗性干扰;

- 3)伪装灵活性,即攻击者可以控制对抗性图像的外观 的程度。

大多数攻击方法都针对数字环境而开发,例如“投影梯度下降”(PGD),对于数字攻击,通常很小的扰动就足够了。但是,物理世界的攻击需要较大的甚至是不受限制的扰动,因为较小的扰 动太微妙,无法被复杂的物理世界环境中的相机捕获。已经存在几种比较小的扰动攻击方法,例如对抗补丁( adversarial patch :AdvPatch)和强大的物理扰动(RP2)。

4.2 总体框架

4.3 具体实现

4.3.1 Style loss

- 对于传统攻击,度量隐匿性的标准: D(x , x’ ) = || x − x’ || p其中||.|| p是L p的范数,通常使用的是L2和L∞ ,这是为了将扰动限制到很小。 对于论文提出的伪装,隐匿性由对抗性示例x ’和样式参考图像x s之间的样式指标来衡量。 可以通过样式表示中的差异来定义两个图像之间的样式距离:

4.3.2 Content loss

- 前面的样式丢失可以在参考样式中生成一个对抗图像,但是对抗图像的内容可能与原始图像的内容有很大的不同。内容丢失如下定义:

4.3.3 Smoothness loss

- 对抗图像的平滑度可以通过减少相邻像素之间的变化来提高。 对于对抗图像x ’,平滑度损失定义为:

4.3.4 Adversarial loss

- 对于对抗性损失,论文中使用以下交叉熵损失:

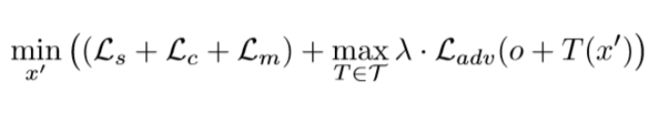

4.3.5 Adaptation for Physical-world Conditions

- 为了使AdvCam生成的对抗在物理上可实现,我们在生成伪装对抗的过程中对物理条件进行建模。由于 物理世界环境经常涉及条件变化,例如视点移动,相机噪声和其他自然变换,因此我们使用一系列适 应方法来适应这种变化的条件。特别的,我们采用与转换期望(EOT)类似的技术,但是却没有期望。我们的目标是在各种物理条件下改进对抗性示例的适应性。因此,我们考虑了用于模拟物理世界条件波动的转换,包括旋转,缩放比例大小,颜色偏 移(模拟光照变化)和随机背景.

5 实验环境

文章作者提出把AdvCam攻击与两种现有的代表性方法:PGD和adversarial patch (AdvPatch)进行了比较。

威胁模型的选择:我们在数字和物理环境中测试了有针对性和无针对性的攻击。威胁模型采用灰盒设置:源网络和目标网络均为VGG-19网络,但在ImageNet上分别训练。

作者从三个方面设置实验:1)伪装区域的形状和位置,2)伪装的损失和平滑度损失(例如风格损失、内容的损失),和3)对抗的强度参数λ和区域大小。

1) 伪装区域的形状和位置

给定一个选定的袭击地区的形状和大小,我们增加强度参数λ的区间[100,1000]:

2) 伪装的损失和平滑度损失

三组经过伪装的对抗示例,其中包含或不包含两个可选增强(内容保存Lc和平滑性增强Lm)。当将一个增强,其损失函数是直接添加到最终的对象按照Eq。

3) 对抗的强度参数λ和区域大小

工艺目标和没有针对性伪装攻击随机选择50 2000 ImageNet测试图像类别不同λ(1000、10000)。对于有针对性的攻击,目标类是随机选择的,与真实类不同。

5.1数字攻击

文中作者从ImageNet ILSVRC2012测试集的5个类别中随机选择150张干净的图像,然后应用PGD、AdvPatch和我们的AdvCam三种方法为每张干净的图像制作一个有针对性的对抗示例。对于PGD和AdvCam,我们对人工选择得到的主要目标区域进行攻击,而对于AdvPatch,我们在目标区域内进一步选择一个圆形的攻击区域。For PGD, 我们 使用 最大 扰动 = 16/255 (denoted PGD-16).AdvCam,我们随机选择一个图像从同一类别的风格形象,从1000年到10000年,逐步增加λ,直到找到一个敌对的例子。

5.2物理攻击

文中作者进一步设计了三个物理世界攻击场景来测试我们的AdvCam攻击的伪装能力。我们还执行AdvPatch和PGD攻击进行比较。

6优缺点

优点:

1.AdvCam是一种灵活的方法,可用于dnn模型的鲁棒性评估。

2.AdvCam可以作为一种有意义的伪装技术来保护目标或人被人类观察者和基于DNN的设备发现。

缺点:

- 目前提出的AdvCam仍然需要攻击者手动指定攻击区域和目标样式,我们计划在未来的工作中探索语义分割技术来自动实现这一点。

7总结分析

文中作者提出对抗攻击可应用于数字场景,攻击者可以将输入的数字图像直接输入到DNN分类器中;物理世界设置,DNN分类器只接受来自摄像机的输入,攻击者只能向摄像机呈现具有对抗性的图像。使用三种特性描述:对抗性强度,它表示愚弄DNNs的能力;对抗性隐形,它是关于对抗性干扰是否能被人类观察者探测到的;伪装的灵活性,也就是攻击者能够控制对手形象出现的程度。

继续探讨AdvCam在其他计算机视觉任务中的应用,包括目标检测和分割。并且针对伪装攻击的有效防御策略方向深入研究。