前言:

commonsense这一方向好多的论文都是和数据集有关。

这里整理了一下 到目前为止allen ai实验室论文所提到的数据集。

0.SWAG

简介

一个多项选择的数据集。包含丰富的生活常识和情境。

来源于视频的字幕。格式如下:

第一个句子。名词性短语(np)+动词短语。

就是根据常识,判断由前边一个句子,来推测下来np会怎么样。

例如:

On stage, a woman takes a seat at the piano. She

a) sits on a bench as her sister plays with the doll.

b) smiles with someone as the music plays.

c) is in the crowd, watching the dancers.

d) nervously sets her fingers on the keys.

正确答案为粗体部分。来源于原始字幕,且经过标注人员的审视。

负例由对该语料微调过的语言模型生成。

作者指出,使用简单的统计方法,例如n-gram。就能达到很好地效果,

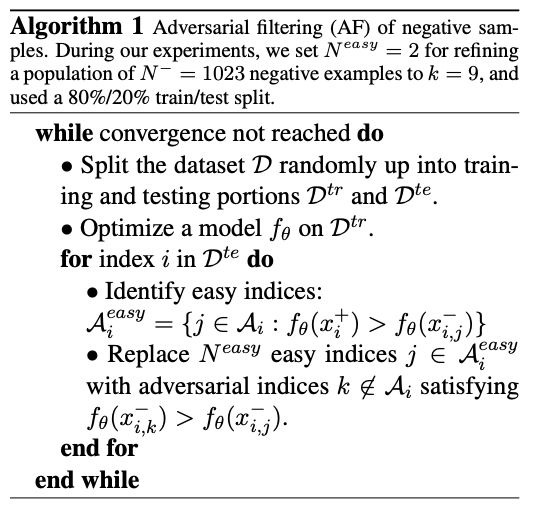

为了避免这种简单的“游戏”模式,使用了Adversarial Filtering。

解决办法:

使用语言模型 将选项带入,看那个句子的概率高

1.MCTACO(多种类型时间常识推理)

这是一个时间常识推理的数据集。

与以往时间常识推理的数据集不同,这个数据集对问题进行了细化。

主要分为五种问题:

1.状态。 如某某是否还在

2.特定的事件事件。 如二战时间

3.时间跨度。 如演唱会持续时间

4.事件顺序。 如灾区接受了捐赠之后发生了什么(收到捐款)

5.时间频率。 如美国总统选举时间。

v

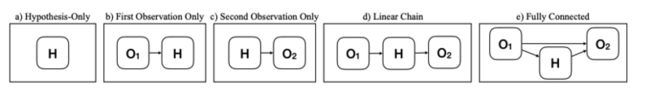

2.αNLI(归纳性常识推理)

Abductive Commonsense Reasoning

归纳性常识推理:是我们对不完全观察到事情的情况下,做出最为合理的解释。

例如:珍妮打扫了房子然后去上班,窗户上还破了一个洞(o_1)。回来的时候,她看到自己的房子一片狼藉(o_2)。推理,缺失的部分事实(即发生了什么导致房子一片狼藉)。(H_1,H_2,...H_n)

在这里,我们仅仅知道部分事实,即珍妮去上班,并且窗户破了个洞,不知道上班的时候家里发生了什么。根据结果,房子一片狼藉,推测可能发生的事情。

方法:

1,2,3.略

4.o1去推测h然后在推测o2

5.在4的基础上又利用了原有的o1信息

3.COSMOS QA(常识阅读理解)

COSMOS QA: Machine Reading Comprehension with Contextual Commonsense Reasoning

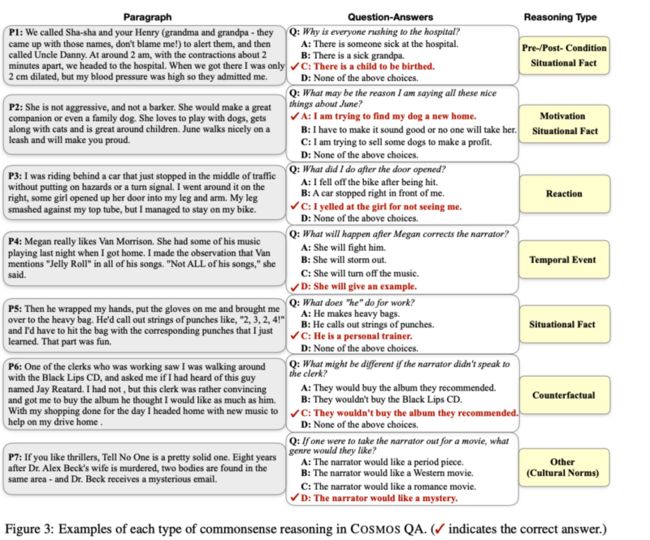

找出事件的原因,或者事件的影响。在文中并未明确给出答案。需要根据上下文根据常识来判断。包含但是不限于以下四种类型问题。

Cosmos QA: Machine Reading Comprehension with Contextual Commonsense Reasoning

Causes of events: What may (or may not) be the plausible reason for an event?

Effects of events: What may (or may not) happen before (or after, or during) an event?

Facts about entities: What may (or may not) be a plausible fact about someone or something?

Counterfactuals: What may (or may not) happen if an event happens (or did not happen)?

与传统阅读理解不同的是,传统阅读理解注重在事实和语义逻辑上。但是本文是人的日常叙事。绝大多数(93.8%)需要上下文常识推理。

示例:

数据集分布

最佳模型(BERT with multiway attention)

这个模型效果比原生的Bert效果好了一点点,不明显。

Knowledge Transfer Through Fine-tuning

对相似任务或数据集进行微调来知识转移。

其中前三个是使用了SWAG,RACE数据集训练,并且直接使用到本文章的数据测试集上来。 效果提升一般,主要是使用了SWAG有提升,使用RACE反而会有干扰。

错误分析

1.复杂的上下文理解。

以图6中的P1为例,为了正确预测答案,我们需要结合该女性在自杀之前尝试自杀但失败的背景信息,自从决定离开后就整理床铺,然后乘坐电梯前往 屋顶,然后推断该女子正试图再次自杀。

2.常识理解错误

如图2,没有找到日护中心,会准备怎么办?根据人的常识,肯定知道应该是找保姆,而不是把孩子单独留在家里。 (其实这个保姆我不认识,让我做我也有可能选C)

3.多轮推理

聊天->没睡觉->头疼==》不聊天->睡觉->不头疼

4.Unanswerable Questions:

“None of the above”未在文中直接提出,较难选

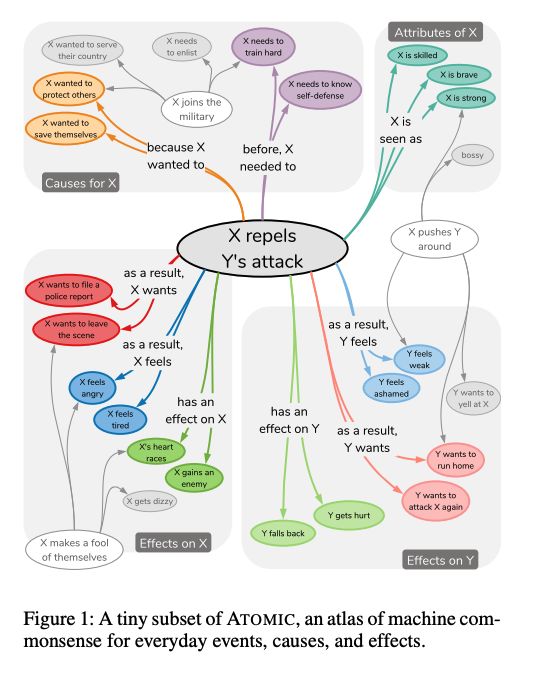

4.ATOMIC (日常常识推理知识图谱)

ATOMIC: An Atlas of Machine Commonsense for If-Then Reasoning

ATOMIC专注于以类型化的if-then与变量的关系进行组织的推理知识(例如,“如果X向Y赞美,那么Y可能会返回赞美”)

知识图谱示例

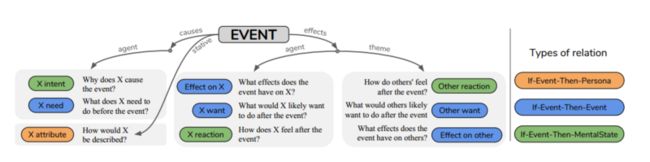

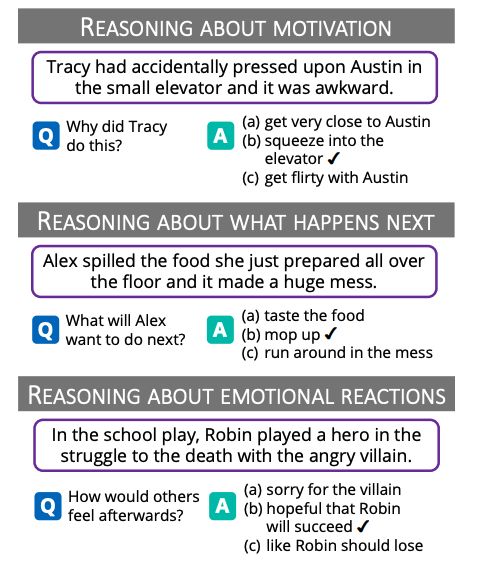

4.SOCIAL IQA

SOCIAL IQA: Commonsense Reasoning about Social Interactions

用于推测他人的心里状态和行为的常识数据集(无法从文章直接找出答案)