简介

为时间序列分析提供了很好的支持。名称来源于面板数据。

数据结构

Series:一维数组,与Numpy中的一维array类。二者与python基本数据结构list也很相近。Series如今能保存不同种数据类型,字符串、boolean值、数字等都能保存在Series中。

Time-Series:以时间为索引的Series.

DataFrame:二维的表格型数据结构。很多功能与R中的###data.frame类似。可以将DataFrame理解为Series的容器。

Panel:三维的数组,可以理解为DataFrame的容器。

Panel4D:是像Panel一样的4维数据容器。

PanelND:拥有factory集合,可以创建像Panel一样的N维数据容器。

生成数据表

1、首先导入pandas,一般都会用到numpy库

import numpy as np

import pandas as pd

2、导入CSV或者Excel的xlsx文件

df=pd.DataFrame(pd.read_csv('name.csv',header=1))

df=pd.DataFrame(pd.read_excel('name.xlsx))

需要安装xlrd的库,可以在pycharm中安装。

3、用pandas创建数据表:

数据表信息查看(df是文件的名字)

1、维度查看 df.shape

2、数据表基本信息(维度、列名称、数据格式、所占空间)

df.info()

3、每一列数据的格式 df.dtypes

4、某一列格式 df['B'].dtype #dtypes是指所有,dtype是一列

5、空值 df.isnull()

判断某一列的空值

print(df['city'].isnull())

#创建DateFrame的参数 data columns(字段)

df=pd.DataFrame({'id':[1001,1002,1003,1004,1005,1006],'date':pd.date_range('20130102',periods=6),'city':['bj','sh','sd','cq','hhht','bt'],'age':[12,23,25,26,24,56]})

print(df)

#获取数据表的结构

print(df.shape)

#获取数据表的信息 维度 列名称 数据的格式 所占空间

print(df.info()) #可以通过它来看数据中有没有空值

print('dtypes……')

#获取每一列数据的格式

print(df.dtypes)

print(df['id']) #获取id这一列

print('索引……')

print(df.iloc[0])

print(df)

print(df['id'].dtype)

#判断表里的空值……

print(df.isnull)

#判断某一列的空值

print(df['city'].isnull())

#获取表中列的唯一值

print(df['city'].unique())

#获取数据表的值

print(df.values)

#获取数据表中所有列的名称

print(df.columns)

#获取数据表的前/后5行数据

print(df.head())

print(df.tail())

print(df.head(3)) #前三行

数据表清洗

1、用数字0填充空值 df.fillna(valu=0)

print(df.fillna(0))

print(df)

print(df.fillna(value=0))

2、用均值取填充 df=df.fillna(df['age'].mean())

print(df.age)

3、清除city字段的空格

df.city=df['city'].str.strip() #或者df.city=df['city'].map(str.strip())

print(df.city)

4、大小写转换

df.city=df['city'].str.lower() #变成小写

print(df.city)

df.city=df['city'].str.upper() #变成大写

print(df.city)

5、改某一列的名字

df=df.rename(columns={'city':'city-shiqu'})

print(df)

6、#删除后出现的重复值

df['city-shiqu'].drop_duplicates()

7、改某一列的名字 将hhht改成huhe

df.city=df['city-shiqu'].replace('hhht','huhe')

print(df.city)

数据预处理

1、数据表合并

1.1 merge

df_inner=pd.merge(df.df1,how='inner') #匹配合并,交集

df_left=pd.merge(df,df1,how=) #左链

df_right=pd.merge(df,df1,how='right') #右连

df_outer=pd.merge(df,df1,how='outer') #并集

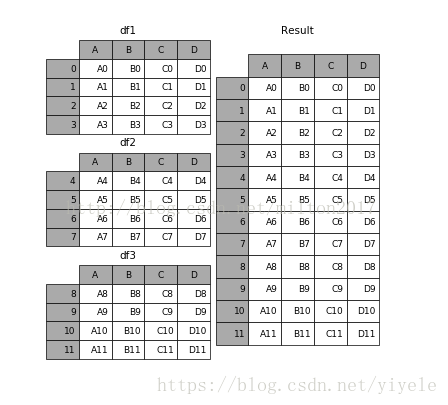

1.2 append

result=df1.append(df2) #两个垂直地(纵向)连接起来

result = df1.append(df2)

1.3 join

result = left.join(right, on='key')

1.4 concat

pd.concat(objs, axis=0, join='outer', join_axes=None, ignore_index=False,keys=None, levels=None, names=None, verify_integrity=False,copy=True)

.

objs︰ 一个序列或系列、 综合或面板对象的映射。如果字典中传递,将作为键参数,使用排序的键,除非它传递,在这种情况下的值将会选择 (见下文)。任何没有任何反对将默默地被丢弃,除非他们都没有在这种情况下将引发 ValueError。

axis: {0,1,…},默认值为 0。要连接沿轴。

join: {‘内部’、 ‘外’},默认 ‘外’。如何处理其他 axis(es) 上的索引。联盟内、 外的交叉口。

ignore_index︰ 布尔值、 默认 False。如果为 True,则不要串联轴上使用的索引值。由此产生的轴将标记 0,…,n-1。这是有用的如果你串联串联轴没有有意义的索引信息的对象。请注意在联接中仍然受到尊重的其他轴上的索引值。

join_axes︰ 索引对象的列表。具体的指标,用于其他 n-1 轴而不是执行内部/外部设置逻辑。

keys︰ 序列,默认为无。构建分层索引使用通过的键作为最外面的级别。如果多个级别获得通过,应包含元组。

levels︰ 列表的序列,默认为无。具体水平 (唯一值) 用于构建多重。否则,他们将推断钥匙。

names︰ 列表中,默认为无。由此产生的分层索引中的级的名称。

verify_integrity︰ 布尔值、 默认 False。检查是否新的串联的轴包含重复项。这可以是相对于实际数据串联非常昂贵。

副本︰ 布尔值、 默认 True。如果为 False,请不要,不必要地复制数据。

例子:

1.frames = [df1, df2, df3]

2.result = pd.concat(frames)

2、设置索引列

df_inner.set_index(‘id’)

3、按照特定列的值排序:

df_inner.sort_values(by=[‘age’])

4、按照索引列排序:

df_inner.sort_index()

5、如果prince列的值>3000,group列显示high,否则显示low:

df_inner[‘group’] = np.where(df_inner[‘price’] > 3000,’high’,’low’)

6、对复合多个条件的数据进行分组标记

df_inner.loc[(df_inner[‘city’] == ‘beijing’) & (df_inner[‘price’] >= 4000), ‘sign’]=1

7、对category字段的值依次进行分列,并创建数据表,索引值为df_inner的索引列,列名称为category和size

pd.DataFrame((x.split(‘-‘) for x in df_inner[‘category’]),index=df_inner.index,columns=[‘category’,’size’]))

8、将完成分裂后的数据表和原df_inner数据表进行匹配

df_inner=pd.merge(df_inner,split,right_index=True, left_index=True)

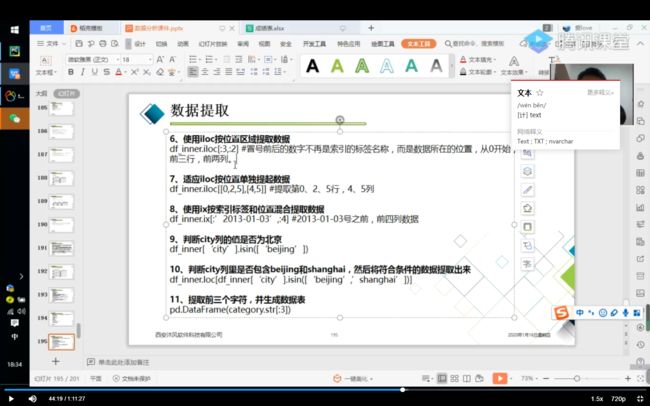

数据提取

数据筛选

数据汇总

数据统计

数据采样,计算标准差,协方差和相关系数

1、简单的数据采样

df.sample(n=3)

print(df.sample(n=3))

2、手动设置采样权重

weights=[0,0,0,0,0.5,0.5]

df.sample(n=2,weights=weights)

print(df.sample(n=2,weights=weights))

3、采样后不放回

print(df.sample(n=6,replace=False))

4、采样后放回

print(df.sample(n=6,replace=True))

5、数据表描述性统计

print(df.describe().round(2).T) #round函数设置显示小数位,T表示转置

6、计算列的标准差

df['age'].std()

print(df['age'].std())

7、计算两个字段间的协方差

print(df['age'].cov(df['price']))

8、数据表中所有字段的协方差

df.cov()

9、两个字段的相关性分析

print(df['price'].corr(df['age']))

10、数据表的相关性分析

df.corr()

数据输出

分析后的数据可以输出为xlsx和csv格式

1、写入Excel

df.to_excel('excel_to_python.xlsx')

sheet_name='bluewhale_cc'

print(sheet_name)

2、写入到csv

df.to_csv('excel_to_python.csv')

print(df.to_csv('excel_to_python.csv'))