Standalone伪分布式安装

实验环境

·操作机:Windows XP

·目标机:1台CentOS 7虚拟机

配置:IP:192.168.129.100

主机名:hadoop1

内存:1GB

硬盘:20GB

实验工具

·Xshell6:是一个强大的安全终端模拟软件,它支持SSH1, SSH2, 以及Microsoft Windows 平台的TELNET 协议。

·Xftp6:是一个功能强大的SFTP、FTP 文件传输软件。

实验内容

Standalone伪分布式,在单机启动多个线程来模拟集群下的分布式场景。

本实验使用Xshell6和Xftp6对一台CentOS服务器进行远程连接操作,使用一台服务器安装spark standalone伪分布式

实验步骤

1.使用xshell连接虚拟机

(1)下载xshell和xftp,下载地址:

https://www.netsarang.com/zh/free-for-home-school/

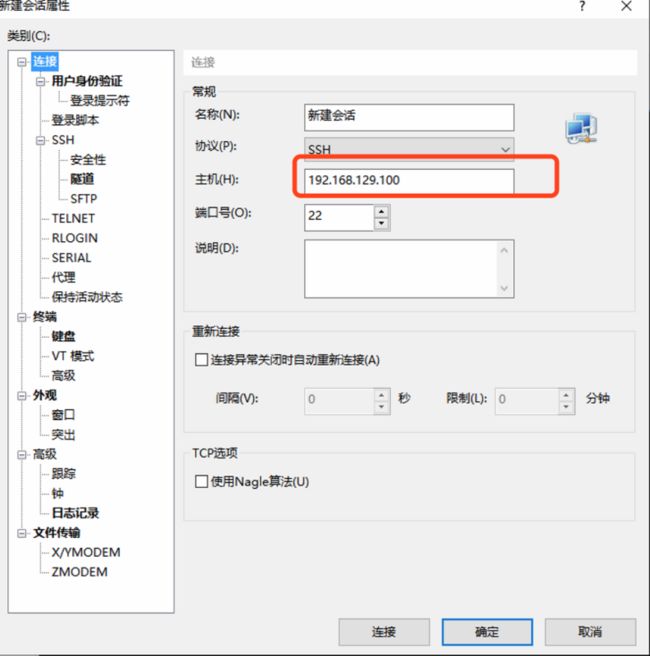

(2)打开下载好的xshell,连接虚拟机,点击文件->新建,填写主机ip地址,

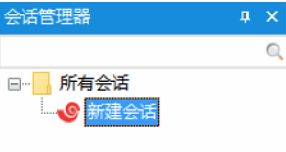

(3)双击新建的会话

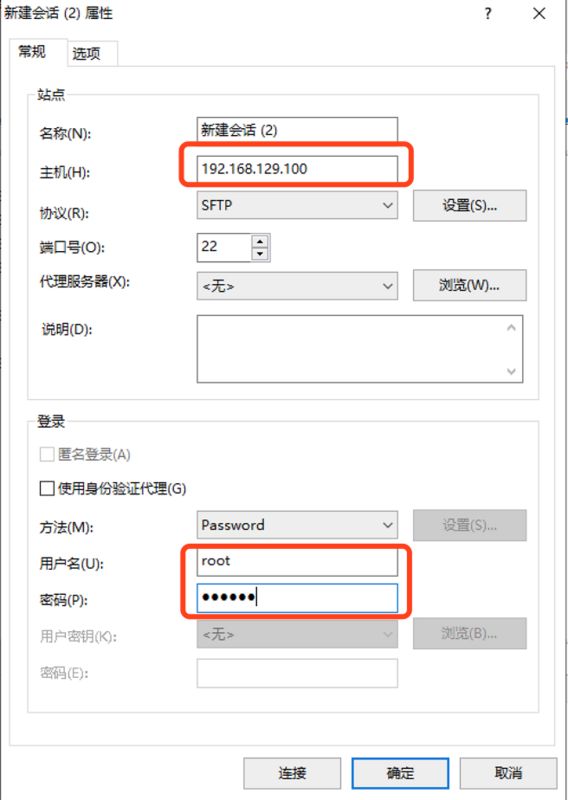

(1)使用下载好的xftp连接虚拟机,点击文件->新建

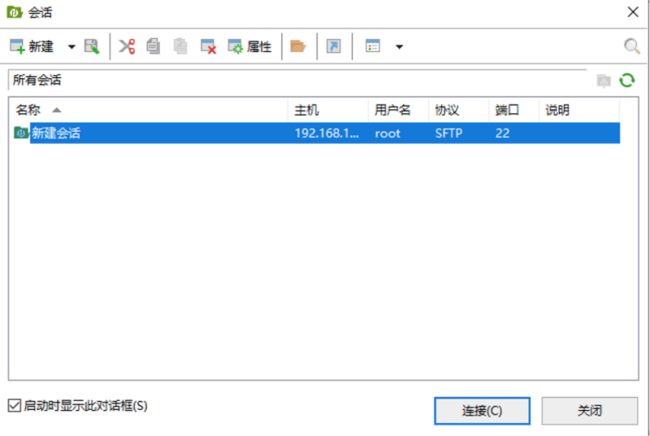

(3)点击新创建的回话,连接

3.安装JDK

(1)在服务器的/opt/目录下创建soft-install文件夹来存放安装的软件:mkdir /opt/soft-install

(2)创建soft目录来安装软件:mkdir /opt/soft

(3)Jdk下载地址:

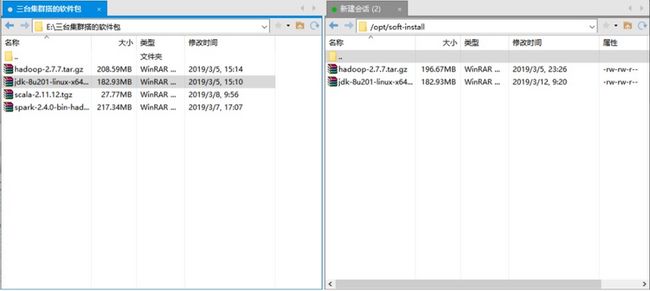

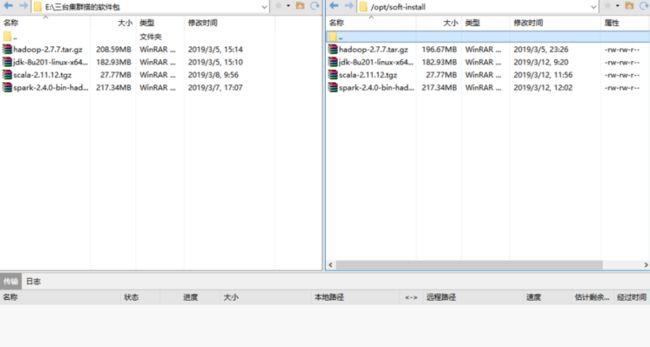

(4)使用xftp6将压缩包传到服务器

(4)将jdk解压到/opt/soft/目录下:

tar -zxvf jdk-8u201-linux-x64.tar.gz -C /opt/soft/

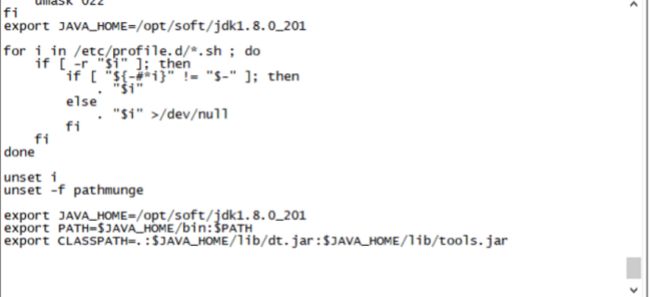

(5)修改环境变量

sudo vi /etc/profile

(6)在文件最后下添加:

export JAVA_HOME=/opt/soft/jdk1.8.0_201

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar(7)刷新配置文件:source /etc/profile

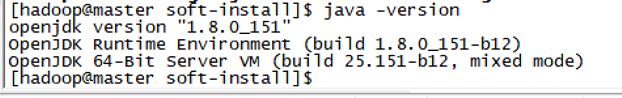

(8)测试java环境:java -version

4.安装scala

(1)官网下载:https://www.scala-lang.org/download/2.11.12.html

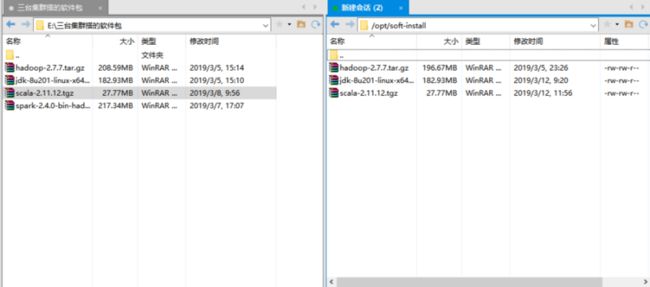

(2)通过xftp发送到服务器

tar -zxvf scala-2.11.12.tgz -C /opt/soft/

(4)修改环境变量

vi /etc/profile

(5)在最后添加:

(6)刷新配置文件

source /etc/profile

(7)检查是否安装完成

5.安装spark

(1)通过官网下载spark

https://www.apache.org/dyn/closer.lua/spark/spark-2.4.0/spark-2.4.0-bin-hadoop2.7.tgz

(2)使用xftp发送到服务器

(3)将spark安装包解压到/opt/soft

tar -zxvf spark-2.4.0-bin-hadoop2.7.tgz -C /opt/soft/

(4)重命名spark根目录

mv /opt/soft/spark-2.4.0-bin-hadoop2.7/ /opt/soft/spark-2.4.0

(5)配置环境变量

vi /etc/profile

(6)最尾巴加入

export SPARK_HOME=/opt/soft/spark-2.4.0

export PATH=$PATH:$SPARK_HOME/bin(7)刷新环境变量

source /etc/profile

6.配置spark

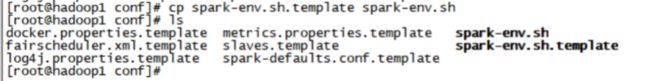

(1)首先我们把缓存的文件spark-env.sh.template改为spark识别的文件spark-env.sh

cp spark-env.sh.template spark-env.sh

(2)修改spark-env.sh,在尾巴加入:

export JAVA_HOME=/opt/soft/jdk1.8.0_201

export SCALA_HOME=/opt/soft/scala-2.11.12

export SPARK_MASTER_IP=hadoop1 #本地的ip或主机名

export SPARK_WORKER_MEMORY=4g

export SPARK_WORKER_CORES=2

export SPARK_WORKER_INSTANCES=17.启动spark

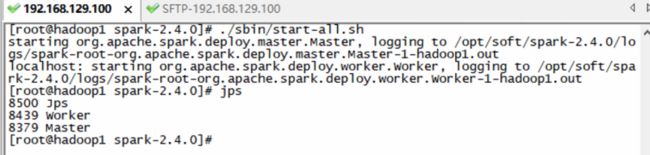

cd /opt/soft/spark-2.4.0

./sbin/start-all.sh

可以看到新开启的Master和Worker两个进程

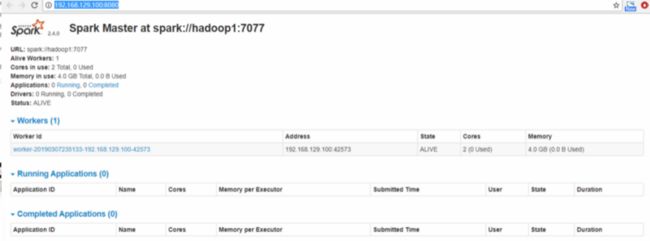

成功打开Spark集群之后可以进入Spark的WebUI界面,可以通过(服务的ip地址:8080)进行访问

8.打开Spark-shell

spark-shell

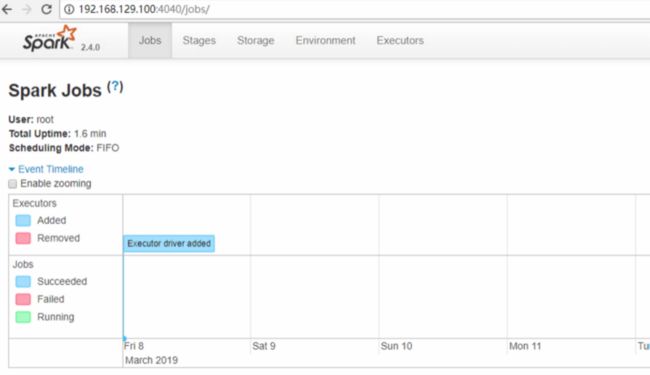

同时,因为shell在运行,可以通过(服务的ip地址:4040)进行访问