Andrew Ng机器学习公开课笔记 – Factor Analysis

网易公开课,第13,14课

notes,9

本质上因子分析是一种降维算法

参考,http://www.douban.com/note/225942377/,浅谈主成分分析和因子分析

把大量的原始变量,浓缩成少数几个因子变量

原始变量,代表浅层的表面现象,所以一定是很多和繁杂的

而因子变量,是代表深层的本质,因,是无法直接观察到的

所以因子分析,就是拨开现象发现本质的过程。。。很牛逼的感觉

举个例子,观察一个学生,你可以统计到很多原始变量,

代数,几何,语文,英语各科的成绩,每天作业时间,每天笔记的量。。。

这些都是现象,那么他们的本质是什么,

逻辑因子,记忆因子,计算因子,表达因子

这些都是些更本质的东西,但是你直接观察不到, 所以我们要做的是,根据表示现象的原始变量,分析出潜在的因子变量,以达到降维

既然要找出latent变量,自然想到要用到EM算法

先看看,这个问题是怎么引出的?

对于前面看到的算法,一般都是m>>n,即训练集远远大于向量维数的

如果m和n近似,或小于n的情况下,会有什么问题?

其实简单点想,

AX = B

其中A是参数向量,而X为变量向量,如果X的维是n

如果要求出A,其实就是在解一个方程组,变量为n个,那么至少要n个方程,如果训练集大小m,即方程数小于n,那一定是没有解的,或无限解

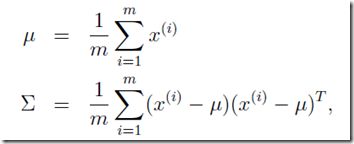

看看formal的形式,对于混合高斯EM算法的M-step,

其中算均值是没有问题的,

但在协方差矩阵时,得到的![]() 是奇异矩阵, 即

是奇异矩阵, 即![]() 不存在

不存在

关于奇异矩阵,可以参考,可汗学院公开课:线性代数_奇异矩阵_网易公开课

简单点理解,就想我上面说的,如果用这个矩阵当成方程组去求解,是无解的,即方程数不够

专业点说,就是不满秩,矩阵秩(rank)的意思,线性无关的纵列的极大数目

其实就是方程是有效的,无法被剩余的方程线性组合得到的,比如

x+y = 0

2x+2y = 0 ,3x+3y=0……

可以一直写下去,但这样形成的rank仍然为1,因为无法得到解,后面的方程都是无效的

为何![]() 不存在,因为在计算逆的时候,需要计算1/|x|,其中|x|表示矩阵的行列式,对于奇异矩阵行列式是为0的,所以无穷大

不存在,因为在计算逆的时候,需要计算1/|x|,其中|x|表示矩阵的行列式,对于奇异矩阵行列式是为0的,所以无穷大

为何奇异矩阵行列式为0?

我只能用一个2×2矩阵来举例,

a,b

c,d

行列式等于, a×d - b×c,如果是奇异矩阵,这个一定为0

在计算混合高斯分布的密度是,需要算,![]()

行列式为0,会导致无穷大,所以没有解

那么怎么解决上面的问题?很显然我们是无法拟合出一个完整的![]() 的,所以对它做些限制

的,所以对它做些限制

我们假设![]() 是个对角矩阵,diagonal

是个对角矩阵,diagonal

简单想想对角矩阵是什么,只有对角线上的值不为0,其他值都为0

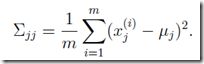

意味着,各个特征间是互相对立的,没有关系的,因为协方差为0即表示没有关系,所以现在只需要算出,每个特征的方差即可

这样对m就没有要求,有样本就可以算出方差

还可以进一步假设,在对角线上的值都是相等的,即是方差的平均值

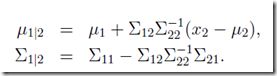

Marginals and conditionals of Gaussians

先看看混合高斯分布中,如何求出边界和条件高斯分布

没太搞明白,直接列出结果

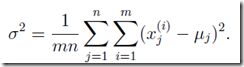

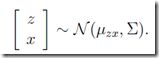

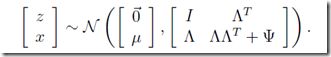

对于如下的联合分布,

则其中x1的边缘分布,也是符合高斯分布,p(x1) = p(x1,x2)对x1求积分

而条件分布,p(x1|x2) = p(x1,x2)/p(x2)

其中,

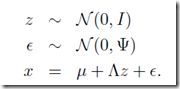

The Factor analysis model

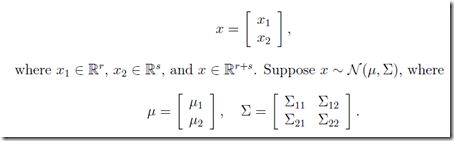

其中x是n维的原始变量,而z是k维的因子变量

![]() ,而

,而![]() ,所以

,所以![]() 就是n维向量,这个就是一个转换,将k维的z转换为维的x

就是n维向量,这个就是一个转换,将k维的z转换为维的x

所以可以理解为,所有的高维的原始变量都是可以用低维的因子变量通过线性变换得到的

所以我们可以用因子变量来作为后续算法的输入,达到降维的目的

比如上面学生的例子,我们可以用下面3维的因子变量来替代上面的高维的原始变量

x:(代数 80,几何 90,语文 60,英语 70 。。。)

z:(逻辑因子 80,记忆因子70,表达因子 60)

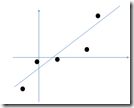

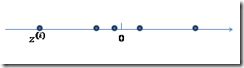

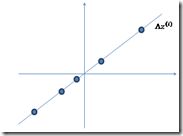

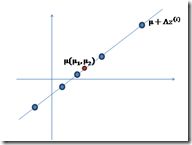

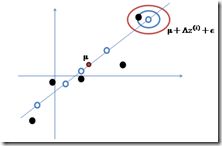

我们再看下,因子分析(Factor Analysis)中给的图示,就更清楚一些

比如对于高维数据集,这里假设是2维,

如何用低维的,即一维的,因子变量转换得到,

最后,加上误差扰动,即点不可能刚好在这个线上,需要加上符合高斯分布的误差

就得到最开始的原始数据集

说了半天,我们下步要干什么?再看下这个式子,

我们的目的是,用z替换x, 那么只要知道参数![]() ,我们就可以用z表示x, 即达到目的

,我们就可以用z表示x, 即达到目的

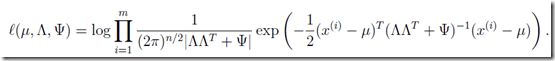

那么我们的目标就是优化参数,使得x达到最大似然估计,即我们这样转换出的x和真实的x是匹配的

但上面只给出z的分布,怎么求x的分布?

这里就用x,z的联合分布,通过边缘分布来求x的分布,原理说不清,所以也是只是列出结果

通过一系列计算过程,可以参考讲义,得到,

通过上面边缘分布的定义,我们知道,

所以得到优化目标函数为,

但是这个目标函数是无法直接解的

EM for factor analysis

所以还是要使用EM,

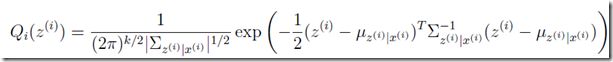

E-Step,

根据上面关于条件分布的定义,

于是,

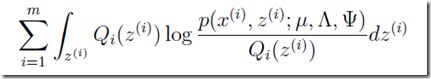

M-Step,

优化目标函数,其中z是满足高斯分布的连续变量,故用积分

然后的过程就是对各个参数求偏导,求值。

求解过程,具体参考讲义吧,看着虐心。。。呵呵