浪潮发布重磅产品“元脑”,专注AI全栈能力输出

4月16日,以“智慧凝聚”为题的IPF2019 浪潮云数据中心合作伙伴大会在上海举办。大会重点聚焦浪潮“智慧计算”战略,以AI计算力和创新力,联接、承载、赋能合作伙伴。

为了布局人工智能计算,浪潮从计算平台、管理套件、框架优化、应用加速四个层次致力于打造人工智能基础设施,已成为BAT人工智能服务器供应商,并帮助科大讯飞、商汤、旷视等AI技术公司在语音、图像、视频、搜索、网络等方面提升应用性能。

作为服务器厂商浪潮向合作伙伴秀技能的重要日子。浪潮集团副总裁彭震在当天下午发布了重磅产品浪潮“元脑”,这被浪潮视作其人工智能战略的再度升级,该产品将以输出人工智能全栈能力为主,从“能力构建”转向“能力输出”,推动人工智能新生态的构建。

浪潮元脑是浪潮人工智能全栈能力的载体与具象,将为人工智能提供最基础的创新支撑,赋能生态合作伙伴,加速产业人工智能化进程。

浪潮方面表示,浪潮元脑既包含浪潮的场景化人工智能基础设施,多样化的深度学习框架与工具,以及最新研发的人工智能PaaS平台和AutoML Suite等“有形”产品,同时也凝聚了浪潮多年积累的人工智能算法优化、系统优化服务等“无形”能力。

该系统主要包括以下五大部分:

- 计算:通过浪潮人工智能计算平台、人工智能超高速计算加速卡、极低延迟RDMA网络与超高带宽并行存储,共同提供极致人工智能计算性能;

- 框架层:针对最热门的TensorFlow框架,可提供公有云最快训练速度的TensorFlow-Opt优化框架与FPGA计算加速引擎TF2,并支持Caffe、Caffe-MPI、MXNet等主流框架;

- PaaS层:最新开发的人工智能PaaS平台面向人工智能企业训练场景,可实现容器化部署、可视化开发、集中化管理等,有效打通开发环境、计算资源与数据资源,提升开发效率;

- 算法层:最新开发的AutoML

Suite可实现非专业人员亦能通过极少操作构建网络模型并获得高精度,极大降低了人工智能开发、应用的门槛和成本。 - 服务:人工智能软硬件系统级优化、人工智能框架与算法级优化、应用咨询与系统设计等专业人工智能优化服务。

浪潮人工智能 PAAS平台

面向人工智能企业训练场景,拉通用户开发环境、计算资源、数据资源,构建一体化的人工智能开发平台。有效的提升计算资源的使用率,提高开发工程师工作效率。

加速AI企业的应用开发与创新主要分为两部分:聚焦高效的AI计算平台,高效的计算力支撑,精准的资源管理和调度,敏捷的数据整合及加速,流程化的AI场景及业务整合;其次是构建开放的AI创新生态,无缝对接行业ISV,赋能生态伙伴,兼容各AI应用和场景。

自动机器学习平台AutoML Suite

浪潮发布的高并行扩展自动机器学习平台AutoML Suite,可灵活支持本地化或云端部署,为AI客户与开发者提供快速高效开发AI模型的能力。

浪潮推出AutoML自动建模工具,其特点有:

1)一站式可视化处理,用户只需经过数据上传、模型搜索、模型训练、模型评估4个步骤的可视化操作即可为学习任务构建好网络模型,并获得高精度;

2)自动生成CV模型,采用强化学习自动完成分类、回归模型生成,并支持监督学习和无监督学习;

3)部署形式灵活,为全球首个支持On-Premise和Cloud双模式部署的产品,分钟级完成部署;

4)支持多机多GPU卡并行,极大降低模型搜索和模型训练时间,如在模型搜索阶段,采用16 V100 GPU测试,单个模型平均搜索的时间为9.6分钟,较单卡提升10.52X,一天可以搜索144个模型,极大提高生成效率。

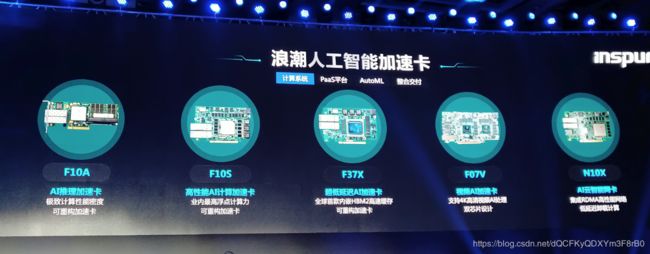

浪潮人工智能加速卡

F10A:支持OpenCL的FPGA加速设备

F10A的单芯片峰值运算能力为1.5TFlops,而功耗仅为35W,每瓦特性能达到42GFlops。同时,F10A设计半高半长PCI-E插卡,具有灵活的板卡内存配置,最大支持32G双通道内存,能够寄存更多的并行任务数据。此外,F10A支持2个10Gb光口,可以实现数据直接从网络到板卡处理,无需经过CPU,减低了传输延时。浪潮方面称,F10A是目前业界支持OpenCL的最高密度、最高性能的FPGA加速设备。

基于F10A,浪潮推出面向AI线上推理、GZip算法与WebP图片转码三大云场景的FPGA加速方案,在扩充FPGA生态的同时,也为从事AI开发与应用的公司以及大型数据中心用户提供更高性能功耗比的专用加速芯片选择。

基于FPGA具有可编程专用性,高性能及低功耗的特点,浪潮F10A AI线上推理加速方案针对CNN卷积神经网络的相关算法进行优化和固化,可加速ResNet等神经网络,能够应用于图片分类、对象检测和人脸识别等应用场景。浪潮F10A AI线上推理加速方案部署非常简单,用户只需要将目前深度学习的算法和模型编译成与浪潮深度学习加速解决方案的配置脚本,即可进行线上应用,省去至少3个月到半年的开发周期和相关成本。

F37X: 集成HBM2高速缓存的FPGA AI加速卡

F37X可在不到75W典型应用功耗提供28.1TOPS的INT8计算性能和460GB/s的超高数据带宽,适合于机器学习推理、视频转码、图像识别、语音识别、自然语言处理、基因组测序分析、NFV、大数据分析查询等各类应用场景,实现高性能、高带宽、低延迟、低功耗的AI计算加速。

F37X是浪潮专为AI极致性能设计的尖端FPGA加速卡,它采用Xilinx Virtex UltraScale+架构,提供285万个系统逻辑单元和9024个DSP单元,INT8计算性能达到了28.1TOPS,集成8GB HBM2高速缓存,带宽达460GB/s,相比单DDR4 DIMM提升20倍。

此外,F37X可支持C/C++、OpenCL和RTL三种主流的编程语言开发环境。相应SDx工具套件内含SDAccel™、Vivado®及SDK工具,应用已有的OpenCV、BLAS、Encoder、DNN、CNN等加速库,实现对主流深度学习框架如Caffe、TensorFlow、Torch、Theano等的支持,覆盖机器学习推理、视频图像处理、数据库分析、金融、安全等典型AI应用领域,提供强大的生态支持。

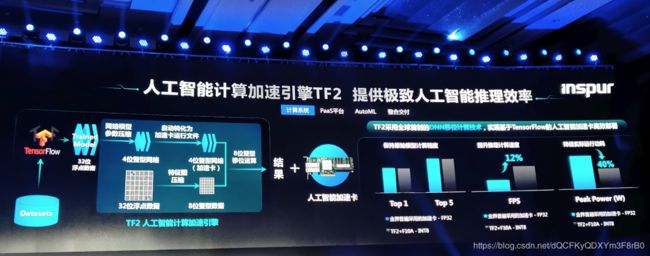

提升AI推理效率的人工智能计算加速引擎TF2

TF2是支持TensorFlow的FPGA计算加速引擎,可帮助人工智能客户快速实现基于主流人工智能训练软件和深度神经网络模型DNN的FPGA线上推理,并通过全球首创的FPGA上DNN的移位运算技术获得人工智能应用的高性能和低延迟。

TF2计算加速引擎由两部分组成。第一部分是模型优化转换工具TF2 Transform Kit,它将经过TensorFlow等框架训练得到的深度神经网络模型数据进行优化转换处理,大幅降低模型数据文件大小,如它可将32位浮点模型数据压缩为4位整型数据模型,使得实际模型数据文件大小精简到原来的1/8,并基本保持原始模型数据的规则存储。

第二部分是FPGA智能运行引擎TF2 Runtime Engine,它可实现将前述已优化转换的模型文件自动转化为FPGA目标运行文件,为了消除深度神经网络如CNN等对FPGA的DSP浮点计算能力的依赖,浪潮创新设计了移位运算技术,它可将32位浮点特征图数据量化为8位整型数据,并结合前述4位整型模型数据,转换卷积操作浮点乘法计算为8位整数移位运算,这将大幅提升FPGA做推理计算的性能并有效降低其实际运行功耗。这也是目前全球首次在保持原始模型计算精度的前提下在FPGA上实现深度神经网络DNN的移位运算。

总的来说,浪潮元脑实际上提供了一个一体化的解决方案,是将浪潮的人工智能计算能力、存储能力、网络能力以及人工智能PaaS平台、AutoML Suite 自动算法调优工具集合在一起,提供了一个完整的平台级解决方案,方便其合作方进行人工智能应用开发的一个底层平台。