LBC(load balance cluster)负载均衡集群

一、LB介绍

原理:当用户的请求过来,会直接发送到分发器上(Director Server),然后它把用户的请求根据预先设置好的算法,智能均衡的分发到后端真是的服务器上(real server)。如果不同的机器,可能请求的数据不一样,为了避免这样的情况发生,使用共享存储,保证所有的用户请求的数据是一样的。

常用的负载均衡开源软件有: lvs,keepalived,haproxy,nginx,apache,heartbeat

商业的硬件负载设备: F5,Netscaler,Radware,A10

二、LVS的3种工作方式8种类调度算法

LVS是linux virtual server的简写,是一个虚拟的服务器集群系统,LVS是一个可以在unix/linux平台下实现负载均衡集群的开源项目,LVS架构从逻辑上分为调度层(Director Server)、集群层(real server)和共享存储

1、LVS有下面三种工作模式:

(1)NAT模式

调度器将请求的目标ip即vip地址修改为Real server的ip,返回的数据也经过调度器,调度器再把源地址修改为vip

(2)TUN模式

调度器将请求来的数据包封装加密通过ip隧道转发到后端的real server上,而real server会直接把数据返回给客户端,而不再经过调度器

(3)DR模式

调度器将请求来的数据包的目标mac地址修改为real server的mac地址,返回的时候也不经过调度器,直接返回给客户端

先说明几个ip的定义:

dip(director ip)分发器ip,NAT模式必须有公网IP

vip(virtual ip)虚拟IP,用在TUN和DR模式中,需要同时配置再分发器和后端的真实服务器上

rip(Real ip)后端真是IP,在TUN和DR模式中,rip为公网ip

2、要想把用户的请求调度给后端的RS,是需要经过调度算法来实现,LVS常用以下几种调度算法:

固定调度算法:rr,wrr,dh,sh

动态调度算法:wlc,lc,lblc,lblcr

(1)rr 轮叫调度(Round Robin),这种算法是最简单的,不管RS的后端配置和处理能力,均衡的分发下去

(2)wrr 加权轮叫(Weight Round Robin),比上面的算法多了一个权重的概念,可以给RS设置权重,权重越高,那么分发的请求数越多,权重取值范围0-100

(3)LC最少链接(least connection),这个算法会根据后端的RS的连接数来决定把请求发给谁,比如RS1连接数比RS2连接数少,那么请求优先发给RS1

(4)WLC 加权最少链接(Weighted Least Connecttion)比最少链接算法多了一个权重

(5)Dh 目的地址哈希调度(destination hashing)以目的地址为关键字查找一个静态hash表来获得需要的RS

(6)SH 源地址哈希调度(source hashing)以源地址为关键字查找一个静态hash表来获得需要的RS

(7)lblc 最小连接数调度(least-connection),IPVS表存储了所有活动的连接。LB会比较将连接请求发送到当前连接最少的RS

(8)Lblcr 带复制的基于本地的最少连接:是LBLC算法的改进

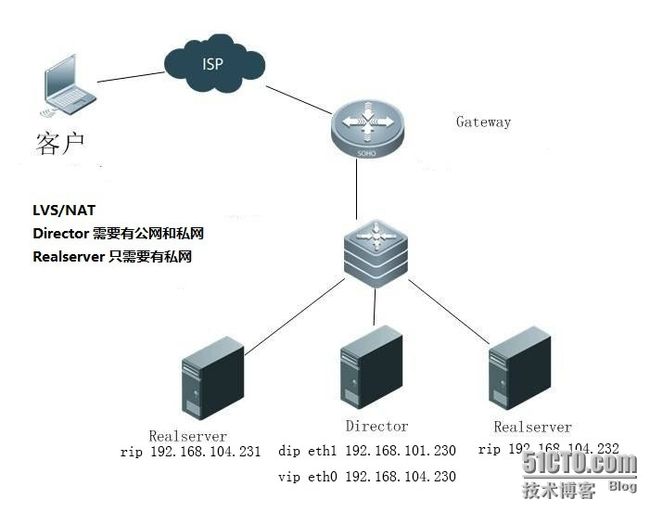

三、安装和配置LVS/NAT模式

1、配置网络

三台服务器一台作为director, 两台作为real server

Director 有一个外网ip (192.168.101.230) 和一个内网ip(192.168.104.230), 两个real server上只有内网ip(192.168.104.231)和(192.168.104.232) 并且需要把两个real server的内网网关设置为director的内网ip(192.168.104.230)

rs回去的数据包经过dir,需要设置rs1和rs2的网关为的vip192.168.101.230

[root@rs1 ~]# vim /etc/sysconfig/network-scripts/ifcfg-eth0

GATEWAY=192.168.104.230

[root@rs1 ~]# ifdown eth0;ifup eth0

同样方法添加rs2的网关

这里的NAT自定义的子网,192.168.104.0/24,三台服务器的104网段IP互通,与101.230也可以ping通

下图为vmware的设置,网关是192.168.104.1

2、更改hostnanme(这其实只是临时更改的方法)

dir 192.168.101.230/192.168.104.230

[root@daixuan ~]# hostname dir

[root@daixuan ~]# bash

[root@dir ~]#

相同方法更改rs1和rs2

rs1 192.168.104.231

rs2 192.168.104.232

3、Director上安装ipvsadm,并写防火墙规则

[root@dir ~]# yum install -y ipvsadm

[root@dir ~]# vim /usr/local/sbin/lvs_nat.sh

#!/bin/bash

#Director服务器上开启路由转发功能

echo 1 > /proc/sys/net/ipv4/ip_forward

# 关闭icmp的重定向

echo 0 > /proc/sys/net/ipv4/conf/all/send_redirects

echo 0 > /proc/sys/net/ipv4/conf/default/send_redirects

echo 0 > /proc/sys/net/ipv4/conf/eth0/send_redirects

echo 0 > /proc/sys/net/ipv4/conf/eth1/send_redirects

# director 设置nat防火墙

iptables -t nat -F

iptables -t nat -X

iptables -t nat -A POSTROUTING -s 192.168.104.0/24 -j MASQUERADE

# director设置ipvsadm

IPVSADM='/sbin/ipvsadm'

$IPVSADM -C

$IPVSADM -A -t 192.168.101.230:80 -s rr 300

$IPVSADM -a -t 192.168.101.230:80 -r 192.168.104.231:80 -m -w 1

$IPVSADM -a -t 192.168.101.230:80 -r 192.168.104.232:80 -m -w 1

直接运行这个脚本就可以完成lvs/nat的配置了:

[root@dir ~]# sh /usr/local/sbin/lvs_nat.sh

查看防火墙的路由规则:

[root@dir ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.101.230:80 rr

-> 192.168.104.231:80 Masq 1 0 0

-> 192.168.104.232:80 Masq 1 0 0

4、两个real server 上都安装nginx:

[root@rs1 ~]# yum install -y nginx

[root@rs1 ~]# /etc/init.d/nginx start

5、通过浏览器测试两台机器上的web内容,为了区分开,我们可以把nginx的默认页修改一下:

rs1上: echo "rs1rs1" >/usr/share/nginx/html/index.html

rs2上: echo "rs2rs2" >/usr/share/nginx/html/index.html

6、测试

[root@dir ~]# curl 192.168.101.230

rs1rs1

[root@dir ~]# curl 192.168.101.230

rs2rs2

[root@dir ~]# curl 192.168.101.230

rs1rs1

[root@dir ~]# curl 192.168.101.230

rs2rs2

浏览器访问,刷新,rs1rs1和rs2rs2轮流切换

7、更改权重,测试结果是两次rs1,一次rs2

[root@dir ~]# vim /usr/local/sbin/lvs_nat.sh

$IPVSADM -A -t 192.168.101.230:80 -s wrr

$IPVSADM -a -t 192.168.101.230:80 -r 192.168.104.231:80 -m -w 2

$IPVSADM -a -t 192.168.101.230:80 -r 192.168.104.232:80 -m -w 1

[root@dir ~]# sh !$

sh /usr/local/sbin/lvs_nat.sh

[root@dir ~]# curl 192.168.101.230

rs1rs1

[root@dir ~]# curl 192.168.101.230

rs1rs1

[root@dir ~]# curl 192.168.101.230

rs2rs2

[root@dir ~]# curl 192.168.101.230

rs1rs1

[root@dir ~]# curl 192.168.101.230

rs1rs1

[root@dir ~]# curl 192.168.101.230

rs2rs2

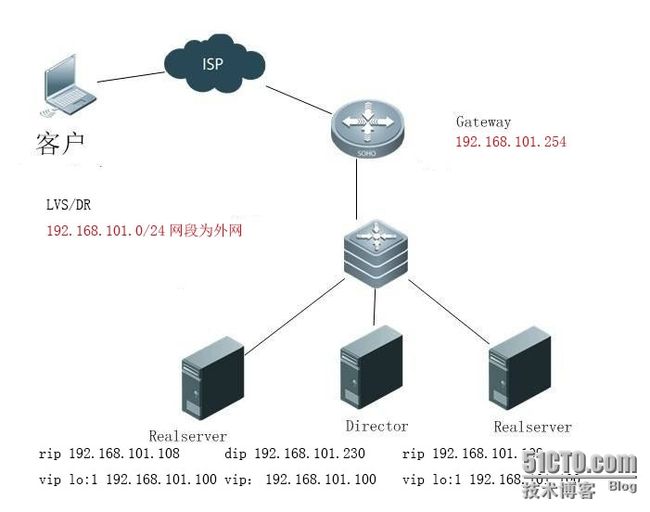

四、安装和配置LVS/DR模式

1、首先清空ipvsadm规则和iptables的规则

[root@dir ~]# ipvsadm -C

[root@dir ~]# iptables -t nat -F

把指定的网关修改回来

2、配置网络

每个rs都必须要有一个独立的公网IP,因为处理结果直接通过公网返回到用户客户端,不经过dir

另外需要添加虚拟vip,作为用户访问的ip,共计4个公网IP

三台机器:

director(192.168.101.230, vip: 192.168.101.100)

real server1(rip: 192.168. 101.108, vip lo:0: 192.168.101.100)

real server2(rip: 192.168.101.109, vip lo:0: 192.168.101.100)

3、编辑脚本

dir server

[root@dir ~]# vim /usr/local/sbin/lvs_dr.sh

#! /bin/bash

echo 1 > /proc/sys/net/ipv4/ip_forward

ipv=/sbin/ipvsadm

vip=192.168.101.100

rs1=192.168.101.108

rs2=192.168.101.109

ifconfig eth0:0 $vip broadcast $vip netmask 255.255.255.255 up

route add -host $vip dev eth0:0

$ipv -C

$ipv -A -t $vip:80 -s rr

$ipv -a -t $vip:80 -r $rs1:80 -g -w 1

$ipv -a -t $vip:80 -r $rs2:80 -g -w 1

执行脚本:

[root@dir ~]# sh /usr/local/sbin/lvs_dr.sh

查看转发路由:

[root@dir ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.101.100:80 rr

-> 192.168.101.108:80 Route 1 0 0

-> 192.168.101.109:80 Route 1 0 0

5、rs1 server上编辑脚本

[root@rs1 ~]# vim /usr/local/sbin/lvs_dr_rs.sh

#! /bin/bash

vip=192.168.101.100

ifconfig lo:0 $vip broadcast $vip netmask 255.255.255.255 up

route add -host $vip lo:0

echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce

[root@rs1 ~]# sh !$

sh /usr/local/sbin/lvs_dr_rs.sh

相同方法添加rs2上的脚本并执行

6、使用ifconfig查看rs1和rs2都已经正常监听192.168.101.100

[root@rs1 ~]# ifconfig

lo:0 Link encap:Local Loopback

inet addr:192.168.101.100 Mask:255.255.255.255

UP LOOPBACK RUNNING MTU:65536 Metric:1

4、测试

在第四台linux服务器上测试curl 192.168.101.100 结果为切换显示rs1rs1和rs2rs2

实现了DR的负载均衡

五、LVS/DR + keepalived配置

如果服务器上rs1上面nginx服务停止了,则用户访问的结果如下,curl: (7) couldn't connect to host这肯定不行,那怎么解决呢?

[root@daixuan ~]# curl 192.168.101.100

curl: (7) couldn't connect to host

rs2rs2

需要有一种机制用来检测real server的状态,这就是keepalived。它的作用除了可以检测rs状态外,还可以检测备用director的状态,也就是说keepalived可以实现ha高可用集群的功能,当然了也需要一台备用director,共四台机器dir,dir2,rs1,rs2

dir 192.168.101.230

dir2 192.168.101.232

rs1 192.168.101.8

rs2 192.168.101.9

1、注意:前面虽然我们已经配置过一些操作,但是下面我们使用keepaliave操作和之前的操作是有些冲突的,所以若是之前配置过DR,请首先做如下操作:dr上执行:

$ipvsadm -C

ifconfig eth0:0 down

2、dir上安装keepalived

[root@dir ~]# yum install -y keepalived

[root@dir2 ~]# yum install -y keepalived

[root@dir ~]# > /etc/keepalived/keepalived.conf

[root@dir ~]# vim /etc/keepalived/keepalived.conf

vrrp_instance VI_1 {

state MASTER #备用服务器上为 BACKUP

interface eth0

virtual_router_id 51

priority 100 #备用服务器上为90

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress {

192.168.101.100

}

}

virtual_server 192.168.101.100 80 {

delay_loop 6 #(每隔10秒查询realserver状态)

lb_algo wlc #(lvs 算法)

lb_kind DR #(Direct Route)

persistence_timeout 60 #(同一IP的连接60秒内被分配到同一台realserver)

protocol TCP #(用TCP协议检查realserver状态)

real_server 192.168.101.108 80 {

weight 100 #(权重)

TCP_CHECK {

connect_timeout 10 #(10秒无响应超时)

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

real_server 192.168.101.109 80 {

weight 100

TCP_CHECK {

connect_timeout 10

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

}

以上为主director的配置文件,拷贝到从服务器上

[root@dir ~]# scp /etc/keepalived/keepalived.conf 192.168.101.232:/etc/keepalived/keepalived.confstate

从director服务器上的配置文件只需要修改

MASTER -> state BACKUP

priority 100 -> priority 90

3、配置完keepalived后,需要开启端口转发(主从都要做):

[root@dir1 ~]# echo 1 > /proc/sys/net/ipv4/ip_forward

[root@dir2 ~]# echo 1 > /proc/sys/net/ipv4/ip_forward

4、两个rs上执行 /usr/local/sbin/lvs_dr_rs.sh 脚本

[root@rs1 ~]# sh /usr/local/sbin/lvs_dr_rs.sh

[root@rs2 ~]# sh /usr/local/sbin/lvs_dr_rs.sh

5、两个director上启动keepalived服务(先主后从):

[root@dir ~]# /etc/init.d/keepalived start

[root@dir2 ~]# /etc/init.d/keepalived start

注意:启动keepalived服务会自动生成vip和ipvsadm规则,不需要再去执行上面提到的/usr/local/sbin/lvs_dr.sh 脚本

6、查看转发是否成功,ipvsadm -ln查看到rs1和rs2服务器地址,如果有,说明成功

[root@dir ~]# ipvsadm -ln

IP Virtual Server version 1.2.1 (size=4096)

Prot LocalAddress:Port Scheduler Flags

-> RemoteAddress:Port Forward Weight ActiveConn InActConn

TCP 192.168.101.100:80 wlc persistent 60

-> 192.168.101.108:80 Route 100 0 0

-> 192.168.101.109:80 Route 100 0 1

7、测试keepalived

在第五台linux机器上curl 192.168.101.100 一次结果rs1rs1一次rs2r2轮流切换

rs1上的nginx服务stop,则在测试linux机器上访问的结果全部为rs2rs2,vip自动切换real server

[root@rs1 ~]# service nginx stop

停止 nginx: [确定]

[root@test ~]# curl 192.168.101.100

rs2rs2

[root@test ~]# curl 192.168.101.100

rs2rs2

dir1主上停止keepalived服务,则原来主服务器监听的vip192.168.101.100自动切换到从服务器上监听,且vip可以正常访问,主服务的keepalived重新启动后,自动切换到dir1上面,切换回去,实现了ha的高可用功能

[root@dir ~]# ip address

inet 192.168.101.100/32 scope global eth0

[root@dir ~]# /etc/init.d/keepalived stop

[root@dir ~]# ip address

无vip192.168.101.100的监听

[root@dir2 ~]# ip address 已经切换到从上面

link/ether 00:0c:29:cf:72:3e brd ff:ff:ff:ff:ff:ff

inet 192.168.101.232/24 brd 192.168.101.255 scope global eth0

inet 192.168.101.100/32 scope global eth0

另外只有一个公网IP也可以做LVS/DR,可参考:

http://storysky.blog.51cto.com/628458/338726