ACL 2019 | 腾讯AI Lab解读三大前沿方向及20篇入选论文

感谢阅读腾讯 AI Lab 微信号第79篇文章。本文将通过介绍入选NLP领域顶级学术会议 ACL 的论文,解读腾讯 AI Lab 的重点研究方向:自然语言理解、对话系统和文本生成,以及机器翻译等。

自然语言处理领域顶级会议 ACL 2019 将于 7 月 28 日– 8 月 2 日在意大利弗洛伦萨举办。此次腾讯 AI 共计入选 34 篇文章,含腾讯 AI Lab 20 篇、微信AI 9 篇、其他部门 5 篇(据内部不完全统计)。

这是腾讯 AI Lab 第三次参加 ACL,本次入选的论文涉及自然语言理解、对话系统和文本生成,以及机器翻译等几大重点研究方向,下面将以不严格的方式分组介绍。Lab 往年参会入选论文可见「 腾讯 AI 实验室 」公众号。

ACL 大会期间,腾讯还将在弗洛伦萨举办 TAIC 学术交流大会,邀请腾讯 AI Lab 副主任俞栋博士等多位技术专家和业界领袖,共谈前沿研究进展。欢迎您前来参加。

时间:7月29日17:00-20:30

地点:Sala della Scherma,Fortezza da Basso,Florence

报名:请扫描下方二维码

方向一:自然语言理解

自然语言理解(Natural Language Understanding)的目标是赋予机器阅读、消化和理解人类语言的能力,是人工智能数十年来致力完成的使命之一,也是自然语言处理研究者长期以来努力攻克的重点和难点之一。腾讯AI Lab长期以来在自然语言理解领域有着持续的投入,本次会议上展示的论文,主要围绕词的语义表示和知识的构建,希望在多语种、跨平台的自然语言理解问题上有所突破。

1. 社交媒体语言的主题感知神经关键词生成

Topic-Aware Neural Keyphrase Generation for Social Media Language

论文地址:https://arxiv.org/pdf/1906.03889.pdf

本文由腾讯AI Lab主导,与香港中文大学联合完成。每天在社交媒体上有大量用户生成的内容发布。为了便于自动语言理解,我们研究关键词预测,即从大量帖子中提取显著信息。相比于大多数从源帖子中提取单词以形成关键短语的现有方法,我们提出了基于序列到序列(seq2seq)的神经关键词生成框架,使得不出现在帖子中的关键词也可以被生成。此外,我们的模型有主题感知的特性,能对跨文本级的隐性主题表示进行联合建模,这有助于缓解在社交媒体语言中广泛存在的数据稀疏性。在从英文和中文社交媒体平台收集的三个数据集的实验表明,我们的模型明显优于不利用隐性主题的基于抽取或生成的模型。进一步的讨论表明,我们的模型能学习到有意义的主题,这也解释了它在社交媒体关键词生成中的优越性。

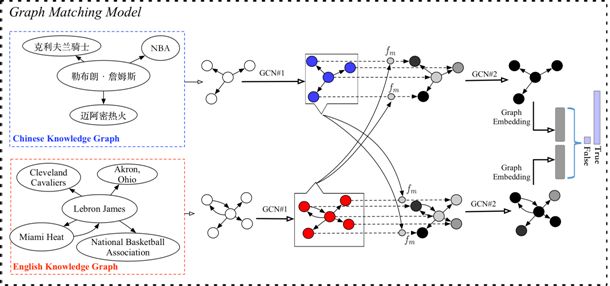

2. 基于图匹配神经网络的跨语言知识库实体对齐

Cross-lingual Knowledge Graph Alignment via Graph Matching Neural Network

本文由腾讯AI Lab主导,与IBM T.J Waston Research Center、Amazon AWS合作完成。之前面向跨语言知识库实体对齐的工作主要是基于从单语言知识库中学习出来的实体表达,因此很难对齐在跨语言知识库中具有不同事实性描述的实体。为了解决这个问题,本工作提出一个“实体主题图”,即首先将实体在跨语言知识库里的事实抽取出来,各自形成一个子图。然后将实体对齐的任务转变成图匹配的问题。同时我们提出一个图匹配神经网络算法,首先匹配两个子图里面所有实体,再综合实体匹配的结果生成一个图匹配结果。实验结果表明,通过这样的方法,我们提出的模型可以更好地利用实体附近的上下文信息判断实体匹配的结果。

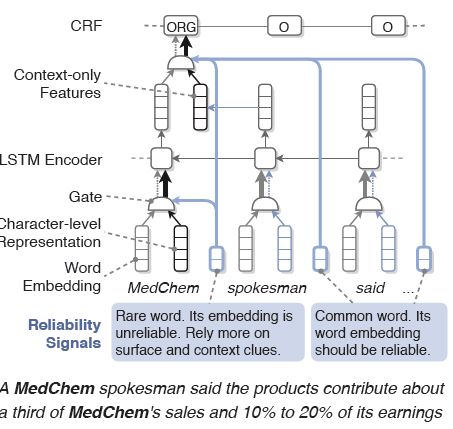

3. 用于专名识别的可靠性感知的动态特征组合

Reliability-aware Dynamic Feature Composition for Name Tagging

论文地址:

http://nlp.cs.rpi.edu/paper/featurecomposition2019.pdf

本文由腾讯AI Lab与RPI、UIUC合作完成。词向量被广泛运用于各种任务,然而受限于,词频的长尾分布,其性能在整个词汇表中并不一致。由于缺乏足够的语境信息,稀有词的向量表示通常不如普通词的表示。通用的模型通常信任所有词向量,而不考虑它们的可靠性,因此可能引入噪声并损害其性能。由于专有名词通常包含罕见和未知的词语,因此该问题对于专名识别尤其重要。本文提出了一种新颖的可靠性感知的专名识别模型来解决这个问题。我们设计了一组基于字频率的可靠性信号,以指示每个词向量的质量。在可靠性信号的指导下,该模型能够使用门控机制动态选择和组合诸如词向量和字符级表示之类的特征。例如,如果输入单词为罕见词/稀有词,则模型较少依赖于其词嵌入,并为其字符和上下文特征分配较高权重。在OntoNotes 5.0上的实验表明,我们的模型比基准模型提高了6.2%的F-score。在OntoNotes的六个文体的跨类型实验中,我们的模型提升了大多数类型对上的性能,平均获得2.3%的F-score绝对增益。

方向二:对话系统和文本生成

目前大多数对话系统是通过生成方法或基于检索方法实现。随着大数据和深度学习技术的发展,生成式对话系统及文本生成技术取得了巨大进展。最早的序列到序列(Seq2Seq)模型把对话回复生成视为一个翻译问题,学习对话上下文到其回复的对齐关系。但生成回复比翻译语言要困难得多,这可能是在对话场景中,输入与输出之间并没有严格的短语对齐关系,允许有大量看似合理的回复同时存在。本次 ACL 会议中,腾讯AI Lab的工作讨论了多个对话任务场景中的特性及问题,包括结合对话的句子功能、增强对话生成中的语料记忆能力以及提升对话回复的语义可控性、多样性、连贯性等问题。

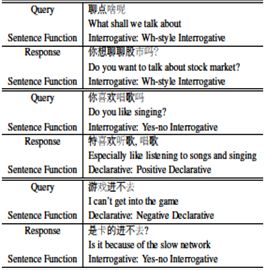

1. 短文本对话中的细粒度句子功能

Fine-Grained Sentence Functions for Short-Text Conversation

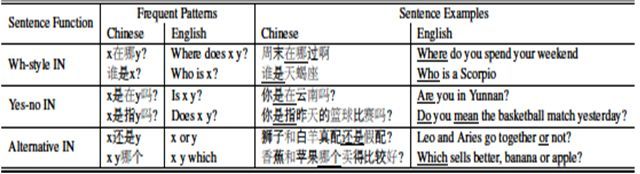

带有细粒度句子功能的短文本对话句对。可以看到,对于不同句子功能的query(Yes-no/Wh-style疑问句), 他们本身以及相应回复的句子结构都大不相同。

三种细粒度疑问句的常见句子结构。x和y是代表内容词的变量。句子中带下划线的单词对应于句子结构中的单词。

本文由腾讯AI Lab主导,与苏州大学合作完成。句子功能(Sentence function)是一个重要的语言学特征,该特征在对话中能够体现说话者的目的。已经有许多研究结果表明引入句子功能特征改善对话模型的性能。但是,目前仍旧不存在一个带有句子功能标注的大型对话数据。在这个工作中,我们构建了一个新的带有句子功能标注的短文本对话数据集。在此数据集上我们训练了分类网络用于:(1) 确定新的大型短文本对话数据中句子的功能类别;(2) 根据测试输入预测回复文本可能的句子功能。我们在此基础上搭建了基于检索和生成的两种对话模型。实验结果表明使用句子功能特征可以帮助这些对话模型提高生成回复的性能。

2. 学习如何抽象:一种记忆增强的对话生成模型

Learning to Abstract for Memory-Augmented Conversational Response Generation

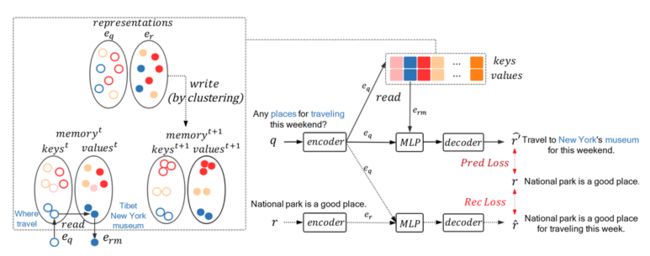

模型框架图:本文致力于开放域闲聊对话,探究检索式对话和生成式对话更好的结合方式。

本文由腾讯AI Lab主导,与香港科技大学合作完成。神经网络生成模型存在诸如生成的回复多样性差、信息量不足等一些问题。一些研究者尝试利用检索系统去增强生成模型的效果,但是该方法受限于检索系统的质量。在本文中,我们提出了一种记忆增强的生成模型,他可以对训练语料进行抽象,并且把抽象出来的有用的信息存储在记忆模块中,以便辅助生成模型去生成回复。具体来说,我们的模型会先对用户输入(query)-回复(response)的聚对做聚类,接着抽取出每个类的共性,然后让生成模型学习如何利用抽出的共性信息。实验效果表面我们的模型可以大幅提升回复生成的效果。

3. 基于指代对齐和对话流建模的连续问题生成

Interconnected Question Generation with Coreference Alignment and Conversation Flow Modeling

论文地址:https://arxiv.org/abs/1906.06893

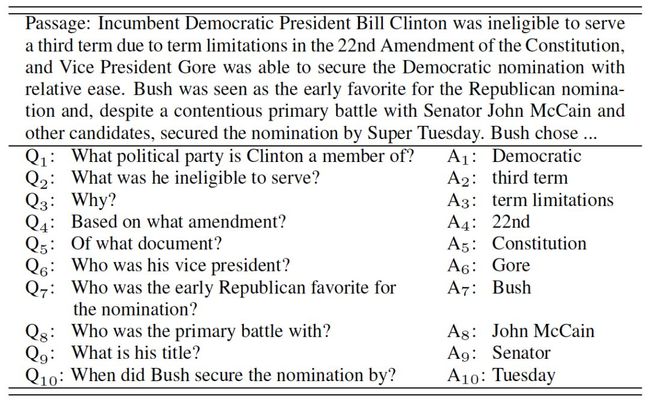

本文研究了问答式对话这一场景中的连续问题生成,目标是生成具有对话性的问题Q1~10。

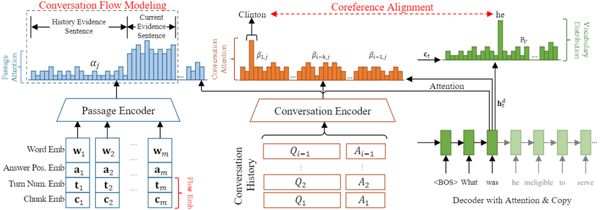

模型框架图

本文由腾讯 AI Lab 主导,与香港中文大学合作完成。本文研究问答式对话这一场景中的连续问题生成。之前的工作是基于一句话(或一段话)生成问题,本工作的不同之处在于: (1)问题的对话性很强,对话中一半的问题利用指代关系依赖于历史对话;(2)在一个连贯的对话中,不同轮之前的问题有着连贯的焦点转移。我们提出了一个端到端的基于指代对齐和对话流建模的模型。指代对齐模块显式地将对话历史中的实体名词和生成问题中的相应的代词对齐,使得问题能够与历史对话连贯。对话流模块在对话的前几轮关注文章前半部分的内容,并随着对话的深入,逐渐转移注意力到文章后面的部分。实验表明我们提出的模型超过了基线系统的水平并能够生成对话性强的问题。

4. 基于多级解偶自注意力机制的对话回复生成机制

Semantically Conditioned Dialog Response Generation via Hierarchical Disentangled Self-Attention

论文地址:https://arxiv.org/pdf/1905.12866.pdf

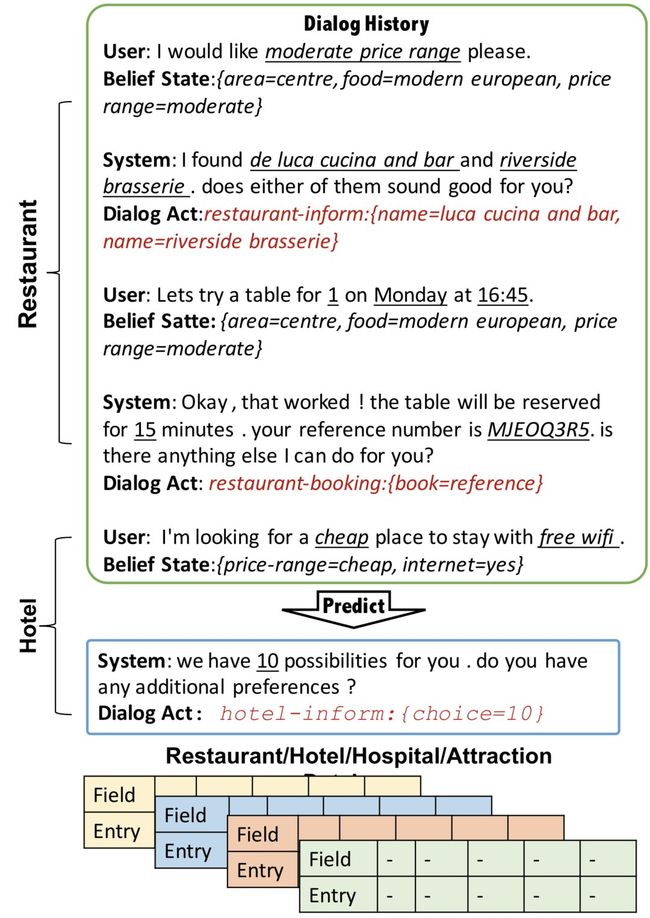

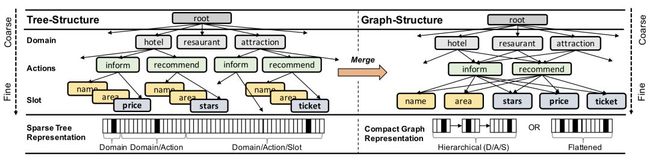

本文研究了对话回复生成机制,目标是生成语义可控的对话回复。

模型框架图

本文由腾讯AI Lab和加州大学Santa Barbara分校合作完成。本文主要解决用语义来控制对话回复生成的问题。在用语义控制多领域大规模对话的生成的问题中,因为多种语义输入的组合呈现指数增长,所以在实际解决时会面临很大困难。本文针对这个问题,将一系列对话决策整合成一个多层的分级图结构,并将这个结构整合到Transformer模型结构中,用于控制其对话文本生成过程。在大规模Multi-Domain-WOZ数据集上,我们提出的模型获得了超过4个BLEU点的提升,同时人工评测也显著超越其他基准方法。

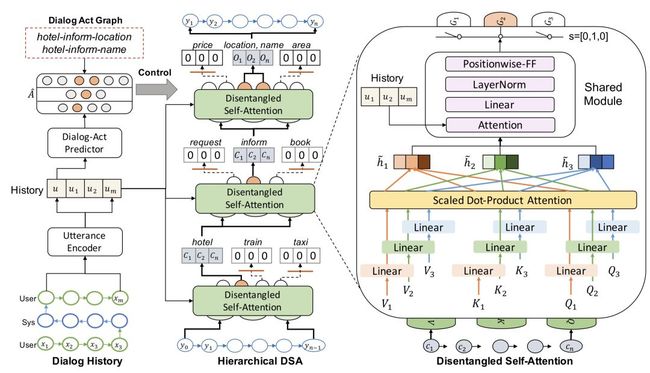

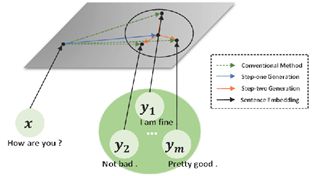

5. 训练数据是否相互关联?基于多个参考回复的对话生成模型

Are Training Samples Correlated? Learning to Generate Dialogue Responses with Multiple References

两步生成架构示意图:传统模型从头开始建模每个回复(绿色标识),我们的方法首先建立多个回复的共同特征,然后在此基础上对每个回复进行建模。

本文由腾讯AI Lab与北京大学合作完成。现有的生成式模型往往会面临通用回复的问题,这是因为其未能很好地考虑到对话中自然存在的提问与回复之间一对多的映射关系。对此,本文通过考虑多个参考回复之间的相关性,提出了一种两步式的对话生成模型,来分别建模多个回复之间的共性与个性特征。实验结果显示本文提出的方法可以生成多样且合理的回复,并且相较于基准模型在自动与人工评测指标下均有着更好的表现。

方向三:机器翻译

机器翻译是人工智能的终极目标之一,其中核心的语言理解和语言生成是自然语言处理的两大基本问题,极具挑战性。虽然神经网络机器翻译近几年来取得了巨大进展,但是由于当前神经网络的不可解释性,无法保证原文内容完整传递到译文,使得神经网络翻译模型存在译文忠实度问题 (即“达而不信”) 。腾讯AI Lab专注于解决该核心问题,在ACL2019会议上发表的多篇论文,尝试解释当前主流Transformer模型核心的解码器及注意力模型的建模能力,加强对神经网络翻译模型的理解,希望能启发其他研究者对神经网络翻译模型的进一步改进。

1. 神经机器翻译中句子表示的利用

Exploiting Sentential Context for Neural Machine Translation

论文地址:https://arxiv.org/pdf/1906.01268.pdf

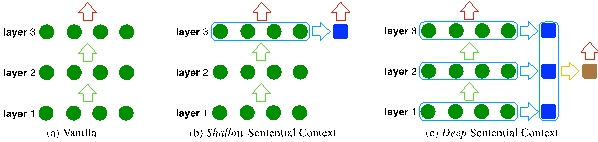

图1 利用多层源语言句子表示的方法框架

本文由腾讯AI Lab独立完成。本文针对“编码器-解码器”结构的神经机器翻译模型提出一种利用源语言句子表示的方法。具体地,针对神经机器翻译中的多层表示,分别提出源语言句子浅层表示和深层表示两种具体的方法 (图1),并将该源语言句子表示集成至神经机器翻译解码器中以指导目标语言句子的生成。实验表明,在多个翻译数据集上,该方法可以取得比基准模型更好的翻译性能。进一步分析表明,该方法可以增强编码器对原句语言信息的建模能力。该论文是我们探索编码器表示的第四个工作,前续工作通过深层表示融合及结构化建模,改进编码器对原句的理解及表达能力。

2. 评估自注意力网络的词序学习能力

Assessing the Ability of Self-Attention Networks to Learn Word Order

论文地址:https://arxiv.org/pdf/1906.00592.pdf

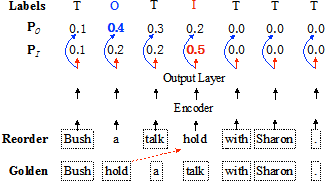

图1 单词重排序检测任务 (WRD)

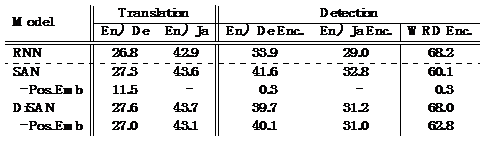

表1 翻译 (Translation) 及WRD准确率 (Detection) 。"En=>De Enc."和"En=>Ja Enc."指对应双语语料训练的NMT模型的编码器,"WRD Enc."指在WRD单语数据上训练的编码器。"- Pos_Emb"指去除SAN模型中的词语位置编码。

本文由腾讯 AI Lab 主导,与澳门大学合作完成。自注意力网络(SAN)由于其高并行化和在机器翻译等NLP任务上的出色表现而受到广泛关注。由于缺乏诸如递归神经网络(RNN)之类的递归结构,SAN被认为在序列建模时学习词序信息的能力较弱。然而,这种推测既没有得到经验上的验证,也无法解释为何在"缺乏位置信息"的情况下基于SAN的机器翻译模型依然表现出色。为此,我们提出了一种全新的单词重新排序检测任务 (图1),用来量化SAN和RNN结构的词序信息的捕获能力。具体地,我们将一个单词随机移动到另一个位置,并检验特定模型是否能够检测出原始位置和插入位置。实验结果 (表1) 表明:1) 即使引入位置编码 (position encoding) ,SAN在单词重排序检测任务中难以学习好词序信息; 2) 但是在机器翻译任务中,SAN可以比RNN可以更好地捕获词序信息,其中位置编码起着至关重要的作用。尽管递归结构使模型在学习词序方面更普遍有效,但学习目标在机器翻译等下游任务中更为重要。该论文是我们探索自注意力模型的第四个工作,前续工作改进了自注意力模型的局部建模能力和全局建模能力。

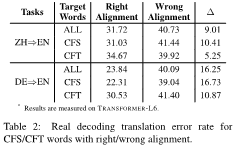

3. 机器翻译中的词对齐

On the Word Alignment from Neural Machine Translation

本文由腾讯AI Lab 主导,与香港中文大学、哈尔滨工业大学合作完成。在机器翻译的研究中,注意力机制一直被认为是词对齐,然而在多层复杂结构的神经机器翻译模型里,研究者发现编码器-解码器注意力机制可能不能做为一个有效的词对齐模型。于是,本文提出了两种与机器翻译具体模型无关的获取词对齐的方法。实验表明所提出的两种方法获得的词对齐都远好于注意力机制获取的词对齐(参见Table 1)。在论证了神经机器翻译模型确实可以学到不错的词对齐之后,研究者试图使用神经机器翻译模型本身词对齐去理解机器翻译。通过在数据集上量化分析词级别上的词对齐错误对于翻译错误的影响,本文论证了词对齐错误会一定程度上导致翻译的错误。通过将目标端的词分为主要贡献来自于源端(CFS)和目标端(CFT),分析结果显示,主要贡献来自于源端的词的词对齐错误对翻译错误的影响占主要部分(参见Table 2)。

注意力模型一直是神经网络翻译模型的核心组件,尤其是当前主流的Transformer模型甚至是纯粹由注意力模型组成。在前续工作中,我们同样对Transformer中自注意力模型及编码器-解码器注意力模型的具体实现方式–多头注意力机制进行了探索,通过鼓励其多样性和信息融合方式,进一步增强注意力模型的表达能力。

其他入选论文

1. 弱监督的时空域自然语句视频定位

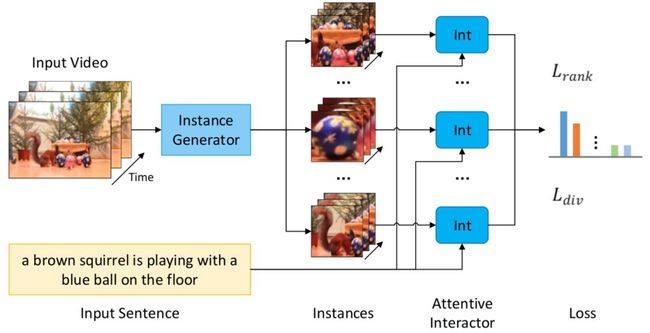

Weakly-Supervised Spatio-Temporally Grounding Natural Sentence in Video

本文由腾讯AI Lab主导,与香港大学合作完成。在本文中,我们讨论了一个新的任务,即弱监督的时空域自然语句视频定位。具体而言,给定自然句子和视频,我们在视频中定位时空片段,其在语义上对应于给定的句子,而不依赖于训练期间的任何时空的标注。首先,我们从视频中提取一组称为实例的时空片段。然后,我们使用我们新提出的注意交互模块对这些实例和句子进行编码,这可以利用它们的细粒度关系来表征它们的匹配行为。除了排名损失之外,还引入了一种新的多样性损失来训练我们注意交互模块,以加强可靠的实例-句子对的匹配行为,并惩罚不可靠的实例-句子对。我们还根据ImageNet视频对象检测数据集提供了一个名为VID-sentence的数据集,作为我们任务的基准数据集合。大量实验的结果证明了我们的模型优于基线方法。

2. 多句子压缩的无监督重写器

Unsupervised Rewriter for Multi-Sentence Compression

本文由腾讯AI Lab主导,与东京大学合作完成。多句压缩(MSC)旨在根据多个输入句子生成一个语法正确的压缩句,同时保留其关键信息。之前的工作大多是利用基于提取的词图的方法。之后的一些工作进一步利用词汇替换产生抽象的压缩句子。但是,当前的方法存在两个不足。首先,简单地连接多个句子中的片段的词图方法可能会产生生硬或不合语法的压缩句。其次,在不考虑上下文信息的词汇替换通常也会导致不恰当的压缩句子。因此,为了解决上述问题,我们提出了一种用于多句子压缩的神经重写器,并且不需要任何平行语料库。实验结果表明,我们的方法在自动评价指标上取得了可比较的结果,并且在人类评价上面提升了压缩句子的语法正确性。此外,我们也构建了大约140,000个(多句子,压缩句)对的平行语料库,以便用于未来的研究。

3. 利用多头注意力机制建模数学应用题内在联系

Modeling Intra-Relation in Math Word Problems with Different Functional Multi-Head Attentions

本文由腾讯AI Lab与电子科技大学、新加坡管理大学合作完成。本文针对数学应用题的自动求解提出了一种分组注意力机制,来分别提取数学应用题中的全局特征、数字相关特征、数字对相关特征和问题相关特征。实验结果表明,该方法的性能明显优于现有的先进方法,在多个数据集上均取得了更好的解题准确率。

4. 低资源命名实体识别中的双重对抗神经网络迁移学习

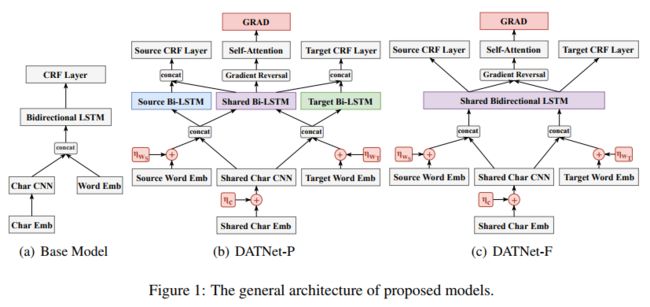

Dual Adversarial Neural Transfer for Low-Resource Named Entity Recognition

本文由腾讯AI Lab/Robotics X与新加坡A*STAR,MIT合作完成。本文提出一种新的神经网路迁移学习算法,称为双重对抗传输网络(DATNet),用于解决低资源命名实体识别问题。具体地,本文研究了DATNet的两种变体,即DATNet-F和DATNet-P,以探索高资源和低资源之间的有效特征融合。为了解决有噪声的和不平衡的训练数据,我们提出了一种新颖的一般性的资源对抗鉴别器(GRAD)。此外,采用对抗训练来推动模型泛化。在实验中,我们检查DATNet中不同组件对跨域和跨语言应用的影响,并表明可以获得显着的改进,特别是对于低资源数据,而不增加任何额外的手工制作的特征和预先训练的语言模型。

5. 关于对话上文和用户聊天历史对用户重回对话行为的研究

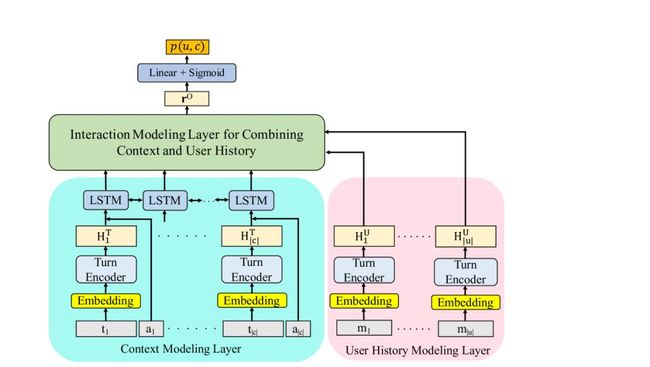

Joint Effects of Context and User History for Predicting Online Conversation Re-entries

本文由腾讯AI Lab与香港中文大学、美国东北大学合作完成。随着网络世界的持续膨胀,人与人之间的交互如今在观点的形成和变化方面扮演着愈发重要的角色。为了帮助用户更好地参与到线上对话当中,我们研究了一个有挑战性的问题:用户重回对话的行为预测。我们假设对话的上文和用户过去的聊天历史都能够影响他们对于一个对话的持续性兴趣。特别地,我们提出了一个神经网络的框架,这个网络共有三个主要层,每一层分别建模对话上文、用户讨论兴趣、以及他们之间的关系以预测一个用户是否会重回一个对话。我们在两个大规模的数据集上做了实验分析,这两个数据集分别收集自Twitter和Reddit。实验结果分析显示用双向注意力机制建模对话上文和用户聊天历史在Twitter上能够取得61.1的F1,超过了之前最好模型的结果。

6. 一个大规模可用于生成一致性摘要式文摘的专利数据集

BigPatent: A large-Scale Dataset for Abastractive and Coherent Summarization

本文由腾讯AI Lab与美国东北大学合作完成。当前大部分存在的文摘数据集都是来源于新闻领域。在这类摘要中,大部分摘要需要的内容都是会集中在文章的开头。而当文摘需要理解文章的全局信息,或者文摘需要高压缩率的时候,这类数据集的这种缺点就显而易见了。在这个工作中,我们发布了一个新的数据集,包含了一百三十万的美国专利文档以及对应的摘取式摘要。和现在研究领域常用的文摘数据相比,我们新发布的数据有如下的特点:1.文摘有丰富的结构化信息和重复的命名实体。2. 文章中重要的信息分散在文章的不同位置。3. 在提供的文摘中存在大量简短的抽取式摘要。在论文的最后,我们在新发布的数据上实验了一些基础模型来揭示该数据集上做文摘会遇到的新挑战。

7. 基于预训练Transformer模型的多关系抽取器

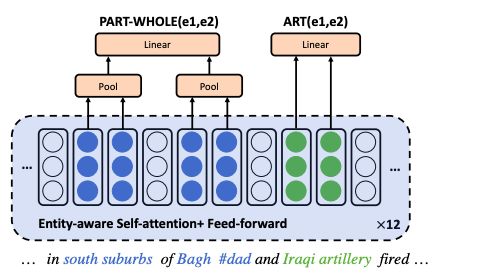

Extracting Multiple-Relations in One-Pass with Pre-Trained Transformers

本文由腾讯AI Lab与IBM T.J Waston Research Center合作完成 。多关系抽取任务中,目前的方法大多需要对目标的段落/句子进行多次(multiple-pass)编码操作,成本高且对长段落和大数据集应用效果差。本文的方法可以对一个段落中的多关系抽取任务,只进行一次段落编码(one-pass),从而缓解上述问题。此外,本文结合预训练语言模型BERT,针对Relation Classification任务的特点提出了两种抽取entity-aware信息的策略。

8. 基于知识的代词指代消解

Knowledge-aware Pronoun Coreference Resolution

本文由腾讯AI Lab与香港科技大学合作完成。代词的指代消解需要外部知识,尤其是对于某些特定的领域,比如医药领域。在本文中,我们探索如何构建神经网络利用多种外部知识。为了保证我们的模型有足够的泛化能力,我们直接将外部知识组织成三元组的形式。在外部知识中,有些知识在特定的上下文中并没有帮助,为此我们提出了一个面向知识的注意力机制,根据不同的上下文选择合适的知识进行指代消解。在两个评测数据集上的结果表明我们的方法是有效地,并且显著地超过基线方法。同时,由于我们的方法学会了如何利用外部知识,而不只是过拟合在某个训练集合上,所以我们的方法在跨领域的指代消解任务里,也显著超过了基线方法。

9. 面向领域迁移的训练数据选择方法

Reinforced Training Data Selection for Domain Adaptation

本文由腾讯AI Lab与香港科技大学、蒙德利尔大学合作完成。强监督学习模型通常会遇到领域迁移的问题。为了解决这个问题,训练数据的选择通常被认为是一个解决领域迁移问题的方法。传统的方法通常需要一个预先设置的阈值,然而这个阈值通常并不容易设置,而且在不同的任务中通常也不一样。为了解决这个问题,我们提出了一个强化学习框架,同时学习选择训练数据和利用训练数据。我们设计了一个选择分布生成器,在强化学习过程中不断根据奖励函数进行更新。在POS tag标注,依存关系分析和情绪分析的任务中的实验结果表明我们的方法不仅在数据选择任务中有效,也可以泛化到不同的NLP任务中。

* 欢迎转载,请注明来自腾讯AI Lab微信(tencent_ailab)