CVPR 2020 Oral | 无域标签下高清场景时移变换

![]()

©PaperWeekly 原创 · 作者|武广

学校|合肥工业大学硕士生

研究方向|图像生成

同一个场景在不同时间段存在着一定的变化,这主要取决于光照对图像的成像的影响,如何通过一个时间段的场景图像在无域标签的情况下合成出不同时间段下的高分辨率场景图像是本文要介绍的 CVPR 2020 oral 中 High-Resolution Daytime Translation Without Domain Labels (HiDT) 所做的工作。

论文标题:High-Resolution Daytime Translation Without Domain Labels

论文来源:CVPR 2020

论文链接:https://arxiv.org/abs/2003.08791

代码链接:https://github.com/saic-mdal/HiDT

![]()

论文引入

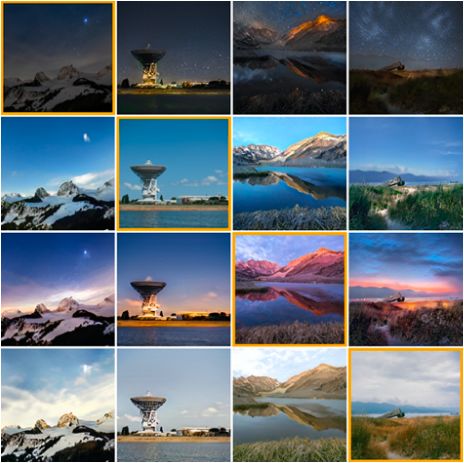

大部分使用 Mac 系统的用户默认动态壁纸是位于洛杉矶卡特琳娜岛的一天场景变化,对应着清晨、日出、正午、傍晚、入夜、凌晨的时移变化,固定机位间隔拍摄可以作为取景,然而这将花费一天时间。如何利用一张高分辨率图像达到时移自然场景的合成,是 HiDT 要实现的任务,文章称之为 Daytime Translation,图 1 展示了任务效果。

▲ 图1.HiDT在自然场景时移变换的结果图

自然场景的时移变换其实就是图像翻译的一类应用,早期的图像翻译在训练以及推理时都需要域标签,而 MUNIT [1] 和 FUNIT [2] 提出了目标域的几幅图像作为翻译指导,同时期的 StarGAN v2 [3] 更是提出了在一个生成器中根据不同的 style code 实现多域转换,这些或多或少都要有域标签的参与。

在时移场景变换下,域对应于一天中的不同时间和不同的照明,这个域标签定义起来是繁琐的,如何在无域标签的情况下实现高分辨率时移场景的合成是一个大的挑战。

然而大部分图像翻译任务在处理的图像上的尺寸多为中等尺寸,即 居多,如何实现高分辨率下( )的图像翻译仍是一个值得研究的问题,同时自然场景时移变换更是面临着不能完全依赖图像色彩空间的全局仿射变换,不能依赖时间戳和高分辨率下如何消去伪影等问题。

HiDT 通过对高分辨率源域图像进行分步转换,最后通过融合实现高分辨率图像合成,在处理图像伪影和细节上,文章将跳跃连接(Skip connections)和 AdaIN 进行结合,总结一下 HiDT 相比较已有的图像翻译方法的优势。

在仅有语义分割图的弱标签下实现了多域图像转换

在图像细节转换上通过跳跃连接和 AdaIN 结合实现高质量转换

通过拆分转换和融合达到高分辨图像转换

![]()

网络架构和优化

HiDT 的架构是建立在跳跃连接和 AdaIN 结合的基础上,采用 UNet 和 AdaIN 架构起网络的编码和解码器的主体,这个结构如图 2 所示。

▲ 图2.HiDT编码和解码器网络

由架构图可以看到对于输入 ,通过下采样进行编码得到对应的图像内容编码 ,解码端(生成器)将内容编码 ,风格编码 与不同下采样进行跳跃连接再配合 AdaIN 嵌入进行上采样生成对应的目标域图像。

决定转换后图像风格(可以理解为自然场景的不同时刻和光照)的是由风格编码 决定。而风格编码 在训练阶段是由目标域图像编码得到,在测试阶段则是通过在先验分布下采样得到,这部分我们待会再详细讨论。

HiDT 的整体架构倒是很直观,详细的网络结构只能通过代码去进一步查看,作者放出了项目地址,但是代码还在更新中。不过值得说的是 HiDT 对于模型的优化过程介绍的很好,这也算是图像翻译中比较详细和先进的模型优化方式。

▲ 图3.HiDT网络优化过程

在介绍之前,先来梳理一下图 3 中的符号, 表示源域输入图像, 表示内容编码器相对应的 为内容编码, 表示风格编码器相对应的 为风格编码, 为生成器, 为目标域风格编码, 为风格编码的先验分布, 为在风格编码的先验分布下随机采样的风格编码。

生成器 不光光输出的是转换后的图像,同时也输出相对应的风格掩码图 。

从上到下分析,随机风格采样 与内容编码 生成 ,此时 的风格取决于随机风格 ,掩码 则是受内容 的影响,对 继续进行内容和风格编码得到 ,将 馈送到生成器 得到重构的 ,为什么说是重构呢?

因为此时输入的风格是 自身的风格编码;中间一路就是对 进行编码后再重构得到 ;最下面一路则是先根据源域内容编码 与目标域风格编码 生成得到目标域图像和分割掩码 ,再由 编码得到的内容编码 与风格编码 得到最原始源域图像 ,由于 给出的损失为 ,这里推测风格编码 就是源域图像的风格表示,此处在原文中并没有做详细交代,等作者公布代码可以做进一步验证。

上述分析,总结起来就是模型在优化阶段由三种模式,一是随机风格的转换和重构,二是原始图像的重构,三是目标域图像转换和循环一致的转换。

最后就是如何对模型进行损失优化,正由图 3 中所展示的,重构损失 ,风格掩码损失 ,内容编码损失 ,风格编码损失 ,风格编码下趋紧先验分布的损失 以及循环一致损失 ,由此衍生的 也是一样的含义,图 3 中省略了对抗损失 ,对抗损失主要是对转换后的 和 进行优化。

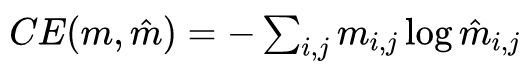

重构损失为 损失,即 ,类似的有 ,循环一致损失也是采用 损失 。对于分割掩码损失则是采取交叉熵损失:

则有:

由于风格编码的维度较低,此时可以通过均值和方差拉向正态分布,达到风格编码向先验分布靠近:

对于内容编码损失 和风格编码损失 ,则是通过 损失一致性优化,即:

总的损失可变式为:

其中 为超参数,HiDT 的模型优化算是对图像翻译下的损失进行了一个系统的介绍。

![]()

增强处理

由于内存和计算时间的限制,在高分辨率图像上进行图像翻译是不可行的。文章进行了一个增强处理,整个过程如图 4 所示。

▲ 图4.HiDT增强处理下拆分和融合方案

虽然内存和时间的限制可以通过在中等分辨率训练,并以完全卷积的方式应用于高分辨率图像;或者可以使用引导过滤 [4] 对中等分辨率的处理结果进行升采样。

但是,经过实验文章发现完全卷积的应用可能会由于感受野有限而导致场景崩塌,在夕阳下可能会出现多个太阳,或者在水反射下可能会混淆天空和水面之间的边界。

另一方面,引导过滤在水或阳光下能较好地实现转换,但如果通过样式转换更改细小细节,则引导过滤将失败,在高对比度边界附近产生光晕伪影。

为此,作者提出了图 4 所示的增强处理拆分和融合方案,对原始的高分辨率图像 分为不同的移位版本,根据保留移位位置像素,对于中间的像素用 0 去替代,得到移位的高分辨率图像 ,对移位后的图像进行双线性下采样得到中等分辨率图像 ,文中的移位版本设置为 16,对这 16 个中等分辨率图像进行图像翻译,即:

再由这 16 个中等分辨率图像经过融合网络 融合得到高分辨率图像输出,图 4 则是大致的演示过程。

![]()

实验

对于对比的基线选择,文章选择了 FUNIT [2] 和 DRIT [5],在定性对比上,得到的结果如图 5 所示,从左到右对应的是原始图像、FUNIT-T、FUNIT-O、HiDT。

▲ 图5.HiDT定性结果对比

定量上也展示了优越的结果。

▲ 图6.HiDT定量结果对比

对于自然场景图像时移变换下,通过随机采样 的设置,可以实现多域的生成,图 7 展示了时移图像的转换结果。

▲ 图7.HiDT自然场景时移结果

由于模型的设计,HiDT 可根据指导图像进行指导转换,图 8 为展示结果。

▲ 图8.HiDT指导图像进行转换

在消融实验上,当去掉分割掩码损失,转换结果上大幅度下降。

▲ 图9.HiDT去掉分割掩码损失后的结果

在高分辨率上的拆分和融合上展示了一定的结果。

▲ 图10.HiDT高分辨率图像下的结果

![]()

总结

HiDT 作为图像翻译模型,在训练和推理过程中均不依赖域标签,通过增强方案解决了图像翻译下高分辨率图像的转换。模型主要用于自然场景时移图像的合成,在定性和定量结果上展示了优越的结果。

整体而言,HiDT 与 MUNIT 存在着一定的相似性,但是网络结构中通过 U-Net 和 AdaIN 的结合实现了更好的翻译结果,同时在高分辨率转换上也取得了一定的成效,这归功于 HiDT 的拆分和融合思想,同时自然场景时移变换在很多场合下有着积极的意义。

参考文献

[1] Xun Huang, Ming-Yu Liu, Serge Belongie, and Jan Kautz. Multimodal Unsupervised Image-to-Image Translation. In Vittorio Ferrari, Martial Hebert, Cristian Sminchisescu, and Yair Weiss, editors, Computer Vision – ECCV 2018, pages 179–196, Cham, 2018. Springer International Publishing. 1, 2, 6

[2] Ming-Yu Liu, Xun Huang, Arun Mallya, Tero Karras, Timo Aila, Jaakko Lehtinen, and Jan Kautz. Few-shot unsupervised image-to-image translation. In The IEEE International Conference on Computer Vision (ICCV), October 2019. 1, 2, 3, 6

[3] Choi Y, Uh Y, Yoo J, et al. StarGAN v2: Diverse Image Synthesis for Multiple Domains[J]. arXiv preprint arXiv:1912.01865, 2019.

[4] K. He, J. Sun, and X. Tang. Guided Image Filtering. IEEE Transactions on Pattern Analysis and Machine Intelligence, 35(6):1397–1409, June 2013. 2, 4

[5] Hsin-Ying Lee, Hung-Yu Tseng, Qi Mao, Jia-Bin Huang, Yu-Ding Lu, Maneesh Singh, and Ming-Hsuan Yang. DRIT++: diverse image-to-image translation via disentangled representations. CoRR, abs/1905.01270, 2019. 1, 2, 6

![]()

点击以下标题查看更多往期内容:

多目标跟踪(MOT)领域近期值得读的几篇论文

时间交错网络:ICCV19多标签视频理解冠军方案

CVPR 2020 | 港中文提出3D目标检测新框架DSGN

基于深度学习的多目标跟踪:端到端的数据关联

从近年CVPR看域自适应立体匹配

大规模计算时代:深度生成模型何去何从

![]()

#投 稿 通 道#

让你的论文被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学习心得或技术干货。我们的目的只有一个,让知识真正流动起来。

???? 来稿标准:

• 稿件确系个人原创作品,来稿需注明作者个人信息(姓名+学校/工作单位+学历/职位+研究方向)

• 如果文章并非首发,请在投稿时提醒并附上所有已发布链接

• PaperWeekly 默认每篇文章都是首发,均会添加“原创”标志

???? 投稿邮箱:

• 投稿邮箱:[email protected]

• 所有文章配图,请单独在附件中发送

• 请留下即时联系方式(微信或手机),以便我们在编辑发布时和作者沟通

????

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

关于PaperWeekly

PaperWeekly 是一个推荐、解读、讨论、报道人工智能前沿论文成果的学术平台。如果你研究或从事 AI 领域,欢迎在公众号后台点击「交流群」,小助手将把你带入 PaperWeekly 的交流群里。

![]()