配置pycharm远程调试的环境(服务器为linux系统)&&服务器上安装tensorflow-gpu及配置cuda环境&&相关问题的解决办法

本文总共分三部分:

一、配置

PyCharm

远程调试的环境(服务器为linux系统)

二、服务器上安装tensorflow-gpu及配置cuda环境,同时改变

PyCharm

的环境

三、配置过程中遇到的问题及解决办法

一、配置pycharm远程调试的环境(服务器为linux系统)

1、设置sftp文件同步

在

PyCharm

中打开SFTP配置面板,路径为Tools => Deployment => Configuration:

1.1填写connection下的所有信息:

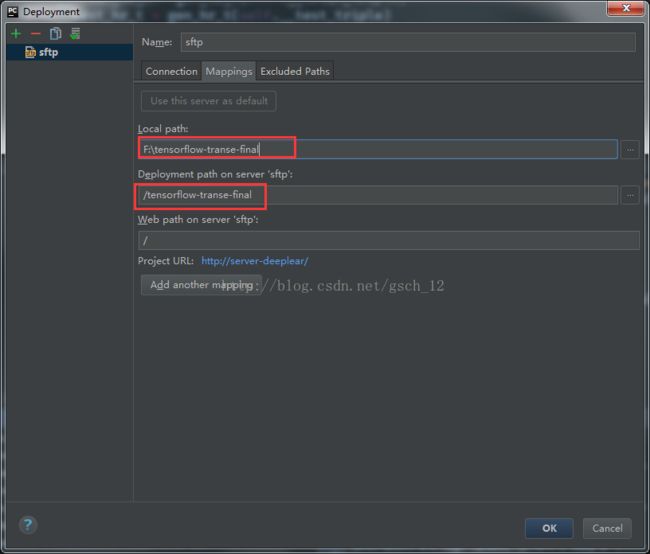

1.2配置Mappings参数设置,进行本地项目路径和远程服务器项目路径的关联:

2、设置远程python interpreter

PyCharm

主界面进入File-Setting-Project-

Project Interpreter

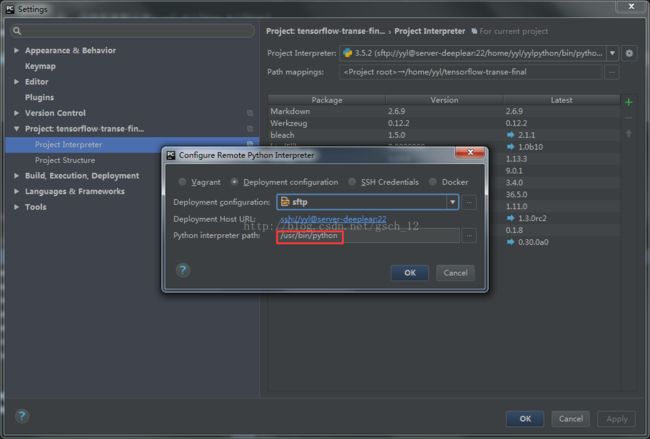

2.1 点击小齿轮选择Add Remote

2.2 默认你配置好了sftp,现在只需

要选择好

Interpreter的路径,默认路径是/usr/bin/python

注意如果在服务器为自己配置了单独的python环境,记得修改解释器路径。

2.3 设置Path mapping

本地项目的路径和远程服务器的路径要填对,后面配置

Configurations需要再填一遍

3、设置

Configurations

在

PyCharm

中打开Run/Debug Configurations设置面板,路径为Run-Edit Configurations-Python Remote Debug,点击左上角的加号

3.1 设置Configuration的信息

Name可以瞎填,Local host name填本机IP,Port可自行填写1002以上的任意数字。

要设置好Path mappings,路径和设置解释器时候一致。

5、完成所有步骤后,需要上传代码到远程服务器

右键具体项目,点击upload to sftp

二、服务器上安装tensorflow-gpu及配置cuda环境,同时改变

PyCharm

的环境

注意:

实验室服务器已经安装cud及

virtualenv

,所以接下来的步骤不会有安装cuda和

virtualenv

步骤,只涉及配置环境变量。

6、利用

virtualenv(虚拟沙盒)创建自己的python环境

注意每次使用沙盒环境前需使用激活命令。

6.1 建立自己的独立python环境

virtualenv --python=python3 yylpython(已建立)

6.2 激活该环境

source yylpython/bin/activate 激活

6.3 退出环境(这步先不做)

deactivate

7、服务器安装tensorflow-gpu

衔接上一步,这时候你已经进入yylpython的环境里,安装最新版本:

pip install tensorflow-gpu

8、配置cuda的环境

在服务器(ubuntu系统)的命令行终端输入以下代码:

export CUDA_DEVICE_ORDER=PCI_BUS_ID

export LD_LIBRARY_PATH="$LD_LIBRARY_PATH:/usr/local/cuda/li

b64:/usr/local/cuda/extras/CUPTI/li

b64"

export CUDA_HOME=/usr/local/cuda

export CUDA_VISIBLE_DEVICES=0,1

export TF_CPP_MIN_LOG_LEVEL=1

9、这时你在服务器上配置好

tensorflow-gpu和cuda环境,需要在

PyCharm

里设置好对应的信息

9.1 改变解释器路径,使用新建立的python环境,而不是默认的usr/bin/python

PyCharm

主界面进入File-Setting-Project-

Project Interpreter,点击小齿轮,点击more

9.2 把默认的

usr/bin/python路径修改成新的yylpython里的路径

9.3

在

PyCharm

中打开Run/Debug Configurations设置面板,路径为Run => Edit Configurations,配置cuda的环境变量

点击Environment variables右边的...添加对应的环境变量:

CUDA_DEVICE_ORDER=PCI_BUS_ID

LD_LIBRARY_PATH="$LD_LIBRARY_PATH:/usr/local/cuda/li

b64:/usr/local/cuda/extras/CUPTI/li

b64"

CUDA_HOME=/usr/local/cuda

CUDA_VISIBLE_DEVICES=0,1

TF_CPP_MIN_LOG_LEVEL=1

3.3.2018 增加

注意这里要填写才能run,否则是未使用,每次运行一个工程就要修改对应的路径

三、配置过程中遇到的问题及解决办法

按一、二步骤则环境安装成功,但在配置过程如果遇到以下问题,可以采取对应的解决办法。

1、

ImportError: libcudnn.so.6: cannot open shared object file: No such file or directory

这个错误是cudnn未能成功配置。

1.1 如果确定服务器里

已安装好

cuDNN v6.0,那么是环境变量配置有问题。

请查看步骤8,将对应的环境变量仔细观察一遍,尤其是在pycharm里设置环境变量时,多一个空格都会无法识别。

1.2 如果服务器未安装cuDNN v6.0,需要去官网下载安装包,并在服务器里安装。

1:对应cuda版本下载cudnn资源: https://developer.nvidia.com/cudnn

2:cudnn的安装:把文件拷入cuda安装文件的对应位置,建立相应软连接。

3、解压下载的压缩包:

tar zxvf

cudnn-8.0-linux-x64-v6.0.tgz

4、拷贝并建立软连接

cd cuda

sudo cp include/cudnn.h /usr/local/cuda/include

sudo cp -a lib64/libcudnn* /usr/local/cuda/lib64

2、ImportError: libcusolver.so.8.0: cannot open shared object file: No such file or directory

这个问题出现时,表示tensorflow的程序无法正常运行,一般是环境变量配置有误。

解决办法:

请查看步骤8,将对应的环境变量仔细观察一遍,

LD_LIBRARY_PATH的路径填写可能有误。