【论文阅读】【CVPR2017】Temporal Attention-Gated Model for Robust Sequence Classification

Temporal Attention-Gated Model for Robust SequenceClassification

用于序列分类的典型技术是针对已经分割良好的序列而设计的,编辑删除嘈杂或不相关的部分。所以,这样的方法不能轻易应用于实际应用中预期的嘈杂序列。在本文中,我们介绍时间注意门控模型(TAGM)集成了注意模型和门控周期性神经网络的想法,以更好地处理噪声或非分段序列。具体而言,我们将注意模型的概念扩展到衡量每个观察(时间步)的相关性一个序列。然后,我们使用一个新的门控循环神经网络学习最终预测的隐藏表示。我们的方法的一个重要优势是可解释性,因为时间注意权重提供了有意义的值是序列中每个时间步的显着性。我们展示了我们的TAGM方法的优点,包括两者预测准确性和解释性,对于三种不同的任务:口头数字识别,基于文本的情感分析和视觉图像识别。

1. Introduction

序列分类被认为是将一个标签分配给一系列观测值的问题。序列分类模型的应用范围广泛于计算机视觉[17]到自然语言处理[1]当中。大多数现有的序列分类模型都经过设计对于分段良好的序列并且不明确建模可能出现在这个事实中序列不相关(嘈杂)部分。为了减少这些不相关部分的干扰,研究人员通常会手动预处理这些不相关的部分数据集去除不相关的子序列。该手动预处理可能非常耗时,并且会降低实际场景的适用性。

门控序列分类的流行方法像门控循环单元(GRU)这样的循环网络[4]和长短期记忆模型(LSTM)[11]。他们使用逻辑门(例如,LSTM模型中的输入门),以在存储时间信息流时平衡当前时间步和先前时间步。然而,这些矢量门单独应用于每个维度信息流,因此很难解释输入时间观测的相对重要性(即时间步长)。顺序观测的哪个子集分类的任务是最显着的?另一种平衡信息流的方式,就像我们在这项工作中做的那样,是通过了基于注意的机制,它将个人注意分数应用于每个观察(时间步骤),从而提供更好的解释性。

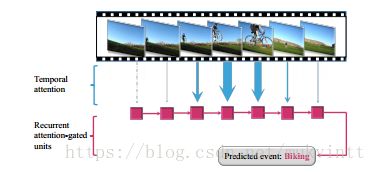

图1.我们提出的模型首先使用注意模块从有噪声的原始输入序列中提取显着帧,然后学习顶级分类器的有效隐藏表示。箭头越宽,信息就越集中在隐藏表示当中。虚线表示没有信息传递。

在本文中,我们引入时间注意门控模型(TAGM),它将基于注意的机制的思想扩展到序列分类任务(参见图1中的概述)。 TAGM的注意模块自动定位相关的显着观察值到最后的决定,并忽略不相关(嘈杂)的部分的输入序列。我们创建了一个新的循环循环神经单元可以学习更好的基于注意分数序列隐藏表示。因此,TAGM的分类决定是基于所选相关的细分,提高了考虑到整个输入序列的传统模型的准确性。

值得注意的是,与传统的序列分类模型相比,TAGM具有以下优点:

·它能够自动捕捉突出部分输入序列从而导致更好的性能。

·推断的注意(标量)分数为每个观察到的信息量提供了有意义的解释观察顺序。

·相比传统的门控循环模型等例如LSTM,我们的模型减少了参数的数量这将导致更快的训练和推理,并且更好通用性,需要的训练数据更少。

·所提出的模型能够推广到计算机视觉,语音识别和自然语言处理任务中。

2. Related Work

因为对以前的序列分类进行了全面审查模型超出了本文的范围,所以在本节我们总结与我们提出的方法最相关的方法,将它们分为三个领域:序列分类,注意模型和循环网络。

Sequence Classification. 传统的序列分类模型大致可以分为两类:生成模型和判别模型。

第一类侧重于基于生成模型学习有效的中间表示。这些方法通常基于隐式马尔可夫模型(HMMs)[31]。 HMM是一个生成的模型,该模型通过结合贝叶斯规则的先验类将其扩展到类条件HMM的序列分类。 HMM也可以用作Fisher Kernel [14]的基本模型学习序列表示。

第二类是区分性的图形模型,它模拟了所有以输入数据为条件的类别标签的分布。有条件的随机场(CRF)[20]是序列标记的判别模型其目的是为每个序列观察分配一个标签。常见CRF的潜在缺点是观测和标签之间的线性映射不能建模复杂的决策边界,这导致了很多非线性CRF变体(例如,潜在动态CRF [29],条件神经域[27],神经条件随机字段[5]和隐藏单元CRF模型[39])。隐藏状态CRF(HCRF)[30]采用一系列k-nomial潜变量来模拟潜在结构,并已成功用于序列标记。同样,隐藏单位逻辑模型(HULM)[26]利用二进制随机隐藏单元来表示指数隐藏状态以建模更复杂的潜在决策边界。

上述工作是专门设计的分段序列,因此不能很好地处理嘈杂或不分段的序列。

Attention Models. 受到人为中心视觉注意方案的启发,选择性地在输入的某些相关部分上,人们提出了注意模型,通过测量输出对输入变量的敏感性。这样做不仅可以提高模型的性能也可以获得更好的解释能力[41]。注意模型已应用于图像和视频字幕[41,3,6,42],机器翻译[1,22,32],基于深度的人识别[10]和语音识别[8]当中。就我们所知,我们的TAGM是第一个在序列的时间域中使用注意机制的端到端循环神经网络,并在每个时间步骤(序列)添加了对其时间显着性指标(即时间注意)的可解释性的优点观察。我们的工作与以往的工作重点不同在空间域(例如图像)上,例如(由Sharma等人提供[34])所提出的模型。

Recurrent Networks. 循环神经网络(RNN)通过考虑当前时间步的观察值和前一个的观察值来学习每个时间步的表示[33]。递归神经网络的最大的优势在于它们随时间通过循环机制保存信息的能力。循环网络已成功应用于各种任务,包括语言建模[23],图像生成[38]和在线手写生成[7]。plain-RNN在处理长序列时为了解决梯度消失,LSTM[11]和GRU [4]被提议用在他们配备了逻辑门以平衡来自前一时间步骤和当前时间的信息流动态地步进。受此设置启发,我们的TAGM模型也采用了一个门来过滤掉嘈杂的保留显着的时间步骤。与LSTM的区别GRU就是我们模型中的门值,这个值得来的是从注意于学习突出表现的注意模块每个时间步骤所获得的。

3. Temporal Attention-Gated Model

给定一个可能的未分段序列作为输入嘈杂信息的观察,我们的目的是:(1)我们的输入序列中的每个时间步观察得分并计算显着性,以及(2)构建一个最适合于序列分类任务的隐藏表示的基础上显着性分数。为实现这些目的,我们提出了由时间注意门控模型(TAGM)组成的两个模块:时间注意模块和循环注意门控单位。我们的TAGM模型可以接受训练高效的端到端方式。该模型如图2所示。

3.1. RecurrentAttention-Gated Units

循环注意的单元的目的是学习隐藏的序列表示(其集成了从时间注意模块推断的注意分数将在下一节讨论)。为了将注意分数整合到循环网络单元中,我们定义一个注意门来控制信息的量,从当前时间步骤的输入中合并对最终任务的显着性和相关性。

形式上,给定一个输入序列x1,...,T ={x1,。 。 。 ,xT},其中xt∈RD表示在第t个时间步骤的观察,注意分数在时间步t表示为at,这是一个标量值表明当前时间步骤到最后的显示决策突出性。为此,我们定义在步骤t中隐藏状态ht的过程,我们的核心循环建模成一个凸和:

图2.我们的时间注意门控模型(TAGM)的图形表示。该图的上半部分是循环注意门控单元,最底层是时间注意模块。请注意,at是以标量表示的显着分数值而不是矢量,因此图中的⊙意味着标量和矢量之间的相乘。

其中,ht-1是前一个隐藏状态,而ht’是候选隐藏状态值,该值完全包含了内在当前时间步骤中输入信息xt:

这里,W和U分别是线性变换以前和当前时间步的参数,而b是偏置项。我们使用修正线性单元(ReLU)[24]作为激活函数g。等式1使用注意分数平衡当前候选隐藏状态h't和先前隐藏状态ht-1之间的信息流。高度注意值将推动模型更多地注意当前隐藏状态和输入特征xt,而低注意将使模型忽略当前输入特征,并从以前的时间步骤继承更多信息。

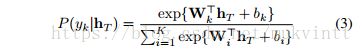

在上一个时间步骤学习的隐藏表示序列的hT被进一步反馈发送到最终的分类器中,通常使用softmax函数,执行分类任务,其计算预测标签yk在K类中的概率:

其中WiT表示计算参数和bi表示为第i类线性映射分数。

3.2. TemporalAttention Module

这个模块的目的是估计每个序列观察的显着性和相关性。这个显着性分数不仅应该以当前时间步的输入观察为基础,还考虑两个方向的相邻观测的信息。模拟这个邻里的影响力,我们推断在等式1(中使用双向RNN)中的注意分数:

![]()

这里,m是我们融合层的集成了双向RNN的两个方向层权向量以及b是偏置项。一个sigmoid函数被用作激活函数σ,在注意的顶层等式4中的模块将注意权重限制为介于[0,1]之间。和 (该处箭头是反方向)是双向RNN模型的隐藏表示:

ReLU功能被用作激活函数g。我们选择使用普通双向RNN模型的动机是减少模型中参数的设计目的。

所学习的注意权重at用作循环注意门控单元门控制涉及的信息流。此外,另一个学习注意权重所起的作用是提供关于每个时间步骤显着程度的解释性。

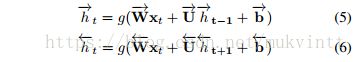

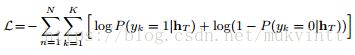

3.3. End-to-EndParameter Learning

假设我们有一个训练集D ={(x(n)1,...,T,y(n))} n = 1,...,N包含N个序列长度T及其相关标签y(n)。 Xt(n)∈RD表示第n个第t个时间步的观测值样本以及T可以是序列之间的不同值。我们共同学习两个TAGM模块(时间注意模块和循环注意的门控单元)和最终的关于的序列分类器的条件负对数似然性参数,通过最小化训练数据:

由于所有三个模块(包括最终序列分类器)都是可分析的,我们的TAGM模型可以随时以端对端的方式进行训练。损失是通过顶层循环注意的单元反向传播时间以及注意模块依次使用反向传播时间算法[40]。

3.4. Comparisonwith LSTM and GRU

虽然我们的模型类似与LSTM和GRU的RNN变体,但它是专门设计用于显着性检测,并在比较时有四个关键区别于LSTM和GRU:

·我们只注意一个标量注意分数来衡量当前时间步的相关性,而不是普遍的门的多维值进行建模,每个隐藏单元都由GRU和LSTM完成。在这我们可以获得可解释的显着性检测(在第4节中展示了三项任务)。

·我们将注意建模和循环隐藏表示学习分离为两个独立的模块来降低耦合度。其中一个这样做的好处是我们能够根据需求的复杂性为不同的每个模块定制特定的循环结构(例如,表格1的TAGM中两个模块中隐藏单元的大小不同)。

·我们采用双向RNN来考虑以上和以下信息时间注意模块中的序列。它有助于模拟序列的时间平滑显着性分数(如图4所示)。这应该值得注意的是它不同于门的设计,在后者的双向LSTM模型中连接两个单向LSTM的隐藏表示,这不能弥补所有矢量门中仍然只考虑单向信息而计算的缺点。

·我们的模型只包含一个标量门,即注意门,而不是GRU中的2个矢量门,以及LSTM有3个门。这样做会强制注意门,全面负责建模显着信息。此外,该模型包含参数更少(与LSTM相比)并且更简单,门控结构冗余度较低(与GRU和LSTM相比)。它简化了训练过程,并且可以减少潜在的过度拟合并且由于少量的训练数据而具有更好的泛化能力,这将在4.1.3节中演示。

4. Experiments

我们在三个公开可用的数据集上进行了TAGM实验,跨越不同的任务和模式来展示泛化这三个数据集:(1)对音频数据集的语音识别,(2)对文本的情感分析数据集和(3)视频数据集上的事件识别。

Experimentalsetup shared across experiments.对于本工作中提到的所有循环网络(TAGM,GRU,LSTM和plain-RNN),隐藏单位的数量是通过从选项集中选择最佳配置进行调整{64,128,256}使用验证集。退出值是从选项集{0.0,0.25,0.5}中选择进行验证以避免潜在的过度拟合。我们使用RMSprop作为在-5和5之间缩减的渐变梯度的下降优化算法[2]。

在公式4中我们验证参数m和b的学习率作出sigmoid的有效区域适用于特定数据的TAGM模型的功能。较大的学习速度会导致更加分散的注意权重。重现我们实验结果的代码是可用1。

4.1. SpeechRecognition Experiments

我们首先对修改后的版本进行初步实验数据集,数据集[9]是由阿拉伯语口语数字(1)评估两个主要模块的有效性TAGM; (2)比较三种不同的概括性门设置循环模型(TAGM,GRU和LSTM),并且训练数据的大小不一。

4.1.1Dataset

阿拉伯语口语数字数据集包含8800个话语,通过向88名阿拉伯语母语人士发出10次十位数字来收集这些信息。每个序列由13维Mel频率倒谱系统组成(MFCC),采样频率为11,025Hz,采样频率为16位海明窗口。我们将白噪声添加到每个样本的开始和结尾以模拟问题具有不分段的序列。无关的长度原始音频剪辑之前和之后的子序列随机化,以确保模型不会训练均匀地集中在序列的中间。

4.1.2Experimental Setup

我们使用与Hammami和Bedda相同的数据部分[9]:6600个样本作为训练集,2200个样本作为测试集。我们进一步从训练集中取出1100个样本作为样本验证集。三组中没有主题重叠。

我们将TAGM的性能与三个基准模型的类型进行比较:

Attention Module + Neural Network (AM-NN).在时间注意模块之上直接使用前馈网络的基线模型,学习包括我们循环注意的单元的影响。在这AM-NN模型中,v被定义为输入的加权特征值:

序列分类结果是通过将h传递给一个 softmax层,如我们的TAGM所做的(参见等式3)。

DiscriminativeGraphical Models. HCRF和HULM是通过插入隐藏层来扩展CRF [20]

对数据中的非线性潜在结构进行建模。区别在于隐藏层的结构:HCRF使用一系列的k-nomial潜变量,而HULM利用k- 二元随机隐藏单元。

Recurrentneural networks.由于我们的模型是一个配备门机制的循环网络,我们将它与其他循环网络进行比较:plain-RNN,GRU,LSTM。我们还研究了双向变体我们的TAGM模型(称为Bi-TAGM),它采用循环的双向循环配置注意门控单元。

在我们的实验中,我们还评估了不同规模训练数据时的普遍性:从1,100到5,500训练样本。在这些实验中,最佳的验证区间从选项集{64,128,256}中自动选择配置。

4.1.3Results and Discussion

Evaluationof Classification Performance 表格1提出了阿拉伯数据集上的几个序列的分类性能的分类器。为了调查手动添加的噪音信息的影响,我们执行在干净和嘈杂的数据版本上进行实验。

虽然Plain-RNN在嘈杂的环境中无法识别口头数字,但其他三种带有入口的门的设置的循环模型不会受到噪音的影响,与HCRF在清洁方面取得的成果相结合数据可以获得可观的表现。我们的模型在所有具有单向循环配置的分类器中实现了最佳结果。这种可能是由于我们的模型更好的概括由于更简单的门设置和相对较小的数据集也是注意机制。我们也进行实验使用GRU,LSTM和TAGM的双向版本,其中我们的Bi-TAGM表现最好。 Bi-GRU实现其目的64个隐藏单元的最佳性能。值得一提的是,我们的(单向)TAGM使用47 K参数已经达到与Bi-LSTM和Bi-GRU相当的结果,也是表明TAGM注意模块中的双向机制使其能够捕获独立注意层中的大多数双向信息。

表1. 通过不同的序列分类模型的阿拉伯语口语数字数据集的分类准确度(%)。星号模型

(*)在处理过的数据版本上进行了训练和评估。注意我们可以分别定制TAGM的两个复杂性模块。看这个设计的优点就显示出来了最佳TAGM模型(验证后),它有128个维度时间注意模块,64个维度循环注意的单元。

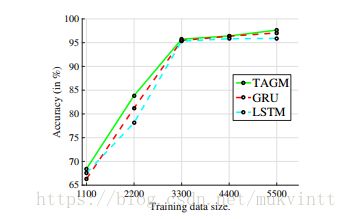

概括性与不同大小的训练数据的比较。我们首先通过改变嘈杂的阿拉伯数据集上训练数据的大小来进行实验,以比较TAGM与GRU和LSTM的一般性。图3给出了实验结果。可以被看见TAGM在用于较小的训练数据大小上表现出比GRU和LSTM更好的概括性,我们相信这是由于需要引入更少的模型参数,避免过度拟合。

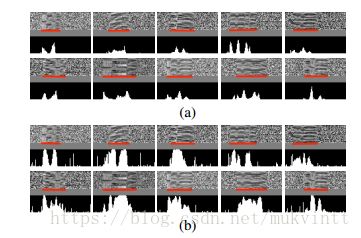

序列显着性检测。为了评估通过我们的TAGM进行序列显着性检测模型,在嘈杂的阿拉伯数据集上训练,我们可视化我们模型的注意权重,如图所示图4.a.它表明注意模型可以正确检测原始信号的信息部分。

为了研究包含在隐藏表示中的时间信息的影响,我们还可以看到注意模块+神经网络的注意权重分类器,如图4.b所示。这表明TAGM产生更清洁和更平滑的注意权重轮廓,也注意到极端的行为,这主要是在我们的时间注意模块中通过双向RNN实现。

图3.嘈杂的阿拉伯语语音的分类准确性数据集作为训练数据的函数。请注意,我们的较少数据训练时,TAGM模型结果胜过GRU和LSTM。

图4.图a中的TAGM和图b中的注意模块+ NN的注意权重的可视化(加权特征被反馈发送到前馈神经网络)10个样本(每一个数字的样本)。对于每个子图,显示顶部子图原始序列数据的谱,底部子图显示随着时间的推移。红线表示突出部分的基本事实。请注意TAGM的注意权重导致更清晰的注意表示。

4.2. SentimentAnalysis Experiments

情感分析是自然语言处理(NLP)该领域的热门研究课题,旨在识别文本域下的视点[25]。我们进行情绪分析实验来评估我们的TAGM模型在文本形式上的表现。

4.2.1Dataset

Stanford Sentiment Tree(SST)[36]是电影评论摘录的数据库。它由11,855个句子组成,每个句子都有一个分数来表示对电影评论的情感态度。数据集提供了两种类型的注释,即情感句级注释(总共有11,855句话)和在短语级别注释(总共215,154个短语)。句级和词组级别标签具有两种分辨率:2元分类任务(正面或负面)和细粒度的任务(5级类别)。

4.2.2Experimental Setup

继之前的工作[36],我们使用300天的手套单词向量(300个维度),在Common Crawl [28]上预训练句子中每个单词的特征。我们的模型非常适合使用句级标签进行情感分析。尽管如此,我们还使用短语级标签进行实验,以便拥有一个与最先进的基线进行公平和直观的比较。

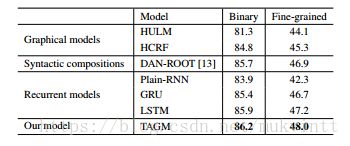

表2.仅使用句级标签进行训练时,Stanford Sentiment TreeBank数据集的分类准确性(%)。我们对二元和细粒度(5级)分类任务。请注意,我们的模型胜过所有其他人任务。

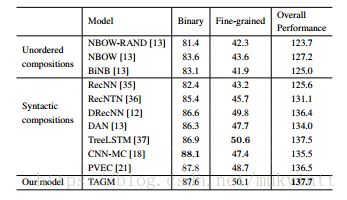

表3.使用短语级别和句级标签进行训练时,Stanford Sentiment TreeBank数据集的分类准确性(%)。我们的TAGM达到了最好的整体效果。

我们遵循与Socher等人所述相同的数据分割。 [85]:8544/1101/2210样本分别用于5级任务的训练,验证和测试。二元分类任务中的相应分割是6920/872/1821。

4.2.3 Results andDiscussion

Evaluation ofClassification Performance 我们进行两组实验来评估我们的性能

模型与基准模型进行比较。自从我们模型被设计用于未分段和可能有噪声的序列建模,虽然也提供了短语级别标签,但它更适合仅在SST数据集中使用句级标签。表2显示了几个连续模型仅用句级标签进行训练实验结果。我们的模型在二元分类任务和细粒度(5级)任务两个方面都取得了最好的结果。由于.LSTM和GRU优于普通RNN模型信息过滤能力由于附加执行逻辑门。值得一提的是,我们的模型取得了更好的成绩性能并且仅比LSTM低一半的隐藏参数。

与现有的情绪进行比较分析模型,我们进行与句子级别和短语级别标签的第二组实验。结果如表3所示。它表明我们的模型胜过了大多数现有模型,并且实现了可比性准确性与最先进的结果。我们的TAGM模型考虑到二分,实际上会获得整体最佳结果和细粒度的情况。这是一个令人振奋的结果,特别是,因为我们的模型并不是专门针对这个模型的NLP任务。

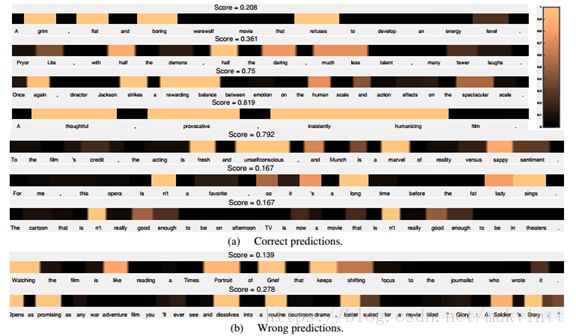

图5.循环注意模型的注意权重的可视化:(a)正确的预测和(b)错误的预测。该显示的分数是表示作者对此评论总体情绪的真实标签。较深的颜色表示较小的分数。

Sequence Salience Detection 为了调查基于TAGM模型的显着性检测情感数据集(SST),我们可以看到测试句子中每个单词的计算的注意权重。(a)组在图5中给出了许多预测的例子我们的模型在二元分类任务中正确。它表明我们的模型能够成功捕捉关键情感的话,省略无关紧要的话,甚至为此语法复杂的句子。我们也测试了包含否定表达式的例子。如上所示(a)两个句子,我们的模型可以很好的处理它们。我们也观察我们正确的情绪标签的模型失败的样本预测(见图5b)。

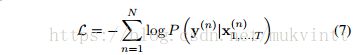

4.3. Event recognitionExperiments

我们随后为视频事件进行实验任务评估我们的视觉形态模型。

4.3.1 Dataset

哥伦比亚消费者视频(CCV)数据库[16]是一个从YouTube视频收集的无约束视频数据库没有任何后期编辑。它由9317个平均持续时间为80秒(共210小时)的网络视频组成。除了一些负面的背景视频,每个视频都是手动注释为20个语义类别中的一个或多个,诸如'篮球','滑冰','骑自行车','生日'等等。由于这是一个非常具有挑战性的数据库,因为其中包含许多嘈杂和无关紧要的部分视频。

4.3.2 Experimental Setup

在Jiang等人[16]说做工作的基础上,我们使用相同的分割来训练和测试集:4659个视频作为训练集和4658个作为测试集。我们将我们的模型与这个数据集上的基线方法[15]进行比较,该方法使用支持向量机(SVM)模型分别执行分类,分开些许流行的功能,然后使用后期结合结果。其实验结果表明在他们尝试过的所有功能中卷积神经网络(CNNs)特征表现最好,我们选择使用CNN具有相同设置的特征,即,预训练的第七个完全连接层的输出(4,096维度)AlexNet模型[19]。为了提高计算效率,我们以1/8的采样率(每八帧中有一帧)提取CNN特征。

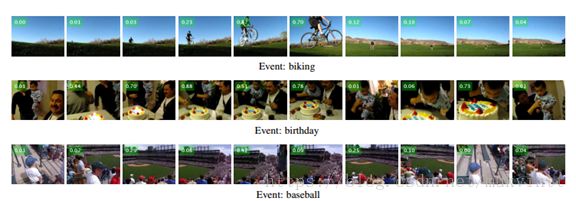

图6.来自CCV数据库测试集的示例中我们的TAGM模型的计算注意权重。注意权重是用于代表性框架。我们的TAGM能够为 “骑自行车”的赛事, “骑行自行车”的活动捕捉,'棒球'的'生日'的“蛋糕”,和'内场区'的动作。包含这三个完整样本序列的视频将在介绍材料文件中补充。

我们采用平均平均精度(mAP)作为评估度量标准,通常用于CCV数据集[16,15]。由于可能发生多于一个事件(正确的标签)样本,我们对每个类别执行二元分类但他们共同训练,因此每个人的预测分数类别由S形函数而不是softmax计算公式3:

并且K类上的联合二叉交叉熵被最小化:

4.3.3Results and Discussion

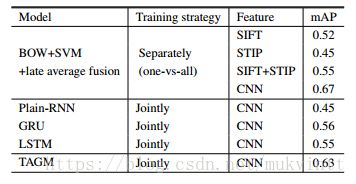

Evaluationof Classification Performance.我们比较我们的模型带有等人[15]所推荐的事件识别系统数据集。表4显示了事件识别的几种模型,其中我们的TAGM大幅优于其他循环模型。在我们的模型中,BOW + SVM基准采用一对多策略为每个事件训练一个单独的分类器,在一个分类器中联合训练所有事件。我们的模型仍然显示出令人振奋的结果,因为TAGM为20个事件捕捉突出部分是一项颇具挑战性的任务同时还有复杂的场景。而且,我们的TAGM可以为BOW + SVM基准提供有意义的解释模型无法做到。

SequenceSalience Detection. 显着性检测由于视频中的复杂和长时间的场景,CCV数据库是一项艰巨而又吸引人的任务。图6显示了一些示例,其中TAGM通过注意权重正确地定位显着子序列。我们的模型能够捕捉事件的相关动作,对象和场景,例如骑自行车的活动“骑自行车”,蛋糕事件'生日'和棒球运动场'棒球'。有趣的是要发现与框架事件'棒球'得分0.42可能是因为右上角的实时屏幕而获得高分。

表4.我们的TAGM模型和模型的平均平均精度(mAP)CCV数据集的基线模型。

5. Conclusion

在这项工作中,我们提出了时间注意门控模型(TAGM),一种用于分类噪声和非分段序列的新模型。该模型受到注意的启发模型和门控周期性网络,并能够检测到序列中的突出部分忽略不相关和嘈杂的部分。由此产生的隐藏结果遭受较少从噪音的影响,从而导致更好的性能。此外,学习的注意分数提供了一个对每个时间步骤观察的相关性的物理意义解释以作最终决定。我们展示了我们对三种方法的推广到很大不同数据集和序列分类任务。作为未来的工作,我们的模型可以扩展为帮助文档或视频摘要。