知识图谱最新权威综述论文解读:知识表示学习部分

知识图谱最新权威综述论文解读:知识表示学习部分

- 知识图谱表示学习

- 1 表示空间

- 1.1 Point-wise空间

- 1.2 复数向量空间

- 1.3 高斯分布

- 1.4 流形和群

- 2 打分函数

- 2.1 基于距离的打分函数

- 2.2 语义匹配模型:

- 3 编码模型

- 3.1 线性/双线性模型

- 3.2 张量分解模型

- 3.3 神经网络模型

- 3.4 卷积神经网络

- 3.5 循环神经网络

- 3.6 Transformer

- 3.7 图神经网络

- 4 结合辅助信息

- 4.1 文本描述

- 4.2 类型信息

- 4.3 视觉信息

- 5 总结

上期,我们简单介绍了2020年知识图谱最新权威综述论文《A Survey on Knowledge Graphs: Representation, Acquisition and Applications》的开篇部分,本期我们将一起学习这篇论文的知识表示学习部分。

论文地址:

https://arxiv.org/pdf/2002.00388.pdfarxiv.org

上期回顾:

知识图谱最新权威综述论文解读:开篇部分

知识图谱表示学习

知识图谱表示学习对于知识获取和下游应用具有很重要的作用。知识表示学习的表示空间包括:point-wise空间,流形空间,复数空间,高斯分布和离散空间。打分函数通常分为基于距离的打分和基于语义匹配的打分函数。编码模型包括:线性/双线性模型,张量分解和神经网络。辅助信息考虑文本,视觉和类型信息。

1 表示空间

1.1 Point-wise空间

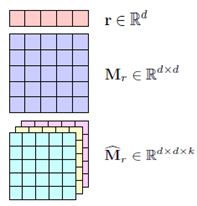

Point-wise的欧式空间是最常用的,将知识图谱中的实体和关系嵌入为向量或者矩阵空间,也有的捕捉关系交互。Point-wise方法包括基于翻译的方法TransE,需要满足平移不变特性h + r = t、TransR、TransH,也有语义匹配的方法NTN、HolE、ANALOGY。

1.2 复数向量空间

从实数空间扩展到复数空间可以得到更多一维的实体和关系表示,具有更丰富的表示能力。ComplEx是第一个将知识图谱表示学习扩展到复数空间的,其中,使用哈密顿乘积法组合多个关系,这种方法可以建模对称和反对称关系。RotatE利用哈密顿乘法将关系视为从头实体到尾实体的旋转操作。QuatE将复数空间扩展到了四元数空间,包含三个虚部和一个实部,通过四元数乘法例如哈密顿乘法组合头实体和关系。

1.3 高斯分布

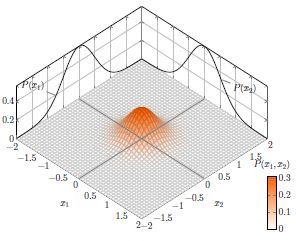

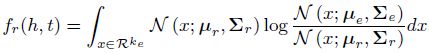

由高斯词嵌入方法得到的启发,KG2E模型将实体和关系嵌入多维高斯分布,均值向量表示实体和关系的位置,方差矩阵建模了不确定性。TransG表示具有高斯分布的实体,同时给出了对于关系嵌入的混合高斯分布。

1.4 流形和群

流形是一种拓扑空间,可以用集合论将其定义为具有邻域的一组点,而该组是抽象代数中定义的代数结构。先前的point-wise建模是一个不适定的代数系统,而ManifoldE将point-wise嵌入扩展为基于流形的嵌入,并介绍了基于流形嵌入的两种设置,即球面和超平面。

基于球面的方法需要将实体和关系从原始空间映射到希尔伯特空间,形式如下公式所示:

TorusE通过将实体和关系嵌入在一个紧凑的Lie群的n维环面空间中,并根据TransE的翻译思想h + r = t来学习嵌入表示。

2 打分函数

打分函数用来衡量一个三元组成立的可靠程度,有时也被称为能量函数,是基于能量的学习框架的基础。基于能量学习的目标是保证正样本的打分高于负样本的打分(在TransE中,是负样本打分高于正样本打分,这个我认为主要看如何定义这个打分函数)。打分函数通常分为两种情况:基于距离的打分函数和基于语义匹配的打分函数。

(1) 基于距离的打分函数通过衡量两个实体之间的距离的可靠程度,这里是使用关系作为加性的平移操作,类似于TransE定义的h + r = t。

(2) 基于语义匹配的打分函数通过头实体向量和关系矩阵的乘性计算,使得头实体与关系组合后转移到尾实体附近h Mr = t

2.1 基于距离的打分函数

SE模型使用两个映射矩阵和L1范数来学习实体和关系的嵌入表示:

![]()

在这之后,就进化为我们耳熟能详的基于翻译思想的TransE模型了:

![]()

自此,TtransE模型的变种和扩展版本就被大量提出,比如将实体表示投影到关系空间的TransR模型:

![]()

通过构建动态映射矩阵的TransD模型:

![]()

为了实现自适应度量学习,用马氏距离来代替欧式距离的TransA模型:

![]()

除了前面完全基于加性算子的打分函数,TransF将完全基于平移的操作扩展到了点乘操作:

![]()

此外,同样基于翻译的思想,KG2E采用高斯空间,并基于两种方式来设计打分函数:

(1)非对称的KL散度:

(2)对称的期望似然:

![]()

采用流形空间的ManifoldE:

![]()

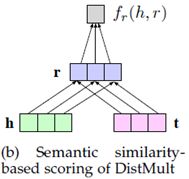

2.2 语义匹配模型:

另一个设计打分函数的思路是计算语义相似度。SME对实体-关系对也就是(h,r)和(t,r)计算其之间的语义匹配程度:

![]()

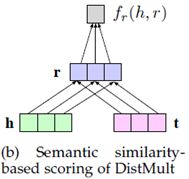

DisMult提出了一个简化的双线性模型:

![]()

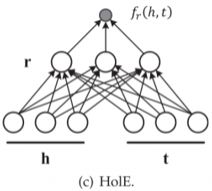

HolE引入了嵌入表示的循环相关操作,可以将其解释为压缩的张量积,其打分函数定义为:

![]()

ANALOGY建模关系数据的类比结构:

![]()

这里,关系矩阵被约束为正规阵。

CrossE除了学习实体和关系的向量表示,同时还学习了一个交互矩阵 C,C 与关系相关,并且用于生成实体和关系经过交互之后的向量表示:

![]()

3 编码模型

通过特定的模型结构能够对实体和关系之间的交互进行编码,包括线性/双线性模型、张量分解模型和神经网络模型。

3.1 线性/双线性模型

线性/双线性模型使用线性操作来编码实体和关系之间的交互:

![]()

或者双线性操作:

![]()

这类模型包括SE、SME、DistMult、ComplEx和ANALOGY。有意思的是,对于采用L2范数的TransE模型,也可以扩展为线性转换的形式:![]()

为解决实体向量在规范化的Polyadia分解中的独立嵌入问题,SimplE引入了关系的逆:

![]()

3.2 张量分解模型

张量分解模型的基本思想是将一个三阶张量中每个切片的矩阵分解为在低维空间的两个实体向量与关系矩阵的乘积。在RESCAL模型中,对于一个具有总共m个关系的知识图谱,其第k个关系对应的表示这个关系的所有实体间关联关系的切片可以分解为:

![]()

LFM对RESCAL通过一个双线性结构进行分解:

![]()

3.3 神经网络模型

对于通过线性/双线性编码实体和关系之间交互的方式也可以利用神经网络来实现,可以将实体和关系输入深度神经网络来输出一个语义匹配的分值。MLP将实体和关系一起送入一个全连接层,并且在第二层使用sigmoid激活函数来对一个三元组打分:![]()

NTN模型将实体的嵌入表示和关系张量一同作为输入,并输出对于三元组的分值:

![]()

3.4 卷积神经网络

众所周知,CNN在图像中具有很强的特征提取的能力,为了能够在知识图谱表示学习中使用CNN,ConvE模型先使用2D卷积将头实体和关系重塑为2维矩阵,然后就可以来建模实体和关系之间的交互

![]()

这里, 表示卷积核,vec是一个向量化操作能够将一个张量reshape为一个向量。

ConvKB通过将头尾实体和关系的嵌入表示直接进行拼接,然后再使用CNN:

![]()

对比ConvE和ConvKB,ConvE捕捉到的是局部关系的特征,我理解的是卷积核只对头实体和关系的嵌入矩阵就行操作,这里没有考虑尾实体,而ConvKB通过拼接操作组合了三元组中的头尾实体和关系,具有更强的特征学习能力,同时保持了一定的平移特性,取得了更好的实验效果。

3.5 循环神经网络

上面的基于MLP和基于CNN的方法都只对三元组进行了编码,而没有考虑长期关系依赖,例如对于知识图谱中的关系路径,就需要使用RNN来进行建模。RSN设计了一个循环跳跃机制,通过区分实体和关系来增强语义表示能力。对于一条通过在知识图谱中随机游走生成的关系路径,利用RNN得到隐层状态:

![]()

3.6 Transformer

Transformer在NLP里尤其是以Bert为代表的自然语言预训练中已经成为炙手可热的一项技术,基于Transformer的表示学习可以集成知识图谱中的上下文信息。CoKE使用Transformer来编码边和路径序列。KG-BERT从预训练语言模型中得到启发,采用Transformer来编码实体和关系。

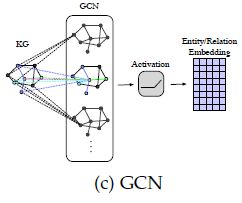

3.7 图神经网络

GNN可以在一个encoder-decoder框架下学习连接结构信息。RGCN提出了关系特定的转换,以建模知识图谱的有向性。在第l+1层得到的聚合一个实体的邻域信息的状态为:

这里,GCN是一个编码器,针对不同任务可以选择不同的编码器集成到RGCN这个框架中。由于RGCN将每个实体的邻域信息都等价对待,

SACN设计了带有权重的GCN,定义了相同关系类型下两个邻接的节点连接强度。解码器模块通常使用ConvE来作为语义匹配的度量,使用C个卷积核,可以得到实体和关系嵌入表示的卷积输出为

![]()

接着,打分函数设计为:![]()

KBAT模型通过拼接实体和关系嵌入表示,然后采用图注意力网络和多头注意力机制来编码多跳邻域信息。

4 结合辅助信息

为了进一步提高表示学习的性能,结合一些外部辅助信息可以实现多模态嵌入,包括文本描述,类型约束,关系路径,视觉信息与,逻辑规则等和知识图谱本身进行结合。

4.1 文本描述

知识图谱中的实体描述信息可以补充语义信息。结合文本描述的知识表示学习的挑战在于如何将结构化的知识图谱和非结构化的文本描述嵌入在同一个表示空间中。一种方法是通过引入实体名称和Wikipedia的集合,用对齐模型来对齐实体空间和词空间。DKRL对TransE进行扩展,利用CNN学习实体描述的表示。SSP将三元组和文本描述映射到一个语义空间中,并用一个关于嵌入的loss和一个关于主题的loss组成整体loss。

4.2 类型信息

知识图谱中的实体有时会带有层次化的类别或类型信心。SSE模型结合实体类型来对属于同一类型的实体进行嵌入。TKRL通过关于实体类型的映射矩阵来捕捉层次化类型信息。KR-EAR将关系类型分为属性和关系,并建模了实体描述之间的关联。

4.3 视觉信息

视觉信息例如实体的图片也能够用来增强知识表示学习。IKRL将图像编码到实体空间,确保基于三元组结构化的表示和基于图像的表示处于同一表示空间中,并遵循平移不变原理学习实体和关系的嵌入表示。

5 总结

最流行的表示空间是基于欧氏空间,通过将实体嵌入向量空间并通过向量,矩阵或张量建模实体间的交互。其它表示空间包括复数向量空间,高斯分布以及流形空间和群。流形空间比点式欧式空间具有的优势是可以放宽点式嵌入。高斯嵌入能够表示实体和关系的不确定性以及多重关系的语义。嵌入复数向量空间可以有效地建模不同的关系连通性模式,尤其是对称/反对称模式。表示空间在编码实体的语义信息和捕获关系属性方面起着重要作用。在设计表示学习模型时,应仔细选择和设计适当的表示空间,以匹配编码方法的性质,并平衡表示能力和计算复杂性。基于距离的度量的打分函数使用翻译原理,而语义匹配打分函数使用合成运算符。编码模型(尤其是神经网络)在建模实体和关系的交互过程中起着至关重要的作用。双线性模型也引起了很多关注,一些张量分解模型也可以视为该类方法。其他方法包含文本描述,关系/实体类型和实体图像的辅助信息。

最近几年最前沿的知识表示学习模型如下表所示:

后期,我们还会对这篇综述的知识获取和知识应用部分进行解读。

欢迎关注微信公众号“人工智能遇上知识图谱”,也欢迎关注知乎专栏“人工智能遇上知识图谱“,让我们一起学习并交流讨论人工智能与知识图谱技术。