迁移学习综述笔记: Transfer Adaptation Learning: A Decade Survey

迁移学习综述笔记

Paper Reading Note

URL: https://arxiv.org/pdf/1903.04687.pdf

TL;DR

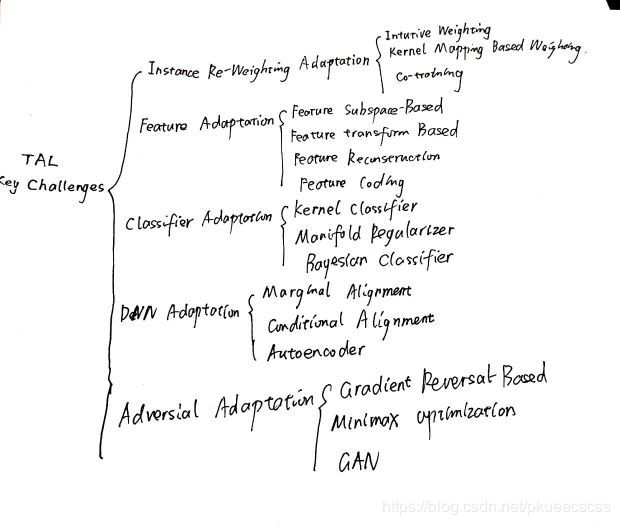

19年所做的对迁移学习和域适应(作者统称为Transfer Adaptation Learning,TAL)的综述,总结了five key challenges of TAL以及TAL模型测试的12个benchmark.作者认为TAL研究的五大关键技术是:

- Instance Re-Weighting Adaptation,样本迁移,在源域中找到与目标域相似的数据,把这个数据的权值进行调整,使得新的数据与目标域的数据进行匹配,然后加重该样本的权值,使得在预测目标域时的比重加大

- Feature Adaptation,特征适应,意在为不同域的数据找到共同的特征表示方法

- Classifier Adaptation,分类器适应,利用source domain的大量带标注数据和target domain的少量带标注数据学习一个generic classifier

- Deep Network Adaptation,DNN适应,研究如何将DNN学习到的特征在不同领域间迁移

- Adversial Adaptation,对抗式适应,基于GAN的思想,使特征生成和域分类器进行对抗训练,直到两个领域的分布难以区分

五个领域细分的taxonomy我自己画了一张图概括,全文的信息量对刚接触TL的同学来说非常大,详细的介绍见note正文.个人认为对我们的工作意义较大的部分是DNN Adaptation和Adversial Adaptation,

Information below is optional; you can change/remove it if you like

Taxonomy of TAL Methods

1.Instance Re-Weighting Adaptation

样本迁移,在源域中找到与目标域相似的数据,把这个数据的权值进行调整,使得新的数据与目标域的数据进行匹配,然后加重该样本的权值,使得在预测目标域时的比重加大.单纯的Instance Re-Weighting方法适用于source与target 分布差距不大时,差距较大时Instance Weighting一般与其他技术共用.样本迁移的方法可分为三个子模型:

1.1 Intuitive Re-Weighting

最早的朴素Instance Reweighting方法,即学习权重使source domain的数据分布接近target domain

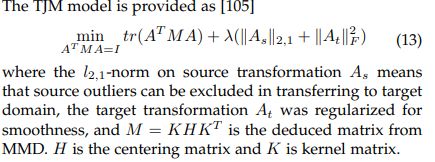

1.2 Kernel Mapping Based Re-Weighting

Intuitive Re-Weighting是在raw dataspace上操作的,而Kernel Mapping Based-ReWeighting是通过kernel mapping,使source和target在再生的希尔伯特核空间(RKHS)上距离最小化(距离衡量用MMD或KMM)做Distribution Mapping.核映射后两个域的边缘分布相似,但条件分布仍不同,可以利用Sample Selelction做进一步变换,可以利用cluster assumption做聚类,选取同一个cluster中标签相同的source samples,另一种方法是TJM model, 给变换矩阵加上范数正则项排除Outliers:

1.3 Co-training Based Weighting

共同训练法, 首先分别在每个视图上利用有标记样本训练一个分类器;然后,每个分类器从未标记样本中挑选若干标记置信度(即对样本赋予正确标记的置信度)高的样本进行标记,并把这些“伪标记”样本(即其标记是由学习器给出的)加入另一个分类器的训练集中,以便对方利用这些新增的有标记样本进行更新。

2. Feature Adaptation

2.1 Feature Subspace-Based

利用子空间变换做无监督域适应,代表有sampling geodesic flow(SGF),geodesic flow kernel(GFK) and subspace alignment(SA),共同的假设是数据可在低维线性子空间表示,常用PCA做降维, 然后在子空间上做域适应,有两种思路:

- 利用Geodesic flow kernel,集成无穷多个子空间来模拟域的移动,代表方法有SGF和GFK,参见论文Geodesic Flow Kernel for Unsupervised Domain Adaptation

- subspace alignment,利用变换矩阵等方法直接对其\source和target的subspace对齐,代表方法有SA,SDA,GTH

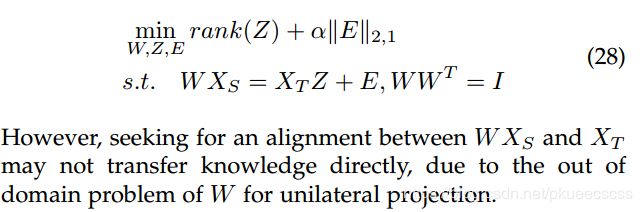

2.2 Feature Transformation-Based

对数据做变换或映射使source domain和target domain的分布尽量match.CV领域迁移学习的主流之一,可分为:

-

Projection-Based:学习一个源域和目标域之间的映射矩阵最小化分布差异

-

Metric-Based: 在带标签的源域上学习一个合适的distance metric,使之也适用于目标域

-

Augementation-Based:特征增强方法,假设数据的特征可分为common,source specific,target specific三种,基于此进行数据增强

2.3 Feature Reconstruction-Based

利用source domain重建target domain以学习共同特征,排除outliers和噪音,对reconstruction矩阵加以rank或sparsity的限制以更好地学习两个领域的相关性

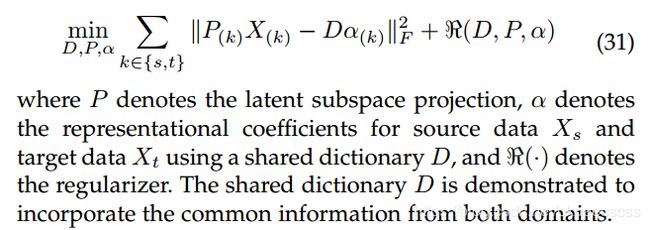

2.4 Feature Coding-Based

Feature Reconstruction是在两个领域的raw feature上学习reconstruction coefficients,而feature coding的方法注重于 seeking a group of basis (i.e., dictionary)

and representation coefficients in each domain, 所以又称为域适应字典学习(domain adaptive dictionary learning).

2.5 Feature-Based Future Directions

- 在MMD之后,提出更好的similarity metric

- ensemble线性和非线性的域特征模型

3. Classifier Adaptation

分类器适应,利用source domain的大量带标注数据和target domain的少量带标注数据学习一个generic classifier

3.1 Kernel Classifier-Based

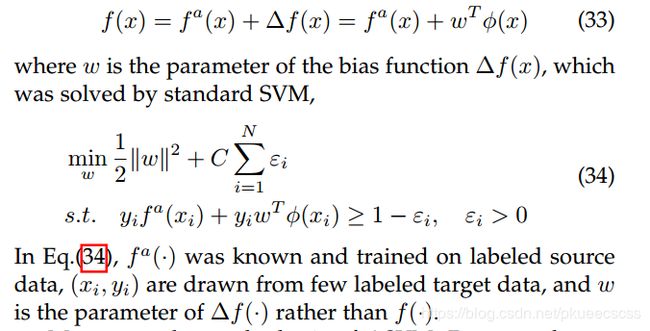

基于核方法,一种思路是ASVM,在SVM中加一个bias item:

另一种是基于multiple kernel learning(MKL), MMD based kernel matching

metric d k 2 ( ) d_k^2() dk2() was jointly minimized with the structural risk based classifiers

3.2 Manifold Regularizer-Based

流形正则化方法,有兴趣的同学可以参考经典论文Manifold Regularization: A Geometric Framework for Learning from Labeled and Unlabeled Examples.这种方法基于半监督学习的manifold assumption,即假设特征空间中距离近的样本属于同一类别的可能性较大.核心是挖掘边缘分布的几何形状,将其作为一个增加的正则化项,用了有监督和无监督样本共同来挖掘这一个数据分布的几何结构,这样训练出来的分类器就有更好的泛化性.

3.3 Bayesian Classifier-Based

通过对先验知识建模弥补数据不足带来的泛化性能损失,本人对贝叶斯学习不够了解,有待阅读相关paper后补充:

- Kernelized Bayesian Transfer Learning

- Optimal classifiers with minimum expected error within a bayesian framework

- Bayesian Generative Active Deep Learning

4. Deep Network Adaptation

DNN适应,研究如何将DNN学习到的特征在不同领域间迁移,个人认为这是迁移学习和我们的工作最相关的部分,基于instance,feature,classifer的方法都可以整合到这里来.

作者列出了很多paper,本人认为与我们的工作密切相关且值得一读的有:

- How transferable are features in deep neural networks

- DeCAF: A Deep Convolutional Activation Feature for Generic Visual Recognition

- Learning Transferable Features with Deep Adaptation Networks

作者将DNN Adaptation 分为三个子领域:

4.1 Marginal Alignment-Based

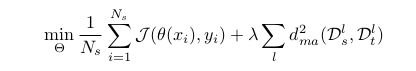

边缘分布对齐,将source domain和target domain各层特征的MMD距离加入损失项,代表是DDC和DAN,模型可表述为:

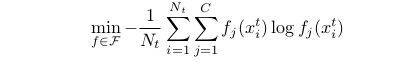

J J J是交叉熵损失函数, θ \theta θ是特征映射函数, D l D^l Dl指网络在第l层输出的特征,边缘对齐 d m a 2 ( ) d^2_{ma}() dma2()是边缘分布对齐的函数(即MMD).这个式子没有考虑网络在目标域的输出,可以用uncertainty minimization解决这个问题:

4.2 Conditional Alignment-Based

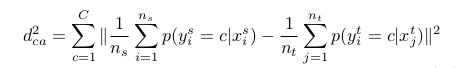

在4.1的基础上多考虑语义信息,定义了与MMD类似的 d c a d_{ca} dca,将条件概率项加入到损失中

4.3 Autoencoder-Based

用source data训练encoder,用decoder表征target data来做Adaptation.Stacked deep autoencoder用于TAL的General idea可以用这个式子表示:

f f f是共用的encoder, g g g是共用的decoder, z z z是中间特征, J J J是reconstruction error(均方根误差), Ω \Omega Ω是衡量source和target feature分布差距的distribution discrepancy metric, L L L是带标签源域上的分类损失, R R R是参数正则项. Ω \Omega Ω可用KL散度表示,参见Supervised reparesentation learning: Transfer learning with deep autoencoders,

5. Adversial Adaptation

对抗式适应,基于GAN的思想,使特征生成和域分类器进行对抗训练啊,直到两个领域的分布难以区分.作者介绍了三类方法,前两种是基于特征进行domain discrimination,第三种是用GAN生成target domain的图像.

5.1 Gradient Reversal-Based 与 Minimax Optimization-Based

在网络中加入gradient reversal layer(GRL).模型由三部分构成:domain-invariant的特征表示模型,参数 θ f \theta_f θf,图像分类器,参数 θ c \theta_c θc,域分类器,参数 θ d \theta_d θd.学习特征表示参数 θ f \theta_f θf时,最小化图像分类器的损失 L c L_c Lc,最大化域分类器的损失 L d L_d Ld.

5.2 GAN-Based

用GAN生成target domain的图像,代表工作有基于CycleGAN的CyCADA和DupGAN等.

Thoughts

这篇论文是非常详尽的迁移学习综述,其中DNN-Based和GAN-Based的方法非常契合数据标注研究的需要,值得进一步调研.