pyspark的windows7环境搭建

安装步骤

注意:本篇的所有资源可通过百度网盘提供,减少寻找和下载时间

链接:https://pan.baidu.com/s/1v53Vt5NZEPZigCXE6rjDGQ

提取码:64pi

1.安装java

这里选择version 1.8.,配置环境变量JAVA_HOME,PATH,CLASSPATH

参考链接:Java JDK8下载地址,Java安装及环境配置

注意java的版本不能太高,否则后面java安装会报错。

2.安装scala,配置环境变量

(1).从 Scala官网下载目录下载 Scala 二进制包,本教程将下载 2.11.8版本

下载后,双击 msi 文件,一步步安装即可,安装过程使用默认的安装目录即可。

(2).右击【我的电脑】--【属性】--【高级系统设置】--【环境变量】

设置 SCALA_HOME 变量:单击新建,变量名输入:SCALA_HOME,变量值输入:C:\scala,即 Scala 的安装目录

注意安装目录名称不能有空格。

设置 Path 变量:找到Path,单击编辑。变量值添加如下的路径: %SCALA_HOME%\bin;%SCALA_HOME%\jre\bin;

注意:后面的分号 ; 不要漏掉。

设置 Classpath 变量:找到ClassPath,单击编辑。变量值添加:.;%SCALA_HOME%\bin;%SCALA_HOME%\lib\dt.jar;%SCALA_HOME%\lib\tools.jar.;

(3).检查软件是否安装成功

cmd中输入 scala,看到如下结果,说明安装成功。

3.安装spark,配置环境变量

(1).从Spark官网下载地址下载需要的spark版本,下载并解压到本地某目录下即可。

(2).配置环境变量

设置SPARK_HOME变量:新建系统变量,变量名输入:SPARK_HOME,变量值输入:C:\spark\spark-2.1.0-bin-hadoop2.7

设置Path变量,找到Path变量,点击编辑,变量值输入: %SPARK_HOME%\bin;

4.安装hadoop,配置环境变量

(1).从hadoop官网下载地址下载需要的hadoop版本,下载并解压到本地某目录下即可。

(2).配置环境变量

设置HADOOP_HOME变量:新建系统变量,变量名输入:HADOOP_HOME,变量值输入:C:\hadoop\hadoop-2.7.6

设置Path变量,找到Path变量,点击编辑,变量值添加: %HADOOP_HOME%\bin;

5.安装winutil.exe

从winutil下载地址下载地址下载hadoop对应版本的winutil.exe

进入hadoop-2.7.1/bin/,下载winutil.exe,并将其拷贝到hadoop的bin目录下,我这里为C:\hadoop\hadoop-2.7.6\bin

通过cmd进入C:\hadoop\hadoop-2.7.6\bin目录,并运行如下命令:

winutils.exe chmod -R 777 c:/tmp/Hive

6.配置其他相关

(1).将spark所在目录下的pyspark文件夹(C:\spark\spark-2.1.0-bin-hadoop2.7\python)拷贝到python文件夹下(C:\Anaconda3\Lib\site-packages)

注意:需安装python3.5(对应的anaconda版本为Anaconda3-4.2.0-Windows-x86_64.exe),spark不支持python3.6

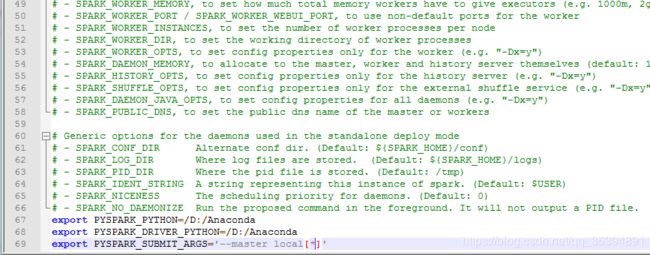

(2).重命名spark/conf下的spark-env.template为spark-env,并修改spark-env文件,最后加入如下三行:

(3).通过Anaconda navigator的Environments安装py4j库

这里默认已经安装好了Anaconda

pyspark依赖于py4j,导入之前必须确保已安装py4j库

(4).添加系统环境变量

新建系统变量,变量名输入:PYTHONPATH,变量值输入:%SPARK_HOME%\python\lib\py4j;%SPARK_HOME%\python\lib\pyspark

7.检查软件是否安装成功

cmd中输入 pyspark,看到如下结果,说明安装成功。