PaddlePaddle--python小白逆袭打卡营7日心得

在此之前已经参加过两期打卡营了,第二期CV特辑的适合深感自己半路出家基础太不牢靠了,PaddlePaddle是我第二个使用的深度学习框架,以前看过一些pytorch。之前两期主要使用paddlepaddle搭建网络,没有详细了解深度学习使用时就特别难,这期的paddlehub不一样,简单易用,搭建快速,只要懂python基础,看着官方文档,马上就可以搞出来一个高大上的人工智能来。

参与前有些担心因为自己基本功不扎实,怕自己跟不上。但是参与之后发现,老师助教班班真的太棒了

day01

学习的是python基础,简单的循环和文件操作。比较难的一点就是文件操作(现在回头再看,也不是那么难),因为当时不知道有 os.walk()这个方法只能“苦兮兮”的自己写。

# 递归版本

def findfiles(path):

#在这里写下您的查找文件代码吧!

directory = os.listdir(path)

for one in directory:

f = os.path.join(path,one)

if os.path.isdir(f): #递归搜索文件夹

findfiles(f)

elif os.path.isfile(f):

if re.search(filename,f):

result.append(f)

print('[%d,\'%s\']'%(len(result),f))

#非递归版本

def findf():

dire = os.listdir(path)

paths = []

for d in dire:

paths.append(os.path.join(path,d))

for p in paths:

if os.path.isdir(p):

dire = os.listdir(p)

for d in dire:

paths.append(os.path.join(p,d))

elif os.path.isfile(p):

if re.search(filename,p):

result.append(p)

for i in range(len(result)):

print('[%d,\'%s\']'%(i+1,result[i]))

不过这些都不是重点,day01的重点是 百度AI技术体验传送门,体验这个,对AI的兴趣大增,也了解到了当前商业化应用AI的典型样例(PS:动漫头像制作好评~~~)

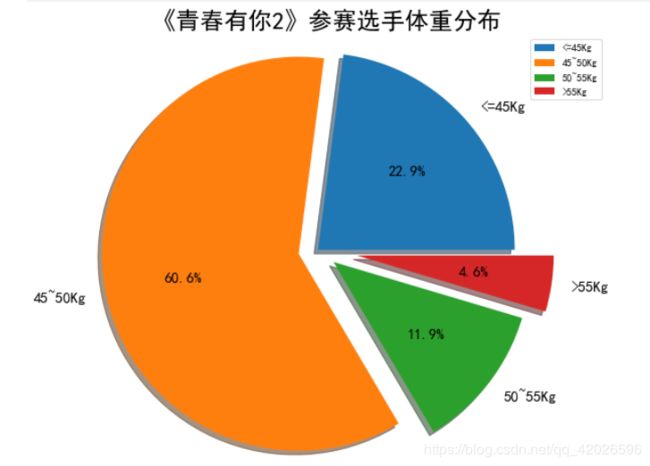

day02

学习的爬虫,以前简单了解过,但是没用过bs4。这次使用bs4简直就是如有神助,比正则舒服多了。

import json

import re

import requests

import datetime

from bs4 import BeautifulSoup

import os

#获取当天的日期,并进行格式化,用于后面文件命名,格式:20200420

today = datetime.date.today().strftime('%Y%m%d')

def crawl_wiki_data():

"""

爬取百度百科中《青春有你2》中参赛选手信息,返回html

"""

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36'

}

url='https://baike.baidu.com/item/青春有你第二季'

try:

response = requests.get(url,headers=headers)

print(response.status_code)

#将一段文档传入BeautifulSoup的构造方法,就能得到一个文档的对象, 可以传入一段字符串

soup = BeautifulSoup(response.text,'lxml')

#返回的是class为table-view log-set-param的