MPEG最新进展 - 20191110

目录

作者序

一、视频方面

二、音频方面

三、Point Clouds方面,点云

四、Font 方面

五、神经网络方面

六、基因组数据Genomic data方面

七、场景描述方面

八、传输方面

九、文件格式File Format方面

十、API方面

十一、探索

面对机器的视频编码的探索

基于MPEG-21的智能合约的探索

机床数据的探索

其他数据

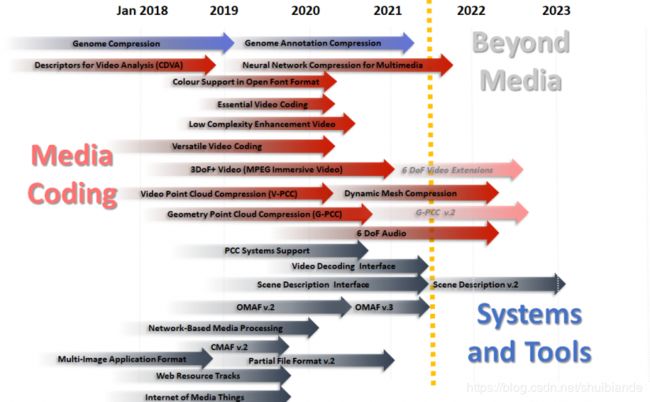

十二、MPEG工作计划

原文:《What is MPEG doing these days?》来自

作者序

距离我上次谈论MPEG开发的进展已经过去几个月了。由于标准团体变化很快,我认为是时候对标准的一些主要领域进展进行更新了:视频、音频、Point Clouds、字体、神经网络、基因组数据Genomic data、场景描述、传输、文件格式File Format和API。MPEG正在进行的三各方面的探索,你在下文中也可能找到相关的描述:

-

Video Coding for Machines

-

MPEG-21 contracts to smart contracts

-

Machine tool data.

-

一、视频方面

视频方向仍然是一个非常活跃的方向。 现在正在为HEVC定义新的SEI(Supplemental Enhancement Information)消息,与此同时,因为要在2020年7月使VVC达到FDIS状态(Final Draft International Standard),VVC的活跃度非常高。VVC的验证测试目前尚未进行,但可以预期的是VVC会带来约1000的视频压缩数值, 可以从下表中看到,给出了没个标准相对于先前标准的比特率降低率。

MPEG-1是与未压缩视频的视频进行的对比。

VVC比特率降低率数据是预测数据。

| Standard |

Bitrate reduction |

Year |

| MPEG-1 Video |

-98% |

1992 |

| MPEG-2 Video |

-50% |

1994 |

| MPEG-4 Visual |

-25% |

1999 |

| MPEG-4 AVC |

-30% |

2003 |

| MPEG-H HEVC |

-60% |

2013 |

| MPEG-I VVC |

-50% |

2020 |

1000的视频压缩数值就是这样计算出来的:0.02*0.5*0.75*0.7*0.4*0.5(=0.00105)。

用于VVC的SEI消息定义在MPEG-C第7部分《用于编码视频比特流的SEI消息》中。SEI消息的这份规范是通用的,因为SEI消息的传输既可以在视频比特流中实现,也可以在系统层实现。针对以前的视频编码标准也做了考虑,消息传输可能同样适用。

MPEG CICP(Coding-Independent code - points)第4部分“Usage of video signal type code points”已经发布。技术报告通过说明视频内容生产中(colour-related code points)与颜色相关的代码点和描述数据的使用方法,提供了在行业实践中广泛使用的视频内容融合(combinations of video properties)方面的指导。

MPEG当然还在研究两个“传统的”视频编码标准,都包含在MPEG-5中:

-

Essential Video Coding (EVC) :基本视频编码EVC用于在某些场景中满足业务需求,例如视频流(现有的ISO视频编码标准并没有因其拥有极其鲜明的“技术属性”而被广泛采用)。EVC现在正在作为DIS(Draft International Standard)进行投票。从事EVC工作的专家正在积极准备验证测试,以了解“为了满足业务需求”将在性能方面花费多少成本。

-

Low Complexity Enhancement Video Coding (LCEVC):低复杂度增强视频编码可以利用其他视频编解码器,从而可以在保持或降低总体编码和解码复杂性的同时提高视频压缩效率。LCEVC目前是CD(Committee Draft)。

MPEG-1 OMAF(Omnidirectional MediA Format)已经支持三个自由度(3DoF)(2018),使用者的头部可以左右摇摆,俯仰和滚动,但是身体的位置是静态的。但是,渲染平坦的360°视频(i.e. 仅支持头部旋转)可能会产生视觉不适,尤其是渲染接近使用者的对象。

6DoF在3DoF基础上,还可以在水平,垂直和深度方向上平移运动。平移的支持使得交互式运动视差可以进行事先,从而为观看者提供相对于他们视觉系统的自然信号,并增强他们周围的音量感知。

MPEG当前正在制定:MPEG-I标准第12部分“沉浸式视频Immersive Video– MIV”,该标准可在有限的空间内进行头部缩放运动。在关于《视频和3D图形的融合》( On the convergence of Video and 3D Graphics)的文章中,我提供了一些用于实现该目标的技术详细信息,并将其与基于视频的点云压缩(V-PCC,Video-based Point Cloud Compression)所使用的技术进行了比较。MIV计划于2020年10月到达FDIS阶段。

-

二、音频方面

音频方面的专家正在努力利用MPEG-H 3D音频标准去提供完整的6DoF音频体验。也就是说,使用者可以在水平和垂直平面上定位声音对象,并感知声音对象随用户在音频对象周围移动而发生的响度变化,感知真实空间中的声音混响以及感知物理对象置于声源和用户之间时的遮挡。

用于测试这些提案的系统特性如下:

-

音频源编码:使用MPEG-H 3D音频

-

元数据编码:举例,来源的方向性或室内声学特性

-

沉浸式VR的音频和视觉展示(presentations )(精确感知没有任何视觉信号的虚拟音频空间是一道难题)

-

虚拟现实篮球场,沉浸式音频渲染器响应于用户对球的交互而产生声音,并且所有的“声音”都被压缩,并从服务器传输到客户端。

对提案的评估将通过以下:

-

完整的实时视听演示

-

可实现“完整(Unity)”视觉呈现的头戴式显示器

-

用于音频演示的耳机和“ Max 8”

-

使用Max VST3 plugin情况下可以实时运行的技术。

由于计划于2022年1月到达FDIS阶段,因此这是目前时限最长的MPEG-I项目。

MPEG沉浸式视频和音频具有许多功能。最重要的是,它们都不是“压缩标准”,它们使用现有的压缩技术,在这些技术的基础上,沉浸式功能元数据将由沉浸式视频(MPEG-1的第12部分)和沉浸式音频(MPEG-I的第5部分)进行定义。MPEG-I第7部分“沉浸式媒体元数据”还将包含来自不同子组的其他元数据。

-

三、Point Clouds方面,点云

基于视频的点云压缩技术正在快速发展,计划于2020年1月到达FDIS阶段。(适用于密集点云,请参阅https://mpeg.chiariglione.org/webtv?v=802f4cd8-3ed6- 4f9d-887b-76b9d73b3db4)该技术的成熟度可以通过相关的活动(Systems activities)得知,稍后将进行报告。

基于几何的点云压缩,(适用于稀疏点云,请参见https://mpeg.chiariglione.org/webtv?v=eeecd349-61db-497e-8879-813d2147363d)该技术将延期6个月,预计到达FDIS阶段将是2020年7月。

-

四、Font 方面

MPEG正在扩展修订MPEG-4 Part 22‘Open Font Format’。修订标题为“Colour font technology and other updates”。

-

五、神经网络方面

神经网络是一种新的数据类型。严格来说,它是为了解决针对多媒体内容描述和分析的神经网络训练的压缩问题。

MPEG专家称之为NNR,它的进展很快。

-

首次提出是在2017年10月并进行了讨论;

-

2018年7月发布征求意见书(CfE,Call for Evidence);

-

2018年10月发布征求提案书(CfP,Call for Proposal);

-

2019年1月的会议上收到九份回复;

-

2019年3月小组发布工作草案(working draft)。

这是一个一个非常活跃的工作组,正在努力在2020年10月到达FDIS阶段。

NNR的更多内容参阅“ Moving intelligence around”。

-

六、基因组数据Genomic data方面

在MPEG-G 1-3部分中,MPEG提供了文件和传输格式、压缩技术、元数据规范、保护帮助(protection support)以及使用本地压缩格式访问测序结果(sequencing data)的标准APIs。借助随附的第4部分和第5部分参考软件以及一致性,MPEG将提供第1-3部分中大部分技术的软件实现,以及与MPEG-G一致性检测方法,2020年4月将达到FDIS阶段。

2020年1月是有关基因组注释编码提案征集的截止日期。此次征集是对大多数基于测序协议的生物学研究的需求的回应,以将不同类型的注释附加在一起,这些注释均与参考序列上的一个或多个间隔相关联,这是由所谓的二次分析产生的。此次征集的目的是获得提供此类注释的压缩呈现(representation,唉representation 一直不好翻译)的技术。

-

七、场景描述方面

MPEG参与场景描述技术的历史可以追溯到1996年,当时它为其Binary Format for Scenes(BIFS)选择VRML为起点。MPEG后续制定了MPEG-4 LASeR、MPEG-B 媒体编排(Media Orchestration)和MPEG-H Composition Information。

MPEG-I同样也离不开场景技术。与过去一样,MPEG将从现有规范glTF2(https://www.khronos.org/gltf/)开始,选择它是因为它是开放的、可扩展的、广泛支持的(许多加载程序和导出程序的广泛支持),它使MPEG能够扩展音频、视频和点云对象的glTF2功能。

基于glTF2的场景描述将是MPEG-I的第14部分。

-

八、传输方面

传输是实时媒体的基本功能,MPEG一直在开发此类标准,不仅针对MPEG自身的标准,而且还包括JPEG标准(例如,JPEG 2000和JPEG XS)。以下是MPEG在这个重要的应用领域中正在做的事情:

-

MPEG-2 part 1 Systems:一个MPEG-2 TS中的承载VVC的修正WD(Working Draft)。由于广播有望成为VVC的‘大用户’,因此这个需求比较紧急。

-

MPEG-H part 10 MMT FEC Codes:对基于窗口的前向纠错(FEC,Forward Error Correcting)代码的修订

-

MPEG-H part 13 MMT Implementation Guidelines:一个对MMT实施指南的修订。

-

九、文件格式File Format方面

基于ISO的媒体文件格式(ISO-based Media File Format)是一个非常多产的标准领域,它扩展了许多MPEG标准。MPEG在这个至关重要的应用领域正在做的事情有:

-

MPEG-4第12部分——ISO基本媒体文件格式(MPEG-4 part 15 Carriage of NAL unit structured video in the ISO Base Media File Format):对紧凑影片分段(Compact movie fragments)和EventMessage轨道格式的两项修订

-

MPEG-4第15部分——使用ISO基本媒体文件格式传输NAL单元结构视频(MPEG-4 part 15 Carriage of NAL unit structured video in the ISO Base Media File Format):HEVC传输改进的修订,以及开始VVC传输的修订,它是MPEG-2 TS中的VVC传输的共同进程

-

MPEG-A第19部分——通用媒体应用格式(MPEG-A part 19 Common Media Application Format):开始对CMAF的增强媒体配置文件进行的修订。CMAF的广泛使用伴随支持更多格式的需求

-

MPEG-B第16部分——ISOBMFF中的派生视觉轨道(MPEG-B part 16 Derived Visual Tracks in ISOBMFF):开始WD(Working Draft)

-

MPEG-H第12部分——图像文件格式(MPEG-H part 12 Image File Format):对支持预测图像编码,突发,包围和其他改进的修正,以使HEIF可以存储预测编码的视频

-

MPEG-DASH第1部分——媒体演示说明和片段格式(MPEG-DASH part 1 Media presentation description and segment formats):新版本包含CMAF支持、事件处理模型和其他扩展

-

MPEG-DASH第5部分——服务器和网络辅助DASH(SAND)(MPEG-DASH part 5 Server and network assisted DASH (SAND)):对SAND消息的FDAM 改进版本已发布

-

MPEG-DASH第8部分——基于会话的DASH操作(MPEG-DASH part 8 Session based DASH operations):WD(Working Draft)已启动

-

MPEG-I第2部分——全向媒体格式(MPEG-I part 2 Omnidirectional Media Format):OMAF第二版已经开始起草

-

MPEG-I第10部分——基于视频的点云压缩数据的传输(MPEG-I part 10 Carriage of Video-based Point Cloud Compression Data):目前是CD(Committee Draft)。

-

十、API方面

这方面的MPEG标准收到越来越多的关注:

-

MPEG-I第8部分——基于网络的媒体处理(MPEG-I part 8 Network-based Media Processing)有望在2020年1月到达FDIS阶段

-

针对NBMP的MPEG-I第11部分——实施指南将于2020年4月进入TR阶段

-

MPEG-I第13部分——视频解码接口(MPEG-I part 13 Video decoding interface)是一种新的接口标准,允许外部应用程序从VVC比特流中提供一个或多个矩形视频窗口。

-

十一、探索

-

面对机器的视频编码的探索

MPEG正在进行可能产出未来标准的领域的探索:6DoF、密集光场、机器视频编码(VCM)。探索VCM是因为:传统的视频编码旨在在固定比特率约束下获得最佳视频/图像,这个固定比特率以人为消费目标(consumption targets),但车联网、视频监控、智慧城市正在产生的数据量巨大的数据,使得传统的以人为本的场景在时延和规模方面效率低下且不切实际。

二十年前,MPEG-7项目开始开发着手一套全面标准包含音频,视频和多媒体描述符。MPEG-7为搜索和分析应用程序在标准的其他部分添加了视觉信息的其他标准描述。VCM可以重新利用这样的经验并在新环境(神经网络的扩展使用)中对其进行构架。感兴趣的人可以订阅https://lists.aau.at/mailman/listinfo/mpeg-vcm上的机器视频编码特别小组,并通过[email protected]参加讨论。

-

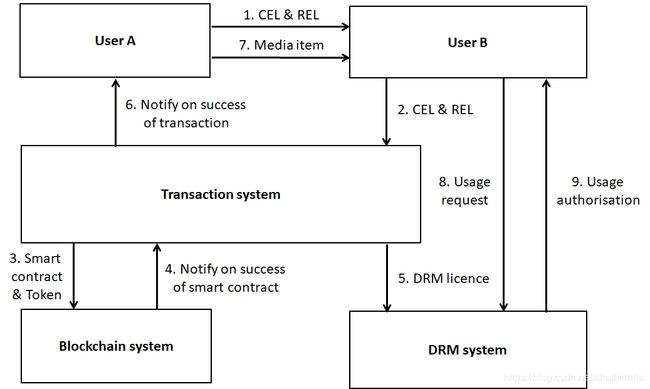

基于MPEG-21的智能合约的探索

MPEG在MPEG-21媒体电子商务框架中开发了一些标准,以解决数字许可证和合同的问题。区块链可以执行智能合约,但是区块链可以将MPEG-21合约转换为智能合约吗?

让我们考虑以下用例,其中用户A和用户B使用与区块链系统和DRM系统接口的交易系统。如果在区块链系统上交易成功,则DRM系统授权用户B使用媒体项目。

相关的工作流程如下:

-

用户A编写CEL合同和REL许可证,然后将两者发送给用户B

-

用户B将CEL和REL发送到交易系统

-

交易系统将CEL转换为智能合约,创建代币并将两者发送到区块链系统

-

区块链系统执行智能合约,记录交易并通知交易系统结果

-

如果通知为positive,则区块链系统会将REL转换为本地DRM许可证并通知用户A

-

用户A将媒体项目发送给用户B

-

用户B请求DRM系统使用媒体项目

-

DRM系统授权用户B

在这个用例中,用户A和用户B可以使用标准的CEL和REL语言进行通信,而交易系统的任务是与区块链系统和DRM系统接口。

这样一个将MPEG-21合约转换为智能合约的标准方法,它可给用户以确保:由区块链执行的智能合约对应于人类可读的MPEG-21合约。

有兴趣探索此主题的人员可以通过https://lists.aau.at/mailman/listinfo/smart-contracts订阅MPEG-21合同到智能合同特别小组, 并通过[email protected]参与讨论。

-

机床数据的探索

机械系统在功能方面以及在生成数据的能力方面变得越来越复杂。维珍航空表示,波音787飞机每次飞行能够生成0.5TB的数据。飞机产生的数据的多样性使这个问题颇具挑战性,相比而言机床不是那么复杂的机器,但是每年仍能产生1TB的数据。数据在性质上并不统一,可以分为3个方面:质量控制、管理和监控。

有机床数据可以用来测试也就意味着可以对机床数据进行处理。

-

其他数据

MPEG致力于压缩两个完全非媒体数据:基因组网络和神经网络,尽管后者目前被视为针对多媒体内容描述和分析的压缩附属功能。MPEG还正在探索压缩机床数据。

-

十二、MPEG工作计划

该图以图形方式说明了当前的MPEG工作计划。灰色的进度条还不是确定的工作计划。