- bert中 [CLS] 和 [SEP] 表示什么意思?

[CLS]和[SEP]是BERT中的两个特殊标记符号,在BERT的输入文本中起到特殊的作用。[CLS]是"classification"的缩写,在文本分类任务中,它通常表示句子或文档的开头。在BERT中,[CLS]对应着输入文本中第一个词的词向量,输出层中的第一个神经元通常会被用来预测文本的类别。[SEP]是"separator"的缩写,它通常表示句子或文档的结尾。在BERT中,[SEP]对应着输

- 踏入真实:具身智能与物理世界的认知交响

当大型语言模型在文本的海洋中纵横捭阖,生成式AI在数字画布上挥洒创意时,人工智能仍有一个根本性的疆域尚未完全征服——真实的三维物理世界。理解一个苹果,不能仅靠词向量坐标;学会行走,无法通过阅读说明书达成;在拥挤的街道导航,远非处理符号逻辑那般简单。智能的进化,自生命诞生之初,便与具身性(Embodiment)和环境交互(Interaction)密不可分。我们的认知、学习、乃至意识的雏形,都源于身体

- 解释LLM怎么预测下一个词语的

ZhangJiQun&MXP

教学2024大模型以及算力2021AIpython语言模型python深度学习人工智能机器学习

解释LLM怎么预测下一个词语的通过上文词的向量进行映射在Transformer架构的大语言模型(如GPT系列、BERT等)中,词语会先被转化为词向量。在预测下一个词时,模型会基于之前所有词的向量表示(并非仅仅上一个词,但上一个词的向量是重要信息来源之一)进行计算。以GPT-2为例,在生成文本时,它会将输入文本中每个词对应的词向量依次输入到模型的多层Transformer编码器-解码器结构中。每一层

- Prompt Engineering终极手册:构建高效AI提示词库的完整技术路线

LCG元

大模型prompt人工智能

目录一、提示词库构建核心架构二、关键技术实现步骤1.数据采集与清洗2.提示词向量化编码3.聚类分析与分类存储三、API服务化部署四、性能优化方案五、监控与持续优化六、应用效果展示本文将深入探讨构建企业级AI提示词库的完整技术方案,含数据处理、模型训练、部署监控全流程代码实现在AI应用爆炸式增长的今天,提示词质量直接决定模型输出效果。本文将手把手教你构建企业级提示词库,涵盖以下核心技术环节:一、提示

- Word2Vec 原理是什么

ZhangJiQun&MXP

教学2024大模型以及算力2021AIpythonword2vec人工智能自然语言处理

Word2Vec原理是什么一、核心概念:从词语到向量的语义映射Word2Vec是2013年由Google提出的词嵌入(WordEmbedding)模型,其核心目标是将自然语言中的词语转换为稠密的连续向量(词向量),使向量空间中的距离能反映词语的语义相关性。本质:通过神经网络学习词语的分布式表示(DistributedRepresentation),打破传统one-hot编码“维度高、无语义关联”的

- 【AI大模型】数据处理

用心分享技术

AI大模型人工智能oracle数据库

一、源文档读取为构建我们的本地知识库,我们需要对以多种类型存储的本地文档进行处理,读取本地文档并通过前文描述的Embedding方法将本地文档的内容转化为词向量来构建向量数据库。在本节中,我们以一些实际示例入手,来讲解如何对本地文档进行处理。二、数据读取1.PDF文档我们可以使用LangChain的PyMuPDFLoader来读取知识库的PDF文件。PyMuPDFLoader是PDF解析器中速度最

- 怎么对词编码进行可视化:Embedding Projector

ZhangJiQun&MXP

教学2024大模型以及算力2021AIpythonembedding

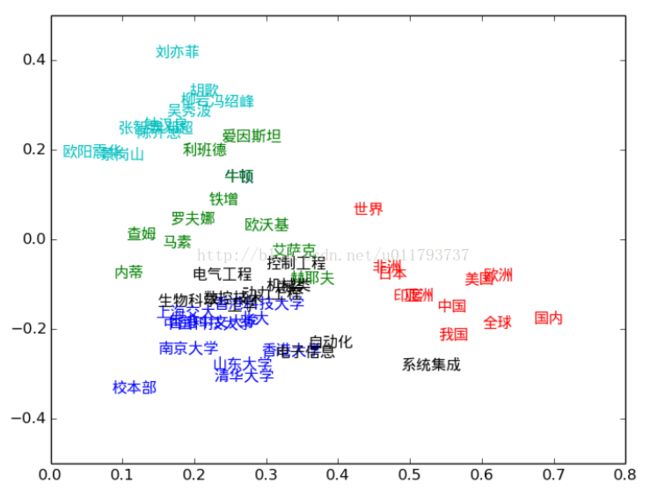

怎么对词编码进行可视化:EmbeddingProjectorhttps://projector.tensorflow.org/EmbeddingProjector是用于可视化高维向量嵌入(如词向量、图像特征向量等)的工具,能帮你理解向量间的关系,下面以词向量分析和**简单自定义数据(比如特征向量)**为例,教你怎么用:一、词向量分析场景(以图中Word2Vec数据为例)1.加载数据与基础查看图里已

- 6月19日复盘

四万二千

人工智能transformer

6月19日复盘二、分词与词向量分词和词向量是NLP的基础技术。1.分词分词是将连续的文本分割成独立的词汇单元(tokens)的过程。这些单元可以是单词、符号或子词。1.1中文特性中文句子由连续的汉字组成,没有明显的词边界:词与词之间没有分隔符英文:Ilovenaturallanguageprocessing.中文:我喜欢自然语言处理。词是最基本的语义单元。为了处理文本信息,须将连续的序列分割成有意

- 从代码学习深度学习 - 词的相似性和类比任务 PyTorch版

飞雪白鹿€

#自然语言处理深度学习pytorch

提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档文章目录前言加载预训练词向量TokenEmbedding类详解预训练词向量简介(GloVe)具体含义总结建议应用预训练词向量词相似度knn函数get_similar_tokens函数相似词查找示例词类比get_analogy函数词类比任务示例总结前言词向量(WordEmbeddings)是自然语言处理(NLP)中的基石之一。它们是将词

- 多模态核心实现技术

charles666666

自然语言处理神经网络人工智能机器学习语言模型

一、模态表示(ModalRepresentation)模态表示是将不同模态数据(文本、图像、音频等)编码为计算机可处理的向量形式的核心步骤。1.单模态编码技术文本表示:采用词嵌入模型(如Word2Vec、GloVe)或预训练语言模型(如BERT、RoBERTa),通过Transformer层提取上下文特征,生成动态词向量。高阶表示:通过句向量模型(如Sentence-BERT)将整段文本映射为固定

- Python自然语言处理库之gensim使用详解

Rocky006

python开发语言

概要Gensim是一个专门用于无监督主题建模和自然语言处理的Python开源库,由捷克共和国的RadimŘehůřek开发。该库专注于处理大规模文本数据,提供了多种经典的主题建模算法,如LDA(潜在狄利克雷分配)、LSI(潜在语义索引)等,以及现代化的词向量模型Word2Vec、Doc2Vec、FastText等。Gensim的设计理念是"为人类而非机器",强调易用性和可扩展性,特别适合处理无标签

- 深度学习中的负采样

洪小帅

深度学习人工智能

深度学习中的负采样负采样(NegativeSampling)是一种在训练大型分类或概率模型(尤其是在输出类别很多时)中,用来加速训练、降低计算量的方法。它常用于:词向量训练(如Word2Vec)推荐系统(从大量候选项中学正例与负例)语言模型、对比学习、信息检索等场景本质概念在许多任务中,我们的模型要从上万个候选中预测正确类别。例如:给定单词“cat”,预测它上下文中出现的词(如Word2Vec的S

- NLP资源汇总和工具汇总

AI拉呱

机器学习深度学习实例讲解与分析

NLP资源汇总和工具汇总涉及内容包括:中英文敏感词、语言检测、中外手机/电话归属地/运营商查询、名字推断性别、手机号抽取、身份证抽取、邮箱抽取、中日文人名库、中文缩写库、拆字词典、词汇情感值、停用词、反动词表、暴恐词表、繁简体转换、英文模拟中文发音、汪峰歌词生成器、职业名称词库、同义词库、反义词库、否定词库、汽车品牌词库、汽车零件词库、连续英文切割、各种中文词向量、公司名字大全、古诗词库、IT词库

- LLM的工作原理详解

我就是全世界

大模型技术与应用人工智能

文章目录1.LLM的核心概念1.1什么是token?1.2tokenization过程1.3embedding层的作用1.3.1词嵌入1.3.2嵌入矩阵1.4位置编码的重要性1.4.1位置编码的作用1.4.2位置编码的实现1.5词向量的表示1.5.1One-Hot编码1.5.2分布式表示1.6Transformer架构1.6.1自注意力机制1.6.2前馈神经网络1.6.3Transformer的层

- NLP学习路线图(十八):Word2Vec (CBOW & Skip-gram)

摸鱼许可证

NLP学习路线图nlp学习自然语言处理

自然语言处理(NLP)的核心挑战在于让机器“理解”人类语言。传统方法依赖独热编码(One-hotEncoding)表示单词,但它存在严重缺陷:每个单词被视为孤立的符号,无法捕捉词义关联(如“国王”与“王后”的关系),且维度灾难使计算效率低下。词向量(WordEmbedding)革命性地解决了这些问题。它将单词映射为稠密、低维的实数向量(如50-300维),其核心思想是:具有相似上下文(Contex

- 共现矩阵的SVD降维与低维词向量计算详解

幽·

NLP与机器学习矩阵线性代数

共现矩阵的SVD降维与低维词向量计算详解1.原始共现矩阵构建根据用户提供的共现对:句子1:(I,like),(like,apples)句子2:(I,like),(like,bananas)词汇表:[I,like,apples,bananas]窗口大小=2(假设共现对直接作为矩阵的非零元素),共现矩阵(M)如下(忽略单词自身的共现,即对角线为0):IlikeapplesbananasI0200lik

- Python自然语言处理:gensim库的探索与应用

丶本心灬

本文还有配套的精品资源,点击获取简介:本文档介绍了gensim库——一个专为Python设计的开源自然语言处理工具,它支持词向量模型、主题模型、相似度计算、TF-IDF和LSA等核心功能。该库适用于文档相似性和主题建模任务,特别强调其在处理大规模语料库中的高效性和准确性。包含gensim-4.0.0版本的预编译安装包,为64位Windows系统上的Python3.6版本提供便捷安装体验。文档还提供

- 自然语言处理核心技术:词向量(Word Embedding)解析

扉间798

python

自然语言处理核心技术:词向量(WordEmbedding)全面解析在自然语言处理(NLP)领域,如何让计算机理解人类语言的语义一直是核心挑战。词向量(WordVector),又称词嵌入(WordEmbedding),通过将词语映射到连续的实数向量空间,为机器理解语言开辟了新路径。本文将从原理、发展历程、主流模型及应用场景等方面,深入解析这一关键技术。一、词向量:让语言可计算的“桥梁”词向量的核心目

- 从 Word2Vec 到 BERT:AI 不止是词向量,更是语言理解

ox180x

程序员转战大模型人工智能word2vecbert

一、前言在上篇文章中,我们介绍了Word2Vec以及它的作用,总的来说:Word2Vec是我们理解NLP的第一站Word2Vec将词变成了“向量”——终于可以用机器理解词语的相似度我们获得了例如“国王-男人+女人≈女王”的类比能力我们可以将Word2Vec这种算法能力,应用到各种创新场景,例如基于Graph的推荐系统,后续如果小伙伴有需要,可以一起深入交流。但同时也指出了它的不足:一个词=一个固定

- 使用 PyTorch 实现 CBOW 词向量模型

进来有惊喜

python

在自然语言处理(NLP)领域,词向量表示是一项基础而关键的技术。通过将文本中的词语映射到低维向量空间,我们可以让计算机更好地理解和处理人类语言。今天,我们将深入探讨并实现CBOW(ContinuousBag-of-Words)模型,这是一种经典的词向量训练方法。什么是CBOW模型?CBOW模型是一种基于上下文预测目标词的神经网络模型,由Mikolov等人在2013年提出。与Skip-gram模型相

- 用 Gensim 实现 Word2Vec 古诗生成

万能小贤哥

word2vec人工智能自然语言处理

向量操作。我们将借助它完成从语料处理到古诗生成的全流程。6.1环境搭建与库导入首先安装Gensim及依赖库:bashpipinstallgensimnumpypandas导入必要模块:python运行fromgensim.modelsimportWord2Vec#核心词向量模型fromrandomimportchoice#随机选择字符fromos.pathimportexists#检查文件存在fr

- 图解gpt之神经概率语言模型与循环神经网络

zhaojiew10

gpt语言模型rnn

上节课我们聊了词向量表示,像Word2Vec这样的模型,它确实能捕捉到词语之间的语义关系,但问题在于,它本质上还是在孤立地看待每个词。英文的“Apple”,可以指苹果公司,也可以指水果。这种一词多义的特性,以及词语在上下文中的微妙变化,Word2Vec这种固定向量的表示方式就捉襟见肘了。而且,它还不能处理新词,一旦遇到词表里没有的词,就束手无策。所以,尽管有了词向量,NLP领域在很长一段时间内,也

- 【Transformer】解密Transformer核心模块可训练参数

小波才露尖尖角

transformer深度学习人工智能

在Transformer模型中,所有可训练(trainable)的模块构成了其核心架构,每个模块都有其特定的功能和意义,并且都包含可通过反向传播进行优化的参数。下面是对各个模块的详细阐述:1.词嵌入层(EmbeddingLayer)功能/意义:将输入的离散token(如单词或子词)映射为连续的向量表示(词向量),便于模型进行数值运算。使得模型能够捕捉词汇之间的语义和语法相似性。可训练参数:一个形状

- 19、RAG的原理及代码实战(2)pipeline介绍

Andy_shenzl

大模型学习embeddingRAGgraphRAG

1、整体流程根据前文介绍,整体的RAG流程如下2、embeddingembedding是指使用嵌入模型将切分后的文本块转换为向量表示。这些向量能够在高维空间中表示文本的语义信息。2.1openaiembedding目前最好的embedding模型是openai的text-embedding-3-large,使用前需要先注册openai账号,申请一个APIkey。主要的词向量有以下三个:模型名称每美

- 从零开始大模型开发与微调:词向量训练模型Word2Vec使用介绍

AI大模型应用实战

javapythonjavascriptkotlingolang架构人工智能

从零开始大模型开发与微调:词向量训练模型Word2Vec使用介绍关键词:词向量,Word2Vec,神经网络,深度学习,自然语言处理(NLP),预训练,微调,Fine-Tuning1.背景介绍1.1问题由来在深度学习蓬勃发展的今天,人工智能技术在自然语言处理(NLP)、计算机视觉、语音识别等领域取得了长足的进步。然而,语言和文本数据由于其高维度和非结构化特性,使得深度学习模型的训练和应用面临诸多挑战

- LSTM的简单模型

D11PMINDER

deeplearninglstm人工智能rnn

好的,我来用通俗易懂的语言解释一下这个LSTMTagger类是如何工作的。1️⃣类的目的这个LSTMTagger类是一个用于自然语言处理(NLP)任务的模型,目的是标注输入的句子,通常用于词性标注(例如,标注每个词是名词、动词、形容词等)。它的核心是一个LSTM(长短时记忆网络),这是一种可以处理序列数据的神经网络。2️⃣模型的组成部分1.word_embeddings(词向量嵌入)self.wo

- 深度学习Day-41:使用Word2vec实现文本分类

Point__Nemo

深度学习分类pytorch

本文为:[365天深度学习训练营]中的学习记录博客原作者:[K同学啊|接辅导、项目定制]任务:本次将加入Word2vec使用PyTorch实现中文文本分类,Word2Vec则是其中的一种词嵌入方法,是一种用于生成词向量的浅层神经网络模型,由TomasMikolov及其团队于2013年提出。Word2Vec通过学习大量文本数据,将每个单词表示为一个连续的向量,这些向量可以捕捉单词之间的语义和句法关系

- Datawhale AI春训营--蛋白质预测(AI+生命科学)

2 0 1 2

人工智能机器学习

基础解题方案方法1:词向量+机器学习步骤1:训练词向量使用gensim库的Word2Vec模型对氨基酸序列进行词向量训练。将每个蛋白质序列转换为由空格分隔的字符串(’'.join(x[“sequence”])),形成句子列表。vector_size=100:词向量的维度为100。min_count=1:至少出现一次的单词才会被考虑。训练完成后,model_w2v包含了每个氨基酸的词向量表示。dat

- 词向量激活阿拉伯语知识 —— 打造本地化智能知识库的创新架构

海棠AI实验室

“智理探索“-深入AI理论与学术创新自然语言处理人工智能

目录引言:赋能阿拉伯语人才的“知识向量化”革命阿拉伯语NLP困境:为什么传统检索不适用?词向量与知识库融合:原理与创新架构解析阿拉伯语知识库构建全流程详解(附代码与解读)架构解剖:检索增强生成(RAG)系统剖析(Mermaid架构图)案例演示:“智能学伴”助力阿拉伯语“因材施教”展望与思考:本地化NLP变革的未来引言:赋能阿拉伯语人才的“知识向量化”革命在全球语言智能化浪潮中,阿拉伯语因其书写复杂

- 【动手学大模型开发】搭建知识库 - 文档处理

青松ᵃⁱ

动手学大模型开发人工智能大模型开发

嗨,我是青松,很高兴遇到你!希望用我的经验,让每个人的AI学习之路走的更容易些~专栏:大模型(LLMs)高频面题全面整理(★2025最新版★)|动手学大模型开发目录一、源文档选取二、数据读取1.PDF文档2.MD文档三、数据清洗四、文档分割为构建我们的本地知识库,我们需要对以多种类型存储的本地文档进行处理,读取本地文档并通过前文描述的Embedding方法将本地文档的内容转化为词向量来构建向量数据

- 统一思想认识

永夜-极光

思想

1.统一思想认识的基础,才能有的放矢

原因:

总有一种描述事物的方式最贴近本质,最容易让人理解.

如何让教育更轻松,在于找到最适合学生的方式.

难点在于,如何模拟对方的思维基础选择合适的方式. &

- Joda Time使用笔记

bylijinnan

javajoda time

Joda Time的介绍可以参考这篇文章:

http://www.ibm.com/developerworks/cn/java/j-jodatime.html

工作中也常常用到Joda Time,为了避免每次使用都查API,记录一下常用的用法:

/**

* DateTime变化(增减)

*/

@Tes

- FileUtils API

eksliang

FileUtilsFileUtils API

转载请出自出处:http://eksliang.iteye.com/blog/2217374 一、概述

这是一个Java操作文件的常用库,是Apache对java的IO包的封装,这里面有两个非常核心的类FilenameUtils跟FileUtils,其中FilenameUtils是对文件名操作的封装;FileUtils是文件封装,开发中对文件的操作,几乎都可以在这个框架里面找到。 非常的好用。

- 各种新兴技术

不懂事的小屁孩

技术

1:gradle Gradle 是以 Groovy 语言为基础,面向Java应用为主。基于DSL(领域特定语言)语法的自动化构建工具。

现在构建系统常用到maven工具,现在有更容易上手的gradle,

搭建java环境:

http://www.ibm.com/developerworks/cn/opensource/os-cn-gradle/

搭建android环境:

http://m

- tomcat6的https双向认证

酷的飞上天空

tomcat6

1.生成服务器端证书

keytool -genkey -keyalg RSA -dname "cn=localhost,ou=sango,o=none,l=china,st=beijing,c=cn" -alias server -keypass password -keystore server.jks -storepass password -validity 36

- 托管虚拟桌面市场势不可挡

蓝儿唯美

用户还需要冗余的数据中心,dinCloud的高级副总裁兼首席营销官Ali Din指出。该公司转售一个MSP可以让用户登录并管理和提供服务的用于DaaS的云自动化控制台,提供服务或者MSP也可以自己来控制。

在某些情况下,MSP会在dinCloud的云服务上进行服务分层,如监控和补丁管理。

MSP的利润空间将根据其参与的程度而有所不同,Din说。

“我们有一些合作伙伴负责将我们推荐给客户作为个

- spring学习——xml文件的配置

a-john

spring

在Spring的学习中,对于其xml文件的配置是必不可少的。在Spring的多种装配Bean的方式中,采用XML配置也是最常见的。以下是一个简单的XML配置文件:

<?xml version="1.0" encoding="UTF-8"?>

<beans xmlns="http://www.springframework.or

- HDU 4342 History repeat itself 模拟

aijuans

模拟

来源:http://acm.hdu.edu.cn/showproblem.php?pid=4342

题意:首先让求第几个非平方数,然后求从1到该数之间的每个sqrt(i)的下取整的和。

思路:一个简单的模拟题目,但是由于数据范围大,需要用__int64。我们可以首先把平方数筛选出来,假如让求第n个非平方数的话,看n前面有多少个平方数,假设有x个,则第n个非平方数就是n+x。注意两种特殊情况,即

- java中最常用jar包的用途

asia007

java

java中最常用jar包的用途

jar包用途axis.jarSOAP引擎包commons-discovery-0.2.jar用来发现、查找和实现可插入式接口,提供一些一般类实例化、单件的生命周期管理的常用方法.jaxrpc.jarAxis运行所需要的组件包saaj.jar创建到端点的点到点连接的方法、创建并处理SOAP消息和附件的方法,以及接收和处理SOAP错误的方法. w

- ajax获取Struts框架中的json编码异常和Struts中的主控制器异常的解决办法

百合不是茶

jsjson编码返回异常

一:ajax获取自定义Struts框架中的json编码 出现以下 问题:

1,强制flush输出 json编码打印在首页

2, 不强制flush js会解析json 打印出来的是错误的jsp页面 却没有跳转到错误页面

3, ajax中的dataType的json 改为text 会

- JUnit使用的设计模式

bijian1013

java设计模式JUnit

JUnit源代码涉及使用了大量设计模式

1、模板方法模式(Template Method)

定义一个操作中的算法骨架,而将一些步骤延伸到子类中去,使得子类可以不改变一个算法的结构,即可重新定义该算法的某些特定步骤。这里需要复用的是算法的结构,也就是步骤,而步骤的实现可以在子类中完成。

- Linux常用命令(摘录)

sunjing

crondchkconfig

chkconfig --list 查看linux所有服务

chkconfig --add servicename 添加linux服务

netstat -apn | grep 8080 查看端口占用

env 查看所有环境变量

echo $JAVA_HOME 查看JAVA_HOME环境变量

安装编译器

yum install -y gcc

- 【Hadoop一】Hadoop伪集群环境搭建

bit1129

hadoop

结合网上多份文档,不断反复的修正hadoop启动和运行过程中出现的问题,终于把Hadoop2.5.2伪分布式安装起来,跑通了wordcount例子。Hadoop的安装复杂性的体现之一是,Hadoop的安装文档非常多,但是能一个文档走下来的少之又少,尤其是Hadoop不同版本的配置差异非常的大。Hadoop2.5.2于前两天发布,但是它的配置跟2.5.0,2.5.1没有分别。 &nb

- Anychart图表系列五之事件监听

白糖_

chart

创建图表事件监听非常简单:首先是通过addEventListener('监听类型',js监听方法)添加事件监听,然后在js监听方法中定义具体监听逻辑。

以钻取操作为例,当用户点击图表某一个point的时候弹出point的name和value,代码如下:

<script>

//创建AnyChart

var chart = new AnyChart();

//添加钻取操作&quo

- Web前端相关段子

braveCS

web前端

Web标准:结构、样式和行为分离

使用语义化标签

0)标签的语义:使用有良好语义的标签,能够很好地实现自我解释,方便搜索引擎理解网页结构,抓取重要内容。去样式后也会根据浏览器的默认样式很好的组织网页内容,具有很好的可读性,从而实现对特殊终端的兼容。

1)div和span是没有语义的:只是分别用作块级元素和行内元素的区域分隔符。当页面内标签无法满足设计需求时,才会适当添加div

- 编程之美-24点游戏

bylijinnan

编程之美

import java.util.ArrayList;

import java.util.Arrays;

import java.util.HashSet;

import java.util.List;

import java.util.Random;

import java.util.Set;

public class PointGame {

/**编程之美

- 主页面子页面传值总结

chengxuyuancsdn

总结

1、showModalDialog

returnValue是javascript中html的window对象的属性,目的是返回窗口值,当用window.showModalDialog函数打开一个IE的模式窗口时,用于返回窗口的值

主界面

var sonValue=window.showModalDialog("son.jsp");

子界面

window.retu

- [网络与经济]互联网+的含义

comsci

互联网+

互联网+后面是一个人的名字 = 网络控制系统

互联网+你的名字 = 网络个人数据库

每日提示:如果人觉得不舒服,千万不要外出到处走动,就呆在床上,玩玩手游,更不能够去开车,现在交通状况不

- oracle 创建视图 with check option

daizj

视图vieworalce

我们来看下面的例子:

create or replace view testview

as

select empno,ename from emp where ename like ‘M%’

with check option;

这里我们创建了一个视图,并使用了with check option来限制了视图。 然后我们来看一下视图包含的结果:

select * from testv

- ToastPlugin插件在cordova3.3下使用

dibov

Cordova

自己开发的Todos应用,想实现“

再按一次返回键退出程序 ”的功能,采用网上的ToastPlugins插件,发现代码或文章基本都是老版本,运行问题比较多。折腾了好久才弄好。下面吧基于cordova3.3下的ToastPlugins相关代码共享。

ToastPlugin.java

package&nbs

- C语言22个系统函数

dcj3sjt126com

cfunction

C语言系统函数一、数学函数下列函数存放在math.h头文件中Double floor(double num) 求出不大于num的最大数。Double fmod(x, y) 求整数x/y的余数。Double frexp(num, exp); double num; int *exp; 将num分为数字部分(尾数)x和 以2位的指数部分n,即num=x*2n,指数n存放在exp指向的变量中,返回x。D

- 开发一个类的流程

dcj3sjt126com

开发

本人近日根据自己的开发经验总结了一个类的开发流程。这个流程适用于单独开发的构件,并不适用于对一个项目中的系统对象开发。开发出的类可以存入私人类库,供以后复用。

以下是开发流程:

1. 明确类的功能,抽象出类的大概结构

2. 初步设想类的接口

3. 类名设计(驼峰式命名)

4. 属性设置(权限设置)

判断某些变量是否有必要作为成员属

- java 并发

shuizhaosi888

java 并发

能够写出高伸缩性的并发是一门艺术

在JAVA SE5中新增了3个包

java.util.concurrent

java.util.concurrent.atomic

java.util.concurrent.locks

在java的内存模型中,类的实例字段、静态字段和构成数组的对象元素都会被多个线程所共享,局部变量与方法参数都是线程私有的,不会被共享。

- Spring Security(11)——匿名认证

234390216

Spring SecurityROLE_ANNOYMOUS匿名

匿名认证

目录

1.1 配置

1.2 AuthenticationTrustResolver

对于匿名访问的用户,Spring Security支持为其建立一个匿名的AnonymousAuthenticat

- NODEJS项目实践0.2[ express,ajax通信...]

逐行分析JS源代码

Ajaxnodejsexpress

一、前言

通过上节学习,我们已经 ubuntu系统搭建了一个可以访问的nodejs系统,并做了nginx转发。本节原要做web端服务 及 mongodb的存取,但写着写着,web端就

- 在Struts2 的Action中怎样获取表单提交上来的多个checkbox的值

lhbthanks

javahtmlstrutscheckbox

第一种方法:获取结果String类型

在 Action 中获得的是一个 String 型数据,每一个被选中的 checkbox 的 value 被拼接在一起,每个值之间以逗号隔开(,)。

所以在 Action 中定义一个跟 checkbox 的 name 同名的属性来接收这些被选中的 checkbox 的 value 即可。

以下是实现的代码:

前台 HTML 代码:

- 003.Kafka基本概念

nweiren

hadoopkafka

Kafka基本概念:Topic、Partition、Message、Producer、Broker、Consumer。 Topic: 消息源(Message)的分类。 Partition: Topic物理上的分组,一

- Linux环境下安装JDK

roadrunners

jdklinux

1、准备工作

创建JDK的安装目录:

mkdir -p /usr/java/

下载JDK,找到适合自己系统的JDK版本进行下载:

http://www.oracle.com/technetwork/java/javase/downloads/index.html

把JDK安装包下载到/usr/java/目录,然后进行解压:

tar -zxvf jre-7

- Linux忘记root密码的解决思路

tomcat_oracle

linux

1:使用同版本的linux启动系统,chroot到忘记密码的根分区passwd改密码 2:grub启动菜单中加入init=/bin/bash进入系统,不过这时挂载的是只读分区。根据系统的分区情况进一步判断. 3: grub启动菜单中加入 single以单用户进入系统. 4:用以上方法mount到根分区把/etc/passwd中的root密码去除 例如: ro

- 跨浏览器 HTML5 postMessage 方法以及 message 事件模拟实现

xueyou

jsonpjquery框架UIhtml5

postMessage 是 HTML5 新方法,它可以实现跨域窗口之间通讯。到目前为止,只有 IE8+, Firefox 3, Opera 9, Chrome 3和 Safari 4 支持,而本篇文章主要讲述 postMessage 方法与 message 事件跨浏览器实现。postMessage 方法 JSONP 技术不一样,前者是前端擅长跨域文档数据即时通讯,后者擅长针对跨域服务端数据通讯,p