机器学习笔记——统计学习方法概论(一)

机器学习

什么是机器学习?

机器学习是近20多年兴起的一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。机器学习理论主要是设计和分析一些让计算机可以自动“学习”的算法。机器学习算法是一类从数据中自动分析获得规律,并利用规律对未知数据进行预测的算法。因为学习算法中涉及了大量的统计学理论,机器学习与统计推断学联系尤为密切,也被称为统计学习理论。算法设计方面,机器学习理论关注可以实现的,行之有效的学习算法。很多推论问题属于无程序可循难度,所以部分的机器学习研究是开发容易处理的近似算法。

机器学习的定义?

机器学习有下面几种定义:

- “机器学习是一门人工智能的科学,该领域的主要研究对象是人工智能,特别是如何在经验学习中改善具体算法的性能”。

- “机器学习是对能通过经验自动改进的计算机算法的研究”。

- “机器学习是用数据或以往的经验,以此优化计算机程序的性能标准。”

- 英文定义:A computer program is said to learn from experience E with respect to some class of tasks T and performance measure P, if its performance at tasks in T, as measured by P, improves with experience E.

机器学习应用

- 数据挖掘

- 计算机视觉

- 自然语言处理

- 生物特征识别

- 搜索引擎

- 医学诊断

- 检测信用卡欺诈

- 证券市场分析

- DNA序列测序

- 语音和手写识别

- 战略游戏

- 机器人

机器学习的发展历程

- “黑暗时代”,人工智能的诞生(1943年~1956年)

- 新的方向:

- 集成学习

- 可扩展机器学习(对大数据集、高维数据的学习等)

- 强化学习

- 迁移学习

- 概率网络

- 深度学习

- 国内外的研究者

- M. I. Jordan

- Andrew Ng

- Tommi Jaakkola

- David Blei

- Eric Xing。。。

- D.Koller

- 2001年IJCAI计算机与思维奖:Terry Winograd、David Marr、Tom Mitchell、Rodney Brooks等人之后的第18位获奖者

- Peter L. Bartlett

- J. D. Lafferty

- 国内:李航,周志华, 杨强,王晓刚,唐晓鸥,唐杰,刘铁岩,何晓飞,朱筠,吴军,

张栋,戴文渊,余凯,邓力,孙健

- M. I. Jordan

机器学习和数据挖掘的关系

- 机器学习是数据挖掘的重要工具。

- 数据挖掘不仅仅要研究、拓展、应用一些机器学习方法,还要通过许多非机器学习技术解决数据仓储、大规模数据、数据噪音等等更为实际的问题。

- 数据挖掘的涉及面更宽,常用在数据挖掘上的方法通常只是“从数据学习”,然则机器学习不仅仅可以用在数据挖掘上,一些机器学习的子领域甚至与数据挖掘关系不大,例如增强学习与自动控制等等。

- 数据挖掘试图从海量数据中找出有用的知识。

- 大体上看,数据挖掘可以视为机器学习和数据库的交叉,它主要利用机器学习界提供的技术来分析海量数据,利用数据库界提供的技术来管理海量数据。

为什么要研究大数据机器学习?

- 例“尿布→啤酒”关联规则

- 实际上,在面对少量数据时关联分析并不难,可以直接使用统计学中有关相关性的知识,这也正是机器学习界没有研究关联分析的一个重要原因。

- 关联分析的困难其实完全是由海量数据造成的,因为数据量的增加会直接造成挖掘效率的下降,当数据量增加到一定程度,问题的难度就会产生质变,

- 例如,在关联分析中必须考虑因数据太大而无法承受多次扫描数据库的开销、可能产生在存储和计算上都无法接受的大量中间结果等。

机器学习相关学术期刊和会议

- 机器学习

- 学术会议:NIPS、ICML、ECML和COLT,

- 学术期刊:《Machine Learning》和《Journal of Machine Learning Research》

- 数据挖掘

- 学术会议:SIGKDD、ICDM、SDM、PKDD和PAKDD

- 学术期刊:《Data Mining and Knowledge Discovery》和《IEEE Transactions on Knowledge and Data Engineering》

- 人工智能

- 学术会议:IJCAI和AAAI、

- 数据库

- 学术会议:SIGMOD、VLDB、ICDE,

- 其它一些顶级期刊如

- 《Artificial Intelligence》、

- 《Journal of Artificial Intelligence Research》、

- 《IEEE Transactions on Pattern Analysis and Machine Intelligence》、

- 《Neural Computation》等也经常发表机器学习和数据挖掘方面的论文

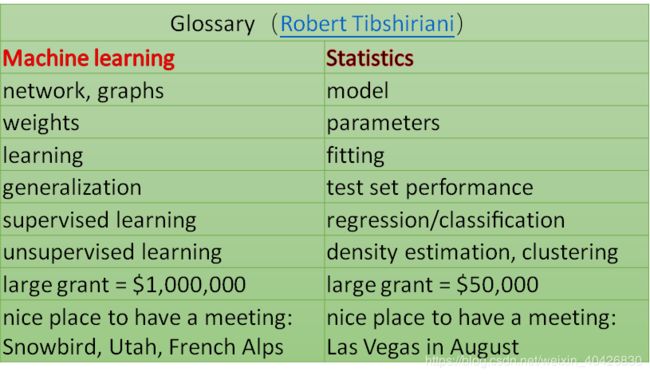

机器学习和统计学习

维基百科:

机器学习是近20多年兴起的一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。机器学习理论主要是设计和分析一些让计算机可以自动“学习”的算法。

机器学习算法是一类从数据中自动分析获得规律,并利用规律对未知数据进行预测的算法。因为学习算法中涉及了大量的统计学理论,机器学习与统计推断学联系尤为密切,也被称为统计学习理论。算法设计方面,机器学习理论关注可以实现的,行之有效的学习算法。很多推论问题属于无程序可循难度,所以部分的机器学习研究是开发容易处理的近似算法。

- Brendan O’Connor的博文Statistics vs. Machine Learning, fight!,初稿是08年写的,或许和作者的机器学习背景有关,他在初稿中主要是贬低了统计学,思想和有点类似,认为机器学习比统计学多了些Algorithm Modeling方面内容,比如SVM的Max-margin,决策树等,此外他认为机器学习更偏实际。但09年十月的时候他转而放弃自己原来的观点,认为统计才是real deal: Statistics, not machine learning, is the real deal, but unfortunately suffers from bad marketing.

- 研究方法差异

- 统计学研究形式化和推导

- 机器学习更容忍一些新方法

- 维度差异

- 统计学强调低维空间问题的统计推导(confidence intervals, hypothesis tests, optimal estimators)

- 机器学习强调高维预测问题

- 统计学和机器学习各自更关心的领域:

- 统计学: survival analysis, spatial analysis, multiple testing, minimax theory, deconvolution, semiparametric inference, bootstrapping, time series.

- 机器学习: online learning, semisupervised learning, manifold learning, active learning, boosting.

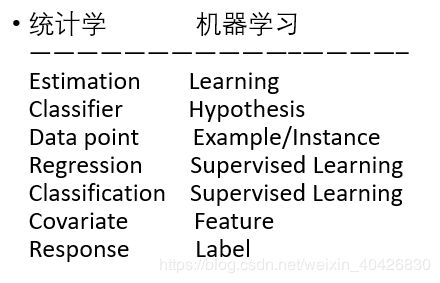

统计学习和机器学习(专业术语)

统计学习

-

统计学习的对象

- data :计算机及互联网上的各种数字、文字、图像、视频、音频数据以及它们的组合。

- 数据的基本假设是同类数据具有一定的统计规律性。

-

统计学习的目的

- 用于对数据(特别是未知数据)进行预测和分析。

-

统计学习的方法

- 分类:

- Supervised learning

- Unsupervised learning

- Semi-supervised learning

- Reinforcement learning

- 监督学习:

- 训练数据 training data

- 模型 model ------- 假设空间 hypothesis

- 评价准则 evaluation criterion -------- 策略 strategy

- 算法 algorithm

- 分类:

-

统计学习的研究:

- 统计学习方法

- 统计学习理论(统计学习方法的有效性和效率和基本理论)

- 统计学习应用

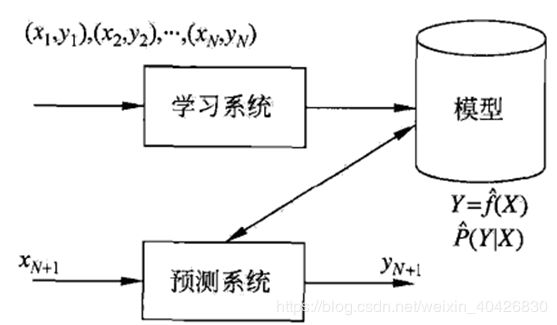

监督学习

- Instance,feature vector,feature space

- 输入实例x的特征向量:

x = ( x ( 1 ) , x ( 2 ) , . . . , x ( i ) , . . . , x ( n ) ) T x = (x^{(1)},x^{(2)},...,x^{(i)},...,x^{(n)})^T x=(x(1),x(2),...,x(i),...,x(n))T - x ( i ) x^{(i)} x(i) 与 x i x_{i} xi 不同,后者表示多个输入变量中的第i个

x i = ( x i ( 1 ) , x i ( 2 ) , . . . , x i ( i ) , . . . , x i ( n ) ) T x_{i} = (x_{i}^{(1)},x_{i}^{(2)},...,x_{i}^{(i)},...,x_{i}^{(n)})^T xi=(xi(1),xi(2),...,xi(i),...,xi(n))T - 训练集:

T = { ( x 1 , y 1 ) , ( x 2 , y 2 ) , . . . , ( x N , y N ) } T = \{{(x_{1},y_{1}),(x_{2},y_{2}),...,(x_{N},y_{N})}\} T={(x1,y1),(x2,y2),...,(xN,yN)} - 输入变量和输出变量:

- 分类问题、回归问题、标注问题

联合概率分布

- 假设输入与输出的随机变量X和Y遵循联合概率分布P(X,Y)

- P(X,Y)为分布函数或分布密度函数

- 对于学习系统来说,联合概率分布是未知的,

- 训练数据和测试数据被看作是依联合概率分布P(X,Y)独立同分布产生的。

假设空间

- 监督学习目的是学习一个由输入到输出的映射,称为模型

- 模式的集合就是假设空间(hypothesis space)

- 概率模型:条件概率分布P(Y|X), 决策函数:Y=f(X)

问题的形式化

无监督学习

强化学习

- 无模型(model-free)

- 基于策略(policy-based):求解最优策略π*

- 基于价值(value-based):求解最优价值函数

- 有模型(model-based)

- 通过学习马尔可夫决策过程的模型,包括转移概率函数和奖励函数

- 通过模型对环境的反馈进行预测

- 求解价值函数最大的策略π*

半监督学习

- 少量标注数据,大量未标注数据

- 利用未标注数据的信息,辅助标注数据,进行监督学习

- 较低成本

主动学习

- 机器主动给出实例,教师进行标注

- 利用标注数据学习预测模型

统计学习

-

按算法分类:

-

按技巧分类:

统计学习三要素

-

策略:经验风险最小化与结构风险最小化

- 经验风险最小化最优模型

m i n f ∈ F 1 N ∑ k = 1 N L ( y i , f ( x i ) ) min_{f\in F} \tfrac{1}{N}\sum_{k=1}^N L(y_{i},f(x_{i})) minf∈FN1k=1∑NL(yi,f(xi))

- 经验风险最小化最优模型

-

当样本容量很小时,经验风险最小化学习的效果未必很好,会产生“过拟合over-fitting”

-

结构风险最小化 structure risk minimization,为防止过拟合提出的策略,等价于正则化(regularization),加入正则化项regularizer,或罚项 penalty term:

R r e g ( f ) = 1 N ∑ i = 1 N L ( y i , f ( x i ) ) + λ J ( f ) R_{reg}(f) = \tfrac{1}{N} \sum_{i=1}^{N}L(y_{i},f(x_{i}))+ \lambda J(f) Rreg(f)=N1i=1∑NL(yi,f(xi))+λJ(f) -

求最优模型就是求解最优化问题:

m i n f ∈ F 1 N ∑ i = 1 N L ( y i , f ( x i ) ) + λ J ( f ) min_{f\in F} \tfrac{1}{N} \sum_{i=1}^{N}L(y_{i},f(x_{i}))+ \lambda J(f) minf∈FN1i=1∑NL(yi,f(xi))+λJ(f) -

算法:

- 如果最优化问题有显式的解析式,算法比较简单

- 但通常解析式不存在,就需要数值计算的方法

模型评估与模型选择

-

训练误差,训练数据集的平均损失: R c m p ( f ^ ) = 1 N ∑ i = 1 N L ( y i , f ^ ( x i ) ) R_{cmp}(\hat f) = \tfrac{1}{N} \sum_{i=1}^{N}L(y_{i},\hat f(x_{i})) Rcmp(f^)=N1∑i=1NL(yi,f^(xi))

-

测试误差,测试数据集的平均损失: e t e s t = 1 N ′ ∑ i = 1 N ′ L ( y i , f ^ ( x i ) ) e_{test} = \tfrac {1}{N\prime} \sum_{i=1}^{N^\prime}L(y_{i},\hat f(x_{i})) etest=N′1∑i=1N′L(yi,f^(xi))

-

损失函数是0-1 损失时: e t e s t = 1 N ′ ∑ i = 1 N ′ I ( y i ≠ f ^ ( x i ) ) e_{test} = \tfrac {1}{N \prime} \sum_{i=1}^{N^\prime}I(y_{i}\ne\hat f(x_{i})) etest=N′1∑i=1N′I(yi=f^(xi))

-

测试数据集的准确率: r t e s t = 1 N ′ ∑ i = 1 N ′ I ( y i = f ^ ( x i ) ) r_{test} = \tfrac {1}{N \prime} \sum_{i=1}^{N^\prime}I(y_{i}=\hat f(x_{i})) rtest=N′1∑i=1N′I(yi=f^(xi))

-

过拟合与模型选择

-

假设给定训练数据集 T = { ( x 1 , y 1 ) , ( x 2 , y 2 ) , . . . , ( x N , y N ) } T=\{(x_{1},y_{1}),(x_{2},y_{2}),...,(x_{N},y_{N})\} T={(x1,y1),(x2,y2),...,(xN,yN)}

f M ( x , w ) = w 0 + w 1 x + w 2 x 2 + . . . + w M x M = ∑ j = 0 M w j x j f_{M}(x,w) = w_{0}+w_{1}x+w_{2}x^2+...+w_{M}x^M = \sum_{j=0}^Mw_{j}x^j fM(x,w)=w0+w1x+w2x2+...+wMxM=j=0∑Mwjxj -

经验风险最小:

L ( w ) = 1 2 ∑ i = 1 N ( f ( x i , w ) − y i ) 2 L(w) = \tfrac{1}{2} \sum_{i=1}^{N}(f(x_{i},w)-y_{i})^2 L(w)=21i=1∑N(f(xi,w)−yi)2

L ( w ) = 1 2 ∑ i = 1 N ( ∑ j = 0 M w j x j − y i ) 2 L(w) = \tfrac{1}{2} \sum_{i=1}^{N}( \sum_{j=0}^Mw_{j}x^j-y_{i})^2 L(w)=21i=1∑N(j=0∑Mwjxj−yi)2

w f = ∑ i = 1 N x i y i ∑ i = 1 N x i j + 1 , j = 0 , 1 , 2 , . . . , M w_{f}=\dfrac {\sum_{i=1}^Nx_{i}y_{i}}{\sum_{i=1}^Nx_{i}^{j+1}},\qquad j=0,1,2,...,M wf=∑i=1Nxij+1∑i=1Nxiyi,j=0,1,2,...,M

正则化与交叉验证

- 正则化一般形式:

m i n f ∈ F 1 N ∑ i = 1 N L ( y i , f ( x i ) ) + λ J ( f ) min_{f\in F} \cfrac{1}{N} \sum_{i=1}^NL(y_{i},f(x_{i}))+ \lambda J(f) minf∈FN1i=1∑NL(yi,f(xi))+λJ(f) - 回归问题中:

L ( w ) = 1 N ∑ i = 1 N ( f ( x i ; w ) − y i ) 2 + λ 2 ∣ ∣ w ∣ ∣ 2 L(w)=\cfrac{1}{N}\sum_{i=1}^N \left( f(x_{i};w)-y_{i} \right)^2+\cfrac{\lambda}{2}||w||^2 L(w)=N1i=1∑N(f(xi;w)−yi)2+2λ∣∣w∣∣2

L ( w ) = 1 N ∑ i = 1 N ( f ( x i ; w ) − y i ) 2 + λ ∣ ∣ w ∣ ∣ 1 L(w)=\cfrac{1}{N}\sum_{i=1}^N \left( f(x_{i};w)-y_{i} \right)^2+\lambda||w||_{1} L(w)=N1i=1∑N(f(xi;w)−yi)2+λ∣∣w∣∣1 - 交叉验证:

- 训练集 training set: 用于训练模型

- 验证集 validation set: 用于模型选择

- 测试集 test set: 用于最终对学习方法的评估

- 简单交叉验证

- S折交叉验证

- 留一交叉验证

泛化能力 generalization ability

- 泛化误差 generalization error

R e x p ( f ^ ) = E p [ L ( Y , f ^ ( X ) ) ] = ∫ x × y L ( y , f ^ ( x ) ) P ( x , y ) d x d y R_{exp}(\hat f) = E_{p}\left[ L(Y,\hat f(X))\right] = \int_{x\times y} L(y,\hat f(x))P(x,y)dxdy Rexp(f^)=Ep[L(Y,f^(X))]=∫x×yL(y,f^(x))P(x,y)dxdy - 泛化误差上界

- 比较学习方法的泛化能力------比较泛化误差上界

- 性质:样本容量增加,泛化误差趋于0,假设空间容量越大, 泛化误差越大

- 二分类问题

X ∈ R n , Y ∈ { − 1 , 1 } X \in R^n , \qquad Y \in \{-1,1\} X∈Rn,Y∈{−1,1} - 期望风险和经验风险

R ( f ) = E [ L ( Y , f ( X ) ) ] R(f) = E[L(Y,f(X))] R(f)=E[L(Y,f(X))]

R ^ ( f ) = 1 N ∑ i = 1 N L ( y i , f ( x i ) ) \hat R(f) = \cfrac{1}{N}\sum_{i=1}^NL(y_{i},f(x_{i})) R^(f)=N1i=1∑NL(yi,f(xi)) - 经验风险最小化函数:

f N = a r g m i n f ∈ F R ^ ( f ) f_{N} = arg min_{f \in F }\hat R(f) fN=argminf∈FR^(f) - 泛化能力:

R ( f N ) = E [ L ( Y , f N ( X ) ) ] R(f_{N})=E[L(Y,f_{N}(X))] R(fN)=E[L(Y,fN(X))] - 定理:泛化误差上界,二分类问题,

当假设空间是有限个函数的结合 F = { f 1 , f 2 , . . . , f d } \mathcal{F}=\{f_{1},f_{2},...,f_{d}\} F={f1,f2,...,fd} ,

对任意一个函数f, 至少以概率1-δ,以下不等式成立:

R ( f ) ≤ R ^ ( f ) + ε ( d , N , δ ) ε ( d , N , δ ) = 1 N ( log d + l o g 1 δ ) R(f)\le\hat R(f)+\varepsilon(d,N,\delta)\qquad \varepsilon(d,N,\delta)=\sqrt{\dfrac{1}{N} \left( \log d+log \dfrac{1}{\delta}\right)} R(f)≤R^(f)+ε(d,N,δ)ε(d,N,δ)=N1(logd+logδ1)

生成模型与判别模型

- 生成模型与判别模型

- 决策函学数: Y = f ( X ) Y =f(X) Y=f(X)

- 条件概率分布: P ( Y ∣ X ) P(Y|X) P(Y∣X)

- 生成方法Generative approach 对应生成模型:generative model,

P ( Y ∣ X ) = P ( X , Y ) P ( X ) P(Y|X)=\cfrac{P(X,Y)}{P(X)} P(Y∣X)=P(X)P(X,Y) - 朴素贝叶斯法和隐马尔科夫模型

- 判别方法由数据直接学习决策函数f(X)或条件概率分布P(Y|X)作为预测的模型,即判别模型

- Discriminative approach对应discriminative model

Y = f ( X ) Y = f(X) Y=f(X)

P ( Y ∣ X ) P(Y|X) P(Y∣X)

K近邻法、感知机、决策树、logistic回归模型、最大熵模型、支持向量机、提升方法和条件随机场。 -

各自优缺点:

- 生成方法:可还原出联合概率分布P(X,Y), 而判别方法不能。生成方法的收敛速度更快,当样本容量增加的时候,学到的模型可以更快地收敛于真实模型;当存在隐变量时,仍可以使用生成方法,而判别方法则不能用。

- 判别方法:直接学习到条件概率或决策函数,直接进行预测,往往学习的准确率更高;由于直接学习Y=f(X)或P(Y|X),可对数据进行各种程度上的抽象、定义特征并使用特征,因此可以简化学习过程。

分类问题

-

二分类评价指标

- TP true positive 真阳性,分类正确的样本

- FN false negative 假阴性,把正样本分类为负样本

- FP false positive 假阳性,把负样本分类为正样本P

- TN true negative 真阴性,分类错误的样本

-

精确率 P = T P T P + F P P=\frac{TP}{TP+FP} P=TP+FPTP

-

召回率 R = T P T P + F N R=\cfrac{TP}{TP+FN} R=TP+FNTP

-

F 1 F_{1} F1值 2 F 1 = 1 P + 1 R \frac{2}{F_{1}}=\frac{1}{P}+\frac{1}{R} F12=P1+R1

F 1 = 2 T P 2 T P + F P + F N F_{1}=\frac{2TP}{2TP+FP+FN} F1=2TP+FP+FN2TP

标注问题

- 标注:tagging, 结构预测:structure prediction

- 输入:观测序列, 输出:标记序列或状态序列

- 学习和标注两个过程

- 训练集: T = { ( x 1 , y 1 ) , ( x 2 , y 2 ) , . . . , ( x N , y N ) } T=\{(x_{1},y_{1}),(x_{2},y_{2}),...,(x_{N},y_{N})\} T={(x1,y1),(x2,y2),...,(xN,yN)}

- 观测序列: x i = ( x i ( 1 ) , x i ( 2 ) , . . . , x i ( n ) ) T , i = 1 , 2 , . . . , N x_{i}=(x_{i}^{(1)},x_{i}^{(2)},...,x_{i}^{(n)})^T, i=1,2,...,N xi=(xi(1),xi(2),...,xi(n))T,i=1,2,...,N

- 输出标记序列: y i = ( y i ( 1 ) , y i ( 2 ) , . . . , y i ( n ) ) T y_{i} = (y_{i}^{(1)},y_{i}^{(2)},...,y_{i}^{(n)})^T yi=(yi(1),yi(2),...,yi(n))T

- 模型:条件概率分布 P ( Y ( 1 ) , Y ( 2 ) , . . . , Y ( n ) ∣ X ( 1 ) , X ( 2 ) , . . . , X ( n ) ) P(Y^{(1)},Y^{(2)},...,Y^{(n)}|X^{(1)},X^{(2)},...,X^{(n)}) P(Y(1),Y(2),...,Y(n)∣X(1),X(2),...,X(n))