Python爬虫之获取淘宝商品数据

爬取淘宝信息数据

首先需要先导入webdriver

from selenium import webdriver

webdriver支持主流的浏览器,比如说:谷歌浏览器、火狐浏览器、IE浏览器等等

然后可以创建一个webdriver对象,通过这个对象就可以通过get方法请求网站

driver = webdriver.Chrome() # 创建driver对象

driver.get('https://www.baidu.com') # 请求百度

接下来可以定义一个方法:search_product

一、selenium的简单介绍

1.selenium简介

selenium是一个用于测试网站的自动化测试工具,支持很多主流的浏览器,比如:谷歌浏览器、火狐浏览器、IE、Safari等。

2.支持多个操作系统

如windows、Linux、IOS、Android等。

3、安装selenium

打开终端输入

pip install Selenium

4、安装浏览器驱动

1、Chrome驱动文件下载:点击下载谷歌浏览器驱动

2、火狐浏览器驱动文件下载:点击下载geckodriver

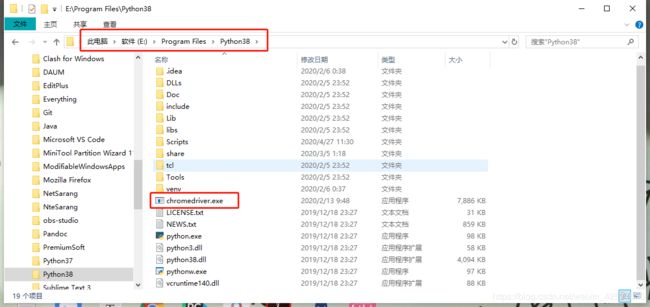

5、配置环境变量

配置环境变量的方法非常简单,首先将下载好的驱动进行解压,放到你安装Python的目录下,即可。

因为之前,在配置Python环境变量的时候,就将Python的目录放到我的电脑–>属性–>系统设置–>高级–>环境变量–>系统变量–>Path

二、selenium快速入门

1、selenium提供8种定位方式

1、id

2、name

3、class name

4、tag name

5、link text

6、partial link text

7、xpath

8、css selector

2、定位元素的8中方式详解

| 定义一个元素 | 定位多个元素 | 含义 |

|---|---|---|

| find_element_by_id | find_elements_by_id | 通过元素的id定位 |

| find_element_by_name | find_elements_by_name | 通过元素name定位 |

| find_element_by_xpath | find_elements_by_xpath | 通过xpath表达式定位 |

| find_element_by_link_text | find_elements_by_link_text | 通过完整超链接定位 |

| find_element_by_partial_link_text | find_elements_by_partial_link_text | 通过部分链接定位 |

| find_element_by_tag_name | find_elements_by_tag_name | 通过标签定位 |

| find_element_by_class_name | find_elements_by_class_name | 通过类名进行定位 |

| find_element_by_css_selector | find_elements_by_css_selector | 通过css选择器进行定位 |

3、selenium库下webdriver模块常用的方法与使用

控制浏览器的一些方法

| 方法 | 说明 |

|---|---|

| set_window_size() | 设置浏览器的大小 |

| back() | 控制浏览器后退 |

| forward() | 控制浏览器前进 |

| refresh() | 刷新当前页面 |

| clear() | 清除文本 |

| send_keys (value) | 模拟按键输入 |

| click() | 单击元素 |

| submit() | 用于提交表单 |

| get_attribute(name) | 获取元素属性值 |

| text | 获取元素的文本 |

4、代码实例

from selenium import webdriver

import time

# 创建Chrome浏览器对象,这会在电脑中打开一个窗口

browser = webdriver.Chrome()

# 通过浏览器向服务器发起请求

browser.get('https://www.baidu.com')

time.sleep(3)

# 刷新浏览器

browser.refresh()

# 最大化浏览器窗口

browser.maximize_window()

# 设置链接内容

element = browser.find_element_by_link_text('抗击肺炎')

# 点击'抗击肺炎'

element.click()

关于selenium的简单介绍就先到这里了,更多详细内容大家可以去selenium官方文档查看。点击查看selenium官方文档

爬取淘宝数据

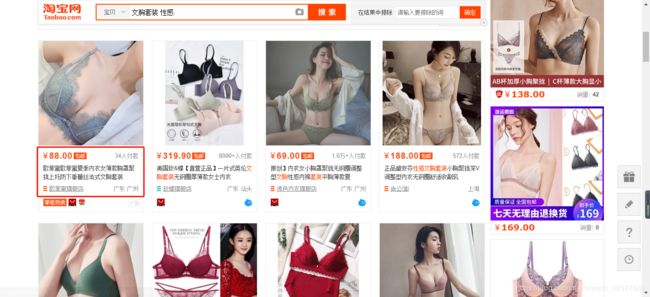

从上图,可以看到需要获取的信息是:价格、商品名称、付款人数、店铺名称。

现在我们开始进入主题。

首先,需要输入你要搜索商品的内容,然后根据内容去搜索淘宝信息,最后提取信息并保存。

1、搜素商品

我在这里定义提个搜索商品的函数和一个主函数。

搜索商品

在这里需要创建一个浏览器对象,并且根据该对象的get方法来发送请求。

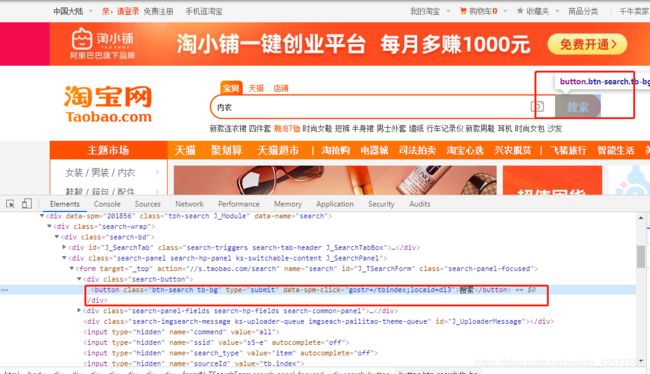

从上图可以发现搜索框的id值为q,那么这样就简单很多了,有HTML基础的朋友肯定知道id值是唯一的。

通过id值可以获取到文本框的位置,并传入参数,然后点击搜索按钮。

从上图可以发现搜索按钮在一个类里面,那么可以通过这个类来定位到搜索按钮,并执行点击操作。

当点击搜索按钮之后,网页便会跳转到登录界面,要求我们登录,如下图所示:

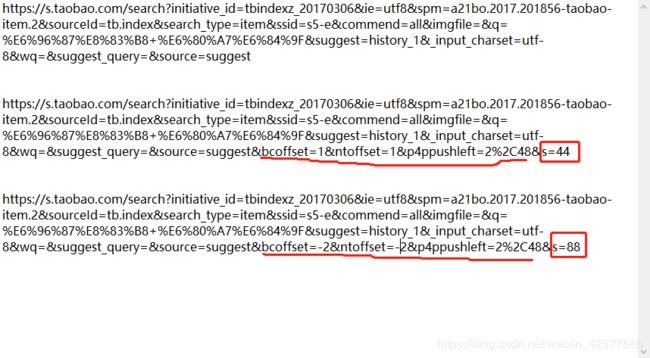

上图是前三页的url地址,你会发现其实并没有太大的变化,经过测试发现,真正有效的参数是框起来的内容,它的变化会导致页面的跳转,很明显第一页的s=0,第二页s=44,第三页s=88,以此类推,之后就可以轻松做到翻页了。

搜搜商品的代码如下:

def search_product(key_word):

'''

:param key_word: 搜索关键字

:return:

'''

# 通过id值来获取文本框的位置,并传入关键字

browser.find_element_by_id('q').send_keys(key_word)

# 通过class来获取到搜索按钮的位置,并点击

browser.find_element_by_class_name('btn-search').click()

# 最大化窗口

browser.maximize_window()

time.sleep(15)

page = browser.find_element_by_xpath('//div[@class="total"]').text # 共 100 页,

page = re.findall('(\d+)', page)[0] # findall返回一个列表

return page

2、获取商品信息并保存

获取商品信息相对比较简单,可以通过xpath方式来获取数据。在这里我就不在论述。在这边我创建了一个函数get_product来获取并保存信息。在保存信息的过程中使用到了csv模块,目的是将信息保存到csv里面。

def get_product():

divs = driver.find_elements_by_xpath('//div[@class="items"]/div[@class="item J_MouserOnverReq "]') # 这里返回的是列表,注意:elements

for div in divs:

info = div.find_element_by_xpath('.//div[@class="row row-2 title"]/a').text

price = div.find_element_by_xpath('.//strong').text + '元'

nums = div.find_element_by_xpath('.//div[@class="deal-cnt"]').text

names = div.find_element_by_xpath('.//div[@class="shop"]/a').text

print(info, price, nums, names,sep='|')

with open('data3.csv', mode='a', newline='', encoding='utf-8') as file:

csv_writer = csv.writer(file, delimiter=',') # 指定分隔符为逗号

csv_writer.writerow([info, price, nums, names])

3、构造URL实现翻页爬取

从上面的图片中可以发现连续三页URL的地址,其实真正变化并不是很多,经过测试发现,只有q和s两个参数是有用的。

构造出的url:https://s.taobao.com/search?q={}&s={}

因为q是你要搜索的商品,s是设置翻页的参数。这段代码就放在了主函数里面

def main():

browser.get('https://www.taobao.com/') # 向服务器发送请求

page = search_product(key_word)

print('正在爬取第1页的数据')

get_product() # 已经获得第1页的数据

page_nums = 1

while page_nums != page:

print('*'*100)

print('正在爬取第{}页的数据'.format(page_nums+1))

browser.get('https://s.taobao.com/search?q={}&s={}'.format(key_word, page_nums*44))

browser.implicitly_wait(10) # 等待10秒

get_product()

page_nums += 1

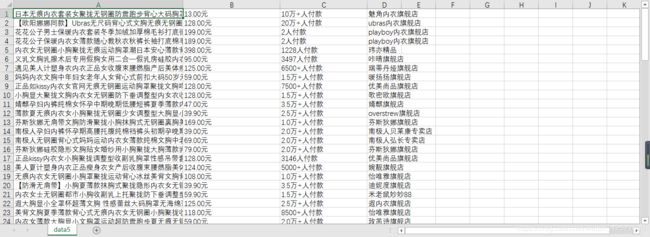

最后结果,如下图所示:

问题咨询

如果在这里大家有不理解的地方可以向我提出。可以在文章下方留言,也可以添加我的微信

代码获取

大家如果需要获取源代码的话可以关注我的公众号,在公众号里面文章会更加的详细。在公众号中回复:淘宝代码

即可获取到源码!!

视频教程

本次爬取淘宝信息的视频教程已经上传到了B站,点击观看视频教程里面有很多的爬虫视频和web安全渗透的视频,欢迎大家观看并留言!!

致谢

好了,又到了该说再见的时候了,希望我的文章可以给你带来知识,带给你帮助。同时也感谢你可以抽出你宝贵的时间来阅读,创作不易,如果你喜欢的话,点个关注再走吧。更多精彩内容会在后续更新,你的支持就是我创作的动力,我今后也会尽力给大家书写出更加优质的文章、。