- 【iOS】MVC设计模式

Magnetic_h

iosmvc设计模式objective-c学习ui

MVC前言如何设计一个程序的结构,这是一门专门的学问,叫做"架构模式"(architecturalpattern),属于编程的方法论。MVC模式就是架构模式的一种。它是Apple官方推荐的App开发架构,也是一般开发者最先遇到、最经典的架构。MVC各层controller层Controller/ViewController/VC(控制器)负责协调Model和View,处理大部分逻辑它将数据从Mod

- 微服务下功能权限与数据权限的设计与实现

nbsaas-boot

微服务java架构

在微服务架构下,系统的功能权限和数据权限控制显得尤为重要。随着系统规模的扩大和微服务数量的增加,如何保证不同用户和服务之间的访问权限准确、细粒度地控制,成为设计安全策略的关键。本文将讨论如何在微服务体系中设计和实现功能权限与数据权限控制。1.功能权限与数据权限的定义功能权限:指用户或系统角色对特定功能的访问权限。通常是某个用户角色能否执行某个操作,比如查看订单、创建订单、修改用户资料等。数据权限:

- 腾讯云技术深度探索:构建高效云原生微服务架构

我的运维人生

云原生架构腾讯云运维开发技术共享

腾讯云技术深度探索:构建高效云原生微服务架构在当今快速发展的技术环境中,云原生技术已成为企业数字化转型的关键驱动力。腾讯云作为行业领先的云服务提供商,不断推出创新的产品和技术,助力企业构建高效、可扩展的云原生微服务架构。本文将深入探讨腾讯云在微服务领域的最新进展,并通过一个实际案例展示如何在腾讯云平台上构建云原生应用。腾讯云微服务架构概览腾讯云微服务架构基于云原生理念,旨在帮助企业快速实现应用的容

- 关于提高复杂业务逻辑代码可读性的思考

编程经验分享

开发经验java数据库开发语言

目录前言需求场景常规写法拆分方法领域对象总结前言实际工作中大部分时间都是在写业务逻辑,一般都是三层架构,表示层(Controller)接收客户端请求,并对入参做检验,业务逻辑层(Service)负责处理业务逻辑,一般开发都是在这一层中写具体的业务逻辑。数据访问层(Dao)是直接和数据库交互的,用于查数据给业务逻辑层,或者是将业务逻辑层处理后的数据写入数据库。简单的增删改查接口不用多说,基本上写好一

- 18、架构-可观测性之聚合度量

大树~~

架构javapython后端架构

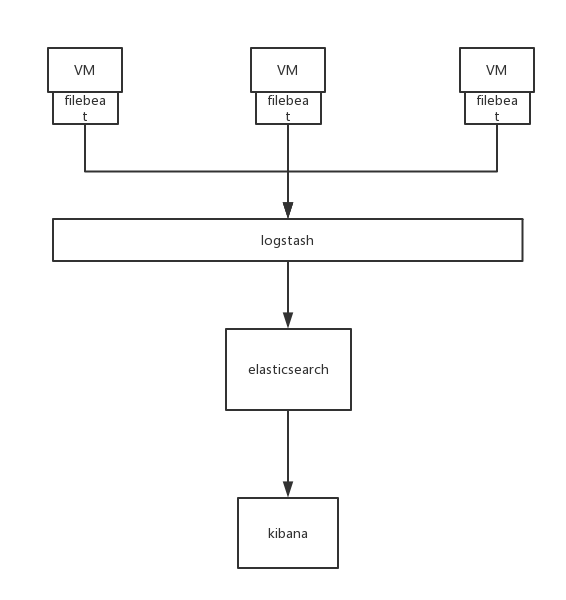

聚合度量聚合度量是指对系统运行时产生的各种指标数据进行收集、聚合和分析,以了解系统的健康状况和性能表现。聚合度量是可观测性的关键组成部分,通过对度量数据的分析,可以及时发现系统中的异常和瓶颈。以下是对聚合度量各个方面的详细解析,并结合具体的数据案例和技术支撑。指标收集收集系统运行时产生的各种指标数据是聚合度量的基础。常见的指标包括CPU使用率、内存使用率、请求处理时间、请求数、错误率等。以下是指标

- BART&BERT

Ambition_LAO

深度学习

BART和BERT都是基于Transformer架构的预训练语言模型。模型架构:BERT(BidirectionalEncoderRepresentationsfromTransformers)主要是一个编码器(Encoder)模型,它使用了Transformer的编码器部分来处理输入的文本,并生成文本的表示。BERT特别擅长理解语言的上下文,因为它在预训练阶段使用了掩码语言模型(MLM)任务,即

- 系统架构设计师 需求分析篇二

AmHardy

软件架构设计师系统架构需求分析面向对象分析分析模型UML和SysML

面向对象分析方法1.用例模型构建用例模型一般需要经历4个阶段:识别参与者:识别与系统交互的所有事物。合并需求获得用例:将需求分配给予其相关的参与者。细化用例描述:详细描述每个用例的功能。调整用例模型:优化用例之间的关系和结构,前三个阶段是必需的。2.用例图的三元素参与者:使用系统的用户或其他外部系统和设备。用例:系统所提供的服务。通信关联:参与者和用例之间的关系,或用例与用例之间的关系。3.识别参

- Java爬虫框架(一)--架构设计

狼图腾-狼之传说

java框架java任务html解析器存储电子商务

一、架构图那里搜网络爬虫框架主要针对电子商务网站进行数据爬取,分析,存储,索引。爬虫:爬虫负责爬取,解析,处理电子商务网站的网页的内容数据库:存储商品信息索引:商品的全文搜索索引Task队列:需要爬取的网页列表Visited表:已经爬取过的网页列表爬虫监控平台:web平台可以启动,停止爬虫,管理爬虫,task队列,visited表。二、爬虫1.流程1)Scheduler启动爬虫器,TaskMast

- Armv8.3 体系结构扩展--原文版

代码改变世界ctw

ARM-TEE-Androidarmv8嵌入式arm架构安全架构芯片TrustzoneSecureboot

快速链接:.ARMv8/ARMv9架构入门到精通-[目录]付费专栏-付费课程【购买须知】:个人博客笔记导读目录(全部)TheArmv8.3architectureextensionTheArmv8.3architectureextensionisanextensiontoArmv8.2.Itaddsmandatoryandoptionalarchitecturalfeatures.Somefeat

- 【ARM Cortex-M 系列 2.3 -- Cortex-M7 Debug event 详细介绍】

主公讲 ARM

#ARM系列arm开发debugevent

请阅读【嵌入式开发学习必备专栏】文章目录Cortex-M7DebugeventDebugeventsCortex-M7Debugevent在ARMCortex-M7架构中,调试事件(DebugEvent)是由于调试原因而触发的事件。一个调试事件会导致以下几种情况之一发生:进入调试状态:如果启用了停滞调试(HaltingDebug),一个调试事件会使处理器在调试状态下停滞。通过将DHCSR.C_DE

- 基于STM32与Qt的自动平衡机器人:从控制到人机交互的的详细设计流程

极客小张

stm32qt机器人物联网人机交互毕业设计c语言

一、项目概述目标和用途本项目旨在开发一款基于STM32控制的自动平衡机器人,结合步进电机和陀螺仪传感器,实现对平衡机器人的精确控制。该机器人可以用于教育、科研、娱乐等多个领域,帮助用户了解自动控制、机器人运动学等相关知识。技术栈关键词STM32单片机步进电机陀螺仪传感器AD采集电路Qt人机界面实时数据监控二、系统架构系统架构设计本项目的系统架构设计包括以下主要组件:控制单元:STM32单片机传感器

- JAVA·一个简单的登录窗口

MortalTom

java开发语言学习

文章目录概要整体架构流程技术名词解释技术细节资源概要JavaSwing是Java基础类库的一部分,主要用于开发图形用户界面(GUI)程序整体架构流程新建项目,导入sql.jar包(链接放在了文末),编译项目并运行技术名词解释一、特点丰富的组件提供了多种可视化组件,如按钮(JButton)、文本框(JTextField)、标签(JLabel)、下拉列表(JComboBox)等,可以满足不同的界面设计

- ARMV8体系结构简介:概述

简单同学

ARMV8体系结构ARMV8

1.前言本文主要概括的介绍ARMV8体系结构定义了哪些内容,概括的说:ARM体系结构定义了PE的行为,不会定义具体的实现ARM体系结构也定义了debug体系结构和trace体系结构ARM体系结构采用RISC指令集(1)长度一致的寄存器;(2)load/store架构,数据处理操作只能对寄存器内容进行处理,不会直接对内存的内容进行处理;(3)简单寻址方式,load/store地址来源于寄存器或指令域

- Table列表复现框实现【勾选-搜索-再勾选】

~四时春~

java开发语言elementuivue

Table列表复现框实现【勾选-搜索-再勾选】概要整体架构流程代码实现技术细节注意参考文献概要最近在开发时遇到一个问题,在进行表单渲染时,正常选中没有问题,单如果需要搜索选中时,一个是已选中的不会回填,二是在搜索的结果中进行选中,没有实现,经过排查,查找资料后实现。例如:整体架构流程具体的实现效果如下:代码实现{{scope.row.userName}}已选区{{userItem.userName

- 深入浅出 -- 系统架构之负载均衡Nginx的性能优化

xiaoli8748_软件开发

系统架构系统架构负载均衡nginx

一、Nginx性能优化到这里文章的篇幅较长了,最后再来聊一下关于Nginx的性能优化,主要就简单说说收益最高的几个优化项,在这块就不再展开叙述了,毕竟影响性能都有多方面原因导致的,比如网络、服务器硬件、操作系统、后端服务、程序自身、数据库服务等,对于性能调优比较感兴趣的可以参考之前《JVM性能调优》中的调优思想。优化一:打开长连接配置通常Nginx作为代理服务,负责分发客户端的请求,那么建议开启H

- AI大模型的架构演进与最新发展

季风泯灭的季节

AI大模型应用技术二人工智能架构

随着深度学习的发展,AI大模型(LargeLanguageModels,LLMs)在自然语言处理、计算机视觉等领域取得了革命性的进展。本文将详细探讨AI大模型的架构演进,包括从Transformer的提出到GPT、BERT、T5等模型的历史演变,并探讨这些模型的技术细节及其在现代人工智能中的核心作用。一、基础模型介绍:Transformer的核心原理Transformer架构的背景在Transfo

- 信息系统安全相关概念(上)

YuanDaima2048

课程笔记基础概念安全信息安全笔记

文章总览:YuanDaiMa2048博客文章总览下篇:信息系统安全相关概念(下)信息系统安全相关概念[上]信息系统概述信息系统信息系统架构信息系统发展趋势:信息系统日趋大型化、复杂化信息系统面临的安全威胁信息系统安全架构设计--以云计算为例信息系统安全需求及安全策略自主访问控制策略DAC强制访问控制策略MAC信息系统概述信息系统用于收集、存储和处理数据以及传递信息、知识和数字产品的一组集成组件。几

- 程序员架构师主要是做什么_程序员架构师:职责、技能与挑战

绿色小猪

免费备考资料(2024年11月软考):历年试题+视频课合集+电子讲义点击领取>>>免费刷题:2024年11月软考备考刷题点此进入>>>程序员架构师的角色定位在软件开发领域,程序员架构师是一个至关重要的角色。他们不仅需要深入理解业务需求,还要将其转化为技术上的解决方案。程序员架构师是项目中的技术领航者,负责制定和维护软件系统的整体架构,确保系统的可扩展性、可维护性和性能。他们的工作涉及从概念化到实现

- metaRTC8.0,一个全新架构的webRTC SDK库

metaRTC

webrtc音视频

概述metaRTC8.0是metaRTC开源以来架构变化最大的一个版本,是metaIPC3.0等高性能的基础。metaRTC8.0是一个全新架构版本,并非在metaRTC7.0版本上简单升级,在QOS/语音对讲/内存占用/视频文件录制读取等方面新增多个模块,在弱网对抗/语音对讲/内存优化等效果上有显著提升。metaRTC8.0在一年多的开发中进行了近200次迭代,metaRTC8.0社区版计划在2

- 鲲鹏 ARM 架构 麒麟 Lylin v10 安装 Nginx (离线)

焚木灵

arm开发架构nginx服务器

最近做一个银行的项目,银行的服务器是鲲鹏ARM架构的服务器,并且是麒麟v10的系统,这里记录一下在无法访问外网安装Nginx的方法。其他文章:鲲鹏ARM架构麒麟Lylinv10安装Mysql8.3(离线)-CSDN博客鲲鹏ARM架构麒麟Lylinv10安装Node和NVM(离线)-CSDN博客鲲鹏ARM架构麒麟Lylinv10安装Pm2(离线)-CSDN博客鲲鹏ARM架构麒麟Lylinv10安装P

- Nginx的使用场景:构建高效、可扩展的Web架构

张某布响丸辣

nginx前端架构

Nginx,作为当今最流行的Web服务器和反向代理软件之一,凭借其高性能、稳定性和灵活性,在众多Web项目中扮演着核心角色。无论是个人博客、中小型网站,还是大型企业级应用,Nginx都能提供强大的支持。本文将探讨Nginx的几个主要使用场景,帮助读者理解如何在实际项目中充分利用Nginx的优势。1.静态文件服务对于包含大量静态文件(如HTML、CSS、JavaScript、图片等)的网站,Ngin

- Hadoop架构

henan程序媛

hadoop大数据分布式

一、案列分析1.1案例概述现在已经进入了大数据(BigData)时代,数以万计用户的互联网服务时时刻刻都在产生大量的交互,要处理的数据量实在是太大了,以传统的数据库技术等其他手段根本无法应对数据处理的实时性、有效性的需求。HDFS顺应时代出现,在解决大数据存储和计算方面有很多的优势。1.2案列前置知识点1.什么是大数据大数据是指无法在一定时间范围内用常规软件工具进行捕捉、管理和处理的大量数据集合,

- Web安全:Web体系架构存在的安全问题和解决方室

程序员-张师傅

前端安全web安全前端

Web体系架构在提供丰富功能和高效服务的同时,也面临着诸多安全问题。这些问题可能涉及数据泄露、服务中断、系统被控制等多个方面,对企业和个人造成不可估量的损失。以下是对Web体系架构中存在的安全问题及解决方案的详细分析:Web体系架构存在的安全问题注入攻击SQL注入:攻击者通过在输入字段中插入恶意SQL代码,操控后台数据库,窃取、篡改或删除数据。OS命令注入:攻击者通过输入字段插入恶意代码,执行系统

- Gobelieve 架构

weixin_34099526

数据库golangjson

Gobelievegithub地址声明:转简书JackieF的文章,为了自己方便copy了一份,加一些自己的东西.链接:https://www.jianshu.com/p/8121d6e85282IMCore主要分三大块:im客户连接服务器(可分布式部署,暂无负载均衡模块)imr路由查询服务器(主要解决im分布式部署的问题)ims存储服务器(主从部署)基础模块1.数据包协议包:header(12)

- Go 面向包的设计和架构分层

云满笔记

golang架构directorylayoutsrcproject

标题Go面向包的设计和架构分层序前项目架构分层工具包项目应用项目cmd/internal/internal/pkg/pkg/vendor/面向包的设计和验证包的位置依赖包导入应用级别的策略数据的发送和接收错误处理测试捕获错误不建议的目录结论Go面向包的设计和架构分层序本篇内容主要讲解golang项目的面向包设计准则和基础的架构分层。信息来自原文ArdanLabs:Package-Oriented-

- Go 语言基本架构

Fe_cow丿

Go

Go基本架构一、Go基本架构:packagemainimport"fmt"funcmain(){fmt.Println("hello,world")}go文件的后缀是.go;packagemain:表示文件所在的包是main;每个Go应用程序都包含一个为main的包;所有包名都应该使用小写字母;import“fmt”:表示引入一个包,包名为fmt,引入该包后,就可以使用fmt包的函数;比如:fmt

- 从单体到微服务:FastAPI ‘挂载’子应用程序的转变

黑金IT

fastapi微服务fastapi架构

在现代Web应用开发中,模块化架构是一种常见的设计模式,它有助于将大型应用程序分解为更小、更易于管理的部分。FastAPI,作为一个高性能的PythonWeb框架,提供了强大的支持来实现这种模块化设计。通过“挂载”子应用程序,我们可以为不同的功能区域(如前端接口、管理员接口和用户中心)创建独立的应用程序,并将它们整合到一个主应用程序中。本文将详细介绍如何在FastAPI中使用“挂载”子应用程序的方

- Kafka详细解析与应用分析

芊言芊语

kafka分布式

Kafka是一个开源的分布式事件流平台(EventStreamingPlatform),由LinkedIn公司最初采用Scala语言开发,并基于ZooKeeper协调管理。如今,Kafka已经被Apache基金会纳入其项目体系,广泛应用于大数据实时处理领域。Kafka凭借其高吞吐量、持久化、分布式和可靠性的特点,成为构建实时流数据管道和流处理应用程序的重要工具。Kafka架构Kafka的架构主要由

- 使用FPGA接收MIPI CSI RX信号并进行去抖动、RGB转YUV处理:FX3014 USB3.0 UVC传输与帧率控制源代码,FPGA实现MIPI CSI RX接收,去Debayer, RGB转

kVfINoSzdrt

fpga开发程序人生

fpgamipicsirx接收去debayer,rgb转yuv,fx3014usb3.0uvc传输与帧率控制源代码,具体架构看图,除dphy物理层外,mipi均为源码sensorimx219mipi源码mipi4lanecsirxraw10fpgamachXO3lf-690usb3.0fx301432bityuvdatawithframesync测试模式3280*246415fps1920*108

- Kafka 基础与架构理解

StaticKing

KAFKAkafka

目录前言Kafka基础概念消息队列简介:Kafka与传统消息队列(如RabbitMQ、ActiveMQ)的对比Kafka的组件Kafka的工作原理:消息的生产、分发、消费流程Kafka系统架构Kafka的分布式架构设计Leader-Follower机制与数据复制Log-basedStorage和持久化Broker间通信协议Zookeeper在Kafka中的角色总结前言Kafka是一个分布式的消息系

- sql统计相同项个数并按名次显示

朱辉辉33

javaoracle

现在有如下这样一个表:

A表

ID Name time

------------------------------

0001 aaa 2006-11-18

0002 ccc 2006-11-18

0003 eee 2006-11-18

0004 aaa 2006-11-18

0005 eee 2006-11-18

0004 aaa 2006-11-18

0002 ccc 20

- Android+Jquery Mobile学习系列-目录

白糖_

JQuery Mobile

最近在研究学习基于Android的移动应用开发,准备给家里人做一个应用程序用用。向公司手机移动团队咨询了下,觉得使用Android的WebView上手最快,因为WebView等于是一个内置浏览器,可以基于html页面开发,不用去学习Android自带的七七八八的控件。然后加上Jquery mobile的样式渲染和事件等,就能非常方便的做动态应用了。

从现在起,往后一段时间,我打算

- 如何给线程池命名

daysinsun

线程池

在系统运行后,在线程快照里总是看到线程池的名字为pool-xx,这样导致很不好定位,怎么给线程池一个有意义的名字呢。参照ThreadPoolExecutor类的ThreadFactory,自己实现ThreadFactory接口,重写newThread方法即可。参考代码如下:

public class Named

- IE 中"HTML Parsing Error:Unable to modify the parent container element before the

周凡杨

html解析errorreadyState

错误: IE 中"HTML Parsing Error:Unable to modify the parent container element before the child element is closed"

现象: 同事之间几个IE 测试情况下,有的报这个错,有的不报。经查询资料后,可归纳以下原因。

- java上传

g21121

java

我们在做web项目中通常会遇到上传文件的情况,用struts等框架的会直接用的自带的标签和组件,今天说的是利用servlet来完成上传。

我们这里利用到commons-fileupload组件,相关jar包可以取apache官网下载:http://commons.apache.org/

下面是servlet的代码:

//定义一个磁盘文件工厂

DiskFileItemFactory fact

- SpringMVC配置学习

510888780

springmvc

spring MVC配置详解

现在主流的Web MVC框架除了Struts这个主力 外,其次就是Spring MVC了,因此这也是作为一名程序员需要掌握的主流框架,框架选择多了,应对多变的需求和业务时,可实行的方案自然就多了。不过要想灵活运用Spring MVC来应对大多数的Web开发,就必须要掌握它的配置及原理。

一、Spring MVC环境搭建:(Spring 2.5.6 + Hi

- spring mvc-jfreeChart 柱图(1)

布衣凌宇

jfreechart

第一步:下载jfreeChart包,注意是jfreeChart文件lib目录下的,jcommon-1.0.23.jar和jfreechart-1.0.19.jar两个包即可;

第二步:配置web.xml;

web.xml代码如下

<servlet>

<servlet-name>jfreechart</servlet-nam

- 我的spring学习笔记13-容器扩展点之PropertyPlaceholderConfigurer

aijuans

Spring3

PropertyPlaceholderConfigurer是个bean工厂后置处理器的实现,也就是BeanFactoryPostProcessor接口的一个实现。关于BeanFactoryPostProcessor和BeanPostProcessor类似。我会在其他地方介绍。PropertyPlaceholderConfigurer可以将上下文(配置文件)中的属性值放在另一个单独的标准java P

- java 线程池使用 Runnable&Callable&Future

antlove

javathreadRunnablecallablefuture

1. 创建线程池

ExecutorService executorService = Executors.newCachedThreadPool();

2. 执行一次线程,调用Runnable接口实现

Future<?> future = executorService.submit(new DefaultRunnable());

System.out.prin

- XML语法元素结构的总结

百合不是茶

xml树结构

1.XML介绍1969年 gml (主要目的是要在不同的机器进行通信的数据规范)1985年 sgml standard generralized markup language1993年 html(www网)1998年 xml extensible markup language

- 改变eclipse编码格式

bijian1013

eclipse编码格式

1.改变整个工作空间的编码格式

改变整个工作空间的编码格式,这样以后新建的文件也是新设置的编码格式。

Eclipse->window->preferences->General->workspace-

- javascript中return的设计缺陷

bijian1013

JavaScriptAngularJS

代码1:

<script>

var gisService = (function(window)

{

return

{

name:function ()

{

alert(1);

}

};

})(this);

gisService.name();

&l

- 【持久化框架MyBatis3八】Spring集成MyBatis3

bit1129

Mybatis3

pom.xml配置

Maven的pom中主要包括:

MyBatis

MyBatis-Spring

Spring

MySQL-Connector-Java

Druid

applicationContext.xml配置

<?xml version="1.0" encoding="UTF-8"?>

&

- java web项目启动时自动加载自定义properties文件

bitray

javaWeb监听器相对路径

创建一个类

public class ContextInitListener implements ServletContextListener

使得该类成为一个监听器。用于监听整个容器生命周期的,主要是初始化和销毁的。

类创建后要在web.xml配置文件中增加一个简单的监听器配置,即刚才我们定义的类。

<listener>

<des

- 用nginx区分文件大小做出不同响应

ronin47

昨晚和前21v的同事聊天,说到我离职后一些技术上的更新。其中有个给某大客户(游戏下载类)的特殊需求设计,因为文件大小差距很大——估计是大版本和补丁的区别——又走的是同一个域名,而squid在响应比较大的文件时,尤其是初次下载的时候,性能比较差,所以拆成两组服务器,squid服务于较小的文件,通过pull方式从peer层获取,nginx服务于较大的文件,通过push方式由peer层分发同步。外部发布

- java-67-扑克牌的顺子.从扑克牌中随机抽5张牌,判断是不是一个顺子,即这5张牌是不是连续的.2-10为数字本身,A为1,J为11,Q为12,K为13,而大

bylijinnan

java

package com.ljn.base;

import java.util.Arrays;

import java.util.Random;

public class ContinuousPoker {

/**

* Q67 扑克牌的顺子 从扑克牌中随机抽5张牌,判断是不是一个顺子,即这5张牌是不是连续的。

* 2-10为数字本身,A为1,J为1

- 翟鸿燊老师语录

ccii

翟鸿燊

一、国学应用智慧TAT之亮剑精神A

1. 角色就是人格

就像你一回家的时候,你一进屋里面,你已经是儿子,是姑娘啦,给老爸老妈倒怀水吧,你还觉得你是老总呢?还拿派呢?就像今天一样,你们往这儿一坐,你们之间是什么,同学,是朋友。

还有下属最忌讳的就是领导向他询问情况的时候,什么我不知道,我不清楚,该你知道的你凭什么不知道

- [光速与宇宙]进行光速飞行的一些问题

comsci

问题

在人类整体进入宇宙时代,即将开展深空宇宙探索之前,我有几个猜想想告诉大家

仅仅是猜想。。。未经官方证实

1:要在宇宙中进行光速飞行,必须首先获得宇宙中的航行通行证,而这个航行通行证并不是我们平常认为的那种带钢印的证书,是什么呢? 下面我来告诉

- oracle undo解析

cwqcwqmax9

oracle

oracle undo解析2012-09-24 09:02:01 我来说两句 作者:虫师收藏 我要投稿

Undo是干嘛用的? &nb

- java中各种集合的详细介绍

dashuaifu

java集合

一,java中各种集合的关系图 Collection 接口的接口 对象的集合 ├ List 子接口 &n

- 卸载windows服务的方法

dcj3sjt126com

windowsservice

卸载Windows服务的方法

在Windows中,有一类程序称为服务,在操作系统内核加载完成后就开始加载。这里程序往往运行在操作系统的底层,因此资源占用比较大、执行效率比较高,比较有代表性的就是杀毒软件。但是一旦因为特殊原因不能正确卸载这些程序了,其加载在Windows内的服务就不容易删除了。即便是删除注册表中的相 应项目,虽然不启动了,但是系统中仍然存在此项服务,只是没有加载而已。如果安装其他

- Warning: The Copy Bundle Resources build phase contains this target's Info.plist

dcj3sjt126com

iosxcode

http://developer.apple.com/iphone/library/qa/qa2009/qa1649.html

Excerpt:

You are getting this warning because you probably added your Info.plist file to your Copy Bundle

- 2014之C++学习笔记(一)

Etwo

C++EtwoEtwoiterator迭代器

已经有很长一段时间没有写博客了,可能大家已经淡忘了Etwo这个人的存在,这一年多以来,本人从事了AS的相关开发工作,但最近一段时间,AS在天朝的没落,相信有很多码农也都清楚,现在的页游基本上达到饱和,手机上的游戏基本被unity3D与cocos占据,AS基本没有容身之处。so。。。最近我并不打算直接转型

- js跨越获取数据问题记录

haifengwuch

jsonpjsonAjax

js的跨越问题,普通的ajax无法获取服务器返回的值。

第一种解决方案,通过getson,后台配合方式,实现。

Java后台代码:

protected void doPost(HttpServletRequest req, HttpServletResponse resp)

throws ServletException, IOException {

String ca

- 蓝色jQuery导航条

ini

JavaScripthtmljqueryWebhtml5

效果体验:http://keleyi.com/keleyi/phtml/jqtexiao/39.htmHTML文件代码:

<!DOCTYPE html>

<html xmlns="http://www.w3.org/1999/xhtml">

<head>

<title>jQuery鼠标悬停上下滑动导航条 - 柯乐义<

- linux部署jdk,tomcat,mysql

kerryg

jdktomcatlinuxmysql

1、安装java环境jdk:

一般系统都会默认自带的JDK,但是不太好用,都会卸载了,然后重新安装。

1.1)、卸载:

(rpm -qa :查询已经安装哪些软件包;

rmp -q 软件包:查询指定包是否已

- DOMContentLoaded VS onload VS onreadystatechange

mutongwu

jqueryjs

1. DOMContentLoaded 在页面html、script、style加载完毕即可触发,无需等待所有资源(image/iframe)加载完毕。(IE9+)

2. onload是最早支持的事件,要求所有资源加载完毕触发。

3. onreadystatechange 开始在IE引入,后来其它浏览器也有一定的实现。涉及以下 document , applet, embed, fra

- sql批量插入数据

qifeifei

批量插入

hi,

自己在做工程的时候,遇到批量插入数据的数据修复场景。我的思路是在插入前准备一个临时表,临时表的整理就看当时的选择条件了,临时表就是要插入的数据集,最后再批量插入到数据库中。

WITH tempT AS (

SELECT

item_id AS combo_id,

item_id,

now() AS create_date

FROM

a

- log4j打印日志文件 如何实现相对路径到 项目工程下

thinkfreer

Weblog4j应用服务器日志

最近为了实现统计一个网站的访问量,记录用户的登录信息,以方便站长实时了解自己网站的访问情况,选择了Apache 的log4j,但是在选择相对路径那块 卡主了,X度了好多方法(其实大多都是一样的内用,还一个字都不差的),都没有能解决问题,无奈搞了2天终于解决了,与大家分享一下

需求:

用户登录该网站时,把用户的登录名,ip,时间。统计到一个txt文档里,以方便其他系统调用此txt。项目名

- linux下mysql-5.6.23.tar.gz安装与配置

笑我痴狂

mysqllinuxunix

1.卸载系统默认的mysql

[root@localhost ~]# rpm -qa | grep mysql

mysql-libs-5.1.66-2.el6_3.x86_64

mysql-devel-5.1.66-2.el6_3.x86_64

mysql-5.1.66-2.el6_3.x86_64

[root@localhost ~]# rpm -e mysql-libs-5.1