(二)人工智能安全问题:《人工智能安全白皮书(2018)》摘要

以下内容摘自《人工智能安全白皮书(2018)》

http://www.caict.ac.cn/kxyj/qwfb/bps/index_1.htm

《人工智能发展白皮书-技术架构篇(2018年)》

《人工智能安全白皮书(2018)》

《2018世界人工智能产业发展蓝皮书》

《电信网络人工智能应用白皮书(2018 年)》

《 深度学习技术选型白皮书(2018 年)》

目录

以下内容摘自《人工智能安全白皮书(2018)》

第一章、 人工智能安全内涵与体系架构

(一) 人工智能基本概念与发展历程

1、人工智能基本概念

2、人工智能发展历程

(二) 人工智能安全内涵

(三) 人工智能安全体系架构

1、人工智能安全风险

2、人工智能安全应用

3、人工智能安全管理

第二章、 人工智能安全风险分析

(一) 网络安全风险

(二) 数据安全风险

1、逆向攻击可导致算法模型内部的数据泄露。

2、人工智能技术可加强数据挖掘分析能力,加大隐私泄露风险。

(三) 算法安全风险

1、算法设计或实施有误可产生与预期不符甚至伤害性结果。

2、算法潜藏偏见和歧视,导致决策结果可能存在不公。

3、算法黑箱导致人工智能决策不可解释,引发监督审查困境。

4、含有噪声或偏差的训练数据可影响算法模型准确性。

5、对抗样本攻击可诱使算法识别出现误判漏判,产生错误结果。

(四) 信息安全风险

1、智能推荐算法可加速不良信息的传播。

2、人工智能技术可制作虚假信息内容,用以实施诈骗等不法活动。

(五) 社会安全风险

1、人工智能产业化推进将使部分现有就业岗位减少甚至消失,导致 结构性失业。

2、人工智能特别是高度自治系统的安全风险可危及人身安全。

3、人工智能产品和应用会对现有社会伦理道德体系造成冲击。

(六) 国家安全风险

1、人工智能可用于影响公众政治意识形态,间接威胁国家安全

2、人工智能可用于构建新型军事打击力量,直接威胁国家安全。

第三章、 人工智能安全应用情况

(一) 网络信息安全应用

1、网络安全防护应用

2、信息内容安全审查应用

3、数据安全管理应用

(二) 社会公共安全应用

1、智能安防应用

2、金融风控应用

第四章、 人工智能安全管理现状

(一) 主要国家人工智能安全关注重点

1、美国:关注人工智能技术对国家安全的影响。

2、欧盟和英国:关注人工智能对隐私、就业及伦理影响

3、俄罗斯、以色列、印度:重点关注人工智能国防领域应用以 及对军事安全影响

4、加拿大、日本、韩国、新加坡:侧重人工智能人才培养、技 术研发和产业推进等,对人工智能安全关注较少

(二) 主要国家人工智能安全法规政策制定情况

(三) 国内外人工智能安全标准规范制定情况

1、IEEE正在开发人工智能伦理道德标准,规范人工智能安全设计。

2、ISO/IEC成立人工智能可信研究组,开展人工智能安全标准研究。

3、我国成立国家人工智能标准化总体组与专家咨询组,加强人工智能安全标准研制工作。

(四) 国内外人工智能安全技术手段建设情况

(五) 国内外人工智能重点应用的安全评估情况

1、自动驾驶的安全测试验证受到各国高度重视,但未形成统一安全 标准和评价体系。

2、工业机器人相关安全标准较为完备,但智能服务机器人安全标准体系和评估能力尚待完善。

(六) 国内外人工智能人才队伍建设情况

(七) 国内外人工智能产业生态培育情况

五、 人工智能安全发展建议

(一) 加强自主创新,突破共性关键技术

(二) 完善法律法规,制定伦理道德规范

(三) 健全监管体系,引导产业健康发展

(四) 强化标准引领,构建安全评估体系

(五) 促进行业协作,推动技术安全应用

(六) 加大人才培养,提升人员就业技能

(七) 加强国际交流,应对共有安全风险

(八) 加大社会宣传,科学处理安全问题

第一章、 人工智能安全内涵与体系架构

(一) 人工智能基本概念与发展历程

1、人工智能基本概念

结合业界专 家观点,项目组研究认为,人工智能是利用人为制造来实现智能机器 或者机器上的智能系统,模拟、延伸和扩展人类智能,感知环境,获 取知识并使用知识获得最佳结果的理论、方法和技术。

2、人工智能发展历程

![]() 人工智能 自 1956 年诞生。

人工智能 自 1956 年诞生。

![]() 以 2006 年深度学习模型的提出为标志,人工智能核心 算法取得重大突破并不断优化。

以 2006 年深度学习模型的提出为标志,人工智能核心 算法取得重大突破并不断优化。

![]() 当前人工智能仍处于弱人工智能阶段,主要是面向特定领域的专 用智能。

当前人工智能仍处于弱人工智能阶段,主要是面向特定领域的专 用智能。

人工智能可划分为弱人工智能、强人工 智能和超人工智能三个阶段。弱人工智能擅长于在特定领域、有限规 则内模拟和延伸人的智能;强人工智能具有意识、自我和创新思维, 能够进行思考、计划、解决问题、抽象思维、理解复杂理念、快速学 习和从经验中学习等人类级别智能的工作;超人工智能是在所有领域 都大幅超越人类智能的机器智能。

(二) 人工智能安全内涵

人工智能安全内涵包含:

一、降低 人工智能不成熟性以及恶意应用给网络空间和国家社会带来的安全 风险;

二、推动人工智能在网络安全和公共安全领域深度应用;

三、构建人工智能安全管理体系,保障人工智能安全稳步发展。

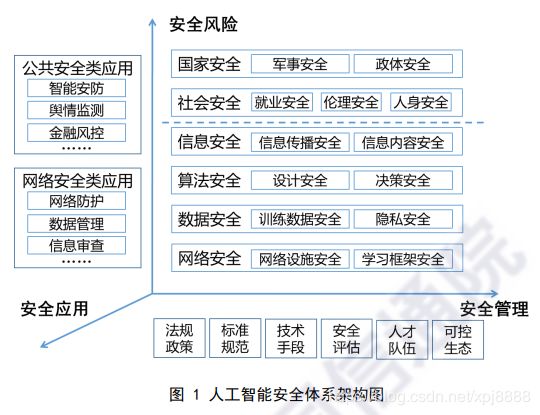

(三) 人工智能安全体系架构

基于对人工智能安全内涵的理解,项目组提出覆盖安全风险、安 全应用、安全管理三个维度的人工智能安全体系架构。

1、人工智能安全风险

人工智能作为战略性与变革性信息技术,给网络空间安全增加了 新的不确定性,人工智能网络空间安全风险包括:网络安全风险、数 据安全风险、算法安全风险和信息安全风险。

网络安全风险涉及网络设施和学习框架的漏洞、后门安全问题, 以及人工智能技术恶意应用导致的系统网络安全风险(破坏网络)。

数据安全风险包括人工智能系统中的训练数据偏差、非授权篡改 以及人工智能引发的隐私数据泄露等安全风险(盗用数据)。

算法安全风险对应技术层中算法设计、决策相关的安全问题,涉 及算法黑箱、算法模型缺陷等安全风险(每个算法都可能存在安全隐患,只是现在没有发现而已)。

信息安全风险主要包括人工智能技术应用于信息传播以及人工 智能产品和应用输出的信息内容安全问题(散播不良信息)。

社会安全风险是指人工智能产业化应用带来的结构性失业、对社 会伦理道德的冲击以及可能给个人人身安全带来损害(大部分人失业导致社会不稳定)。

国家安全风险是指人工智能在军事作战、社会舆情等领域应用给 国家军事安全和政体安全带来的风险隐患。

2、人工智能安全应用

网络防护应用是指利用人工智能算法开展入侵检测、恶意软件检 测、安全态势感知、威胁预警等技术和产品的研发。

数据管理应用是指利用人工智能技术实现对数据分级分类、防泄 漏、泄露溯源等数据安全保护目标。

信息审查应用是指利用人工智能技术辅助人类对表现形式多样, 数量庞大的网络不良内容进行快速审查。

智能安防应用是指利用人工智能技术推动安防领域从被动防御 向主动判断、及时预警的智能化方向发展。

金融风控应用是指利用人工智能技术提升信用评估、风险控制等 工作效率和准确度,并协助政府部门进行金融交易监管。

舆情监测应用是指利用人工智能技术加强国家网络舆情监控能 力,提升社会治理能力,保障国家安全。

3、人工智能安全管理

法规政策方面,针对人工智能重点应用领域和突出的安全风险, 建立健全相应的安全管理法律法规和管理政策。

标准规范方面,加强人工智能安全要求、安全评估评测等方面的 国际、国内和行业标准的制定完善工作。

技术手段方面,建设人工智能安全风险监测预警、态势感知、应 急处置等安全管理的技术支撑能力。

安全评估方面,加快人工智能安全评估评测指标、方法、工具和 平台的研发,构建第三方安全评估评测能力。

人才队伍方面,加大人工智能人才教育与培养,形成稳定的人才 供给和合理的人才梯队,促进人工智能安全持续发展。

可控生态方面,加强人工智能产业生态中薄弱环节的研究与投入, 提升产业生态的自我主导能力,保障人工智能安全可控发展。

以下的第二章、第三章、第四章,分别对第一章的安全风险、安 全应用、安全管理三大部分观点,又分别进行叙述。最后,本文提出人工智能的发展建议,相当于对人工智能的总结。因此,文本采用了总分总的结构来阐述人工智能。

第二章、 人工智能安全风险分析

(一) 网络安全风险

1、目前,国内人工智能产品和应用的研发主要是基于谷歌、微软、 亚马逊、脸书、百度等科技巨头发布的人工智能学习框架和组件。但 是,由于这些开源框架和组件缺乏严格的测试管理和安全认证,可能 存在漏洞和后门等安全风险。

2、过去恶意软件的创建 在很大程度上由网络犯罪分子人工完成,通过手动编写脚本以组成计 算机病毒和木马,并利用 rootkit、密码抓取器和其他工具帮助分发 和执行。但人工智能技术可使这些流程自动化,通过插入一部分对抗 性样本,绕过安全产品的检测,甚至根据安全产品的检测逻辑,实现 恶意软件自动化地在每次迭代中自发更改代码和签名形式,在自动修 改代码逃避反病毒产品检测的同时,保证其功能不受影响。

3、2017 年 3 月,首个用机器学习创建恶意软件的案例出现在《为基于 GAN 的黑盒 测试产生敌对恶意软件样本》的论文报告中,基于生成性对抗网络 (GAN)的算法来产生对抗恶意软件样本,这些样本能绕过基于机器学 习的检测系统。

4、Fortinet 在其发布的 2018 年全球威胁态势预测中表示,人工 智能技术未来将被大量应用在蜂巢网络(Hivenet)和机器人集群 (Swarmbots)中,利用自我学习能力以前所未有的规模自主攻击脆弱 系统。

(二) 数据安全风险

1、逆向攻击可导致算法模型内部的数据泄露。

逆向攻击是利用机器学 习系统提供的一些应用程序编程接口(API)来获取系统模型的初步 信息,进而通过这些初步信息对模型进行逆向分析,从而获取模型内 部的训练数据和运行时采集的数据。例如,Fredrikson 等人在仅能黑 盒式访问用于个人药物剂量预测的人工智能算法的情况下,通过某病 人的药物剂量就可恢复病人的基因信息。

2、人工智能技术可加强数据挖掘分析能力,加大隐私泄露风险。

Facebook 数据泄露事件的主角剑桥分析公司通过关联分 析的方式获得了海量的美国公民用户信息,包括肤色、性取向、智力 水平、性格特征、宗教信仰、政治观点以及酒精、烟草和毒品的使用 情况,借此实施各种政治宣传和非法牟利活动。

(三) 算法安全风险

1、算法设计或实施有误可产生与预期不符甚至伤害性结果。

2018 年 3 月,Uber 自动驾驶汽车因机器 视觉系统未及时识别出路上突然出现的行人,导致与行人相撞致人死 亡。

谷歌、斯坦福大学、伯克利大学和 OpenAI 研究机构的学者根据 错误产生的阶段将算法模型设计和实施中的安全问题分为三类。第一 类是设计者为算法定义了错误的目标函数。例如,设计者在设计目标 函数时没有充分考虑运行环境的常识性限制条件,导致算法在执行任 务时对周围环境造成不良影响。第二类是设计者定义了计算成本非常 高的目标函数,使得算法在训练和使用阶段无法完全按照目标函数执行,只能在运行时执行某种低计算成本的替代目标函数,从而无法达 到预期的效果或对周围环境造成不良影响。第三类是选用的算法模型 表达能力有限,不能完全表达实际情况,导致算法在实际使用时面对 不同于训练阶段的全新情况可能产生错误的结果。

2、算法潜藏偏见和歧视,导致决策结果可能存在不公。

比如Northpointe 公司开发的犯罪风险评估算法 COMPAS 时,黑人被错误地评估为具有 高犯罪风险的概率两倍于白人。本质原因由两方面原因造成,一、设计者和开发者的主观偏见。二是数据是社会现 实的反应,训练数据本身带有歧视性,用这样的数据训练得出的算法 模型天然潜藏歧视和偏见。

3、算法黑箱导致人工智能决策不可解释,引发监督审查困境。

4、含有噪声或偏差的训练数据可影响算法模型准确性。

例 如,主流人脸识别系统大多用白种人和黄种人面部图像作为训练数据, 在识别黑种人时准确率会有很大下降。MIT 研究员与微软科学家对微 软、IBM 和旷世科技三家的人脸识别系统进行测试,发现其针对白人 男性的错误率低于 1%,而针对黑人女性的错误率则高达 21%-35%。

5、对抗样本攻击可诱使算法识别出现误判漏判,产生错误结果。

例如,Biggio 研究团队利用梯度法来产生最优化的逃避对抗 样本,成功实现对垃圾邮件检测系统和 PDF 文件中的恶意程序检测 系统的攻击。再例如,Nguyen 等人利用改进的遗传 算法产生多个类别图片进化后的最优对抗样本,对谷歌的 AlexNet 和 基于 Caffe 架构的 LeNet5 网络进行模仿攻击,从而欺骗 DNN 实现误 分类。

(四) 信息安全风险

1、智能推荐算法可加速不良信息的传播。

McAfee 公司表示,犯罪分子将越来越多地 利用机器学习来分析大量隐私记录,以识别潜在的易攻击目标人群, 通过智能推荐算法投放定制化钓鱼邮件,提升社会工程攻击的精准性。

2、人工智能技术可制作虚假信息内容,用以实施诈骗等不法活动。

2017 年,我国浙江、湖北等地发生多起犯罪分子利用语音合 成技术假扮受害人亲属实施诈骗的案件,造成恶劣社会影响。 2018 年 2 月英国剑桥大学等发布的《人工智能的恶意使用:预测、预防和 缓解》研究报告预测,未来通过合成语音和视频及多轮次对话的诈骗 技术成为可能,基于人工智能的精准诈骗将使人们防不胜防。

2018 年 5 月 8 日,谷歌在 I/O 开发者大会上展示的聊天机器人,在与人进 行电话互动时对话自然流畅、富有条理,已经完全骗过了人类。

(五) 社会安全风险

1、人工智能产业化推进将使部分现有就业岗位减少甚至消失,导致 结构性失业。

据 Forrester Research 预测统计,人工智能技术将在 2025 年之前取代美国 7%的 工作岗位,其中16%的美国工人将被人工智能系统取代。《未来简史》 作者尤瓦尔·赫拉利预言,二三十年内超过 50%工作会被人工智能取 代。

2、人工智能特别是高度自治系统的安全风险可危及人身安全。

例如,2016 年 5 月,开启自动驾驶功能的特斯拉汽车无法识别蓝天背景下的白色 货车,在美国发生车祸致驾驶员死亡;2017 年年初,我国发生多起 无人机干扰致航班紧急迫降事件。

3、人工智能产品和应用会对现有社会伦理道德体系造成冲击。

体现在4个方面:

3.1、智能系统的决策算法会影响社会公平正义。

Kronos 公司的人工智能雇佣辅助系统让少数族裔、女性 或者有心理疾病史的人更难找到工作。

3.2、人工智能应用缺乏道德规 范约束,资本逐利本性会导致公众权益受到侵害。

例如:携程、滴滴等基于用户行为数 据分析,实现对客户的价格歧视;Facebook 利用人工智能有针对性 地向用户投放游戏、瘾品甚至虚假交友网站的广告,从中获取巨大利 益。

3.3、人工智能会让人类产生严重依赖,冲击现有人际观念。

智能伴侣机器人依托个人数据分析,能够更加了解个体心理,贴近用 户需求,对人类极度体贴和恭顺,这就会让人类放弃正常的异性交往, 严重冲击传统家庭观念。

3.4、人工智能产品和系统安全事件导致的财 产损失、人身伤害等面临无法追责的困境。

(六) 国家安全风险

1、人工智能可用于影响公众政治意识形态,间接威胁国家安全

美国伊隆大学数据科 学家奥尔布赖特指出,通过行为追踪识别技术采集海量数据,识别出 潜在的投票人,进行虚假新闻的点对点的推送,可有效影响美国大选 结果。

2、人工智能可用于构建新型军事打击力量,直接威胁国家安全。

例如,美国国防部明确 把人工智能作为第三次“抵消战略”的重要技术支柱。俄罗斯军队于 2017 年开始大量列装机器人,计划到 2025 年,无人系统在俄军装备 结构中的比例将达到 30%

第三章、 人工智能安全应用情况

(一) 网络信息安全应用

1、网络安全防护应用

1.1、从应用深度看,人工智能在网 络安全的应用程度仍处于前期积累阶段。

例如,在入侵检测方面, 以色列 Hexadite 公司利用人工智能来自动分析威胁,迅速识别和解 决网络攻击,帮助企业内部安全团队管理和优先处理潜在威胁;我国 山石网科公司研发智能防火墙,可基于行为分析技术,帮助客户发现 未知网络威胁,能够在攻击的全过程提供防护和检测。

1.2、从应用范围看,人工智 能在网络安全的应用场景日益广泛。

如英国 DarkTrace 公司 基于剑桥大学的机器学习和人工智能算法仿生人类免疫系统,致力于 实现网络自动自主防御潜在威胁,能够帮助企业快速识别并应对人为 制造的网络攻击,同时还能预防基于机器学习的网络攻击。

2、信息内容安全审查应用

美国互联网巨头 Facebook 不仅利用人工智能技术 对互联网内容进行标记,而且利用机器学习开发了一款对用户的视频 直播内容进行实时监控识别的工具,自动对直播中涉黄、涉暴或者自 杀类别的视频内容进行标记。

3、数据安全管理应用

德国的 Neokami 公司利用人工智能技术帮助客 户保护云端、本地或物理资产上的敏感数据,该公司所研发的数据分 类引擎适用于多种业务场景,已被众多合作伙伴厂商所采用,在多家 财富 500 强公司中创造价值。

(二) 社会公共安全应用

1、智能安防应用

1.1、基于人工智能技术的智能安防呈现全球高速发展的良好态势。

与传统安防不同,基于人工智能的智能安防依 托对海量视频数据的学习,可完成行为模式的推断和预测,已经从被 动防御向主动判断、及时预警的智能化方向发展,目前已经应用于人 脸识别、车辆识别等系统中,进行目标属性提取,实现对目标的智能 检测、跟踪及排查。

1.2、国外芯片巨头把握行业发展良机,加紧在智能安防产业链上游布 局。

美国芯片巨头英特尔早在 2016 年就收购了具有领先技术的计算 机视觉公司 Movidius,之后陆续推出多款植入独立神经运算引擎、 支持边缘深度学习推断的视觉运算芯片以及神经计算 SDK 开发包,形 成平台化设计,为世界范围内各大安防公司提供个性化的解决方案。

1.3、国内智能安防产业发展空间巨大。

预计到 2020 年, 安防企业总收入达到 8000 亿元左右,年增长率达到 10%以上

1.4、国 内智能安防行业创新能力不断加强,但仍需向产业链上游努力迈进。

目前看,国内安防市场竞争格局以人工智能创新型企业和传统安防巨 头两类企业为主。其中,基于人工智能的初创企业如云从科技、商汤 科技和旷视科技等,依托在计算机视觉、数据深度分析等方面的技术 积累,推出智能安防产品,进行产业布局;传统安防巨头海康威视、 大华股份等近年来不断加大研发投入,加强技术创新能力,并且对初 创企业进行投资收购,逐步提升安防产品智能化水平

2、金融风控应用

2.1、人工智能技术可用于提升金融风控工作效率和准确度。

2.2、国外发展相对成熟,已应用于金融交易监管。

2016 年 底,纳斯达克和伦敦证券交易所启用人工智能投入市场监管;2017 上半年,华尔街两家交易所推出智能监管系统。

2.3、国内处于起步阶段,仍需长时间的市场验证。

国内融 360、好贷 网、资信客等金融企业借助对企业市场影响力、产品口碑评价等广泛 的数据采集和有效筛选,依托人工智能技术实现了对历史经营数据和 实时市场信息的量化建模,进而实现了对各类资产风险的预测评估。

第四章、 人工智能安全管理现状

(一) 主要国家人工智能安全关注重点

1、美国:关注人工智能技术对国家安全的影响。

2017 年 7 月,哈佛大学肯尼迪政治学院发 布《人工智能与国家安全》报告。

2018 年 3 月 20 日,美国国 会发起提案,建议成立“国家人工智能安全委员会”,并将制定 “2018 年国家安全委员会人工智能法”。

2、欧盟和英国:关注人工智能对隐私、就业及伦理影响

2018 年 3 月 27 日,欧洲政治战略中心发布《人工智能时代:确立以人为本的欧 洲战略》

3、俄罗斯、以色列、印度:重点关注人工智能国防领域应用以 及对军事安全影响

4、加拿大、日本、韩国、新加坡:侧重人工智能人才培养、技 术研发和产业推进等,对人工智能安全关注较少

加拿大政府 2017 年 3 月推出了《泛加拿大人工智能战略》。

日本政府在 2016 年 1 月颁布了《第 5 期科学技术基本计划》。

韩国在 2005 年 1 月至 2017 年第三季度期 间,与人工智能相关的专利数量全球排名第三,仅次于美国和日本。

新加坡在 2017 年 5 月发布《新加坡人工智能战略》

(二) 主要国家人工智能安全法规政策制定情况

省略

(三) 国内外人工智能安全标准规范制定情况

1、IEEE正在开发人工智能伦理道德标准,规范人工智能安全设计。

2017 年 3 月,IEEE 在《IEEE 机器人与自动化》杂志发表 了名为“旨在推进人工智能和自治系统的伦理设计的 IEEE 全球倡议 书”。

目前,IEEE 工作组正在开发 IEEE P7000 系列中涉及道德规范的伦理标准。

2、ISO/IEC成立人工智能可信研究组,开展人工智能安全标准研究。

3、我国成立国家人工智能标准化总体组与专家咨询组,加强人工智能安全标准研制工作。

(四) 国内外人工智能安全技术手段建设情况

1、2016 年 10 月,英国下议院科学和技术委 员会发布《机器人技术和人工智能》报告,呼吁政府应该对人工智能 进行监管。

2、大疆科技 通过事前环节的实名登记,实现所有无人机的实名使用,确保使用者 有据可查。

(五) 国内外人工智能重点应用的安全评估情况

1、自动驾驶的安全测试验证受到各国高度重视,但未形成统一安全 标准和评价体系。

2016 年 9 月 20 日,美国交通运输部颁布《联邦自 动驾驶汽车政策》。

2018 年 4 月 12 日,我国工信部、公安部、交通部联合发布《智能网联汽车道 路测试管理规范(试行)》

2、工业机器人相关安全标准较为完备,但智能服务机器人安全标准体系和评估能力尚待完善。

ISO/TC299/WG2 完成了服务机器人领域第一个安全标准——ISO 13482:2014 《个人护理机器人的安全要求》。

2017 年 1 月,国家发改委、工信部、国标委、认监委等部门联合发布了《家用/商用服务机器人安全及 EMC 认证实施 规则》。

(六) 国内外人工智能人才队伍建设情况

1、清华、 南开等多所 985 高校成立人工智能研究院。

2 、2018 年 7 月,清华、南 大、西交大等 26 所高校联合签署《关于设置人工智能专业建议书》, 申请设立人工智能本科专业。

3、目前,人工智能领域学术能力排在世界前 20 的学校中,美国占据 14 所,排名前八个席位的都为美国所占据。

4、截止 2017 年 6 月,美国产业人才总量约是中国的两 倍,美国 1078 家人工智能企业约有 78000 名员工,中国 592 家公司 中约有 39000 位员工。

5、我国 深人工智能从业者占比与美国差距明显(十年以上从业者占比 38.7%,而美国是 71.5%20)。

(七) 国内外人工智能产业生态培育情况

1、国内人工智能产业投资和技术研究主要集中在应用层环节,在 自动驾驶、计算机视觉、语音识别等应用领域形成一定优势,甚至部 分产业处于国际领先水平。

2、我国人工智能基础层发展相对缓慢,缺少重大原创成果, 在基础理论、核心算法以及关键设备、高端芯片等方面差距较大,尽 管涌现出寒武纪、地平线等优秀创业公司,并已形成成熟产品,但同 国外英伟达、谷歌等巨头相比差距明显,尚难以取得市场竞争主导权。

3、牛津 大学研究报告提出“国家人工智能潜力指数(AIPI)”,中国产业生态 位居世界第二,但得分仅为美国的四分之一。

五、 人工智能安全发展建议

(一) 加强自主创新,突破共性关键技术

因此,需要从云计 算、大数据和机器学习等关键通用技术研究入手,破解基础安全风险。一方面,立足自主,以传感器、智能芯片、基础算法等重点技术安全 可控发展为目标,实施重大技术攻关工程;另一方面,加大技术引进, 以开放务实的态度开展对外技术合作,实现技术消化吸收和再创新。

(二) 完善法律法规,制定伦理道德规范

(三) 健全监管体系,引导产业健康发展

(四) 强化标准引领,构建安全评估体系

(五) 促进行业协作,推动技术安全应用

(六) 加大人才培养,提升人员就业技能

(七) 加强国际交流,应对共有安全风险

(八) 加大社会宣传,科学处理安全问题