GAN(生成对抗网络)和IQA(图像质量评价能擦出什么样的火花呢?)简单聊一些近来published的论文

在图像质量评价领域奋斗了三年,感觉实在不容易。现在的目标是做一些相当开创性的工作,而不是刻意是follow别人的工作,当然,这很难,至今还没有实现,希望我能圆梦。

之前自己的博客有写过关于手工特征和深度学习做无参考图像质量评价的工作,包括Tone-mapped image,3D图像,自然图像,对比度失真图像。(加一句:屏幕图像和3D图像质量评价是我的老本行[1][2][3],已经换成了其他的目标了)。重新回忆一些图像质量评价吧。

图像质量评价,顾名思义,评价图像的视觉质量。是较好呢?好呢?一半呢?还是较差呢?/// 好的话究竟有多好呢?差的话究竟是多差呢?前面的判断属于绝对评价,后面的判断属于相对评价。众所周知,我们处在一个“相对的”世界里,自然而然绝对评价就不靠谱了,评价结果包含的噪声太大。在“相对的”图像质量评价中,就催生了第一类图像质量评价算法,全参考图像质量评价算法(Full reference image quality assessment): 把无失真的图像(reference image)当成是参考系,然后计算失真图像(distorted image)与参考系之间的距离(一般是用相似性)。半参考不想聊,好无聊。无参考图像质量评价算法类似,构建一个模型(或者学习一个模型),本身来讲,也可以把它看成是参考系,因为模型是通过大量的样本学习得到的,数学表达式无非就是model=f(samples)。

无参考图像质量算法中,之前用的最多的就是手工特征+机器学习算法,近几年用的比较多的就是深度学习了。深度学习给我的感觉就是把手工特征+机器学习算法彻底打压了,性能好,关注点也多。很久之前,我也在关注这一块,希望蹦出个idea来。用深度学习设计的图像质量评价算法大部分都是end-to-end了。而GAN又为IQA注入了新的思想。(有时间再写详细一点,论文也都很容易懂)

本博客简单介绍4篇论文,包括:2018CVPR: Hallucinated-IQA:No-reference imagequality assessment via adversarial learning;2018AAAI: RAN4IQA:Restorative adversarial nets for no-referenceimage quality assessment. 北京大学;2018CVPR: Blind predicting similar quality mapfor image quality assessment. 中国传媒大学;2018ICASSP:VR IQA NET: deep virtual realityimage quality using adversarial learning.

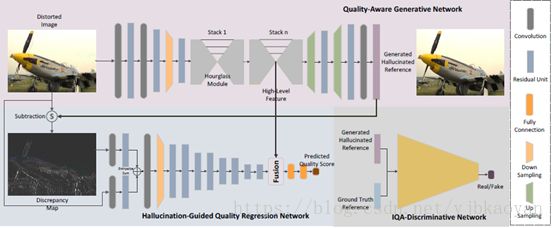

论文1:2018CVPR: Hallucinated-IQA

核心思想:

生成网络:输入为失真图像,通过卷积和反卷积,生成一张复原图(Hallucinated image,假性参考图)。

判别网络:判断生成的复原图和参考图像是否属于参考图像。

图像质量预测网络:输入是失真图,以及失真图与复原图的残差图。

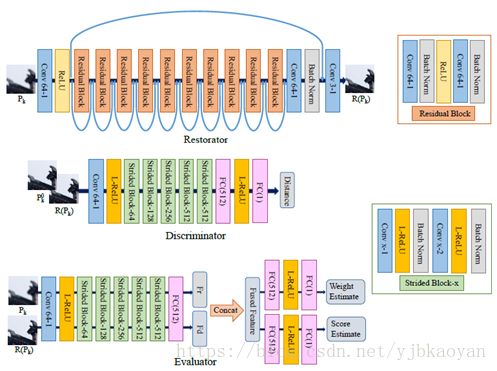

论文2:2018AAAI: RAN4IQA本文的idea和上一篇论文2018CVPR框架类似,也是先对失真图像进行恢复,并将复原图像和失真图像作为输入,输出失真图像的质量分数。(这是patch based)

论文3:2018CVPR:

Idea: 通过U-net生成一张quality map.

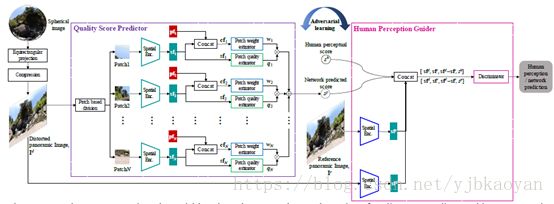

论文4:2018ICASSP:VR IQA NET:

感觉这个工作有点玄学:adversarial learning用于判断输入的分数是机器预测的分数还是主观分数。

[1] Y. Fang, J. Yan, et. al. No reference quality assessment for screen content images with both local and global feature representation, IEEE Transactions on Image Processing, vol. 27, no. 4, pp. 1600-1610, 2018[2] Y. Fang, J. Yan, et. al. Objective quality assessment of screen content images by uncertainty weighting, IEEE Transactions on Image Processing, vol. 26, no. 4, pp. 2016-2027, 2017

[3] Y. Fang, J. Yan, et. al. No reference quality assessment for stereoscopic images by statistic features, QoMEX, 2017