Scrapy+splash抓取js生成的数据

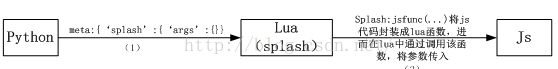

一、python、lua、js间参数传递原理

抓取过程是python调用splash的lua脚本,lua中又调用了js代码实现相关页面内容的提取及js动作的模拟。在python中通过meta的splash中的args设置python将要传入splash的参数信息,在splash中通过splash:jsfunc的接口封装js代码成为lua函数,进而将lua中的参数传入js代码中。

(1)具体形式如下:

meta = {

'splash':{

'endpoint':'execute',

'args':{'lua_source':script,'pagenum':i+1}

}

}

(2)具体形式如下:

local gotopage = splash:jsfunc([[

function(x) {

$('#goInt').val(x);

$('#contenttable:nth-child(4) td:nth-child(8) input').click();

}

]])

gotopage(3)

二、总结在lua中jquery的调试方法

Lua脚本中所含的js代码,是在splash引擎中执行的,相关打印信息无法执行显示,为了保证jquery代码的正确性,可以对jquery代码进行单独调试。将要抓取的网页单独保存,在网页源码中导入jquery-1.4.2.min.js,在中写入jquery代码,刷新页面就可以对jquery单独调试,调试通过后可以将jquery代码复制进lua中。

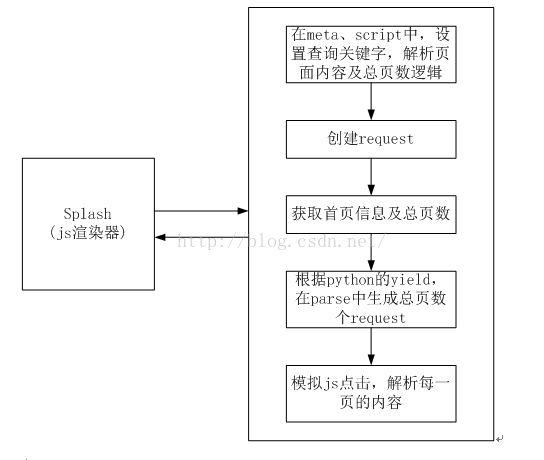

三、以国家药品食品监督管理局网站的数据抓取为例,总结splash的抓取流程,本流程中实现了翻页的动作,分别对翻页的每一页进行操作

首先、在start_requests方法中,对start_url集合中的url,加入meta信息,重新创建request。 在request中植入的js脚本中,不能出现操作本地文件的代码,否则会报http的400状态码,提示该请求不合法,因此保存抓取结果的持久化操作,只有在python的scrapy 的parse中进行;

其次、第一次会返回首页信息及总页数信息,在根据得到的总页数信息,在parse中创建总页数个request,每个request的splash中接收当前的页数,通过模拟跳转到该页进行当前页内容的获取。

附:模拟点击“下一页”,直到“下一页”按钮失效,虽然能将内容抓到,但是在请求中无法通过写文件进行保存,写文件代码会被视为不合法的request请求。

抓取的数据格式如下:

抓取的数据格式如下:

1.北京东邵渠食品厂(SC11711281711709)"content.jsp?tableId=120&tableName=TABLE120&tableView=食品生产许可获证企业(SC)&Id=594"

2.北京顺利康食品有限公司(SC12411132511803)"content.jsp?tableId=120&tableName=TABLE120&tableView=食品生产许可获证企业(SC)&Id=595"

3.贵港市新鑫米业有限公司(SC10145080300039)"content.jsp?tableId=120&tableName=TABLE120&tableView=食品生产许可获证企业(SC)&Id=596"

4.北京尚世超越食品有限责任公司(SC13111130311819)"content.jsp?tableId=120&tableName=TABLE120&tableView=食品生产许可获证企业(SC)&Id=597"

5.北京溪漫昌兴饮用水有限公司