论文笔记《Deep Cosine Metric Learning for Person Re-Identification》

论文地址:https://arxiv.org/abs/1812.00442v1

代码地址:https://github.com/nwojke/cosine_metric_learning

这篇论文是deep sort多目标跟踪模型中行人外观特征模型的来源,该论文主要是用来做person Re-ID研究的

Abstract:

度量学习(从相同Person 提取的两个特征可能比来自不同Person提取的特征更接近),本文提出了一种学习这种特征空间的方法,其中 cosine similarity(通过简单的传统softmax分类方案的重新参数化)得到有效优化。在测试时,可以从网络剥离最终分类层,以利用cosine similarity metric来促进对未知个体的最近邻查询。这种方法提供了直接度量学习目标的简单替代方法,例如过去 siamese networks 使用 sophisticated pair 或者 triplet sampling strategies 。该方法在两个大规模的行人识别数据集上进行评估,其中总体上获得了有竞争力的结果。 特别是,与使用triplet loss训练的网络相比,我们在测试集上实现了更好的泛化。

1. Introduction

Person Re-identification是视频监控中的常见任务,其中给定的查询图像(query)用于搜索可能包含同一人的大型图像库(gallery)。由于gallery图像通常是使用不同的相机在不同的时间点拍摄的,因此系统必须处理姿势变化、不同的光照条件和不断变化的背景。此外,在这种情况下禁止直接身份分类,因为在测试时收集的图库中的个人不包含在训练集中。相反,Re-id问题通常在度量学习框架内得到解决。这里的目标是学习一个特征表示 -----适用于在测试为图像和身份上执行最近邻查询提供特征。理想地,学习的特征表示应该对上述干扰条件不变,同时遵循预定的度量,其中特征相似性对应于人的身份。

度量学习将相似性度量直接编码到训练目标中,基于分类的方法在训练集中的一组身份上训练分类器,然后使用网络的底层特征表示在测试时执行最近邻查询。在此设置中,度量学习通常会减少到最小化同一类的样本之间的距离,并强制不同类别的样本之间的距离[3,8]。精心建立的分类器可以与指导度量学习目标类似的方式减少类内方差并增加类间方差。受此讨论的启发,本文的主要贡献是度量学习和分类的统一。更具体地说,我们提出了一个重新参数化的softmax分类器,该分类器将度量学习目标直接编码到分类任务中。

2. Related Work

特定于分类任务的分类器通常预先在ImageNet [11]或MS COCO [16]之上进行训练,学习的通用特征表示。 但是无法保证一个网络(使用softmax分类器训练)的表征可以直接用于图像检索任务,例如 person re-identification,因为该表示不一定遵循用于最近邻居查询的某个(已知)度量。但是,在面部验证和人员重新识别方面也存在若干成功应用[24,31,37]。在这种情况下,训练softmax分类器以区分训练集中的身份。当训练完成时,分类器被剥离网络,并且使用网络的最后一层上特征的cosine similarity or Euclidean distance来进行距离查询。但是,如果不能直接使用特征表示,则可以在后处理步骤[10,15]中找到度量子空间。

深度度量学习方法将相似性概念直接编码到训练目标中。最突出的方法是contrastive loss [3] 和 triplet loss[28]。contrastive loss最小化同一类样本之间的距离,并强制不同类别的样本之间的差距,这种损失将同一类的所有样本推向表示空间中的单个点,并惩罚不同类之间的重叠。triplet loss放松了对比公式,只要保留边距,样品就可以更自由地移动。给定锚点,同一类的点和不同类的点,triplet loss迫使到同一类的点的距离小于到不同类的点的距离加上余量。triplet loss 可以从三元组中选择包含关于可以区分身份的相关结构的很少信息。如果每个批次中都包含了错误的难以区分的对/三元组,则优化器要么无法学习任何有意义的内容,要么根本不会收敛。制定有效的抽样策略可能是一项复杂而耗时的任务,因此限制了triplet的实际适用性。

与contrastive loss 和triplet loss 相关的第二个问题源于不同类别样本之间强制执行的硬边界。硬边缘导致非光滑的目标函数更难以优化,因为在每次迭代时只向优化器提供了很少的示例,并且不同批次之间可能存在强烈的分歧[19]。除了siamese network,magnet loss [19]已被制定为克服许多相关问题的替代方案。损失被表示为正确的类和所有其他类之间的负对数似然比,但也强制不同类的样本之间的余量。通过对整个类分布而不是单个对或三元组进行操作,magnet loss 可能会更快地收敛并导致整体更好的解决方案。 center loss [29]的开发是为了将分类和度量学习结合起来。该方法采用softmax分级机与α的组合,通过惩罚样本到其类平均值的距离来强制紧凑类的附加术语。标量超参数可以平衡两种损失。实验表明,这种分类和度量学习的联合表达产生了最先进的结果。

3. Standard Softmax Classifier

其中 r = f(x),是与分类器联合训练的参数化编码器网络的基础特征表示。

图2:图(a)显示了三个高斯类条件密度(等值线)和相应的决策边界(虚线)。

图(b)显示了条件类概率(颜色编码)和一组假设的训练样例。softmax分类器直接模拟后验概率,而不构造高斯密度。通过训练交叉熵损失,样本被推离决策边界,但不一定朝向类平均值。

曲线(c)示出了针对三个类的cosine softmax classifier 的后验类概率(颜色编码)和决策边界(白线)。在训练期间,将所有样本从决策边界推向其参数化的类平均方向(由箭头指示)。

4. Cosine Softmax Classifier

我们通过很少的调整,可以修改标准softmax分类器以在表示空间中生成紧凑的簇。首先,必须将L2归一化应用于编码器网络的最后一层,以确保这个特征表示为单位长度。其次,权重也必须标准化为单位长度 ,然后,可以用下式表示 cosine softmax分类器:

其中 κ 是自由缩放参数。与标准公式(1)相比,这种参数化的参数减少了C - 1,因为偏差项bk已被删除。训练本身可以像往常一样使用交叉熵损失来执行,因为余弦softmax分类器与标准公式相比仅仅是参数化的变化。

为了理解为什么这个参数化强制表示空间上的余弦相似性,观察对数概率与训练样本和参数化类平均方向之间的余弦相似性成正比。通过最小化交叉熵损失,将示例从决策边界推向其参数化均值,如图2c所示。因此,参数向量wk成为情况k中所有样本的替代。缩放参数κ控制条件类概率的形状,如图3所示。较低的值对应于具有更广泛支持的更平滑的功能。高κ值导致条件类概率在决策边界周围呈盒状。这对错误分类的示例施加了更大的惩罚,但同时为样本在其相应类所占据的表示空间区域中自由移动留下了更多空间。在这方面,在这方面,K也有类似之处直接度量学习目标中的边际参数角色。当比例保留为自由参数时,优化程序会逐渐增加其值,因为类之间的重叠会减少。通过使权重衰减规范化,可以强制实施不同类别样本之间的差距。

图3:具有三个类的一维问题中的自由缩放参数κ的图示。条件类概率显示为彩色函数。 优化的样本位置在y = 0时可视化为星形。低κ值(a)导致更平滑的函数和更广泛的支持,使得样品被推入紧密簇中。对于高值(b),形状变为盒状,允许样本在类所占据的区域内更自由地移动。

5. Evaluation

5.1. Network Architecture

在我们的实验中使用的网络架构相对较浅,以允许快速训练和推断,例如,用于基于外观的对象跟踪的相关任务中的应用[30]。

输入图像重新缩放为128×64,并以RGB色彩空间呈现给网络。 在层Dense 10提取长度为128的全局特征向量之前,一系列卷积层将特征映射的大小减小到16×8。最终的L2归一化将特征变为单元超球面,用于应用余弦softmax分类器。该网络包含几个残差块,这些块遵循He等人提出的预激活布局[7]。该设计遵循wide residual networks [33]的思想:所有卷积大小为3×3,最大池化由步幅2的卷积代替。当特征图的空间分辨率降低时,则相应地增加通道的数量以避免瓶颈。Dropout and batch normalization are used as means of regularization. Exponential linear units [4] are used as activation function in all layers. 请注意,与当前更深层架构的趋势相比,该网络一共15层(包括每个残差块中的两个卷积层)网络相对较浅[7]。做出这一决定有以下两个原因。 首先,网络架构设计用于person reID和在线人员跟踪的应用[30],后者需要快速计算外观特征。In total, the network has 2,800,864 parameters and one forward pass of 32 bounding boxes takes approximately 30 ms on an Nvidia GeForce GTX 1050 mobile GPU。因此,即使在低成本硬件上,该网络也非常适合在线跟踪。 其次,专门为人员REID设计的架构[13,1]特别强调中级特征。因此,在特征图仍然提供足够空间分辨率的点处添加dense层。

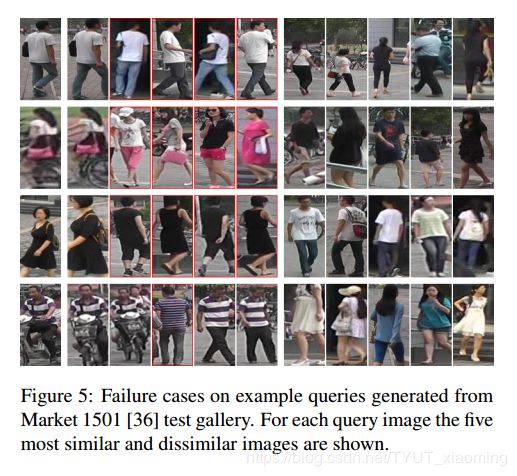

5.4. Results

本节报告的结果是通过使用Adam [9]对网络进行固定数量的100,000次迭代来建立的。 学习率设定为1×10-3。从图4中可以看出,此时所有配置都完全收敛。网络正规化,权重衰减为1×10-8,残差单位内的丢失概率为0.4。余弦softmax标度κ作为优化器调整的自由参数,但是以1×10-1的权重衰减进行正则化。批量大小固定为128张图像。在magnet loss和triplet loss 的情况下使用欧几里德距离建立图库排名,而对于softmax使用余弦相似性分类。为了增加训练集中的可变性,输入图像已被随机翻转,但未执行随机调整大小或裁剪。

6. Conclusion

我们提出了传统softmax分类器的重新参数化,当训练识别训练集中的个体时,该分类器在表示空间上强制执行余弦相似性。由于该属性,可以在训练之后剥离分类器,并且可以使用最近邻搜索来执行对看不见的身份的查询。 因此,所提出的方法为度量学习提供了一种简单,易于应用的替代方案,其不需要复杂的采样策略。