谷歌Coral USB Accelerator最新安装使用指南

谷歌Coral USB加速器是一种USB设备,提供Edge TPU作为计算机的协处理器。 当连接到Linux,Mac或Windows主机时,它可以加快机器学习模型的推理速度。

你需要做的就是在连接USB Accelerator的计算机上下载Edge TPU运行时和TensorFlow Lite库。 然后,使用示例应用程序执行图像分类。

系统要求:

具有以下操作系统之一的计算机:

·Linux Debian 6.0或更高版本,或其任何派生版本(例如Ubuntu 10.0+),以及x86-64或ARM64系统架构(支持Raspberry Pi,但我们仅测试了Raspberry Pi 3 Model B +和Raspberry Pi 4)

·安装了MacPorts或Homebrew的macOS 10.15

·Windows 10

-一个可用的USB端口(为获得最佳性能,请使用USB 3.0端口)

-Python 3.5、3.6或3.7

操作流程

一、安装Edge TPU runtime

需要Edge TPU runtime才能与Edge TPU通信。 你可以按照以下说明在主机,Linux,Mac或Windows上安装它。

1、Linux系统

1)将官方提供的Debian package添加到你的系统中:

2)安装Edge TPU runtime:

使用随附的USB 3.0电缆将USB Accelerator连接到计算机。 如果已插入,请将其删除并重新插入,以使新安装的udev规则生效。

※ 以最大工作频率安装(可选)

上面的命令将安装Linux的标准Edge TPU runtime,该运行时将以默认时钟频率运行设备。 你可以安装runtime版本,该版本以最大频率(默认值的2倍)运行。 这样可以提高推理速度,但同时也会增加功耗,USB Accelerator会变得非常热。

如果不确定应用程序是否需要提高性能,则应使用默认的工作频率。 否则,你可以如下安装最大频率运行时:

sudo apt-get install libedgetpu1-max

你不能同时安装两个版本的运行时,但是可以通过简单地安装备用运行时来进行切换,如上所示。

注意:使用最大频率操作设备时,USB Accelerator上的金属可能会变得非常烫手。 这可能会导致烧伤。 为避免受伤,请在以最大频率操作设备时将其放在遥不可及的地方,或者使用默认频率。

2、Mac系统

1)下载并解压缩Edge TPU runtime

2)安装Edge TPU runtime

安装脚本将询问你是否要启用最大工作频率。 以最大工作频率运行会提高推理速度,但也会增加功耗,并使USB Accelerator变得非常热。 如果不确定你的应用程序需要提高性能,则应键入“ N”以使用默认工作频率。

你可以在官方提供的USB Accelerator数据表中阅读有关性能设置的更多信息。

现在,使用随附的USB 3.0数据线将USB Accelerator连接到计算机。然后继续安装TensorFlow Lite库。

3、Windows系统:

1)单击以下载官方提供的最新压缩包。解压缩ZIP文件,然后双击其中的install.bat文件。

将打开一个控制台窗口以运行安装脚本,它将询问你是否要启用最大工作频率。 以最大工作频率运行会提高推理速度,但也会增加功耗,并使USB Accelerator变得非常热。 如果不确定你的应用程序需要提高性能,则应键入“ N”以使用默认工作频率。

你可以在Google官方提供的Coral USB Accelerator数据表中阅读有关性能设置的更多信息。

现在,使用随附的USB 3.0数据线将USB Accelerator连接到计算机。

二、安装TensorFlow Lite库

有多种安装TensorFlow Lite API的方法,但是要开始使用Python,最简单的选择是安装tflite_runtime库。 该库提供了使用Python运行推理所需的最基本代码(主要是Interpreter API),从而节省了大量磁盘空间。

要安装它,请遵循TensorFlow Lite Python快速入门,然后在运行pip3 install命令后返回此页面。

三、使用TensorFlow Lite API运行模型

现在可以在Edge TPU上进行推理了。 使用示例代码和模型执行图像分类。

1)从GitHub:下载示例模型

2)下载 bird classifier模型,标签文件和鸟类照片

3)使用鸟类的照片运行图像分类器

根据主机系统以及是否使用USB 3.0连接,推断速度可能会有所不同。

要运行其他类型的神经网络,可查看官方的示例项目,包括执行实时对象检测,姿势预测,关键短语检测,设备上转移学习等的示例。

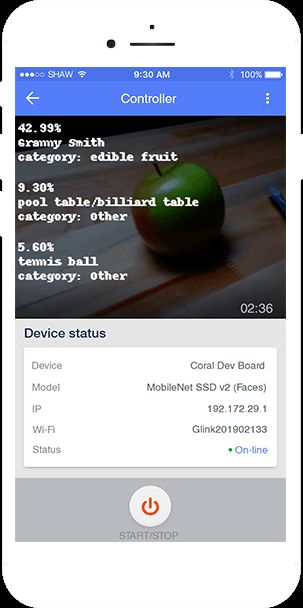

支持Google Edge TPU的AI软硬件

Gravitylink引力互联研发的Model Play与Tiorb AIX(钛灵AIX)可完美支持Edge TPU。AIX是一款集计算机视觉与智能语音交互两大核心功能为一体的人工智能硬件,内置AI加速芯片(Coral Edge TPU/intel movidius)支持边缘深度学习推理,为用户的各种疯狂创意提供可靠的性能支持。

Model Play是面向全球开发者的AI模型资源平台,内置多样化AI模型,与钛灵AIX结合,基于Google开源神经网络架构及算法,构建自主迁移学习功能,无需写代码,通过选择图片、定义模型和类别名称即可完成AI模型训练。