源码分析 Canal 系列开始了,一个全新的系列,即能探讨 canal 本身的实现原理,也是笔者源码阅读技巧的展示。

1、应用场景

提到 Canal,大家应该都能想到这是一个用于解析 MySQL binlog 日志的工具,并将 MySQL 数据库中数据同步到其他存储介质中,例如 Elasticsearch。

即 Canal 一个非常常用的使用场景:数据异构,一种更高级别的数据读写分离架构设计方法。

随着业务不断的发展,企业发展到一定阶段,发现单体的关系型数据库已无法支撑业务高速发展带来数据不断累积的压力,从而会诞生出一种设计架构:分库分表。分库分表对缓解单库数据库压力确实是一种非常好的解决方案,但又衍生出另外一种困境,关联查询不友好,甚至跨库JOIN就更加如此。

举例说明如下: 例如一个订单系统,通常有两类用户需要去查询订单,一类是顾客,一类是商家,在对数据库进行分库分表时,如果以顾客(buy_id)进行分库的话,同一个商家的订单数据会分布在不同的库中,如果以商家(shop_id)进行分库的话,同一个用户购买的所有订单数据将会分布子啊不同的库中,这样进行关联查询,就必然需要跨库进行join,其成本都会偏高。而且上面的场景只能满足一方的需求,那如何是好呢?

Canal 这个时候就闪亮登场了,在电商设计中,其实商家、顾客会被拆分成两个不同的服务,我们可以为两个不同的服务搭建不同的数据库集群,我们可以用户订单库、商家订单库进行分库,以用户订单库为主库,当用户在订单系统下单后,数据进入到用户订单库中,然后可以通过 canal 监听数据库的binlog日志,然后将数据再同步到商家订单库,而用户订单库以用户ID为维度进行分库,商家订单库以商家ID做分库,完美解决问题。

2、架构设计原理

在了解到 Canal 的基本使用场景后,我们通过 canal 官方文档,去探究一下其核心架构设计理念,以此打开进入 Canal 的神秘世界中。

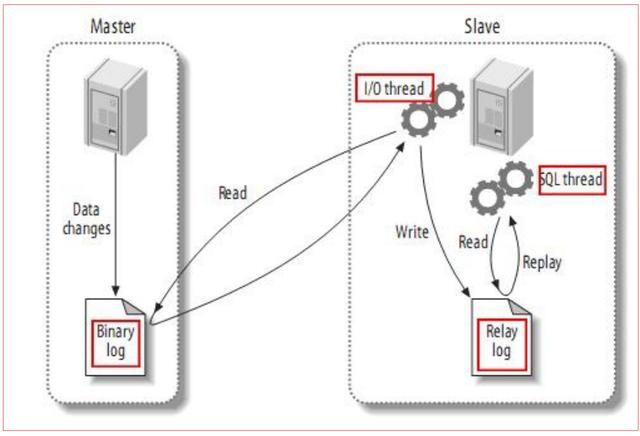

首先我们简单看一下 MySQL 的主从同步原理:

从上面的图中可以看成主从复制主要分成三个步骤:

- master将改变记录到二进制日志(binary log ) 中( 这些记录叫做二进制日志事件,binary log events,可以通过show binlog events进行查看)

- slave将master的binary log events拷贝到它的中继日志(relay log)

- slave重做中继日志中的事件,将改变反映它自己的数据。

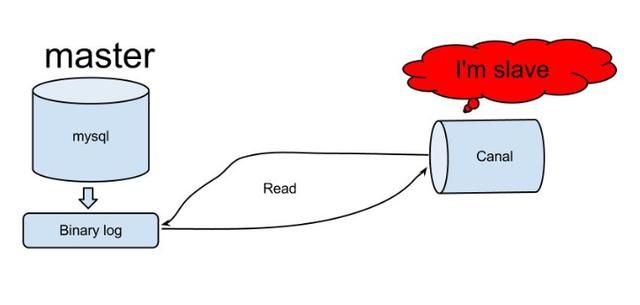

基于 MySQL 这种数据同步机制,那 Canal 的设计目标主要就是实现数据的同步,即数据的复制,从上面的图自然而然的想到了如下的设计:

原理相对比较简单:

- canal 模拟 mysql slave 的交互协议,伪装自己为 mysql slave,向 mysql master 发送 dump 协议

- mysql master 收到 dump 请求,开始推送 binary log 给 slave (canal)

- canal解析 binary log 对象(原始为byte流)

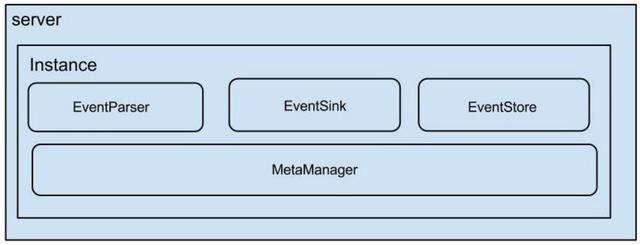

接下来我们来看一下 Canale 的整体组成部分:

说明:

- server代表一个canal运行实例,对应于一个jvm

- instance对应于一个数据队列 (1个server对应1..n个instance)

instance模块:

- eventParser (数据源接入,模拟slave协议和master进行交互,协议解析)

- eventSink (Parser和Store链接器,进行数据过滤,加工,分发的工作)

- eventStore (数据存储)

- metaManager (增量订阅&消费信息管理器)

这些组件我暂时不打算深入去研究,因为在目前这个阶段我自己也不清楚,但这个是我后续需要学习研究的重点。

3、在 IntelliJ IDEA 中运行 Canal Demo

在 Linux 环境中安装 canal 比较简单,大家可以安装官方手册一步一步操作即可,在这里我就不重复介绍,本节主要的目的是希望在开发工具中运行 Canal 的 Demo,以便后续在研究源码的过程中遇到难题时可以进行 Debug。

温馨提示:大家在学习过程中,可以根据官方文档先安装一遍 canal,对理解 Canal 的核心组件有着非常重要的帮助。

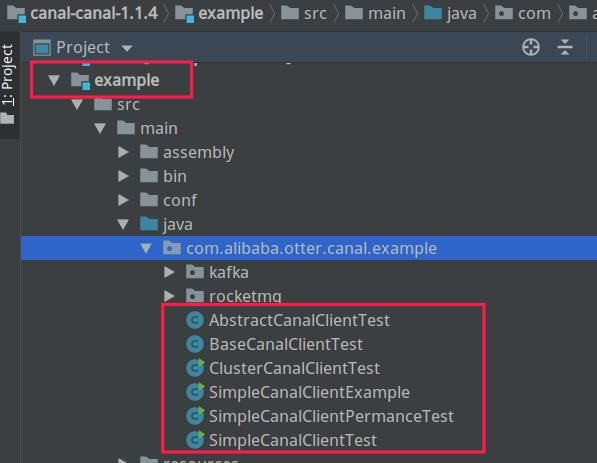

首先先从 canal 源码中寻找官方提供的 Demo,其示例代码在 example 包中,如下图所示:

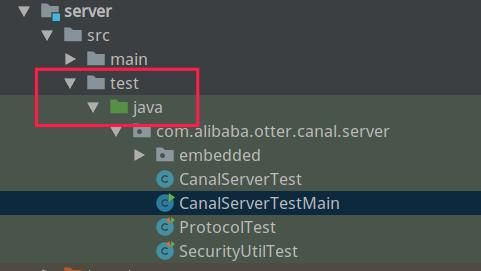

但是另外稍微遗憾的是 canal 提供提供的示例代码中只包含了 client 端相关的代码,并没有包含服务端(server),故我们将目光放到其单元测试中,如下图所示:

接下来我根据官方的一些提示,结合自己的理解,编写出如下测试代码,在 IDEA 开发工具中实现运行 Canal 相关的 Demo。下面的代码已通过测试,可直接使用。

1、Canal Server Demo

package com.alibaba.otter.canal.server;

import com.alibaba.otter.canal.instance.core.CanalInstance;

import com.alibaba.otter.canal.instance.core.CanalInstanceGenerator;

import com.alibaba.otter.canal.instance.manager.CanalInstanceWithManager;

import com.alibaba.otter.canal.instance.manager.model.Canal;

import com.alibaba.otter.canal.instance.manager.model.CanalParameter;

import com.alibaba.otter.canal.server.embedded.CanalServerWithEmbedded;

import com.alibaba.otter.canal.server.netty.CanalServerWithNetty;

import java.net.InetSocketAddress;

import java.nio.ByteBuffer;

import java.util.Arrays;

public class CanalServerTestMain {

protected static final String ZK\_CLUSTER\_ADDRESS = "127.0.0.1:2181";

protected static final String DESTINATION = "example";

protected static final String DETECTING\_SQL = "select 1";

protected static final String MYSQL\_ADDRESS = "127.0.0.1";

protected static final String USERNAME = "canal";

protected static final String PASSWORD = "canal";

protected static final String FILTER = ".\\\\\*\\\\\\\\\\\\\\\\..\\\\\*";

/\*\* 默认 500s 后关闭 \*/

protected static final long RUN\_TIME = 120 \* 1000;

private final ByteBuffer header = ByteBuffer.allocate(4);

private CanalServerWithNetty nettyServer;

public static void main(String\[\] args) {

CanalServerTestMain test = new CanalServerTestMain();

try {

test.setUp();

System.out.println("start");

} catch (Throwable e) {

e.printStackTrace();

} finally {

System.out.println("sleep");

try {

Thread.sleep(RUN\_TIME);

} catch (Throwable ee) {

}

test.tearDown();

System.out.println("end");

}

}

public void setUp() {

CanalServerWithEmbedded embeddedServer = new CanalServerWithEmbedded();

embeddedServer.setCanalInstanceGenerator(new CanalInstanceGenerator() {

public CanalInstance generate(String destination) {

Canal canal = buildCanal();

return new CanalInstanceWithManager(canal, FILTER);

}

});

nettyServer = CanalServerWithNetty.instance();

nettyServer.setEmbeddedServer(embeddedServer);

nettyServer.setPort(11111);

nettyServer.start();

// 启动 instance

embeddedServer.start("example");

}

public void tearDown() {

nettyServer.stop();

}

private Canal buildCanal() {

Canal canal = new Canal();

canal.setId(1L);

canal.setName(DESTINATION);

canal.setDesc("test");

CanalParameter parameter = new CanalParameter();

//parameter.setZkClusters(Arrays.asList(ZK\_CLUSTER\_ADDRESS));

parameter.setMetaMode(CanalParameter.MetaMode.MEMORY);

parameter.setHaMode(CanalParameter.HAMode.HEARTBEAT);

parameter.setIndexMode(CanalParameter.IndexMode.MEMORY);

parameter.setStorageMode(CanalParameter.StorageMode.MEMORY);

parameter.setMemoryStorageBufferSize(32 \* 1024);

parameter.setSourcingType(CanalParameter.SourcingType.MYSQL);

parameter.setDbAddresses(Arrays.asList(new InetSocketAddress(MYSQL\_ADDRESS, 3306),

new InetSocketAddress(MYSQL\_ADDRESS, 3306)));

parameter.setDbUsername(USERNAME);

parameter.setDbPassword(PASSWORD);

parameter.setSlaveId(1234L);

parameter.setDefaultConnectionTimeoutInSeconds(30);

parameter.setConnectionCharset("UTF-8");

parameter.setConnectionCharsetNumber((byte) 33);

parameter.setReceiveBufferSize(8 \* 1024);

parameter.setSendBufferSize(8 \* 1024);

parameter.setDetectingEnable(false);

parameter.setDetectingIntervalInSeconds(10);

parameter.setDetectingRetryTimes(3);

parameter.setDetectingSQL(DETECTING\_SQL);

canal.setCanalParameter(parameter);

return canal;

}}

2、Canal Client Demo

package com.alibaba.otter.canal.example;

import java.net.InetSocketAddress;

import java.util.List;

import com.alibaba.otter.canal.client.CanalConnectors;

import com.alibaba.otter.canal.client.CanalConnector;

import com.alibaba.otter.canal.common.utils.AddressUtils;

import com.alibaba.otter.canal.protocol.CanalEntry;

import com.alibaba.otter.canal.protocol.Message;

import com.alibaba.otter.canal.protocol.CanalEntry.Column;

import com.alibaba.otter.canal.protocol.CanalEntry.EventType;

public class SimpleCanalClientExample {

public static void main(String\[\] args) {

// 创建链接

CanalConnector connector = CanalConnectors.newSingleConnector(new InetSocketAddress(AddressUtils.getHostIp(),

11111), "example", "", "");

int batchSize = 1000;

int emptyCount = 0;

try {

connector.connect();

connector.subscribe(".\*\\\\..\*");

connector.rollback();

int totalEmptyCount = 3000;

while (emptyCount < totalEmptyCount) {

Message message = connector.getWithoutAck(batchSize); // 获取指定数量的数据

long batchId = message.getId();

int size = message.getEntries().size();

if (batchId == -1 || size == 0) {

emptyCount++;

System.out.println("empty count : " + emptyCount);

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

}

} else {

emptyCount = 0;

// System.out.printf("message\[batchId=%s,size=%s\] \\n", batchId, size);

printEntry(message.getEntries());

}

connector.ack(batchId); // 提交确认

// connector.rollback(batchId); // 处理失败, 回滚数据

}

System.out.println("empty too many times, exit");

} finally {

connector.disconnect();

}

}

private static void printEntry(List entrys) {

for (CanalEntry.Entry entry : entrys) {

if (entry.getEntryType() == CanalEntry.EntryType.TRANSACTIONBEGIN || entry.getEntryType() == CanalEntry.EntryType.TRANSACTIONEND) {

continue;

}

CanalEntry.RowChange rowChage = null;

try {

rowChage = CanalEntry.RowChange.parseFrom(entry.getStoreValue());

} catch (Exception e) {

throw new RuntimeException("ERROR ## parser of eromanga-event has an error , data:" + entry.toString(),

e);

}

CanalEntry.EventType eventType = rowChage.getEventType();

System.out.println(String.format("================> binlog\[%s:%s\] , name\[%s,%s\] , eventType : %s",

entry.getHeader().getLogfileName(), entry.getHeader().getLogfileOffset(),

entry.getHeader().getSchemaName(), entry.getHeader().getTableName(),

eventType));

for (CanalEntry.RowData rowData : rowChage.getRowDatasList()) {

if (eventType == CanalEntry.EventType.DELETE) {

printColumn(rowData.getBeforeColumnsList());

} else if (eventType == EventType.INSERT) {

printColumn(rowData.getAfterColumnsList());

} else {

System.out.println("-------> before");

printColumn(rowData.getBeforeColumnsList());

System.out.println("-------> after");

printColumn(rowData.getAfterColumnsList());

}

}

}

}

private static void printColumn(List columns) {

for (Column column : columns) {

System.out.println(column.getName() + " : " + column.getValue() + " update=" + column.getUpdated());

}

} }

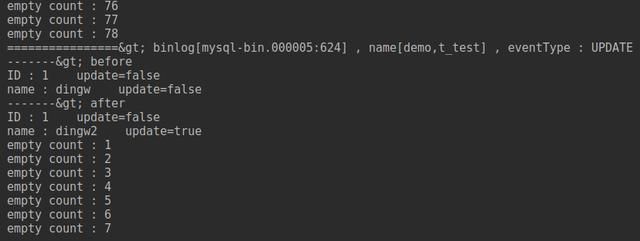

运行 client 的效果如下图所示:

在数据库中变更一条数据,以便产生新的binlog日志,其输出结果如下:

能在 IDEA 中搭建并运行 Demo,是我们踏入 canal 的第一步,后续将根据官方文档中的内容为提纲,尝试逐步解开 canal 的实现原理,以便更好的指导实践。

本文就介绍到这里了,欢迎大家留言与笔者共同交流探讨。三连是对我最大的鼓励与支持(点赞、评论、转发)。

最近整理了源码案例免费分享给大家,希望能帮助到您面试前的复习且找到一个好的工作,也节省大家在网上搜索资料的时间来学习,也可以关注我一下以后会有更多干货分享。

添加小助手VX:xuanwo008 即可获取