Hadoop 3.2.0 安装---安装Hadoop

1.下载最新的Hadoop安装包

https://www.apache.org/dyn/closer.cgi/hadoop/common/hadoop-3.2.0/hadoop-3.2.0.tar.gz

2.将安装包上传到linux服务器/usr/local/software/目录下

3.切换到该目录,解压hadoop安装包

#cd /usr/local/software/

#tar -zxvf hadoop-3.2.0.tar.gz

解压成功后进行hadoop的初始化配置

4. 进行服务器及Hadoop的初始化配置

4.1修改主机名

#vim /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=sjd

4.2 修改主机名和IP的映射关系

#vim /etc/hosts

192.168.182.128 sjd ###注意前面的IP地址为服务器的地址,可通过ifconfig查看

4.3 关闭防火墙

#systemctl status firewalld ###查看firewall服务状态

#firewall-cmd --state ###查看firewall的状态

### 开启

#service firewalld start

# ##重启

#service firewalld restart

###关闭

#service firewalld stop

4.4 配置Hadoop伪分布式需要修改5个配置文件

4.4.1配置hadoop

第一个:hadoop-env.sh

vim hadoop-env.sh

#第27行

export JAVA_HOME=/usr/java/jdk1.7.0_65

第二个:core-site.xml

fs.defaultFS

hdfs://itcast01:9000

hadoop.tmp.dir

/itcast/hadoop-2.4.1/tmp

第三个:hdfs-site.xml

dfs.replication

1

第四个:mapred-site.xml (mv mapred-site.xml.template mapred-site.xml)

mv mapred-site.xml.template mapred-site.xml

vim mapred-site.xml

mapreduce.framework.name

yarn

第五个:yarn-site.xml

yarn.resourcemanager.hostname

itcast01

yarn.nodemanager.aux-services

mapreduce_shuffle

4.4.2将hadoop添加到环境变量

#vim /etc/proflie

export HADOOP_HOME=/itcast/hadoop-3.2.0

export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

#source /etc/profile

4.4.3 格式化namenode(是对namenode进行初始化)

在/usr/local/software/hadoop-3.2.0目录下创建tmp文件夹

#mkdir /usr/local/software/hadoop-3.2.0/tmp

格式化namenode

#hdfs namenode -format (hadoop namenode -format)

当执行结束后,查看打印successfully formatted 则说明格式化成功。

@@@@@@@注意@@@@@@@@

1)hadoop3.x升级jdk为1.8+所以在格式化namenode时若jdk版本不匹配则会报错

2)如果没有修改自己的IP和主机名的映射,在namenode格式化时会报错如下,需参见4.2描述中,配置本机主机名和IP映射关系。

5 启动Hadoop

按照官方文档,第一步先检查ssh能否免密登录如果不能免密登录需要执行以下命令

#ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa #cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys #chmod 0600 ~/.ssh/authorized_keys

#cd /usr/local/software/hadoop-3.2.0/sbin

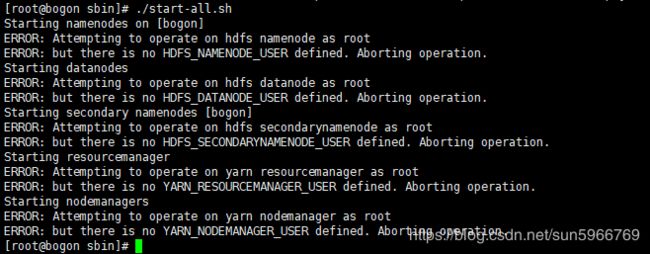

#./start-all.sh

这时候会发现出现如上图所示的错误,解决方法如下

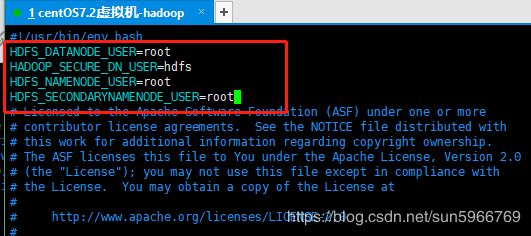

在/hadoop/sbin路径下:

将start-dfs.sh,stop-dfs.sh两个文件顶部添加以下参数!!!注意两个文件都要修改

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

还有,start-yarn.sh,stop-yarn.sh顶部也需添加以下:!!!注意两个文件都要修改

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

启动后输入jps命令,查看服务是否都已经启动成功,出现如下界面启动成功。

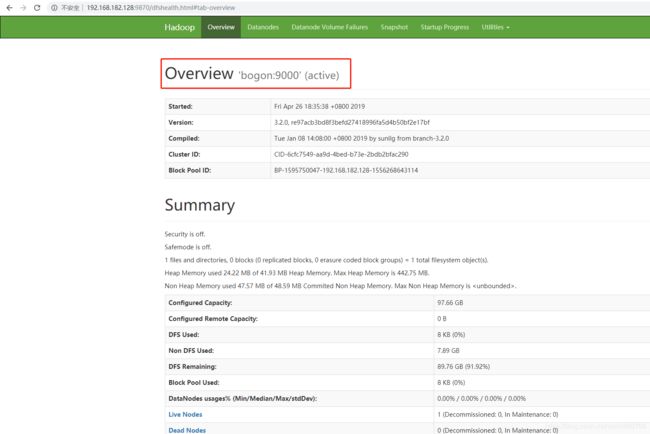

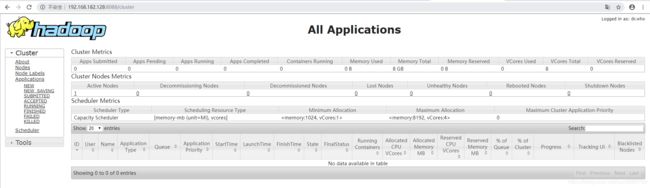

也可以通过浏览器地址验证

http://192.168.182.128:9870 (HDFS管理界面)###IP为Hadoop部署服务器的IP地址,Hadoop3中HDFS的默认端口改为9870,Hadoop2的默认端口为50070

http://192.168.182.128:8088 (RM管理界面)###IP为Hadoop部署服务器的IP地址