【NLP实践-Task8 循环神经网络】LSTM详解 & Text-RNN文本分类 & RCNN原理

目录

RNN基础

循环神经网络(Recurrent Neural Networks)

RNN的训练方法——BPTT算法(back-propagation through time)

长期依赖(Long-Term Dependencies)问题

LSTM(long short-term memory)

LSTM 的核心思想

逐步理解 LSTM

LSTM 的变体

GRU(Gated Recurrent Unit)

双向RNN

递归神经网络(Recursive Neural Network)

Memory Network(待完成)

Text-RNN

模型结构

Text-RNN文本分类实战

数据集

预处理

RNN模型

训练

Recurrent Convolutional Neural Networks(RCNN)

原理

RCNN小结

RCNN文本分类实战(待完成)

参考

RNN基础

循环神经网络(Recurrent Neural Networks)

人类并不是每时每刻都从一片空白的大脑开始他们的思考。在你阅读这篇文章时候,你都是基于自己已经拥有的对先前所见词的理解来推断当前词的真实含义。我们不会将所有的东西都全部丢弃,然后用空白的大脑进行思考。我们的思想拥有持久性。

传统的神经网络并不能做到这点,看起来也像是一种巨大的弊端。例如,假设你希望对电影中的每个时间点的时间类型进行分类。传统的神经网络应该很难来处理这个问题——使用电影中先前的事件推断后续的事件。

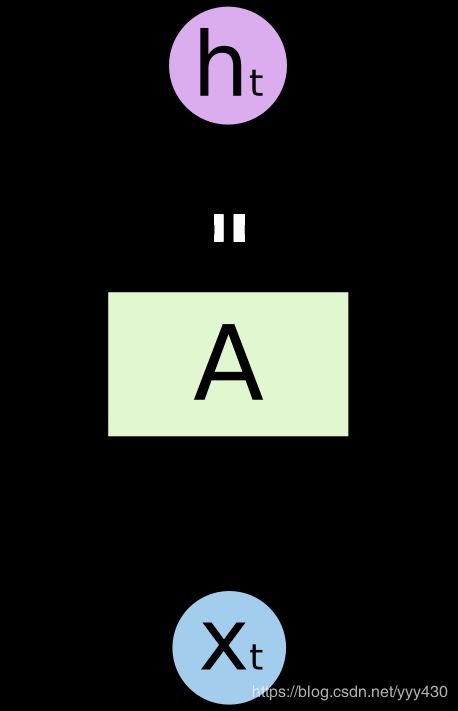

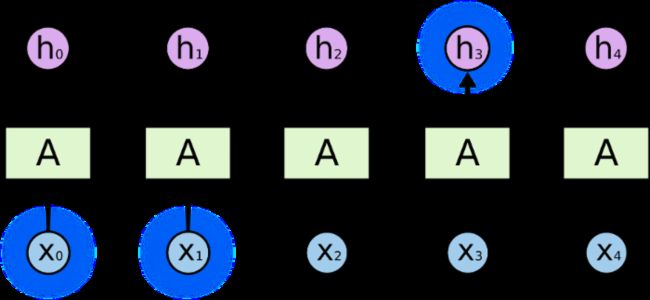

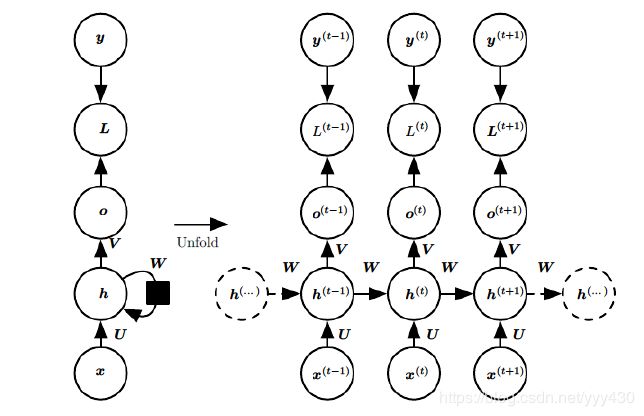

RNN 解决了这个问题。RNN 是包含循环的网络,允许信息的持久化。RNN结构:

RNN 包含循环

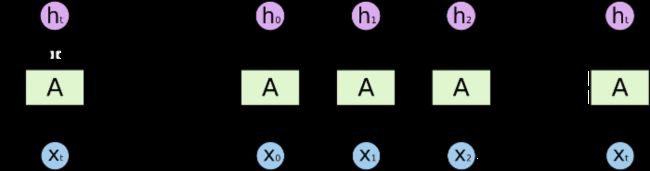

在上面的示例图中,神经网络的模块A,正在读取某个输入 x_i,并输出一个值 h_i。循环可以使得信息可以从当前步传递到下一步。这些循环使得 RNN 看起来非常神秘。然而,如果你仔细想想,这样也不比一个正常的神经网络难于理解。RNN 可以被看做是同一神经网络的多次赋值,每个神经网络模块会把消息传递给下一个。所以,如果我们将这个循环展开:

展开的 RNN

链式的特征揭示了 RNN 本质上是与序列和列表相关的。他们是对于这类数据的最自然的神经网络架构。

先介绍一下各个符号的含义:x是输入,h是隐层单元,o为输出,L为损失函数,y为训练集的标签。这些元素右上角带的t代表t时刻的状态,其中需要注意的是,因策单元h在t时刻的表现不仅由此刻的输入决定,还受t时刻之前时刻的影响。V、W、U是权值,同一类型的权连接权值相同。

有了上面的理解,前向传播算法其实非常简单,对于t时刻:

![]()

其中ϕ()为激活函数,一般来说会选择tanh函数,b为偏置。

t时刻的输出就更为简单:

![]()

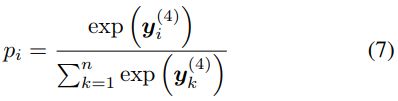

最终模型的预测输出为:

![]()

其中σ为激活函数,通常RNN用于分类,故这里一般用softmax函数。

RNN的训练方法——BPTT算法(back-propagation through time)

BPTT(back-propagation through time)算法是常用的训练RNN的方法,其实本质还是BP算法,只不过RNN处理时间序列数据,所以要基于时间反向传播,故叫随时间反向传播。BPTT的中心思想和BP算法相同,沿着需要优化的参数的负梯度方向不断寻找更优的点直至收敛。综上所述,BPTT算法本质还是BP算法,BP算法本质还是梯度下降法,那么求各个参数的梯度便成了此算法的核心。

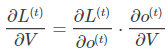

再次看上图,这里寻优的参数有三个,分别是U、V、W。与BP算法不同的是,其中W和U两个参数的寻优过程需要追溯之前的历史数据,参数V相对简单只需关注目前,那么我们就来先求解参数V的偏导数。

这个式子看起来简单但是求解起来很容易出错,因为其中嵌套着激活函数函数,是复合函数的求导过程。

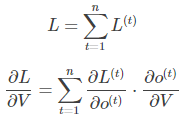

RNN的损失也是会随着时间累加的,所以不能只求t时刻的偏导。

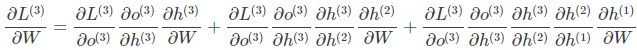

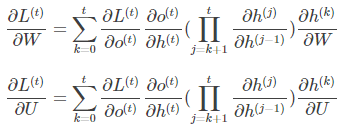

W和U的偏导的求解由于需要涉及到历史数据,其偏导求起来相对复杂,我们先假设只有三个时刻,那么在第三个时刻 L对W的偏导数为:

相应的,L在第三个时刻对U的偏导数为:

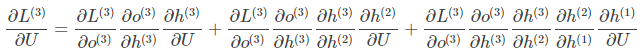

可以观察到,在某个时刻的对W或是U的偏导数,需要追溯这个时刻之前所有时刻的信息,这还仅仅是一个时刻的偏导数,上面说过损失也是会累加的,那么整个损失函数对W和U的偏导数将会非常繁琐。虽然如此但好在规律还是有迹可循,我们根据上面两个式子可以写出L在t时刻对W和U偏导数的通式:

整体的偏导公式就是将其按时刻再一一加起来。

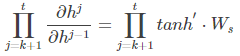

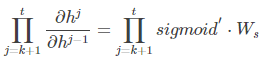

前面说过激活函数是嵌套在里面的,如果我们把激活函数放进去,拿出中间累乘的那部分:

或是

我们会发现累乘会导致激活函数导数的累乘,进而会导致“梯度消失“和“梯度爆炸“现象的发生。

至于为什么,我们先来看看这两个激活函数的图像。 这是sigmoid函数的函数图和导数图:

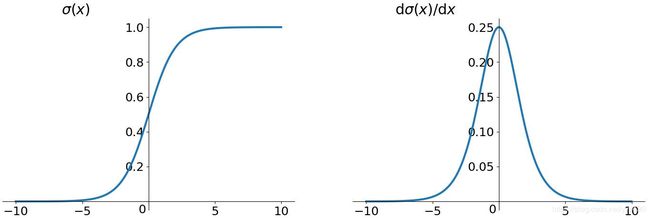

这是tanh函数的函数图和导数图:

它们二者是何其的相似,都把输出压缩在了一个范围之内。他们的导数图像也非常相近,我们可以从中观察到,sigmoid函数的导数范围是(0,0.25],tach函数的导数范围是(0,1],他们的导数最大都不大于1。

这就会导致一个问题,在上面式子累乘的过程中,如果取sigmoid函数作为激活函数的话,那么必然是一堆小数在做乘法,结果就是越乘越小。随着时间序列的不断深入,小数的累乘就会导致梯度越来越小直到接近于0,这就是“梯度消失“现象。其实RNN的时间序列与深层神经网络很像,在较为深层的神经网络中使用sigmoid函数做激活函数也会导致反向传播时梯度消失,梯度消失就意味消失那一层的参数再也不更新,那么那一层隐层就变成了单纯的映射层,毫无意义了,所以在深层神经网络中,有时候多加神经元数量可能会比多家深度好。

你可能会提出异议,RNN明明与深层神经网络不同,RNN的参数都是共享的,而且某时刻的梯度是此时刻和之前时刻的累加,即使传不到最深处那浅层也是有梯度的。这当然是对的,但如果我们根据有限层的梯度来更新更多层的共享的参数一定会出现问题的,因为将有限的信息来作为寻优根据必定不会找到所有信息的最优解。

之前说过我们多用tanh函数作为激活函数,那tanh函数的导数最大也才1啊,而且又不可能所有值都取到1,那相当于还是一堆小数在累乘,还是会出现“梯度消失“,那为什么还要用它做激活函数呢?原因是tanh函数相对于sigmoid函数来说梯度较大,收敛速度更快且引起梯度消失更慢。

还有一个原因是sigmoid函数还有一个缺点,Sigmoid函数输出不是零中心对称。sigmoid的输出均大于0,这就使得输出不是0均值,称为偏移现象,这将导致后一层的神经元将上一层输出的非0均值的信号作为输入。关于原点对称的输入和中心对称的输出,网络会收敛地更好。

RNN的特点本来就是能“追根溯源“利用历史数据,现在告诉我可利用的历史数据竟然是有限的,这就令人非常难受,解决“梯度消失“是非常必要的。解决“梯度消失“的方法主要有:

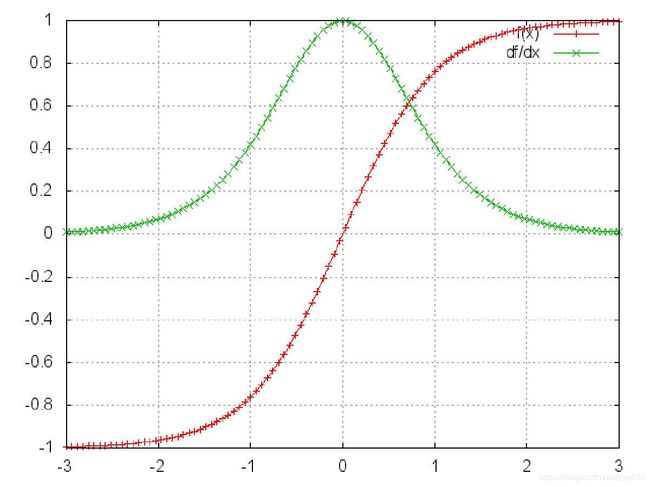

- 选取更好的激活函数

- 改变传播结构

关于第一点,一般选用ReLU函数作为激活函数,ReLU函数的图像为:

ReLU函数的左侧导数为0,右侧导数恒为1,这就避免了“梯度消失“的发生。但恒为1的导数容易导致“梯度爆炸“,但设定合适的阈值可以解决这个问题。还有一点就是如果左侧横为0的导数有可能导致把神经元学死,不过设置合适的步长(学习率)也可以有效避免这个问题的发生。

关于第二点,LSTM结构可以解决这个问题。

总结一下,sigmoid函数的缺点:

- 导数值范围为(0,0.25],反向传播时会导致“梯度消失“。tanh函数导数值范围更大,相对好一点。

- sigmoid函数不是0中心对称,tanh函数是,可以使网络收敛的更好。

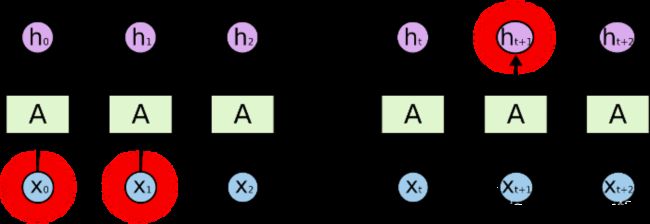

长期依赖(Long-Term Dependencies)问题

RNN 的关键点之一就是他们可以用来连接先前的信息到当前的任务上,例如使用过去的视频段来推测对当前段的理解。如果 RNN 可以做到这个,他们就变得非常有用。但是真的可以么?答案是,还有很多依赖因素。

有时候,我们仅仅需要知道先前的信息来执行当前的任务。例如,我们有一个语言模型用来基于先前的词来预测下一个词。如果我们试着预测 “the clouds are in the sky” 最后的词,我们并不需要任何其他的上下文 —— 因此下一个词很显然就应该是 sky。在这样的场景中,相关的信息和预测的词位置之间的间隔是非常小的,RNN 可以学会使用先前的信息。

不太长的相关信息和位置间隔

但是同样会有一些更加复杂的场景。假设我们试着去预测“I grew up in France... I speak fluent French”最后的词。当前的信息建议下一个词可能是一种语言的名字,但是如果我们需要弄清楚是什么语言,我们是需要先前提到的离当前位置很远的 France 的上下文的。这说明相关信息和当前预测位置之间的间隔就肯定变得相当的大。

不幸的是,在这个间隔不断增大时,RNN 会丧失学习到连接如此远的信息的能力。

相当长的相关信息和位置间隔

在理论上,RNN 绝对可以处理这样的 长期依赖 问题。人们可以仔细挑选参数来解决这类问题中的最初级形式,但在实践中,RNN 肯定不能够成功学习到这些知识。如果序列过长会导致优化时出现梯度消散的问题。

然而,幸运的是,LSTM 并没有这个问题!

LSTM(long short-term memory)

长短期记忆网络是RNN的一种变体,RNN由于梯度消失的原因只能有短期记忆,LSTM网络通过精妙的门控制将短期记忆与长期记忆结合起来,并且一定程度上解决了梯度消失的问题。

LSTM 通过刻意的设计来避免长期依赖问题。记住长期的信息在实践中是 LSTM 的默认行为,而非需要付出很大代价才能获得的能力!

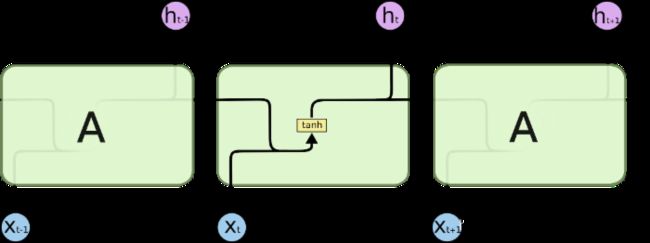

所有 RNN 都具有一种重复神经网络模块的链式的形式。在标准的 RNN 中,这个重复的模块只有一个非常简单的结构,例如一个tanh层:

标准 RNN 中的重复模块包含单一的层

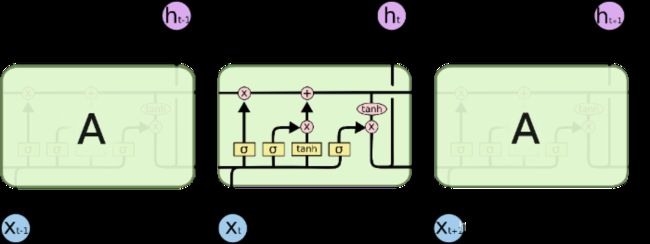

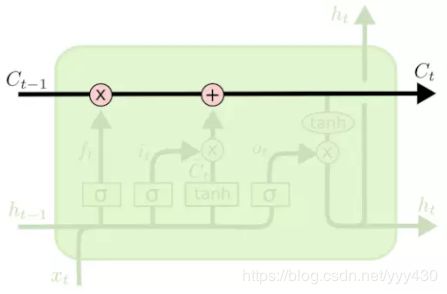

LSTM 同样是这样的结构,但是重复的模块拥有一个不同的结构。不同于 单一神经网络层,这里是有四个,以一种非常特殊的方式进行交互:

LSTM 中的重复模块包含四个交互的层

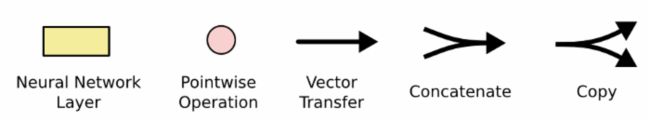

不必担心这里的细节。我们会一步一步地剖析 LSTM 解析图。现在,我们先来熟悉一下图中使用的各种元素的图标。

LSTM 中的图标

在上面的图例中,每一条黑线传输着一整个向量,从一个节点的输出到其他节点的输入。粉色的圈代表按位 pointwise 的操作,诸如向量的和,而黄色的矩阵就是学习到的神经网络层。合在一起的线表示向量的连接,分开的线表示内容被复制,然后分发到不同的位置。

LSTM 的核心思想

LSTM 的关键就是细胞状态,水平线在图上方贯穿运行。

细胞状态类似于传送带。直接在整个链上运行,只有一些少量的线性交互。信息在上面流传保持不变会很容易。

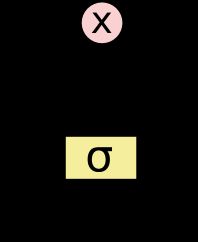

LSTM 有通过精心设计的称作为“门”的结构来去除或者增加信息到细胞状态的能力。门是一种让信息选择式通过的方法。他们包含一个sigmoid神经网络层和一个按位的乘法操作。

Sigmoid 层输出 0 到 1 之间的数值,描述每个部分有多少量可以通过。0 代表“不许任何量通过”,1 就指“允许任意量通过”!

LSTM 拥有3个门,来保护和控制细胞状态。

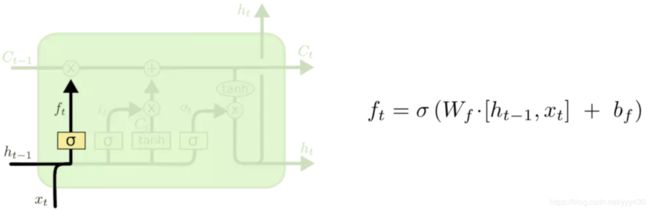

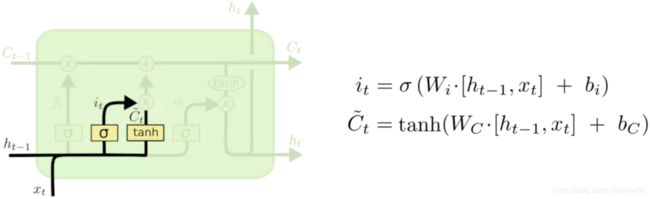

逐步理解 LSTM

在我们 LSTM 中的第一步是决定我们会从细胞状态中丢弃什么信息。这个决定通过一个称为忘记门层完成。该门会读取 ![]() 和

和 ![]() ,输出一个在 0 到 1 之间的数值给每个在细胞状态

,输出一个在 0 到 1 之间的数值给每个在细胞状态 ![]() 中的数字。1 表示“完全保留”,0 表示“完全舍弃”。

中的数字。1 表示“完全保留”,0 表示“完全舍弃”。

让我们回到语言模型的例子中来基于已经看到的预测下一个词。在这个问题中,细胞状态可能包含当前主语的性别,因此正确的代词可以被选择出来。当我们看到新的主语,我们希望忘记旧的主语。

决定丢弃信息

下一步是确定什么样的新信息被存放在细胞状态中。这里包含两个部分。第一,sigmoid层称 “输入门层” 决定什么值我们将要更新。然后,一个tanh层创建一个新的候选值向量,![]() ,会被加入到状态中。下一步,我们会讲这两个信息来产生对状态的更新。

,会被加入到状态中。下一步,我们会讲这两个信息来产生对状态的更新。

在我们语言模型的例子中,我们希望增加新的主语的性别到细胞状态中,来替代旧的需要忘记的主语。

确定更新的信息

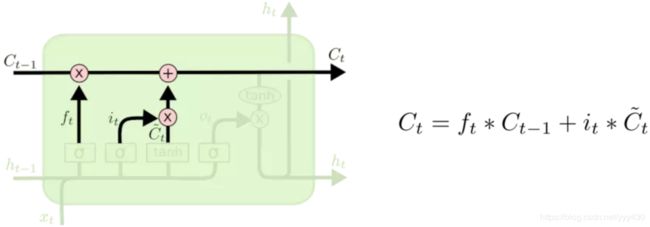

现在是更新旧细胞状态的时间了,![]() 更新为

更新为 ![]() 。前面的步骤已经决定了将会做什么,我们现在就是实际去完成。

。前面的步骤已经决定了将会做什么,我们现在就是实际去完成。

我们把旧状态与 ![]() 相乘,丢弃掉我们确定需要丢弃的信息。接着加上

相乘,丢弃掉我们确定需要丢弃的信息。接着加上 ![]() 。这就是新的候选值,根据我们决定更新每个状态的程度进行变化。

。这就是新的候选值,根据我们决定更新每个状态的程度进行变化。

在语言模型的例子中,这就是我们实际根据前面确定的目标,丢弃旧代词的性别信息并添加新的信息的地方。

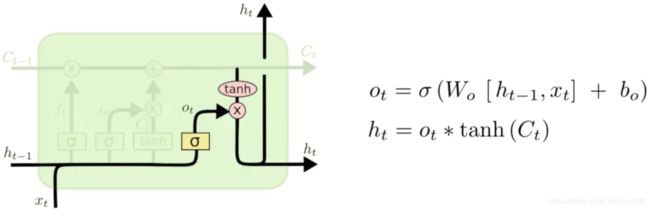

更新细胞状态

最终,我们需要确定输出什么值。这个输出将会基于我们的细胞状态,但是也是一个过滤后的版本。首先,我们运行一个 层sigmoid来确定细胞状态的哪个部分将输出出去。接着,我们把细胞状态通过tanh 进行处理(得到一个在 -1 到 1 之间的值)并将它和sigmoid门的输出相乘,最终我们仅仅会输出我们确定输出的那部分。

在语言模型的例子中,因为他就看到了一个 代词,可能需要输出与一个 动词 相关的信息。例如,可能输出是否代词是单数还是负数,这样如果是动词的话,我们也知道动词需要进行的词形变化。

输出信息

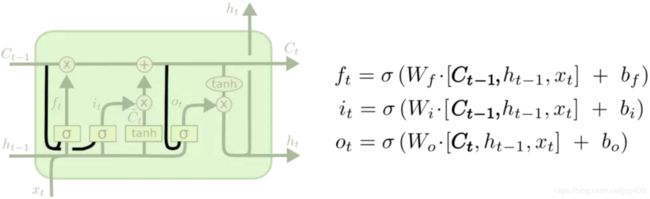

LSTM 的变体

我们到目前为止都还在介绍正常的 LSTM。但是不是所有的 LSTM 都长成一个样子的。实际上,几乎所有包含 LSTM 的论文都采用了微小的变体。差异非常小,但是也值得拿出来讲一下。

其中一个流形的 LSTM 变体,就是由 Gers & Schmidhuber (2000) 提出的,增加了 “peephole connection”。是说,我们让 门层 也会接受细胞状态的输入。

peephole 连接

上面的图例中,我们增加了 peephole 到每个门上,但是许多论文会加入部分的 peephole 而非所有都加。

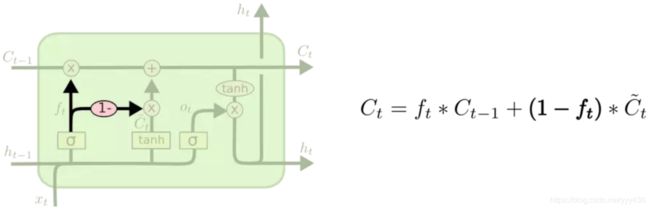

另一个变体是通过使用 coupled 忘记和输入门。不同于之前是分开确定什么忘记和需要添加什么新的信息,这里是一同做出决定。我们仅仅会当我们将要输入在当前位置时忘记。我们仅仅输入新的值到那些我们已经忘记旧的信息的那些状态 。

coupled 忘记门和输入门

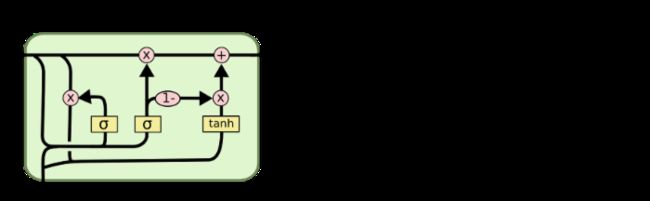

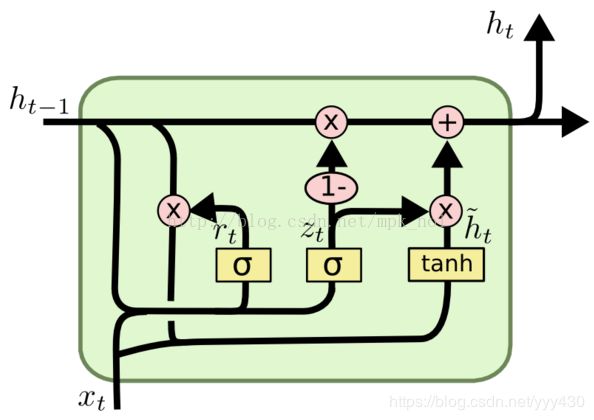

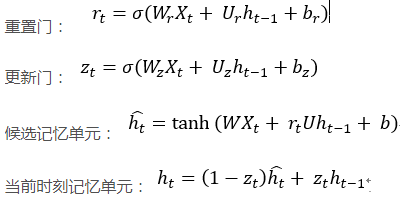

GRU(Gated Recurrent Unit)

另一个改动较大的变体是 Gated Recurrent Unit (GRU),这是由 Cho, et al. (2014) 提出。GRU将忘记门和输入门合成了一个单一的更新门。还混合了细胞状态和隐藏状态ht,在计算当前时刻新信息的方法和LSTM有所不同。最终的模型比标准的 LSTM 模型要简单。

GRU

GRU更新ht的过程:

双向RNN

在经典的循环神经网络中,状态的传输是从前往后单向的。然而,在有些问题中,当前时刻的输出不仅和之前的状态有关系,也和之后的状态相关。这时就需要双向RNN(BiRNN)来解决这类问题。例如预测一个语句中缺失的单词不仅需要根据前文来判断,也需要根据后面的内容,这时双向RNN就可以发挥它的作用。

双向RNN是由两个RNN上下叠加在一起组成的。输出由这两个RNN的状态共同决定。

从上图可以看出,双向RNN的主题结构就是两个单向RNN的结合。在每一个时刻t,输入会同时提供给这两个方向相反的RNN,而输出则是由这两个单向RNN共同决定(可以拼接或者求和等)。

同样地,将双向RNN中的RNN替换成LSTM或者GRU结构,则组成了BiLSTM和BiGRU。

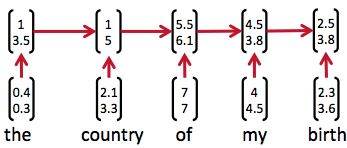

递归神经网络(Recursive Neural Network)

递归神经网络和循环神经网络的缩写一样,都是是RNN。

循环神经网络可以用来处理包含序列结构的信息。然而,除此之外,信息往往还存在着诸如树结构、图结构等更复杂的结构。对于这种复杂的结构,循环神经网络就无能为力了。而递归神经网络 (Recursive Neural Network, RNN)则可以处理诸如树、图这样的递归结构。

因为神经网络的输入层单元个数是固定的,因此必须用循环或者递归的方式来处理长度可变的输入。循环神经网络实现了前者,通过将长度不定的输入分割为等长度的小块,然后再依次的输入到网络中,从而实现了神经网络对变长输入的处理。一个典型的例子是,当我们处理一句话的时候,我们可以把一句话看作是词组成的序列,然后,每次向循环神经网络输入一个词,如此循环直至整句话输入完毕,循环神经网络将产生对应的输出。如此,我们就能处理任意长度的句子了。入下图所示:

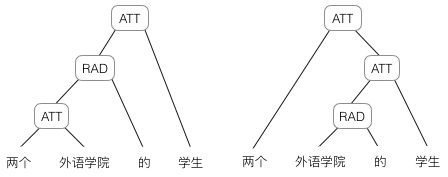

然而,有时候把句子看做是词的序列是不够的,比如下面这句话『两个外语学院的学生』:

上图显示了这句话的两个不同的语法解析树。可以看出来这句话有歧义,不同的语法解析树则对应了不同的意思。一个是『两个外语学院的/学生』,也就是学生可能有许多,但他们来自于两所外语学校;另一个是『两个/外语学院的学生』,也就是只有两个学生,他们是外语学院的。为了能够让模型区分出两个不同的意思,我们的模型必须能够按照树结构去处理信息,而不是序列,这就是递归神经网络的作用。当面对按照树/图结构处理信息更有效的任务时,递归神经网络通常都会获得不错的结果。

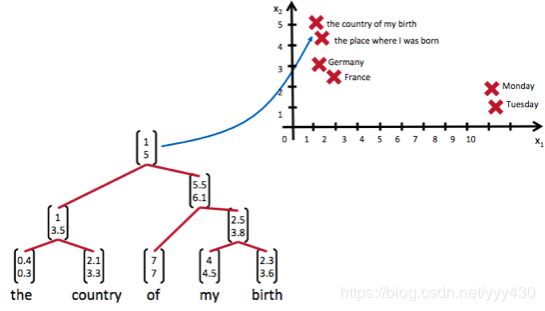

递归神经网络可以把一个树/图结构信息编码为一个向量,也就是把信息映射到一个语义向量空间中。这个语义向量空间满足某类性质,比如语义相似的向量距离更近。也就是说,如果两句话(尽管内容不同)它的意思是相似的,那么把它们分别编码后的两个向量的距离也相近;反之,如果两句话的意思截然不同,那么编码后向量的距离则很远。如下图所示:

从上图我们可以看到,递归神经网络将所有的词、句都映射到一个2维向量空间中。句子『the country of my birth』和句子『the place where I was born』的意思是非常接近的,所以表示它们的两个向量在向量空间中的距离很近。另外两个词『Germany』和『France』因为表示的都是地点,它们的向量与上面两句话的向量的距离,就比另外两个表示时间的词『Monday』和『Tuesday』的向量的距离近得多。这样,通过向量的距离,就得到了一种语义的表示。

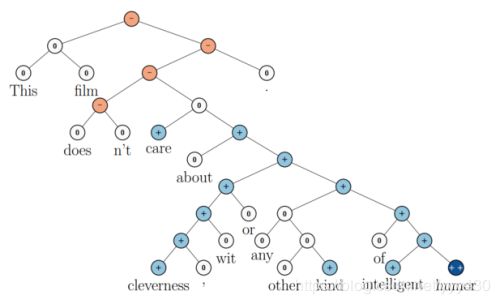

上图还显示了自然语言可组合的性质:词可以组成句、句可以组成段落、段落可以组成篇章,而更高层的语义取决于底层的语义以及它们的组合方式。递归神经网络是一种表示学习,它可以将词、句、段、篇按照他们的语义映射到同一个向量空间中,也就是把可组合(树/图结构)的信息表示为一个个有意义的向量。比如上面这个例子,递归神经网络把句子"the country of my birth"表示为二维向量[1,5]。有了这个『编码器』之后,我们就可以以这些有意义的向量为基础去完成更高级的任务(比如情感分析等)。如下图所示,递归神经网络在做情感分析时,可以比较好的处理否定句,这是胜过其他一些模型的:

在上图中,蓝色表示正面评价,红色表示负面评价。每个节点是一个向量,这个向量表达了以它为根的子树的情感评价。比如"intelligent humor"是正面评价,而"care about cleverness wit or any other kind of intelligent humor"是中性评价。我们可以看到,模型能够正确的处理doesn't的含义,将正面评价转变为负面评价。

尽管递归神经网络具有更为强大的表示能力,但是在实际应用中并不太流行。其中一个主要原因是,递归神经网络的输入是树/图结构,而这种结构需要花费很多人工去标注。想象一下,如果我们用循环神经网络处理句子,那么我们可以直接把句子作为输入。然而,如果我们用递归神经网络处理句子,我们就必须把每个句子标注为语法解析树的形式,这无疑要花费非常大的精力。很多时候,相对于递归神经网络能够带来的性能提升,这个投入是不太划算的。

Memory Network(待完成)

Text-RNN

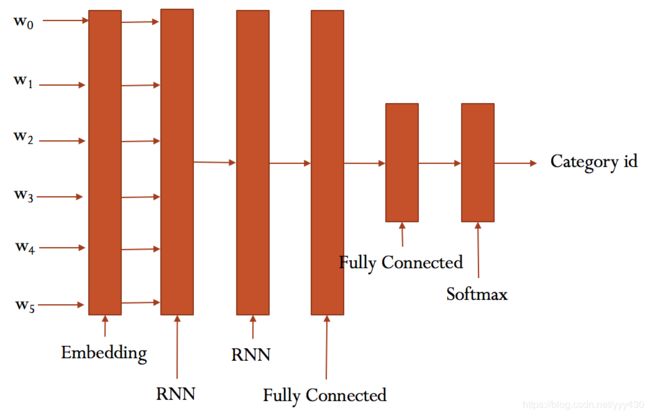

模型结构

RNN模型结构

Text-RNN文本分类实战

数据集

百度网盘https://pan.baidu.com/s/1hugrfRu 密码:qfud

本数据集是清华NLP组提供的THUCNews新闻文本分类数据集的一个子集(原始的数据集大约74万篇文档,训练起来需要花较长的时间)。

本次训练使用了其中的10个分类(体育, 财经, 房产, 家居, 教育, 科技, 时尚, 时政, 游戏, 娱乐),每个分类6500条,总共65000条新闻数据。

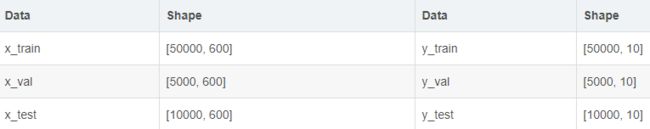

数据集划分如下:

cnews.train.txt: 训练集(50000条)

cnews.val.txt: 验证集(5000条)

cnews.test.txt: 测试集(10000条)

预处理

预处理文件preprocess.py,代码中的函数说明如下:

read_file(): 读取文件数据;

build_vocab(): 构建词汇表,使用字符级的表示,这一函数会将词汇表存储下来,避免每一次重复处理;

read_vocab(): 读取上一步存储的词汇表,转换为{词:id}表示;

read_category(): 将分类目录固定,转换为{类别: id}表示;

to_words(): 将一条由id表示的数据重新转换为文字;

preocess_file(): 将数据集从文字转换为固定长度的id序列表示;

batch_iter(): 为神经网络的训练准备经过shuffle的批次的数据。

# coding: utf-8

import sys

from collections import Counter

import numpy as np

import tensorflow.contrib.keras as kr

if sys.version_info[0] > 2:

is_py3 = True

else:

reload(sys)

sys.setdefaultencoding("utf-8")

is_py3 = False

def native_word(word, encoding='utf-8'):

"""如果在python2下面使用python3训练的模型,可考虑调用此函数转化一下字符编码"""

if not is_py3:

return word.encode(encoding)

else:

return word

def native_content(content):

if not is_py3:

return content.decode('utf-8')

else:

return content

def open_file(filename, mode='r'):

"""

常用文件操作,可在python2和python3间切换.

mode: 'r' or 'w' for read or write

"""

if is_py3:

return open(filename, mode, encoding='utf-8', errors='ignore')

else:

return open(filename, mode)

def read_file(filename):

"""读取文件数据"""

contents, labels = [], []

with open_file(filename) as f:

for line in f:

try:

label, content = line.strip().split('\t')

if content:

contents.append(list(native_content(content)))

labels.append(native_content(label))

except:

pass

return contents, labels

def build_vocab(train_dir, vocab_dir, vocab_size=5000):

"""根据训练集构建词汇表,存储"""

data_train, _ = read_file(train_dir)

all_data = []

for content in data_train:

all_data.extend(content)

counter = Counter(all_data)

count_pairs = counter.most_common(vocab_size - 1)

words, _ = list(zip(*count_pairs))

# 添加一个 来将所有文本pad为同一长度

words = [''] + list(words)

open_file(vocab_dir, mode='w').write('\n'.join(words) + '\n')

def read_vocab(vocab_dir):

"""读取词汇表"""

# words = open_file(vocab_dir).read().strip().split('\n')

with open_file(vocab_dir) as fp:

# 如果是py2 则每个值都转化为unicode

words = [native_content(_.strip()) for _ in fp.readlines()]

word_to_id = dict(zip(words, range(len(words))))

return words, word_to_id

def read_category():

"""读取分类目录,固定"""

categories = ['体育', '财经', '房产', '家居', '教育', '科技', '时尚', '时政', '游戏', '娱乐']

categories = [native_content(x) for x in categories]

cat_to_id = dict(zip(categories, range(len(categories))))

return categories, cat_to_id

def to_words(content, words):

"""将id表示的内容转换为文字"""

return ''.join(words[x] for x in content)

def process_file(filename, word_to_id, cat_to_id, max_length=600):

"""将文件转换为id表示"""

contents, labels = read_file(filename)

data_id, label_id = [], []

for i in range(len(contents)):

data_id.append([word_to_id[x] for x in contents[i] if x in word_to_id])

label_id.append(cat_to_id[labels[i]])

# 使用keras提供的pad_sequences来将文本pad为固定长度

x_pad = kr.preprocessing.sequence.pad_sequences(data_id, max_length)

y_pad = kr.utils.to_categorical(label_id, num_classes=len(cat_to_id)) # 将标签转换为one-hot表示

return x_pad, y_pad

def batch_iter(x, y, batch_size=64):

"""生成批次数据"""

data_len = len(x)

num_batch = int((data_len - 1) / batch_size) + 1

indices = np.random.permutation(np.arange(data_len))

x_shuffle = x[indices]

y_shuffle = y[indices]

for i in range(num_batch):

start_id = i * batch_size

end_id = min((i + 1) * batch_size, data_len)

yield x_shuffle[start_id:end_id], y_shuffle[start_id:end_id] 经过数据预处理,数据的格式如下:

RNN模型

rnn_model.py

# -*- coding: utf-8 -*-

import tensorflow as tf

class TRNNConfig(object):

"""RNN配置参数"""

# 模型参数

embedding_dim = 64 # 词向量维度

seq_length = 600 # 序列长度

num_classes = 10 # 类别数

vocab_size = 5000 # 词汇表达小

num_layers= 2 # 隐藏层层数

hidden_dim = 128 # 隐藏层神经元

rnn = 'gru' # lstm 或 gru

dropout_keep_prob = 0.8 # dropout保留比例

learning_rate = 1e-3 # 学习率

batch_size = 128 # 每批训练大小

num_epochs = 10 # 总迭代轮次

print_per_batch = 100 # 每多少轮输出一次结果

save_per_batch = 10 # 每多少轮存入tensorboard

class TextRNN(object):

"""文本分类,RNN模型"""

def __init__(self, config):

self.config = config

# 三个待输入的数据

self.input_x = tf.placeholder(tf.int32, [None, self.config.seq_length], name='input_x')

self.input_y = tf.placeholder(tf.float32, [None, self.config.num_classes], name='input_y')

self.keep_prob = tf.placeholder(tf.float32, name='keep_prob')

self.rnn()

def rnn(self):

"""rnn模型"""

def lstm_cell(): # lstm核

return tf.contrib.rnn.BasicLSTMCell(self.config.hidden_dim, state_is_tuple=True)

def gru_cell(): # gru核

return tf.contrib.rnn.GRUCell(self.config.hidden_dim)

def dropout(): # 为每一个rnn核后面加一个dropout层

if (self.config.rnn == 'lstm'):

cell = lstm_cell()

else:

cell = gru_cell()

return tf.contrib.rnn.DropoutWrapper(cell, output_keep_prob=self.keep_prob)

# 词向量映射

with tf.device('/cpu:0'):

embedding = tf.get_variable('embedding', [self.config.vocab_size, self.config.embedding_dim])

embedding_inputs = tf.nn.embedding_lookup(embedding, self.input_x)

with tf.name_scope("rnn"):

# 多层rnn网络

cells = [dropout() for _ in range(self.config.num_layers)]

rnn_cell = tf.contrib.rnn.MultiRNNCell(cells, state_is_tuple=True)

_outputs, _ = tf.nn.dynamic_rnn(cell=rnn_cell, inputs=embedding_inputs, dtype=tf.float32)

last = _outputs[:, -1, :] # 取最后一个时序输出作为结果

with tf.name_scope("score"):

# 全连接层,后面接dropout以及relu激活

fc = tf.layers.dense(last, self.config.hidden_dim, name='fc1')

fc = tf.contrib.layers.dropout(fc, self.keep_prob)

fc = tf.nn.relu(fc)

# 分类器

self.logits = tf.layers.dense(fc, self.config.num_classes, name='fc2')

self.y_pred_cls = tf.argmax(tf.nn.softmax(self.logits), 1) # 预测类别

with tf.name_scope("optimize"):

# 损失函数,交叉熵

cross_entropy = tf.nn.softmax_cross_entropy_with_logits(logits=self.logits, labels=self.input_y)

self.loss = tf.reduce_mean(cross_entropy)

# 优化器

self.optim = tf.train.AdamOptimizer(learning_rate=self.config.learning_rate).minimize(self.loss)

with tf.name_scope("accuracy"):

# 准确率

correct_pred = tf.equal(tf.argmax(self.input_y, 1), self.y_pred_cls)

self.acc = tf.reduce_mean(tf.cast(correct_pred, tf.float32))训练

run_rnn.py

# coding: utf-8

from __future__ import print_function

import os

import sys

import time

from datetime import timedelta

import numpy as np

import tensorflow as tf

from sklearn import metrics

from rnn_model import TRNNConfig, TextRNN

from data.cnews_loader import read_vocab, read_category, batch_iter, process_file, build_vocab

base_dir = 'data/cnews'

train_dir = os.path.join(base_dir, 'cnews.train.txt')

test_dir = os.path.join(base_dir, 'cnews.test.txt')

val_dir = os.path.join(base_dir, 'cnews.val.txt')

vocab_dir = os.path.join(base_dir, 'cnews.vocab.txt')

save_dir = 'checkpoints/textrnn'

save_path = os.path.join(save_dir, 'best_validation') # 最佳验证结果保存路径

def get_time_dif(start_time):

"""获取已使用时间"""

end_time = time.time()

time_dif = end_time - start_time

return timedelta(seconds=int(round(time_dif)))

def feed_data(x_batch, y_batch, keep_prob):

feed_dict = {

model.input_x: x_batch,

model.input_y: y_batch,

model.keep_prob: keep_prob

}

return feed_dict

def evaluate(sess, x_, y_):

"""评估在某一数据上的准确率和损失"""

data_len = len(x_)

batch_eval = batch_iter(x_, y_, 128)

total_loss = 0.0

total_acc = 0.0

for x_batch, y_batch in batch_eval:

batch_len = len(x_batch)

feed_dict = feed_data(x_batch, y_batch, 1.0)

loss, acc = sess.run([model.loss, model.acc], feed_dict=feed_dict)

total_loss += loss * batch_len

total_acc += acc * batch_len

return total_loss / data_len, total_acc / data_len

def train():

print("Configuring TensorBoard and Saver...")

# 配置 Tensorboard,重新训练时,请将tensorboard文件夹删除,不然图会覆盖

tensorboard_dir = 'tensorboard/textrnn'

if not os.path.exists(tensorboard_dir):

os.makedirs(tensorboard_dir)

tf.summary.scalar("loss", model.loss)

tf.summary.scalar("accuracy", model.acc)

merged_summary = tf.summary.merge_all()

writer = tf.summary.FileWriter(tensorboard_dir)

# 配置 Saver

saver = tf.train.Saver()

if not os.path.exists(save_dir):

os.makedirs(save_dir)

print("Loading training and validation data...")

# 载入训练集与验证集

start_time = time.time()

x_train, y_train = process_file(train_dir, word_to_id, cat_to_id, config.seq_length)

x_val, y_val = process_file(val_dir, word_to_id, cat_to_id, config.seq_length)

time_dif = get_time_dif(start_time)

print("Time usage:", time_dif)

# 创建session

session = tf.Session()

session.run(tf.global_variables_initializer())

writer.add_graph(session.graph)

print('Training and evaluating...')

start_time = time.time()

total_batch = 0 # 总批次

best_acc_val = 0.0 # 最佳验证集准确率

last_improved = 0 # 记录上一次提升批次

require_improvement = 1000 # 如果超过1000轮未提升,提前结束训练

flag = False

for epoch in range(config.num_epochs):

print('Epoch:', epoch + 1)

batch_train = batch_iter(x_train, y_train, config.batch_size)

for x_batch, y_batch in batch_train:

feed_dict = feed_data(x_batch, y_batch, config.dropout_keep_prob)

if total_batch % config.save_per_batch == 0:

# 每多少轮次将训练结果写入tensorboard scalar

s = session.run(merged_summary, feed_dict=feed_dict)

writer.add_summary(s, total_batch)

if total_batch % config.print_per_batch == 0:

# 每多少轮次输出在训练集和验证集上的性能

feed_dict[model.keep_prob] = 1.0

loss_train, acc_train = session.run([model.loss, model.acc], feed_dict=feed_dict)

loss_val, acc_val = evaluate(session, x_val, y_val) # todo

if acc_val > best_acc_val:

# 保存最好结果

best_acc_val = acc_val

last_improved = total_batch

saver.save(sess=session, save_path=save_path)

improved_str = '*'

else:

improved_str = ''

time_dif = get_time_dif(start_time)

msg = 'Iter: {0:>6}, Train Loss: {1:>6.2}, Train Acc: {2:>7.2%},' \

+ ' Val Loss: {3:>6.2}, Val Acc: {4:>7.2%}, Time: {5} {6}'

print(msg.format(total_batch, loss_train, acc_train, loss_val, acc_val, time_dif, improved_str))

session.run(model.optim, feed_dict=feed_dict) # 运行优化

total_batch += 1

if total_batch - last_improved > require_improvement:

# 验证集正确率长期不提升,提前结束训练

print("No optimization for a long time, auto-stopping...")

flag = True

break # 跳出循环

if flag: # 同上

break

def test():

print("Loading test data...")

start_time = time.time()

x_test, y_test = process_file(test_dir, word_to_id, cat_to_id, config.seq_length)

session = tf.Session()

session.run(tf.global_variables_initializer())

saver = tf.train.Saver()

saver.restore(sess=session, save_path=save_path) # 读取保存的模型

print('Testing...')

loss_test, acc_test = evaluate(session, x_test, y_test)

msg = 'Test Loss: {0:>6.2}, Test Acc: {1:>7.2%}'

print(msg.format(loss_test, acc_test))

batch_size = 128

data_len = len(x_test)

num_batch = int((data_len - 1) / batch_size) + 1

y_test_cls = np.argmax(y_test, 1)

y_pred_cls = np.zeros(shape=len(x_test), dtype=np.int32) # 保存预测结果

for i in range(num_batch): # 逐批次处理

start_id = i * batch_size

end_id = min((i + 1) * batch_size, data_len)

feed_dict = {

model.input_x: x_test[start_id:end_id],

model.keep_prob: 1.0

}

y_pred_cls[start_id:end_id] = session.run(model.y_pred_cls, feed_dict=feed_dict)

# 评估

print("Precision, Recall and F1-Score...")

print(metrics.classification_report(y_test_cls, y_pred_cls, target_names=categories))

# 混淆矩阵

print("Confusion Matrix...")

cm = metrics.confusion_matrix(y_test_cls, y_pred_cls)

print(cm)

time_dif = get_time_dif(start_time)

print("Time usage:", time_dif)

if __name__ == '__main__':

if len(sys.argv) != 2 or sys.argv[1] not in ['train', 'test']:

raise ValueError("""usage: python run_rnn.py [train / test]""")

print('Configuring RNN model...')

config = TRNNConfig()

if not os.path.exists(vocab_dir): # 如果不存在词汇表,重建

build_vocab(train_dir, vocab_dir, config.vocab_size)

categories, cat_to_id = read_category()

words, word_to_id = read_vocab(vocab_dir)

config.vocab_size = len(words)

model = TextRNN(config)

if sys.argv[1] == 'train':

train()

else:

test()Recurrent Convolutional Neural Networks(RCNN)

原理

paper地址:https://www.aaai.org/ocs/index.php/AAAI/AAAI15/paper/view/9745/9552

RCNN结合了RNN和CNN。

文本可以是一个句子、文档(短文本,若干句子)或篇章(长文本),因此每段文本的长度都不尽相同。

在对文本进行分类时,我们一般会指定一个固定的输入序列/文本长度:该长度可以是最长文本/序列的长度,此时其他所有文本/序列都要进行填充以达到该长度;该长度也可以是训练集中所有文本/序列长度的均值,此时对于过长的文本/序列需要进行截断,过短的文本则进行填充。

总之,要使得训练集中所有的文本/序列长度相同,该长度除之前提到的设置外,也可以是其他任意合理的数值。在测试时,也需要对测试集中的文本/序列做同样的处理。

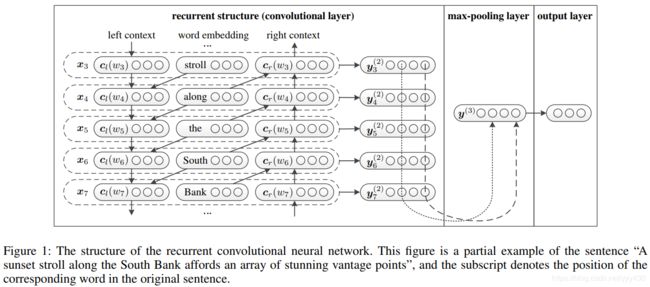

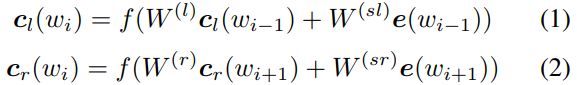

假设训练集中所有文本/序列的长度统一为n,我们需要对文本进行分词,并使用词嵌入得到每个词固定维度的向量表示。在RCNN中,我们不仅要考虑每个词的词向量还要考虑该词上下文的向量表示,三者共同构成该词最终的嵌入表示,作为CNN卷积层的输入。接下来我们具体如何操作。

图中中间是输入序列中每个单词的嵌入表示,左右使用双向RNN分别学习当前词![]() 的左上下文表示

的左上下文表示![]() 和右上下文表示

和右上下文表示![]() ,在与当前词

,在与当前词![]() 本身的词向量连接,构成后续卷积层的输入

本身的词向量连接,构成后续卷积层的输入![]() 。具体如下:

。具体如下:

与TextCNN比较类似,都是把文本表示为一个嵌入矩阵,再进行卷积操作。不同的是TextCNN中的文本嵌入矩阵每一行只是文本中一个词的向量表示,而在RCNN中,文本嵌入矩阵的每一行是当前词的词向量以及上下文嵌入表示的拼接。

例如:上图中的along这一个单词,中间是他的词向量,左边利用一个RNN得到along之前上文所有单词的嵌入表示(当前时间步骤上RNN的隐藏状态),右边同样利用一个反向的RNN得到along之后所有单词的嵌入表示(当前时间步骤上RNN的隐藏状态)。三者共同构成along的嵌入表示,文本中的其他词同理。最后文本被表示为上图左边的一个嵌入矩阵。

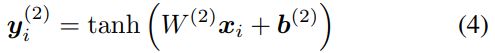

然后将![]() 作为当前词的嵌入表示,输入到卷积核大小为1*d(d为

作为当前词的嵌入表示,输入到卷积核大小为1*d(d为![]() 的长度)激活函数为tanh的卷积层,得到潜在

的长度)激活函数为tanh的卷积层,得到潜在![]() 的语义向量:

的语义向量:

在TextCNN中我们曾经设置了多个卷积核f*d,RCNN中将卷积核大小设置为1*d的原因是![]() 中已经包含了

中已经包含了![]() 左右上下文的信息,无需再使用窗口大于1的卷积核进行特征提取。需要说明的是,实践中依然可以同时使用多个不同大小的卷积核,如[1,2,3],可能会取得更好的实践效果,一种解释是窗口大于1的卷积核强化了

左右上下文的信息,无需再使用窗口大于1的卷积核进行特征提取。需要说明的是,实践中依然可以同时使用多个不同大小的卷积核,如[1,2,3],可能会取得更好的实践效果,一种解释是窗口大于1的卷积核强化了![]() 左右最近的上下文信息。此外实践中一般使用更复杂的RNN来捕捉的上下文信息,如LSTM和GRU等。

左右最近的上下文信息。此外实践中一般使用更复杂的RNN来捕捉的上下文信息,如LSTM和GRU等。

再经过卷积层以后,获得了文本中所有词的语义表示![]() ,然后经过一个max-pooling层和softmax层(输出层使用softmax激活函数)进行分类:

,然后经过一个max-pooling层和softmax层(输出层使用softmax激活函数)进行分类:

RCNN小结

- 在RCNN论文的所有实验上,神经网络比传统方法效果好。

- 基于CNN的方法比基于RNN的方法好。

- RCNN可以捕获更长的模式。

- 在RCNN论文的使用实验数据集上,RCNN比CNN好。

- CNN使用固定词窗口(捕获上下文信息),实验结果受窗口大小的影响;RCNN使用循环结构捕获广泛的上下文信息。

但是在实际应用中,CNN的效果已经足够好了,RCNN未必能有比CNN更好的效果,而且CNN的训练速度更快,可以尝试多种方法,找一个效果最好的。

RCNN文本分类实战(待完成)

参考

理解 LSTM 网络 https://www.jianshu.com/p/9dc9f41f0b29

RNN https://blog.csdn.net/zhaojc1995/article/details/80572098

深度学习笔记——RNN(LSTM、GRU、双向RNN)学习总结 https://blog.csdn.net/mpk_no1/article/details/72875185

一份详细的LSTM和GRU图解 https://www.atyun.com/30234.html

零基础入门深度学习(5) - 循环神经网络 https://zybuluo.com/hanbingtao/note/541458

零基础入门深度学习(7) - 递归神经网络 https://zybuluo.com/hanbingtao/note/626300

CNN-RNN中文文本分类,基于TensorFlow https://github.com/gaussic/text-classification-cnn-rnn

自然语言处理 | (23) 基于RCNN的文本分类原理 https://blog.csdn.net/sdu_hao/article/details/88099535

RCNN文本分类-Tensorflow https://github.com/roomylee/rcnn-text-classification

TextRCNN 文本分类 https://github.com/zhangfazhan/TextRCNN

TextRCNN 文本分类-Keras https://github.com/airalcorn2/Recurrent-Convolutional-Neural-Network-Text-Classifier

Tensorflow实战(1): 实现深层循环神经网络 https://zhuanlan.zhihu.com/p/37070414

从LSTM到Seq2Seq https://x-algo.cn/index.php/2017/01/13/1609/一份详细的LSTM和GRU图解