对抗样本(论文解读十五): Universal Physical Camouflage Attacks on Object Detectors

Universal Physical Camouflage Attacks on Object Detectors

Lifeng Huang1,2 Chengying Gao1 Yuyin Zhou3 Cihang Xie3 Alan Yuille3 Changqing Zou4,5 Ning Liu1,2∗

1School of Data and Computer Science, Sun Yat-sen University

2Guangdong Key Laboratory of Information Security Technology

3Department of Computer Science, The Johns Hopkins University

4Max Planck Institute for Informatics, 5University of Maryland, College Park

发表于CVPR 2020

Abstract

提出学习一个对抗模式去有效的攻击同一类别的所有实例,称为通用的物理躲避攻击UPC。

Concretely,通过联合欺骗区域建议网络,同时误导分类器和回归器,输出错误。为了使UPC对非刚性或非平面对象有效,我们引入了一组用于模拟可变形属性的转换。

我们还附加了优化约束,使生成的模式对人类观察者来说更自然。为了公平地评估不同物理世界攻击的有效性,我们提出了第一个标准化的虚拟数据库AttackScenes,它在一个可控制和可复制的环境中模拟了真实的3D世界。

Code and dataset are available at https:// mesunhlf.github.io/index_physical.html.

1. Introduction

看看人家是怎么引得

Current mainstream works focus on the digital domain, which can be hardly transferred to the real world due to the lack of considering physical constraints (e.g., invariant to different environmental conditions such as viewpoint, lighting)

Compared with previous works [3, 12, 1] which mostly focus on attacking image classification systems, we consider the far more realistic computer vision scenario, i.e., object detection.

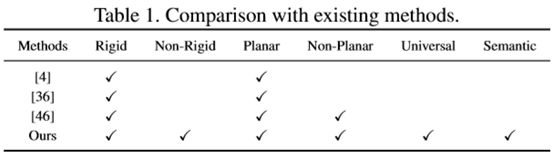

Though prior works have revealed the vulnerability of object detectors to adversarial perturbations in the real world [4, 36, 46], there are several limitations:

(1) focusing on only attacking a specific object (e.g. a stop sign [6, 4], commercial logo [35] or car [46]); 聚焦于攻击特定目标

(2) generating perturbations only for rigid or planar objects (e.g., traffic sign, vehicle body, board [39]), which can be less effective for complex objects (articulated non-rigid or non-planar objects, e.g., human). 不鲁棒

(3)constructing meaning less which lack semantics and appear unnatural for human observers (i.e., noisy or mosaic-like texture) [4, 39, 46]; and 不自然

(4) a unified evaluation environment is missing, which makes it difficult to make fair comparisons between different attacks. 很难评估

(不鲁棒、不自然,人家是怎么发的论文。。。。)

与以往产生实例级扰动的工作不同,UPC构建了一个通用模式,通过共同攻击区域建议网络、分类器和回归器来攻击属于同一类别的所有实例(例如person、cars)。

贡献:

- 提出了一个通用的躲避模式用于有效的攻击目标检测器,纹理自然有如配件;

- 提出了一个3d模拟数据集,AtackScenes

- 鲁棒性变换,用于非刚性、非平面

- 实现最有效攻击,且具有泛化和可转移性。

2. Methodology

攻击faster-rcnn,联合愚弄区域提议网络,使其产生低质量的提议,同时攻击分类及回归器,使其输出错误。

如上图a,UPC分为3步:

Step 1:图像合成:扰动变换、优化限制;

Step 2:RPN攻击更新对抗块;

Step 3:联合分类及回归攻击;

3.2. Physical Simulation

材料限制:为了使生成的对抗图案不那么明显,扰动被伪装成人类饰品上的纹理图案(如服装、面具)。外部环境:光照、视角、位置和角度。

语义限制:受到数字攻击中的不可感知约束的启发,我们在优化过程中使用投影函数(Eq. 1)使生成的对抗模式在视觉上与自然图像相似。

![]()

δ表示对抗块,I为给定的自然图像,限制其扰动范围,使用∞范数控制,借鉴像素级别攻击;

![]()

训练集x生成对抗图像x^,Tr应用于整体图像的变换模拟,Tc用于对抗块的变换模拟。

3.3. RPN攻击

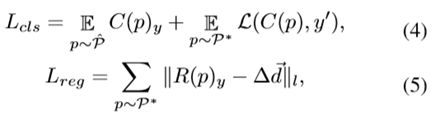

Si是box的置信分数,y1是背景,y0是前景;L为欧式距离,di为box坐标, 为预定义向量,攻击提议产生偏移及变形;

3.4. 分类及回归器攻击

L为交叉熵损失,C和R为分类器及回归器的预测输出,

3. AttackScenes Dataset

由于缺乏标准化的基准数据集,早期的工作是在不可复制的物理环境下度量性能,这使得在不同的攻击之间进行公平的比较变得困难。

Environments. 攻击场景包括20个不同物理条件下的虚拟场景(图3),其中10个室内场景(如浴室、客厅)和10个室外场景(如浴室、客厅,桥梁,市场)。

Camera Setting. 对于每个虚拟场景,放置了18个摄像头,从不同的视角捕捉图像。为了保证图像的多样性,这些相机被放置在不同的角度、高度和距离上。

Illumination Control. 我们扩展了测试环境,以更好地模拟不同的日常时间,如傍晚和黎明。区域光源和方向光源分别用来模拟室内和室外照明。

4. Experiments

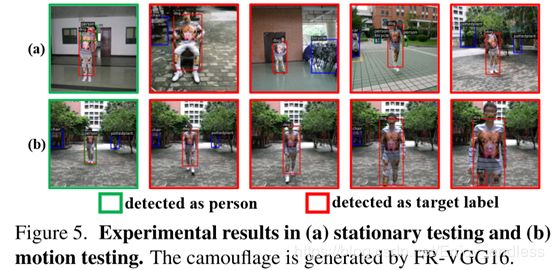

物理环境真实应用:

附录

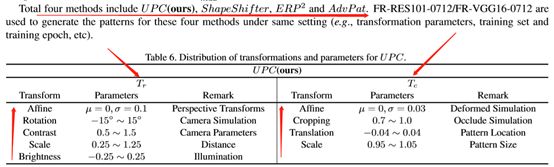

鲁棒性变换:

图像变换Tr: 仿射变换、旋转、对比度、大小、亮度

对抗块变换Tc:仿射变换、裁剪、平移、大小

这里的鲁棒性变换很常见,并无新的贡献。。。

我个人总结

论文贡献:

- 联合攻击RPN及分类和回归器;

- 鲁棒性变换得组合;

- 虚拟3d数据集;

- 详尽实验对比。

不足:

- 联合攻击,很常见;无创新

- 鲁棒性变换很常见;无创新

- 虚拟3d数据集,真正用处有多大,不好说

综合来说,是一篇实验比较详尽的论文。

有一个思想不错:借鉴像素级别对抗攻击,在给定图像上进行人眼不可见的扰动,实现对抗攻击。之前是在对抗块上,直接loss回传更新,没有控制。这里结合了像素级及对抗块级攻击,算是一个创新点。(这一点创新在文章中并没有点出来,只是简单的归结于隐蔽性)

(和GAN生成的区别??对比优缺点??)

不过最后生成的对抗图像的效果,确实还是不尽人意的。整的满身或者满车身,花儿胡绍。