百度飞桨(Python+AI)入门

第一次参加百度飞桨深度学习Python+AI的打卡训练营,整体课程由浅入深,连续每晚通过B站直播方式向我们介绍理论基础及实践操作,并且通过实践作业打卡和及时讲解让我们巩固知识的同时又能查漏补缺。

百度AIStudio:https://aistudio.baidu.com/aistudio/index

想必大家最近都有在追《青春有你2》,你pick谁呢?

(当然是Lisa小仙女啦!)

巧了,本次训练营的主题是对《青春有你2》小姐姐选手的信息爬取,数据分析,图像识别和对视频下方评论的综合运用。

当然,学习这些之前需要具备一定的Python基础语法知识,尤其需要注意格式!

文章目录

- 一、基础准备

- 爬虫的过程:

- 实现工具:

- 二、爬取109位小姐姐信息

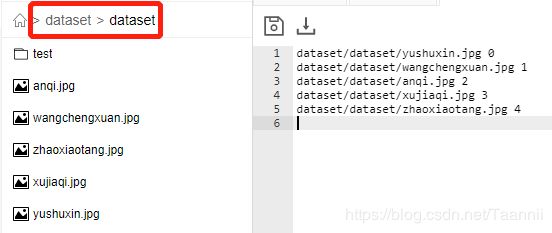

- 三、爬取并保存小姐姐们的美照

- 四、对小姐姐体重分布进行可视化

- 五、人脸识别

一、基础准备

深度学习的过程:

我们需要收集大量的数据,尤其是有标签的。如何才能高效获取数据呢?这就需要我们学会爬虫,Python为此提供实现的工具:requests模块和BeautifulSoup库

爬虫的过程:

1.发送请求(requests模块)

2.获取响应数据(服务器返回)

3.解析并提取数据(BeautifulSoup查找或者re正则)

4.保存数据

实现工具:

requests 是Python实现简单易用的HTTP库,详情可参照官网:https://requests.readthedocs.io/zh_CN/latest/

requests.get(url) 可以发送一个http get请求,返回服务器响应内容。

BeautifulSoup 是一个可以从HTML或XML文件中提取数据的Python库,详情可参照官网:https://beautifulsoup.readthedocs.io/zh_CN/v4.4.0/

BeautifulSoup(markup, “lxml”) lxml作为解析器,效率更高。

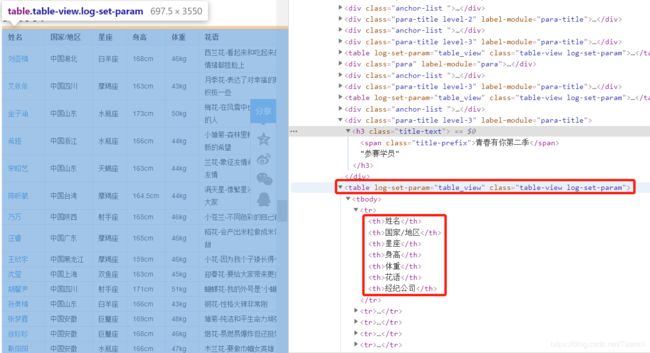

二、爬取109位小姐姐信息

import json

import re

import requests

import datetime

from bs4 import BeautifulSoup

import os

#获取当天的日期,并进行格式化,用于后面文件命名,格式:20200420

today = datetime.date.today().strftime('%Y%m%d')

def crawl_wiki_data():

"""

爬取百度百科中《青春有你2》中参赛选手信息,返回html

"""

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/67.0.3396.99 Safari/537.36'

}

url='https://baike.baidu.com/item/青春有你第二季'

try:

response = requests.get(url,headers=headers)

print(response.status_code)

#将一段文档传入BeautifulSoup的构造方法,就能得到一个文档的对象, 可以传入一段字符串

soup = BeautifulSoup(response.text,'lxml')

#返回的是class为table-view log-set-param的