相机像素尺寸(像元大小)和成像系统分辨率之间的关系

相机像素尺寸(像元大小)和成像系统分辨率之间的关系

在显微成像系统中,常常会用分辨率来评价其成像能力的好坏。这里的分辨率通常是指光学系统的极限分辨率以及成像探测器的图像分辨率。最终图像所呈现出的实际分辨率,取决于二者的综合影响。过高的光学分辨率如果没有足够精细的图像分辨率来体现,则实际分辨率会降低到图像分辨率以下;如果相机解析能力过高但光学系统的分辨率低,同样也看不清物体的精细结构。所以在选择相机的时候,我们也不妨根据自己这套系统需要达到的分辨率来综合考虑一下(实操性的结论部分请直接移动到文章最下方)。

1. 光学系统的分辨率

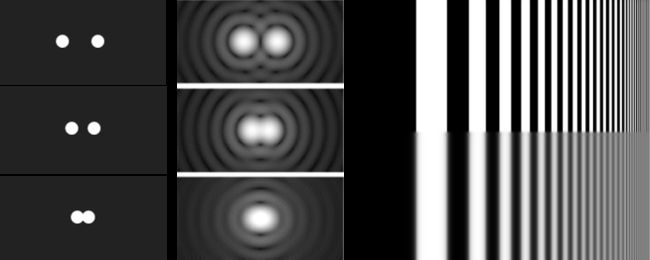

光学系统的分辨率,是指“物”在经过光学系统后的“像”在细节上能被分辨的最小距离。一般我们会用光学系统所能分辨的两个像点的最小距离来表示,大于这个距离的两个像点就能被识别为两个点,而小于这个距离的两个点经过光系统后就会被识别为一个点。而对于黑白图样(荧光样品其实也是一种黑白图样)来说,这个分辨能力也可以用单位距离里内能够分辨的黑白线对数来表示,间隔越宽的黑白条纹越容易分别(想象一下细胞的Lamellipodia和Filopodia的差别)。

图一 从"物"到"像"的失真

存在这个分辨率的原因是因为光学系统的衍射和像差导致从“物”到“像”的过程中会发生“失真”。这种失真是空间上高频信号丢失所导致的(光学系统可以看作是一个空间上的低通滤波器,只能允许一定带宽范围内的空间频率信号通过),通俗的理解就是削弱了由“黑”到“白”过渡的锐度和对比度,使其变得平滑和模糊。下图所示,黑白条纹的真实灰度可以用一个方波信号表示。在经过光学系统之后,如图像 A 和下方波形所示,原始信号被“平滑”,方波的每一个峰都展宽成一个贝塞尔峰,黑白相交处的信号变化斜率下降到一个固定水平(这个斜率的下降就是以该系统带宽所做的滤波效果)。当我们将原始条纹变的密集(增加空间频率),该系统仍以固定带宽进行滤波,这样这些被展宽的峰就会互相交叠,损失重叠部分的对比度从而产生图像B的效果。如果我们换一个带宽更宽的系统 2,其信号的高频部分会被更好的保留,表现为黑白交界处的信号变化斜率更大,对比度也越接近真实情况,如图像 B'。

回归到我们熟悉的生物荧光成像,上述分辨率的概念通过瑞利判据与样品的发射光波长和光学系统的数值孔径相联系起来。即在传统宽场荧光下,光学系统的极限分辨率 d = 0.6λ/NA,波长越短,NA值越大,分辨率越高(可以理解为对空间高频信号的保留越充分)。

2. 相机的图像分辨率

说完了光学系统的分辨率之后我们来看看相机的图像分辨率。图像分辨率比较好理解,就是单位距离内的像用多少个像素来显示。以我们的ORCA-Flash4.0为例,芯片的像元大小为 6.5 μm,在 40X物镜的放大倍率下,1 μm的物经光学系统放大为 40 μm的像,这样的像会由 40/6.5 = 6.15 个像素来显示,所以图像分辨率为 6.15 pixel/μm。反推回实际物体,则图像中的一个像素点表示的实际距离为 1/6.15 = 162 nm (其实就是像元尺寸/放大倍数)。根据这个原理,我们可以得出像元尺寸越小,其图像分辨率越高。

3. 相机采样与光学分辨率的匹配关系

那么要使整个系统达到光学上的极限分辨率,我们要如何选择成像系统使其图像分辨率相匹配呢? 这里还需要借助上图中黑白条纹的例子。图中不管是图像 A,B还是 B‘,其图像在x方向上的灰度都可以用图像下方的波形图来展示。相机的芯片则会在该方向上以像元尺寸为单位距离均匀对曲线作积分,得到每个像素的数值。这个过程就是对一个连续信号的离散采样。因为芯片上的像素以固定的距离排列,所以这个采样在空间上的采样周期 l 对应的就是像元尺寸(更准确的说是两像素中心点的间距,因为需要考虑芯片的填充因子),其频率就是单位距离内像素点的个数。上述黑白条纹图样的空间频率就是白色/黑色条纹重复出现的频率,而其条纹间距就是他们在空间上的周期 d。频率越高,这个周期 d 就越短。根据Nyquist采样定理(可参考:https://www.zhihu.com/question/24490634),我们需要以连续信号最高频率的2倍作为离散采样的频率,才能刚好还原连续信号的特征。因此我们所需要的芯片采样周期 l,就应该小于等于条纹间距 d 的一半。同样类推到相距很近的两个物点也是如此。如此这样一来我们就能够将光学极限分辨率和像元尺寸联系在一起了。对于生物成像系统,光学上的极限分辨率就是荧光信号变化的最大频率所对应的空间周期 d = 0.6λ/NA,因此像元尺寸 l = d × 放大倍数/2 (注意物点在经过物镜放大后的像点的距离是d × 放大倍数)。

图三 "像"的空间频率和相机的采样频率

1. 已有显微镜和相机,希望知道当前成像系统的分辨率究竟是多少

我们可以用木桶理论来考虑这个问题。光学系统的分辨率(光学分辨率)和相机的图像分辨率是整个成像系统分辨率这个“木桶”上的两块“木板”;成像系统的分辨率等于这两块“木板”上比较差的那个。

对于显微镜:

光学分辨率=0.61*λ/NA。

其中λ为波长(对于荧光显微镜,就是荧光探针的发射波长);NA为物镜的数值孔径(可以在物镜上找到)。

相机的图像分辨率=2*像元大小/放大倍数

举一个具体的例子:一台荧光显微镜,采用NA1.4的63倍油镜,光路中没有其他放大;观察509nm的绿色荧光样品。

(1) 采用滨松Flash 4.0相机,像元大小为6.5um。其光学分辨率为:

光学分辨率 = 0.61*509nm/1.4 = 222nm

其相机的图像分辨率为:

相机的图像分辨率 = 2*6.5um/63 = 206nm

比较二者,光学分辨率较差(即数值较大),所以整个系统的分辨率是受限于光学分辨率的,为222nm。

(2) 如果采用的是一款11um的相机。其光学分辨率不变,仍为:

光学分辨率 = 0.61*509nm/1.4 = 222nm

但其相机的图像分辨率为:

相机的图像分辨率 = 2*6.5um/63 = 349nm

比较二者,相机的图像分辨率较差(即数值较大),所以整个系统的分辨率是受限于相机像素大小的,为349nm。

2. 已有显微镜,希望知道从成像分辨率的角度如何选择相机

首先强调,以下建议仅仅是从成像分辨率的角度。在选择相机时,信噪比常常是更加关键的考量。

我们以GFP的发射波长 λ = 509 nm为例,在使用不同放大倍率的常用显微镜物镜时,其光学极限分辨率和对应的相机芯片像元尺寸匹配如下表:

原则上来说,实际选用的像元大小应小于理想像元大小,像元越小对细节的解析越好(但是小于理想值的1/2以后就无显著性改善了)。

但是从图像信噪比的角度来说,像元越大能够得到更高的信噪比。不同相机除了在像元大小上有所差别,在灵敏度、噪音等方面也是不尽相同。所以在选择成像系统时要充分考虑实际情况来进行多种条件的平衡与取舍。