- 【华为OD技术面试真题 - 技术面】- python八股文真题题库(1)

算法大师

华为od面试python

华为OD面试真题精选专栏:华为OD面试真题精选目录:2024华为OD面试手撕代码真题目录以及八股文真题目录文章目录华为OD面试真题精选1.数据预处理流程数据预处理的主要步骤工具和库2.介绍线性回归、逻辑回归模型线性回归(LinearRegression)模型形式:关键点:逻辑回归(LogisticRegression)模型形式:关键点:参数估计与评估:3.python浅拷贝及深拷贝浅拷贝(Shal

- Python实现简单的机器学习算法

master_chenchengg

pythonpython办公效率python开发IT

Python实现简单的机器学习算法开篇:初探机器学习的奇妙之旅搭建环境:一切从安装开始必备工具箱第一步:安装Anaconda和JupyterNotebook小贴士:如何配置Python环境变量算法初体验:从零开始的Python机器学习线性回归:让数据说话数据准备:从哪里找数据编码实战:Python实现线性回归模型评估:如何判断模型好坏逻辑回归:从分类开始理论入门:什么是逻辑回归代码实现:使用skl

- 七.正则化

愿风去了

吴恩达机器学习之正则化(Regularization)http://www.cnblogs.com/jianxinzhou/p/4083921.html从数学公式上理解L1和L2https://blog.csdn.net/b876144622/article/details/81276818虽然在线性回归中加入基函数会使模型更加灵活,但是很容易引起数据的过拟合。例如将数据投影到30维的基函数上,模

- 机器学习VS深度学习

nfgo

机器学习

机器学习(MachineLearning,ML)和深度学习(DeepLearning,DL)是人工智能(AI)的两个子领域,它们有许多相似之处,但在技术实现和应用范围上也有显著区别。下面从几个方面对两者进行区分:1.概念层面机器学习:是让计算机通过算法从数据中自动学习和改进的技术。它依赖于手动设计的特征和数学模型来进行学习,常用的模型有决策树、支持向量机、线性回归等。深度学习:是机器学习的一个子领

- Python实现梯度下降法

闲人编程

pythonpython开发语言梯度下降算法优化

博客:Python实现梯度下降法目录引言什么是梯度下降法?梯度下降法的应用场景梯度下降法的基本思想梯度下降法的原理梯度的定义学习率的选择损失函数与优化问题梯度下降法的收敛条件Python实现梯度下降法面向对象的设计思路代码实现示例与解释梯度下降法应用实例:线性回归场景描述算法实现结果分析与可视化梯度下降法的改进版本随机梯度下降(SGD)小批量梯度下降(Mini-batchGradientDesce

- 12312312

二进制掌控者

c++

c语言中的小小白-CSDN博客c语言中的小小白关注算法,c++,c语言,贪心算法,链表,mysql,动态规划,后端,线性回归,数据结构,排序算法领域.https://blog.csdn.net/bhbcdxb123?spm=1001.2014.3001.5343给大家分享一句我很喜欢我话:知不足而奋进,望远山而前行!!!铁铁们,成功的路上必然是孤独且艰难的,但是我们不可以放弃,远山就在前方,但我们

- 你知道什么是回调函数吗?

二进制掌控者

#C语言专栏c语言开发语言

c语言中的小小白-CSDN博客c语言中的小小白关注算法,c++,c语言,贪心算法,链表,mysql,动态规划,后端,线性回归,数据结构,排序算法领域.https://blog.csdn.net/bhbcdxb123?spm=1001.2014.3001.5343给大家分享一句我很喜欢我话:知不足而奋进,望远山而前行!!!铁铁们,成功的路上必然是孤独且艰难的,但是我们不可以放弃,远山就在前方,但我们

- 百行代码复现扩散模型-基于线性回归

李新然

数据统计分析深度学习线性回归算法回归python数据分析

文章目录引言简化模型原本模型模型改造实现过程数据集文本编码图像编码解码扩散过程训练过程生成过程完整实现结论引言多模态的深度学习模型,通常需要大量的算力去训练和验证。这导致缺乏算力的普通读者,阅读“大模型”论文,只能按论文作者所写来构造自己的认知。可能对很多类似笔者的人来说:纸上得来终觉浅。或许我们可以退而求其次,只选择Follow论文的思路。本文以DiffusionModel为例,说明从核心思想来

- 【机器学习】广义线性模型(GLM)的基本概念以及广义线性模型在python中的实例(包含statsmodels和scikit-learn实现逻辑回归)

Lossya

机器学习pythonscikit-learn线性回归人工智能逻辑回归

引言GLM扩展了传统的线性回归模型,使其能够处理更复杂的数据类型和分布文章目录引言一、广义线性模型1.1定义1.2广义线性模型的组成1.2.1响应变量(ResponseVariable)1.2.2链接函数(LinkFunction)1.2.3线性预测器(LinearPredictor)1.3常见的广义线性模型1.3.1线性回归1.3.2逻辑回归1.3.3泊松回归1.4GLM的特性1.5广义线性模型

- 惩罚线性回归模型

媛苏苏

算法/模型/函数线性回归算法回归

惩罚线性回归模型是一种常见的线性回归的变体,它在原始的线性回归模型中引入了一种惩罚项,以防止模型过拟合数据。在惩罚线性回归中,除了最小化预测值与实际值之间的平方误差(或其他损失函数)外,还会考虑模型参数的大小。惩罚项通常被加到模型的损失函数中,以限制模型参数的大小。这样做有助于减少模型对训练数据的过度拟合,提高模型的泛化能力。常见的惩罚线性回归模型包括:岭回归(RidgeRegression):岭

- L2正则线性回归(岭回归)

一壶浊酒..

深度学习回归线性回归

岭回归数据的特征比样本点还多,非满秩矩阵在求逆时会出现问题岭回归即我们所说的L2正则线性回归,在一般的线性回归最小化均方误差的基础上增加了一个参数w的L2范数的罚项,从而最小化罚项残差平方和简单说来,岭回归就是在普通线性回归的基础上引入单位矩阵。回归系数的计算公式变形如下岭回归最先用来处理特征数多于样本数的情况,现在也用于在估计中加入偏差,从而得到更好的估计。这里通过引入λ来限制了所有w之和,通过

- 通俗理解线性回归(Linear Regression)

小夏refresh

机器学习数据挖掘机器学习算法人工智能数据挖掘

线性回归,最简单的机器学习算法,当你看完这篇文章,你就会发现,线性回归是多么的简单.首先,什么是线性回归.简单的说,就是在坐标系中有很多点,线性回归的目的就是找到一条线使得这些点都在这条直线上或者直线的周围,这就是线性回归(LinearRegression).是不是有画面感了?那么我们上图片:![1.png][1]那么接下来,就让我们来看看具体的线性回归吧首先,我们以二维数据为例:我们有一组数据x

- 理论+实践,一文带你读懂线性回归的评价指标

木东居士

关于作者:饼干同学,某人工智能公司交付开发工程师/建模科学家。专注于AI工程化及场景落地,希望和大家分享成长中的专业知识与思考感悟。0x00前言:本篇内容是线性回归系列的第三篇。在《模型之母:简单线性回归&最小二乘法》、《模型之母:简单线性回归&最小二乘法》中我们学习了简单线性回归、最小二乘法,并完成了代码的实现。在结尾,我们抛出了一个问题:在之前的kNN算法(分类问题)中,使用分类准确度来评价算

- 第12周数学建模作业

WinterCruel

数学建模

第12周数学建模作业1、考察温度x对产量y的影响,测得下列10组数据:温度(℃)20253035404550556065产量(kg)13.215.116.417.117.918.719.621.222.524.3求y关于x的线性回归方程,检验回归效果是否显著,并预测x=42℃时产量的估值.Matlab代码:x=[20,25,30,35,40,45,50,55,60,65];y=[13.2,15.1

- 多元线性回归 python实现

雪可问春风

python机器学习numpy

importnumpyasnp#多元线性回归x=np.matrix([[2104,1416,1534,852,1],[5,3,3,2,1],[1,2,2,1,1],[45,40,30,36,1]])y=np.matrix([460,232,315,178])y1=np.matrix([460],[232].[315],[178])w=(x.T*x).I*x.T*yw1=(x.T*x).I*x.T*

- 机器学习100天-Day2503 Tensorboard 训练数据可视化(线性回归)

我的昵称违规了

首页.jpg源代码来自莫烦python(https://morvanzhou.github.io/tutorials/machine-learning/tensorflow/4-1-tensorboard1/)今日重点读懂教程中代码,手动重写一遍,在浏览器中获取到训练数据Tensorboard是一个神经网络可视化工具,通过使用本地服务器在浏览器上查看神经网络训练日志,生成相应的可是画图,帮助炼丹师

- R实现线性回归逻辑回归

weixin_55475210

r语言线性回归逻辑回归

线性回归基本模型Y=β0+β1X1+β2X2+⋯+βmXm+ϵY=\beta_0+\beta_1X_1+\beta_2X_2+\cdots+\beta_mX_m+\epsilonY=β0+β1X1+β2X2+⋯+βmXm+ϵYYY为因变量X1,X2,…,XmX_1,X_2,\ldots,X_mX1,X2,…,Xm为m个自变量ϵ\epsilonϵ为残差lm()函数用于完成多元线性回归系数估计,回归系

- C#语言实现最小二乘法算法

2401_86528135

算法c#最小二乘法

最小二乘法(LeastSquaresMethod)是一种常用的拟合方法,用于在数据点之间找到最佳的直线(或其他函数)拟合。以下是一个用C#实现简单线性回归(即一元最小二乘法)的示例代码。1.最小二乘法简介对于一组数据点(x1,y1),(x2,y2),…,(xn,yn)(x_1,y_1),(x_2,y_2),\ldots,(x_n,y_n)(x1,y1),(x2,y2),…,(xn,yn),最小二乘

- 2024国赛数学建模备战-数学建模思想方法大全及方法适用范围

V建模忠哥V

2024国赛数学建模

第一篇:方法适用范围一、统计学方法1.1多元回归1、方法概述:在研究变量之间的相互影响关系模型时候,用到这类方法,具体地说:其可以定量地描述某一现象和某些因素之间的函数关系,将各变量的已知值带入回归方程可以求出因变量的估计值,从而可以进行预测等相关研究。2、分类分为两类:多元线性回归和非线性线性回归;其中非线性回归可以通过一定的变化转化为线性回归,比如:y=lnx可以转化为y=uu=lnx来解决;

- 从0开始深度学习(4)——线性回归概念

青石横刀策马

从头学机器学习深度学习神经网络人工智能

1线性回归回归(regression)指能为一个或多个自变量与因变量之间的关系进行建模。1.1线性模型线性假设是指目标可以表示为特征的加权和,以房价和面积、房龄为例,可以有下面的式子:w称为权重(weight)b称为偏置(bias)、偏移量(offset)或截距(intercept)给定一个数据集,我们的目标是寻找模型的权重和偏置,使得根据模型做出的预测大体符合数据里的真实价格。1.2损失函数在我

- 线性回归(1)——起源

Magina507

几乎所有的科学观察都着了魔似的向平均值回归——《女士品茶》什么是线性回归线性回归这个概念是由达尔文的表弟高尔顿在研究父代与子代身高关系的时候提出的,我第一次看到这四个字的时候,心中暗骂,这起的什么破名,一点都不直观。什么叫线性?什么叫回归?你在进行什么骚操作啊。然而这两个概念其实准确表达了该算法的核心思想,只要解释明白了这两个概念,我们就搞明白了线性回归。线性高尔顿搜集了1078对父亲及其儿子的身

- 计算机毕业设计hadoop+spark知识图谱房源推荐系统 房价预测系统 房源数据分析 房源可视化 房源大数据大屏 大数据毕业设计 机器学习

计算机毕业设计大全

创新点:1.支付宝沙箱支付2.支付邮箱通知(JavaMail)3.短信验证码修改密码4.知识图谱5.四种推荐算法(协同过滤基于用户、物品、SVD混合神经网络、MLP深度学习模型)6.线性回归算法预测房价7.Python爬虫采集链家数据8.AI短信识别9.百度地图API10.lstm情感分析11.spark大屏可视化开发技术:springbootvue.jspythonechartssparkmys

- Logistic分类算法原理及Python实践

doublexiao79

数据分析与挖掘分类python数据挖掘

一、Logistic分类算法原理Logistic分类算法,也称为逻辑回归(LogisticRegression),是机器学习中的一种经典分类算法,主要用于解决二分类问题。其原理基于线性回归和逻辑函数(Sigmoid函数)的组合,能够将输入特征的线性组合映射到一个概率范围内,从而进行分类预测。以下是Logistic分类算法的主要原理:1.线性组合首先,对于输入的n个特征,我们将其表示为一个n维的列向

- Spark MLlib LinearRegression线性回归算法源码解析

SmileySure

Spark人工智能算法SparkMLlib

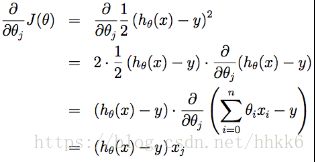

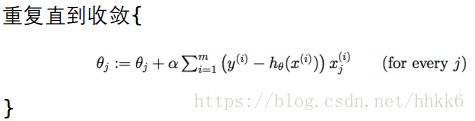

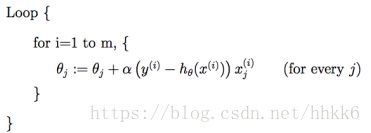

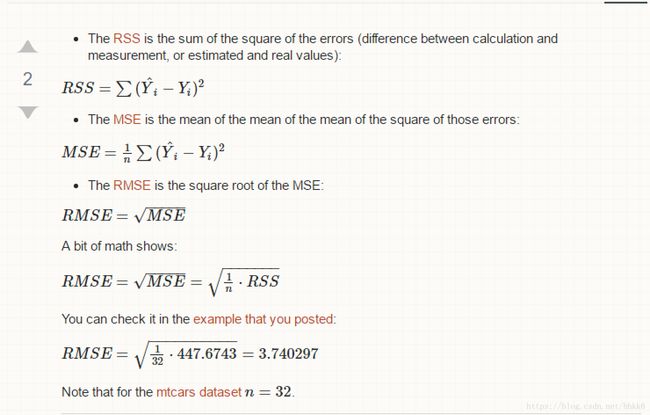

线性回归一元线性回归hθ(x)=θ0+θ1xhθ(x)=θ0+θ1x——————–1多元线性回归hθ(x)=∑mi=1θixi=θTXhθ(x)=∑i=1mθixi=θTX—————–2损失函数J(θ)=1/2∑mi=1(hθ(xi)−yi)2J(θ)=1/2∑i=1m(hθ(xi)−yi)2—————31/2是为了求导时系数为1,平方里是真实值减去估计值我们的目的就是求其最小值最小二乘法要求较为

- Spark MLlib模型训练—回归算法 GLR( Generalized Linear Regression)

猫猫姐

Spark实战回归spark-ml线性回归spark

SparkMLlib模型训练—回归算法GLR(GeneralizedLinearRegression)在大数据分析中,线性回归虽然常用,但在许多实际场景中,目标变量和特征之间的关系并非线性,这时广义线性回归(GeneralizedLinearRegression,GLR)便应运而生。GLR是线性回归的扩展,能够处理非正态分布的目标变量,广泛用于分类、回归以及其他统计建模任务。本文将深入探讨Spar

- 机器学习(2)单变量线性回归

天凉玩个锤子

2.1模型表示我们学习的第一个算法是线性回归算法。在监督学习中,我们有一个数据集,这个数据集被称为训练集(TrainingSet)。我们用小写字母m来表示训练样本的数目。监督学习算法的工作方式以房屋价格的训练为例,将训练集里房屋价格喂给学习算法,学习算法工作后输出一个函数h,h代表hypothesis(假设)。函数h输入为房屋尺寸大小x,h根据输入来得出y值,y值对应房子的价格。因此,h是一个从x

- 【ShuQiHere】《机器学习的进化史『下』:从神经网络到深度学习的飞跃》

ShuQiHere

机器学习深度学习神经网络

【ShuQiHere】引言:神经网络与深度学习的兴起在上篇文章中,我们回顾了机器学习的起源与传统模型的发展历程,如线性回归、逻辑回归和支持向量机(SVM)。然而,随着数据规模的急剧增长和计算能力的提升,传统模型在处理复杂问题时显得力不从心。在这种背景下,神经网络重新进入了研究者们的视野,并逐步演变为深度学习,成为解决复杂问题的强大工具。今天,我们将进一步探索从神经网络到深度学习的进化历程,揭示这些

- 【ShuQiHere】《机器学习的进化史『上』:从数学模型到智能算法的百年征程》

ShuQiHere

机器学习人工智能

【ShuQiHere】引言:概述机器学习的演进机器学习的发展史是一段从数学基础到智能算法的演进历程。从19世纪的数学探索,到20世纪的计算革命,再到21世纪的智能算法应用,机器学习模型的演化贯穿了科学进步的每个重要阶段。这篇博客将系统回顾这些模型的历史演进,展示它们之间的联系,并探讨其在现代应用中的重要性。线性回归:机器学习的起点背景故事:1805年的法国,年轻的数学家Adrien-MarieLe

- 机器学习(ML)算法分类

活蹦乱跳酸菜鱼

机器学习

机器学习(ML)算法是一个广泛而多样的领域,涵盖了多种用于数据分析和模式识别的技术。以下是一些常见的机器学习算法分类及其具体算法:一、监督学习算法监督学习算法使用标记(即已知结果)的训练数据来训练模型,以便对新数据进行预测。线性回归:用于建立连续变量之间的关系,通过拟合一条直线或超平面来预测新数据的输出值。逻辑回归:虽然名称中包含“回归”,但实际上是用于分类问题,特别是二分类问题。通过将线性回归模

- 探索数据世界的钥匙:机器学习中的线性回归

程序员-李旭亮

机器学习

在浩瀚的数据海洋中,寻找隐藏的模式与规律,一直是科学家、工程师乃至各行各业决策者们的共同追求。而机器学习,作为这一领域的璀璨明珠,以其强大的数据分析与预测能力,正逐步改变着我们的世界。在众多机器学习算法中,线性回归以其简洁、直观、易于理解的特点,成为了入门机器学习的首选,更是解决回归问题的一把金钥匙。一、线性回归:定义与原理线性回归,顾名思义,是一种通过线性模型来预测一个或多个自变量(X)与因变量

- 异常的核心类Throwable

无量

java源码异常处理exception

java异常的核心是Throwable,其他的如Error和Exception都是继承的这个类 里面有个核心参数是detailMessage,记录异常信息,getMessage核心方法,获取这个参数的值,我们可以自己定义自己的异常类,去继承这个Exception就可以了,方法基本上,用父类的构造方法就OK,所以这么看异常是不是很easy

package com.natsu;

- mongoDB 游标(cursor) 实现分页 迭代

开窍的石头

mongodb

上篇中我们讲了mongoDB 中的查询函数,现在我们讲mongo中如何做分页查询

如何声明一个游标

var mycursor = db.user.find({_id:{$lte:5}});

迭代显示游标数

- MySQL数据库INNODB 表损坏修复处理过程

0624chenhong

tomcatmysql

最近mysql数据库经常死掉,用命令net stop mysql命令也无法停掉,关闭Tomcat的时候,出现Waiting for N instance(s) to be deallocated 信息。查了下,大概就是程序没有对数据库连接释放,导致Connection泄露了。因为用的是开元集成的平台,内部程序也不可能一下子给改掉的,就验证一下咯。启动Tomcat,用户登录系统,用netstat -

- 剖析如何与设计人员沟通

不懂事的小屁孩

工作

最近做图烦死了,不停的改图,改图……。烦,倒不是因为改,而是反反复复的改,人都会死。很多需求人员不知该如何与设计人员沟通,不明白如何使设计人员知道他所要的效果,结果只能是沟通变成了扯淡,改图变成了应付。

那应该如何与设计人员沟通呢?

我认为设计人员与需求人员先天就存在语言障碍。对一个合格的设计人员来说,整天玩的都是点、线、面、配色,哪种构图看起来协调;哪种配色看起来合理心里跟明镜似的,

- qq空间刷评论工具

换个号韩国红果果

JavaScript

var a=document.getElementsByClassName('textinput');

var b=[];

for(var m=0;m<a.length;m++){

if(a[m].getAttribute('placeholder')!=null)

b.push(a[m])

}

var l

- S2SH整合之session

灵静志远

springAOPstrutssession

错误信息:

Caused by: org.springframework.beans.factory.BeanCreationException: Error creating bean with name 'cartService': Scope 'session' is not active for the current thread; consider defining a scoped

- xmp标签

a-john

标签

今天在处理数据的显示上遇到一个问题:

var html = '<li><div class="pl-nr"><span class="user-name">' + user

+ '</span>' + text + '</div></li>';

ulComme

- Ajax的常用技巧(2)---实现Web页面中的级联菜单

aijuans

Ajax

在网络上显示数据,往往只显示数据中的一部分信息,如文章标题,产品名称等。如果浏览器要查看所有信息,只需点击相关链接即可。在web技术中,可以采用级联菜单完成上述操作。根据用户的选择,动态展开,并显示出对应选项子菜单的内容。 在传统的web实现方式中,一般是在页面初始化时动态获取到服务端数据库中对应的所有子菜单中的信息,放置到页面中对应的位置,然后再结合CSS层叠样式表动态控制对应子菜单的显示或者隐

- 天-安-门,好高

atongyeye

情感

我是85后,北漂一族,之前房租1100,因为租房合同到期,再续,房租就要涨150。最近网上新闻,地铁也要涨价。算了一下,涨价之后,每次坐地铁由原来2块变成6块。仅坐地铁费用,一个月就要涨200。内心苦痛。

晚上躺在床上一个人想了很久,很久。

我生在农

- android 动画

百合不是茶

android透明度平移缩放旋转

android的动画有两种 tween动画和Frame动画

tween动画;,透明度,缩放,旋转,平移效果

Animation 动画

AlphaAnimation 渐变透明度

RotateAnimation 画面旋转

ScaleAnimation 渐变尺寸缩放

TranslateAnimation 位置移动

Animation

- 查看本机网络信息的cmd脚本

bijian1013

cmd

@echo 您的用户名是:%USERDOMAIN%\%username%>"%userprofile%\网络参数.txt"

@echo 您的机器名是:%COMPUTERNAME%>>"%userprofile%\网络参数.txt"

@echo ___________________>>"%userprofile%\

- plsql 清除登录过的用户

征客丶

plsql

tools---preferences----logon history---history 把你想要删除的删除

--------------------------------------------------------------------

若有其他凝问或文中有错误,请及时向我指出,

我好及时改正,同时也让我们一起进步。

email : binary_spac

- 【Pig一】Pig入门

bit1129

pig

Pig安装

1.下载pig

wget http://mirror.bit.edu.cn/apache/pig/pig-0.14.0/pig-0.14.0.tar.gz

2. 解压配置环境变量

如果Pig使用Map/Reduce模式,那么需要在环境变量中,配置HADOOP_HOME环境变量

expor

- Java 线程同步几种方式

BlueSkator

volatilesynchronizedThredLocalReenTranLockConcurrent

为何要使用同步? java允许多线程并发控制,当多个线程同时操作一个可共享的资源变量时(如数据的增删改查), 将会导致数据不准确,相互之间产生冲突,因此加入同步锁以避免在该线程没有完成操作之前,被其他线程的调用, 从而保证了该变量的唯一性和准确性。 1.同步方法&

- StringUtils判断字符串是否为空的方法(转帖)

BreakingBad

nullStringUtils“”

转帖地址:http://www.cnblogs.com/shangxiaofei/p/4313111.html

public static boolean isEmpty(String str)

判断某字符串是否为空,为空的标准是 str==

null

或 str.length()==

0

- 编程之美-分层遍历二叉树

bylijinnan

java数据结构算法编程之美

import java.util.ArrayList;

import java.util.LinkedList;

import java.util.List;

public class LevelTraverseBinaryTree {

/**

* 编程之美 分层遍历二叉树

* 之前已经用队列实现过二叉树的层次遍历,但这次要求输出换行,因此要

- jquery取值和ajax提交复习记录

chengxuyuancsdn

jquery取值ajax提交

// 取值

// alert($("input[name='username']").val());

// alert($("input[name='password']").val());

// alert($("input[name='sex']:checked").val());

// alert($("

- 推荐国产工作流引擎嵌入式公式语法解析器-IK Expression

comsci

java应用服务器工作Excel嵌入式

这个开源软件包是国内的一位高手自行研制开发的,正如他所说的一样,我觉得它可以使一个工作流引擎上一个台阶。。。。。。欢迎大家使用,并提出意见和建议。。。

----------转帖---------------------------------------------------

IK Expression是一个开源的(OpenSource),可扩展的(Extensible),基于java语言

- 关于系统中使用多个PropertyPlaceholderConfigurer的配置及PropertyOverrideConfigurer

daizj

spring

1、PropertyPlaceholderConfigurer

Spring中PropertyPlaceholderConfigurer这个类,它是用来解析Java Properties属性文件值,并提供在spring配置期间替换使用属性值。接下来让我们逐渐的深入其配置。

基本的使用方法是:(1)

<bean id="propertyConfigurerForWZ&q

- 二叉树:二叉搜索树

dieslrae

二叉树

所谓二叉树,就是一个节点最多只能有两个子节点,而二叉搜索树就是一个经典并简单的二叉树.规则是一个节点的左子节点一定比自己小,右子节点一定大于等于自己(当然也可以反过来).在树基本平衡的时候插入,搜索和删除速度都很快,时间复杂度为O(logN).但是,如果插入的是有序的数据,那效率就会变成O(N),在这个时候,树其实变成了一个链表.

tree代码:

- C语言字符串函数大全

dcj3sjt126com

cfunction

C语言字符串函数大全

函数名: stpcpy

功 能: 拷贝一个字符串到另一个

用 法: char *stpcpy(char *destin, char *source);

程序例:

#include <stdio.h>

#include <string.h>

int main

- 友盟统计页面技巧

dcj3sjt126com

技巧

在基类调用就可以了, 基类ViewController示例代码

-(void)viewWillAppear:(BOOL)animated

{

[super viewWillAppear:animated];

[MobClick beginLogPageView:[NSString stringWithFormat:@"%@",self.class]];

- window下在同一台机器上安装多个版本jdk,修改环境变量不生效问题处理办法

flyvszhb

javajdk

window下在同一台机器上安装多个版本jdk,修改环境变量不生效问题处理办法

本机已经安装了jdk1.7,而比较早期的项目需要依赖jdk1.6,于是同时在本机安装了jdk1.6和jdk1.7.

安装jdk1.6前,执行java -version得到

C:\Users\liuxiang2>java -version

java version "1.7.0_21&quo

- Java在创建子类对象的同时会不会创建父类对象

happyqing

java创建子类对象父类对象

1.在thingking in java 的第四版第六章中明确的说了,子类对象中封装了父类对象,

2."When you create an object of the derived class, it contains within it a subobject of the base class. This subobject is the sam

- 跟我学spring3 目录贴及电子书下载

jinnianshilongnian

spring

一、《跟我学spring3》电子书下载地址:

《跟我学spring3》 (1-7 和 8-13) http://jinnianshilongnian.iteye.com/blog/pdf

跟我学spring3系列 word原版 下载

二、

源代码下载

最新依

- 第12章 Ajax(上)

onestopweb

Ajax

index.html

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN" "http://www.w3.org/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="http://www.w3.org/

- BI and EIM 4.0 at a glance

blueoxygen

BO

http://www.sap.com/corporate-en/press.epx?PressID=14787

有机会研究下EIM家族的两个新产品~~~~

New features of the 4.0 releases of BI and EIM solutions include:

Real-time in-memory computing –

- Java线程中yield与join方法的区别

tomcat_oracle

java

长期以来,多线程问题颇为受到面试官的青睐。虽然我个人认为我们当中很少有人能真正获得机会开发复杂的多线程应用(在过去的七年中,我得到了一个机会),但是理解多线程对增加你的信心很有用。之前,我讨论了一个wait()和sleep()方法区别的问题,这一次,我将会讨论join()和yield()方法的区别。坦白的说,实际上我并没有用过其中任何一个方法,所以,如果你感觉有不恰当的地方,请提出讨论。

&nb

- android Manifest.xml选项

阿尔萨斯

Manifest

结构

继承关系

public final class Manifest extends Objectjava.lang.Objectandroid.Manifest

内部类

class Manifest.permission权限

class Manifest.permission_group权限组

构造函数

public Manifest () 详细 androi

- Oracle实现类split函数的方

zhaoshijie

oracle

关键字:Oracle实现类split函数的方

项目里需要保存结构数据,批量传到后他进行保存,为了减小数据量,子集拼装的格式,使用存储过程进行保存。保存的过程中需要对数据解析。但是oracle没有Java中split类似的函数。从网上找了一个,也补全了一下。

CREATE OR REPLACE TYPE t_split_100 IS TABLE OF VARCHAR2(100);

cr