TensorFlow2.0 卷积层实现

一、自定义权值

tf.nn.conv2d基于输入X: [batch_size,高,宽,通道数] 和卷积核W: [卷积核大小,卷积核大小 ,输入通道数,卷积核数量] 进行卷积运算,得到输出

O [batch_size,新的高,新的宽,卷积核数量]

import tensorflow as tf

x = tf.random.normal([2,5,5,3]) # 模拟输入,3 通道,高宽为5

# 需要根据[k,k,cin,cout]格式创建W 张量,4 个3x3 大小卷积核

w = tf.random.normal([3,3,3,4])

# 步长为1, padding 为0,

out = tf.nn.conv2d(x,w,strides=1,padding=[[0,0],[0,0],[0,0],[0,0]])其中padding 参数的设置格式为:padding=[[0,0],[上,下],[左,右],[0,0]]。例如,上下左右各padding 一个单位,则padding=[[0,0],[1,1],[1,1],[0,0]],实现如下:

x = tf.random.normal([2,5,5,3]) # 模拟输入,3 通道,高宽为5

# 需要根据[k,k,cin,cout]格式创建,4 个3x3 大小卷积核

w = tf.random.normal([3,3,3,4])

# 步长为1, padding 为1,

out = tf.nn.conv2d(x,w,strides=1,padding=[[0,0],[1,1],[1,1],[0,0]])二、卷积层类

在TensorFlow 中,API 的命名有一定的规律,首字母大写的对象一般表示类,全部小写的一般表示函数,如layers.Conv2D 表示卷积层类,nn.conv2d 表示卷积运算函数。使用类方式会(在创建类时或build 时)自动创建需要的权值张量和偏置向量,用户不需要记忆卷积核张量的定义格式,因此使用起来更简单方便,但是灵活性也较低。函数方式的接口需要自行定义权值和偏置等,更加灵活和底层。

在新建卷积层类时,只需要指定卷积核数量参数filters,卷积核大小kernel_size,步长strides,填充padding 等即可,如下创建了4 个3x3 大小的卷积核的卷积层,步长为1,padding 方案为'SAME'。创建完成后,通过调用实例(的__call__方法)即可完成前向计算:

layer = layers.Conv2D(4,kernel_size=3,strides=1,padding='SAME')

out = layer(x) # 前向计算

out.shape在类Conv2D 中,保存了卷积核张量W 和偏置b,可以通过类成员trainable_variables直接返回W,b 的列表 。

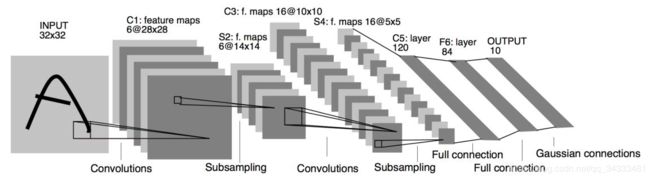

layer.trainable_variables三、实战:LeNet-5

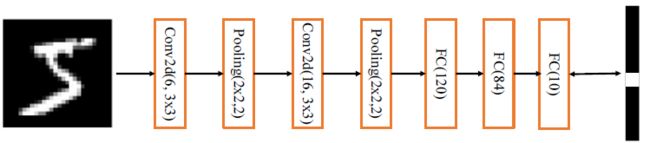

我们在 LeNet-5 的基础上进行了少许调整,使得它更容易在现代深度学习框架上实现。首先我们将输入X 形状由32x32 调整为28x28,然后将2 个下采样层实现为最大池化层(降低特征图的高、宽),最后利用全连接层替换掉Gaussian connections层。

from tensorflow.keras import Sequential,layers

import tensorflow as tf

network = Sequential([ # 网络容器

layers.Conv2D(6,kernel_size=3,strides=1), # 第一个卷积层, 6 个3x3 卷积核

layers.MaxPooling2D(pool_size=2,strides=2), # 高宽各减半的池化层

layers.ReLU(), # 激活函数

layers.Conv2D(16,kernel_size=3,strides=1), # 第二个卷积层, 16 个3x3 卷积核

layers.MaxPooling2D(pool_size=2,strides=2), # 高宽各减半的池化层

layers.ReLU(), # 激活函数

layers.Flatten(), # 打平层,方便全连接层处理

layers.Dense(120, activation='relu'), # 全连接层,120 个节点

layers.Dense(84, activation='relu'), # 全连接层,84 节点

layers.Dense(10) # 全连接层,10 个节点

])

# build 一次网络模型,给输入X 的形状,其中4 为随意给的batchsz

network.build(input_shape=(4, 28, 28, 1))

# 统计网络信息

network.summary()