爬虫让我再次在女同学面前长脸了~(现实版真实案例)

1. 文章背景:

鉴于这几天掉发情况,想着周末是多休息的啦,睡午觉的时候被微信滴滴来信给吵醒了,拿来一看,是那个女同学哦,简单看了一下,她主要表达的意思就是:“你能不能帮我 x x x x x x x ?(省略几百个字)”,身为一个男同学,你能说你不能嘛? m(o_ _)m

2. 前言:

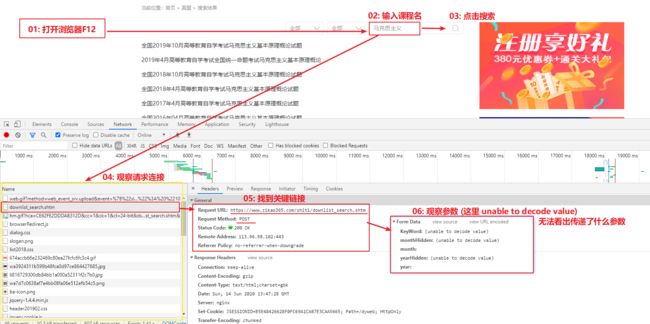

简单介绍一下 “需求” ,她希望我帮忙在 “自考365” 下载一批量的试题以及答案,如下图:

https://www.zikao365.com/shiti/downlist_search.shtm

3. 爬虫

了解到要实现的东西之后,就可以对网页进行解剖了,下面是具体步骤。

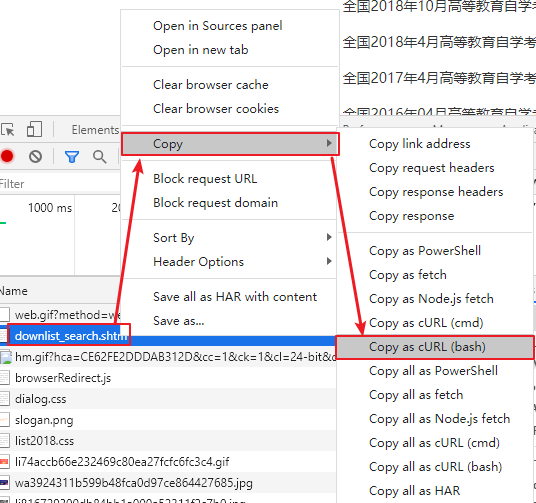

2.了解传递的参数

在浏览器抓包中我们看不到实际传递了哪些参数(unable to decode value),因此这里可以使用 Fiddler 进行抓包或者使用下面的一种方式,任意一种都行,看你喜欢了…

然后使用文本框粘贴刚才复制的内容:

curl 'https://www.zikao365.com/shiti/downlist_search.shtm' \

-H 'Connection: keep-alive' \

-H 'Cache-Control: max-age=0' \

-H 'Upgrade-Insecure-Requests: 1' \

-H 'Origin: https://www.zikao365.com' \

-H 'Content-Type: application/x-www-form-urlencoded' \

-H 'User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/83.0.4103.97 Safari/537.36' \

-H 'Accept: text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8,application/signed-exchange;v=b3;q=0.9' \

-H 'Sec-Fetch-Site: same-origin' \

-H 'Sec-Fetch-Mode: navigate' \

-H 'Sec-Fetch-User: ?1' \

-H 'Sec-Fetch-Dest: document' \

-H 'Referer: https://www.zikao365.com/shiti/downlist_search.shtm' \

-H 'Accept-Language: zh-CN,zh;q=0.9,zh-TW;q=0.8,en-US;q=0.7,en;q=0.6' \

--data-raw 'KeyWord=%C2%ED%BF%CB%CB%BC%D6%F7%D2%E5&monthHidden=%C8%AB%B2%BF&month=&yearHidden=%C8%AB%B2%BF&year=' \

--compressed

留意一下倒数第二行 KeyWord=%C2%ED%BF%CB%CB%BC%D6%F7%D2%E5

结合浏览器抓包06了解到Keyword,这里其实就是上面搜索传递的内容啦!!!

3.如何传递分页

来到这里我们就能获取一页的列表数据了,那么获取第二页传递什么参数呢?点击 下一页 然后观察抓包情况

https://www.zikao365.com/shiti/downlist_search.shtm?page=2

如上,url 发生了一点点变化了,添加了一个参数page,也就是说page=2代表第2页

翻页也不成问题了,那就看看如何获取内部的下载链接吧~

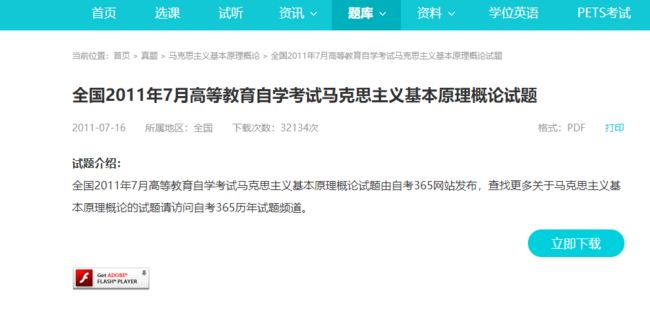

4.查找下载链接

随便点击一个链接进如试题详情页如下:

https://www.zikao365.com/shiti/download-427-16827.html

原本我打算高高兴兴的点击 “立即下载” 的,结果发现需要登录

真的是好事多磨啊~~

摆在眼前只有三条路

找女同学要一个账号,点击一下看看什么情况自己注册一个账号,但是太麻烦了- 尝试绕开登录验证,直接下载(很明显我选择第三种)

因为一般 超链接 点击了都是直接跳转的,如果没有直接跳转,那就说明禁用了 href 属性,并且重写onclick事件,带着这种前提意识打开 F12 > Elements 观察源码

OK~~ 来到这里对自考365的整体列表数据以及详情数据的下载文件都有了一个整体的了解,那就可以着手编码啦!!

代码实现较简单 我这里就全部贴出来

public static void main(String[] args) throws Exception {

HttpClient httpClient = HttpClient.buildHttpClient();

String urlTemplate = "https://www.zikao365.com/shiti/downlist_search.shtm?page=${page}&KeyWord=${KeyWord}";

String url = null;

for (int i = 1; i < 6; i++) {

// 第一页开始

url = urlTemplate.replace("${page}", i + "");

url = url.replace("${KeyWord}", "%C2%ED%BF%CB%CB%BC%D6%F7%D2%E5");

// 这里我竟然直接使用 GET 也是可以的 ( 我当时是忘记了抓包是 POST ,直接写了GET, 可以,那就更加方便了)

Request request = httpClient.buildRequest(url).GET();

Response<String> response = request.execute(BodyHandlers.ofString(Charset.forName("gbk")));

log.debug("response: [{}]", response.getBody());

// 把html解析为一个Document

Document document = Jsoup.parse(response.getBody());

// 获取每一页的试题超链接

Elements a = document.select(".bot.clearfix li > a");

List<String> hrefs = a.stream().map(v -> v.attr("href")).collect(Collectors.toList());

for (String href : hrefs) {

// 这里相当于点击进入具体的试题超链接

response = httpClient.buildRequest(href).execute(BodyHandlers.ofString(Charset.forName("gbk")));

String html = response.getBody();

// 解析每一个试题内部的document

document = Jsoup.parse(html);

// 获取当前试题的标题

String title = document.selectFirst(".main div > h1").text();

// 手动字符串切割获取文件的path

String[] scripts = StringUtils.substringsBetween(html, ", "");

String path = Arrays.stream(scripts).filter(v -> v.contains("addClick") && v.contains("path")).findFirst().get();

path = path.substring(path.indexOf("path") + 4);

path = path.replaceAll("'", "\"");// 这里是为了统一 ' 转为 " , 避免个别页面使用的是' 如: var path = 'http://download.zikao365.com/shiti/19158.pdf'

path = path.substring(path.indexOf("\"") + 1);

path = path.substring(0, path.indexOf("\""));

// 获取文件的后缀

String suffix = path.substring(path.lastIndexOf("."));

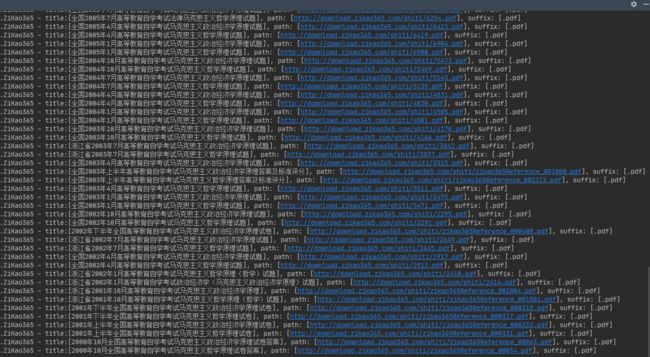

log.info("title:[{}], path: [{}], suffix: [{}]", title, path, suffix);

// 执行下载文件到本地目录

// 也可以使用 commons.io 的工具类下载, 如: FileUtils.copyURLToFile(new URL(path), Paths.get("C:\\Users\\houyu\\Desktop\\马克思主义", title + suffix).toFile());

httpClient.buildRequest(path).execute(BodyHandlers.ofFile(Paths.get("C:\\Users\\houyu\\Desktop\\马克思主义", title + suffix)));

}

}

}

说明:这里列举一下使用到几个类库或者工具类

-

HttpClient:基于HttpURLConnection封装超级好用的HttpClient (就一个java文件,内含丰富的好用的api)

-

commons-lang3:比较常用的工具包

-

jsoup:一个 java 版的 css selector,用起来就像吃甜品一样。

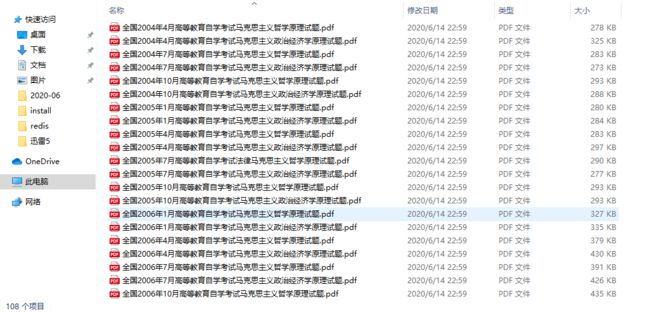

4. 下载

5. 最后

当我把这108个文件发给哪位那个女同学的时候…

你想学呀 我叫你呀,从此就可以有正当理由聊了呀,你是否遇到你这样子的女同学呢 ?

公众号:IT加载中(it_loading)

CSDN:https://blog.csdn.net/JinglongSource

博客:https://shaines.cn/

邮箱:[email protected]

程序员[ 后宇 ],是一个关注编程,热爱技术的Java后端开发者,热衷于 [ Java后端 ],[ 数据爬虫领域 ]。不定期分享 I T 技能和干货!!欢迎关注 “IT加载中”,一个只出 干货 和 实战 的公众号。