Spark伪分布式环境搭建

这里选择Scala-2.11.12.tgz + spark-2.3.2-bin-hadoop2.7.tgz

前提条件:

Ubuntu16.04

JDK1.8(Ubuntu环境下)

安装步骤:

1.下载安装包:

http://archive.apache.org/dist/spark/spark-2.3.2/

2.解压安装文件

$ mkdir ~/soft

$ tar -zxvf scala-2.11.12.tgz -C ~/soft

$ tar -zxvf spark-2.3.2-bin-hadoop2.7.tgz -C ~/soft

3. 建立软链接,方便使用

$ cd ~/soft

$ ln -s scala-2.11.12 scala

$ ln -s spark-2.3.2-bin-hadoop2.7 spark

4.配置环境变量

$ nano ~/.bashrc文件末尾添加以下内容:

export SCALA_HOME=~/soft/scala

export PATH=$PATH:$SCALA_HOME/bin

export SPARK_HOME=~/soft/spark

export PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin

让环境变量生效

$ source ~/.bashrc

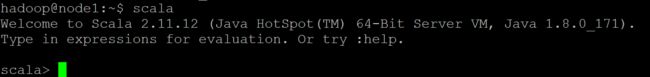

5. 测试Scala

查看Scala版本

$ scala -version进入Scala命令行

$ scala查看scala帮助:

scala> :help简单数学运算:

scala> 1+2

res0: Int = 3scala会自动推测出变量的类型,1和2都不用指定数字类型,结果的变量名自动为res0, 类型自动为Int

scala> println("l love scala!")

l love scala!退出Scala命令行

scala> :q

6.配置Spark

进入Spark conf目录,复制并重命名spark-env.sh.template、log4j.properties.template、slaves.template

$ cd spark/conf

$ cp spark-env.sh.template spark-env.sh

$ cp log4j.properties.template log4j.properties

$ cp slaves.template slaves修改spark-env.sh

export JAVA_HOME=/home/hadoop/soft/jdk #添加Java位置,注意按实际修改

export SCALA_HOME=/home/hadoop/soft/scala #添加Scala位置,注意按实际修改

export SPARK_MASTER_IP=node1 #设置主节点ip地址或主机名,注意按实际修改

export SPARK_WORKER_MEMORY=1024m #设置节点内存大小,此处为1024m。

export SPARK_WORKER_CORES=2 #设置节点参与计算的核心数

export SPARK_WORKER_INSTANCES=1 #设置节点实例数注意:

前三行要按照实际情况修改,例如: /home/<用户名>,我这里的用户名为hadoop,所以写/home/hadoop

第三行应该填写自己的IP,如果IP与主机名称已经映射过,也可以填写主机名称,例如:node1

修改slaves文件

# A Spark Worker will be started on each of the machines listed below.

#localhost

node1注意:如果IP与主机名已经映射过,可以填写node1,否者需要填写虚拟机的IP地址

6.1 配置PySpark使用python3作为编程语言

Ubuntu默认使用python2作为PySpark的编程语言,如果想将python3作为PySpark的编程语言时,需要进行此步骤,否则可以跳过此步骤。

添加python3相关环境变量

$ nano ~/.bashrc文件末尾添加如下语句

export PYTHONPATH=$SPARK_HOME/python:$SPARK_HOME/python/lib/py4j-0.10.7-src.zip:$PYTHONPATH

export PYSPARK_PYTHON=python3注意:py4j-0.10.7-src.zip要到$SPARK_HOME/python/lib目录查看是否是这个名称。不同版本的py4j的名称会有差别

保存后,让环境变量生效

$ source ~/.bashrc

7.启动Spark集群

进入到Spark按照目录下,执行sbin/目录下的启动命令

$ cd ~/soft/spark

$ sbin/start-all.sh

查看Spark进程,正确启动会有Master和Worker进程。

$ jps

1860 Jps

1669 Master

1773 Worker

8.WebUi访问

到浏览器地址栏输入ip:8080

9.关闭Spark集群

进入到Spark按照目录下,执行sbin/目录下的关闭命令

$ cd ~/soft/spark

$ sbin/stop-all.sh

完成!enjoy it!