Hadoop伪分布式搭建详细步骤

hadoop伪分布搭建流程

----------------------------

1.通过挂在上传软件至/home/hyxy/soft

$>cp jdk1.8.XXX.tar.gz ~/soft

$>cp hadoop.2.7.3.tar.gz ~/soft

2.解压相关软件

$>tar -zxvf jdk1.8.XXX.tar.gz

$>tar -zxvf hadoop.2.7.3.tar.gz

3.创建软连接

$>ln -s jdk1.8.0_121/ jdk

$>ln -s hadoop-2.7.3/ hadoop

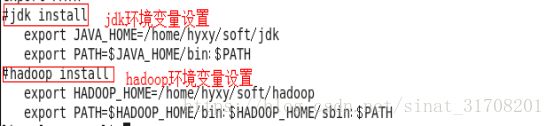

4.修改环境变量

$>cd ~

$>gedit .bash_profile

(.bash_profile在/home/用户名下)

在文件最后追加以下指令:

#jdk install

export JAVA_HOME=/home/hyxy/soft/jdk

export PATH=$JAVA_HOME/bin:$PATH

#hadoop install

export HADOOP_HOME=/home/hyxy/soft/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

$>source .bash_profile

注意:刷新完之后,当前回话可用;建议reboot(重启)

5.配置SSH

a.修改hostname

$>su root

$>gedit /etc/sysconfig/network

【HOSTNAME=master】

b.修改hosts文件

$>gedit /etc/hosts

【在文件后追加:ip 主机名:192.168.142.138 master】

c.reboot;

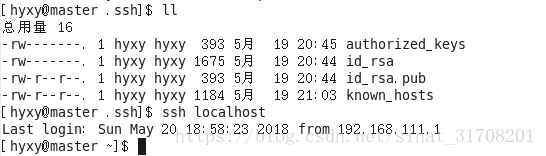

d.生成秘钥

$>ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

【说明:-t设置生成秘钥的算法,采用的rsa;-P设置密码,默认为空;-f设置秘钥生成的文件位置,~/.ssh】

e.生成认证库

$>cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

f.修改认证库的权限为600

$>chmod 600 ~/.ssh/authorized_keys

g.ssh master

//无密登录成功!!!!

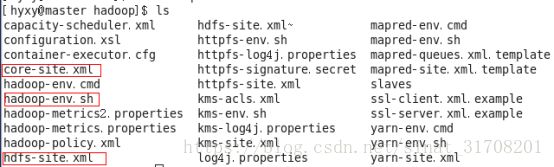

6.配置hadoop

a.找到hadoop的配置路径:cd $HADOOP_HOME/etc/hadoop

b.修改core-site.xml

c.修改hdfs-site.xml

d.修改hadoop-env.sh中的JAVA_HOME变量

【export JAVA_HOME=/home/hyxy/soft/jdk】

e.格式化HDFS

$>hdfs namenode -format

此处为0,证明没有错误

f.开启hadoop守护进程

$>start-dfs.sh //开启HDFS

开启后,查询jps,看是否namenode,datanode,secondarynamenode都启动了,一定要全部都启动!

注意:

①如果此时发现datanode没有启动,需要进入到tmp文件夹中,通常是在我们解压后的hadoop文件夹下,并进入到tmp/dfs/data下,data下的所有文件都要删除,删除后重新格式化,重新启动。

②当开启后出现stop it first时,则要先执行stop-dfs.sh的命令,再重新开启

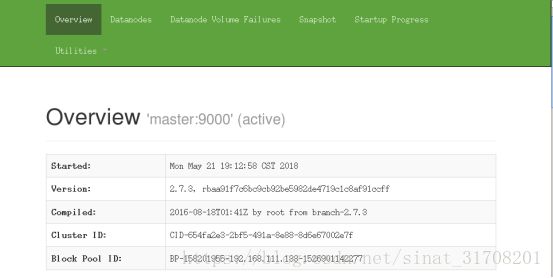

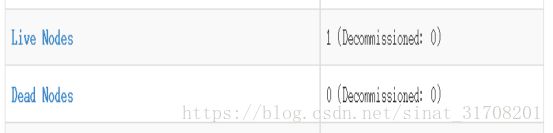

运行成功后在浏览器中输入 localhost:50070,进入下面的界面

我们会发现有一个节点存活,到此,我们的伪分布式就搭建成功啦!!!