【计算机视觉】Lecture 1:计算机视觉的介绍

http://www.cse.psu.edu/~rtc12/CSE486/

CSE/EE486 Computer Vision I

Introduction to Computer Vision

什么是视觉?

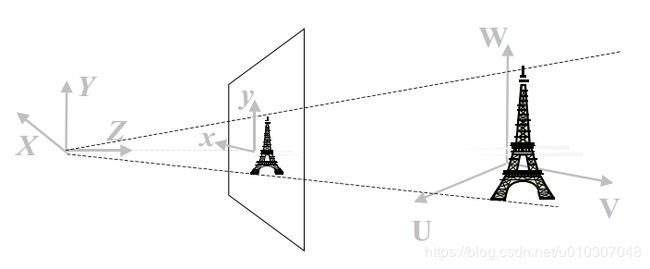

特别强调:三维世界和一个二维图像的联系。物体的位置和特征。

什么是计算机视觉?

与下列有关系,但不等同于:

摄影测量学

图像处理

人工智能

为什么要学习计算机视觉?

到处都有图像和视频

应用的快速积累

—从图片中建立三维世界的表示

—自动侦查(谁在干什么)

—视频后处理

—面部视觉

许多深层的有意思的科学秘密

人类视觉的更深理解

课程目的和目标

介绍计算机视觉基本的问题

介绍用来解决这些问题的主要概念和技术

是学生能够应用视觉算法

是学生理解视觉科学

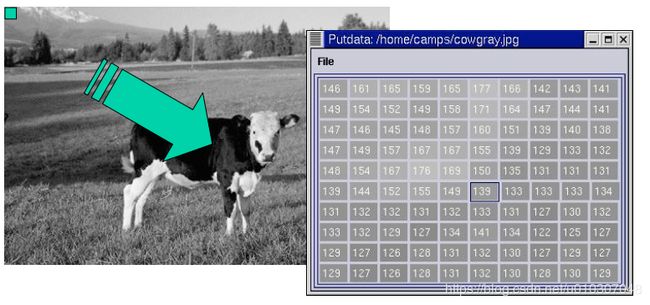

输入:数字图像

二维数组(矩阵)

加入彩色图像,我们有三个数组—红色,绿色,蓝色

为什么计算机视觉难?

我们尝试从一个数组推导出世界中的东西。

问题:太局部;缺少上下文;抽象级别的不匹配。但等等,甚至比这更糟糕…

假如我们已经知道几何关系,平面材料和光照情况,如何在每个像素上产生具体值就很好理解了。(这是计算机图形学)

但这些因素的交织造成了每个像素不容易分解。这个过程不能被颠倒。

告诉我们你从下面的图片中看到了什么

恭喜你!你做到了数学不能做到的事。

恭喜你!你做到了数学不能做到的事。

如何?你使用一些假设,这些假设是基于你对世界运作方式的之前的知识/经验。

从单张图片中恢复三维结构是数学上不能解决的问题。

所以我们不能只用匹配来解决这个问题。

所以我们不能只用匹配来解决这个问题。

好消息:使用数量超过一个的相机,我们能够回复三维机构!

例子:双目相机。

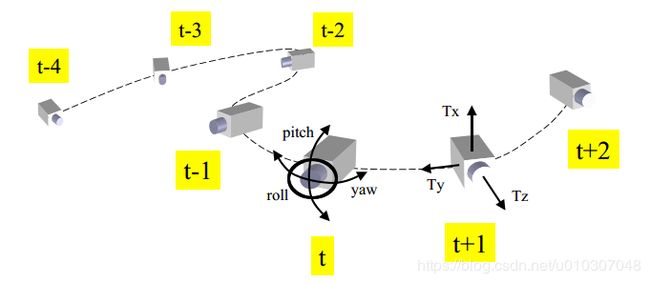

从运动中恢复结构(SfM)

假如我们移动一个相机尽量多,也能够推断三维结构。

所以多少是属于足够多的运动?这得看情况。

更多难题

观察的物体外观相对于观察点的变化

关照的影响

关照的影响

相对于关照强度和方向,观察物体的外观也会发生变化

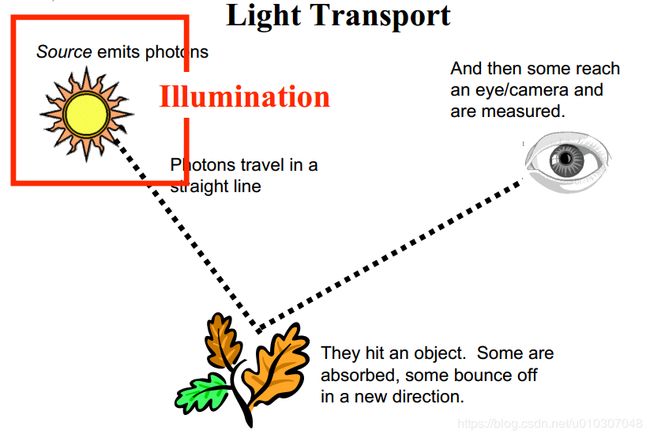

光度测定概述

源头发射光子,光子在一直线上传播,撞击到了物体。其中一些被吸收,一些从一个新的方向弹出。之后一些到达了人眼/相机,被测量。

光照

表面反射

表面反射

传感器响应

传感器响应

“红色”是什么意思?

“红色”是什么意思?

颜色感知是由三个因素组成的(光照,表面反射,传感器响应)

我们不能轻易地把我们在图像中看到的颜色作为推断光照和材质的因素(即使传感器特性是固定且已知的)

同样,这与人类的经验是背道而驰的。

感知:色彩恒常性

人类非常善于在不同的光照下识别相同的物质颜色。不清楚在一般情况下这是如何实现的。

同样,数学不能拯救我们。

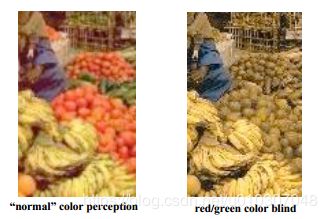

“红色”是什么意思?

颜色感知是由三个因素组成的(光照,表面反射,传感器响应)

思考一些事:

—“红色”一般表示“在白色灯光下人类观测器出现红色”

—在红色灯光下白色物体出现红色

—如果你是红/绿色盲,没有什么东西看起来是红色的

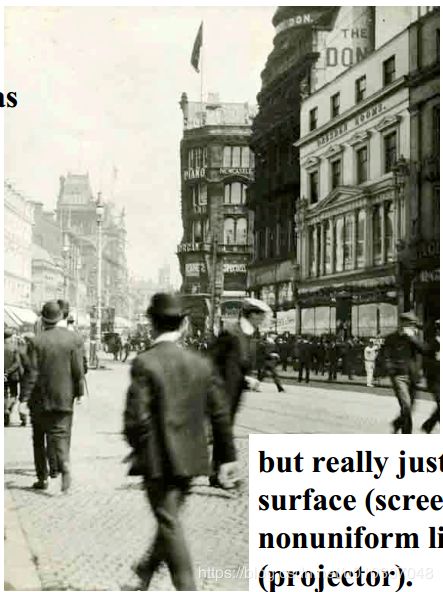

这被视为三维场景,但实际上这只是一个在非均匀光照(投影仪)下的平面(屏幕)。

这被视为三维场景,但实际上这只是一个在非均匀光照(投影仪)下的平面(屏幕)。

我们将在这门课上学到什么…举几个例子说明。

特征提取

图像求导

图像求导

梯度操作

DoG/LoG操作

Harris角提取

为什么?寻找更多的唯一描述符(相比于像素)进行匹配

应用:皮肤检测

皮肤检测已经被用于基于成人内容识别的网页过滤

投影模型

内参(镜头)

外参(位姿)

相机校准

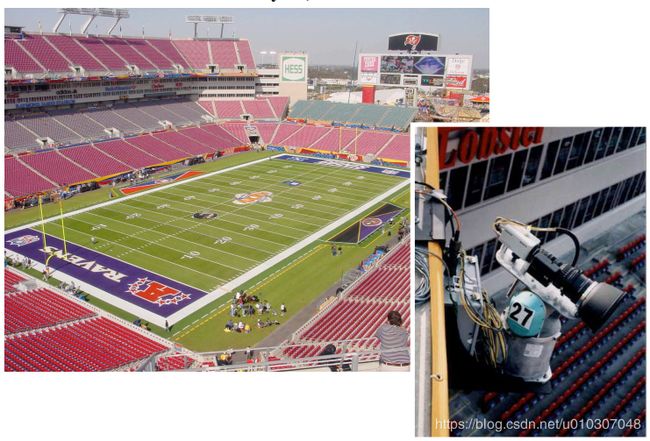

应用:鹰眼系统

相机校准!

鹰眼系统:超级碗XXXV 2001.1.28

鹰眼系统:超级碗XXXV 2001.1.28

鹰眼例子

鹰眼例子

鹰眼系统:超级碗XXXV 2001.1.28 哥伦比亚广播公司体育频道提供

鹰眼系统:超级碗XXXV 2001.1.28 哥伦比亚广播公司体育频道提供

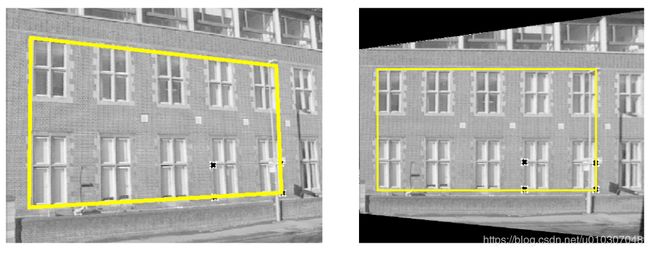

平面到平面映射

刚性,相似,放射,投影映射

刚性,相似,放射,投影映射

单应估计

图像变形

例子:虚拟现实

立体视觉

立体视觉

立体相机设置

立体视差

极线几何

对应匹配

三角化/深度恢复

相机运动

运动场vs光流

光流估计

自我运动估计

从运动恢复结构

应用:匹配移动

通过一个视频序列跟踪一系列特征点

推断摄像机的位置和被跟踪点的三维位置

根据导出的场景/相机三维几何来合成物体

视频变换检测 (Video Change Detection)

视频流

背景建模

变换检测

应用:视频监控

移动人和车的自动检测,分类和跟踪

移动人和车的自动检测,分类和跟踪

根据三维校园模型确定目标位置

单个操作员可以监控分布在一个大范围场景中的多个传感器的结果

自动监控

用于检测运动和检测朝错误方向运动的触发区域。这些都是被很好地“解决”的问题  视频跟踪 (Video Tracking)

视频跟踪 (Video Tracking)

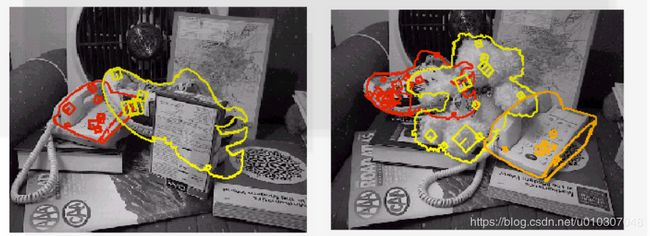

基于外观的跟踪

样本跟踪算法

目标识别 (Object Recognition)

模型库

模型匹配 (使用Lowe’s SIFT)

方法:PCA; Sift Keys; boosted cascade of detectors

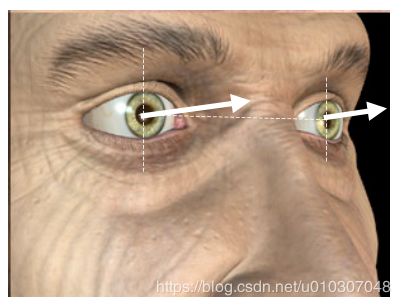

应用:脸/眼检测

找到交互的用户

找到交互的用户

从相片中去掉红眼

疲劳驾驶检测

提醒…

“视觉是一种通过观察了解事物在哪里的行为” ("Vision is the act of knowing what is where by looking.” ) --亚里士多德