Improved Disease Classification in Chest X-Rays with Transferred Features from Report Generation论文解读

Improved Disease Classification in Chest X-Rays with Transferred Features from Report Generation

从文本生成器的转移特征提升胸部X光的疾病分类表现

首先在小型胸部X射线数据集(IU)上训练报告生成网络,然后将学习的视觉特征传输到在大型数据集(ChestX-ray14)上训练分类网络,并使用新颖的注意力引导特征融合策略来提高检测性能14种常见胸部疾病。

通过学习不同类型的特征表示之间的对应关系,由报告生成和分类模型学习的共同特征被赋予更高的注意力权重,并且不改变任何已经学习到的特征。

贡献:

- 加权的视觉特征提高了胸部疾病分类网络的性能。

- 证明了使用小数据集上学习到的视觉表示来补充在另一个大数据集上学到的特征是可行的,不同的任务来提高模型的性能。

做法:不同于传统迁移学习(大->小),而是先在小数据集上训练文本生成模型,之后在大数据集上,使用融合特征进行疾病分类模型训练。 ----医学图像上的迁移学习

文本生成特征+分类网络特征得到attention map,之后融合初始特征再进行训练。

模型概览:

使用NLP+CV的分层结构

- 放射报告生成模型

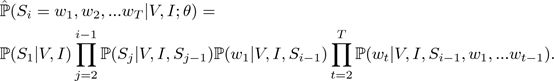

对于长度为T的第i个句子,估计的概率可表示为:

Image Encode:使用ResNet152的最后一层卷积得到attention map的局域特征(2048*7*7,49个),最后一个平均池化层取全局特征àimage encode

上半部分:报告生成器首先将正面视图图像作为输入并通过CNN-RNN模型,然后使用双向长短期存储器(Bi-LSTM)作为主题编码器以产生全局主题向量。

下半部分:句子解码器采用区域视觉特征和主题向量来生成第一个句子。之后,通过将区域视觉特征,先前生成的句子和主题向量作为多模式输入来生成每个句子。

训练细节:由Adam优化器训练。 初始学习率设置为1e-4,并且每5个时期学习率衰减为0.5。 批量大小为32,采用贪婪搜索在每个时间步长中生成单词和句子。最大句子数设置为7.分开训练Iimpression decoder和sentence decoder。

- 胸部疾病分类以及注意力主导的特征融合过程

不变操作:

训练两种不同的基线分类模型以获得视觉特征。ResNet-18模型和DenseNet-121模型。,最终完全连接的层被替换为具有14个输出的14个疾病类别。通过最小化二元交叉熵损失来完成训练。使用ImageNet上预训练的模型的权重初始化网络的权重。

特殊操作:

丢弃包括最终汇集层,最终完全连接层和Sigmoid的转换块,以仅保留局部视觉特征。然后在分类数据集上运行报告生成器的图像编码器。将提取的局部视觉特征和来自分类网络的本地视觉特征两者馈送到特征关注模块中:

特征归一化:

之后将注意力权重应用于从分类网络学习的原始视觉特征。融合两种特征并重新训练最后几层以获得新的分类预测。

特征注意模块可以发现在两个独立的任务上训练的特征之间的对应关系,并且更多地强调在两个表示中共存的特征,获得更高的分类准确度,而无需重新训练特征提取模型。

3. 实验结果

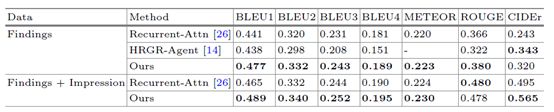

文本生成网络:

使用BLEU,METEOR,ROUGE和CIDEr指标评估

由于放射学报告的语料库与其他文本语料库不同,CIDEr未提高。

说明我们的报告生成模型能够通过图像编码器学习有意义的特征

疾病分类网络:

14种疾病类别的ROC曲线的AUC的比较。 R18和D121分别代表ResNet-18和DenseNet-121基线模型。

在特征融合期间,由报告生成器的图像编码器和原始分类模型学习的所有视觉特征是固定的,以确保改进不是来自模型的重新训练而是更好的利用了已经学习到的特征。。

具有转移特征和注意力引导特征融合的ResNet-18模型在几乎所有除Mass之外的疾病上都大大优于基线ResNet-18分类模型

CheXNet除了心脏扩大和疝气之外的12种疾病的明显改善

DenseNet-121模型在14个类别中的11个中获得了最高的AUC分数,并且在所有方法中具有最高的平均AUC分数

实验结果表明,报告生成器中的图像编码器确实在训练过程中学到了有意义的特征,并且注意力模块引导的特征融合能够通过更好地利用多任务特征来改进分类结果。

总结:

- 报告生成模型首先在小胸部X射线数据集上进行训练,并由放射科医师提供书面报告,然后将学习的视觉表示转移到具有多种疾病的较大胸部X射线数据集中,这些特征能在注意力模块下进行加权。成功地改进了疾病分类结果,

- 针对不同任务在不同数据集上学习特征的迁移和注意引导特征融合可以提高模型性能,即使在大型数据集上也是如此。通过以互补的方式利用来自不同领域或任务的特征表示,这种特征转移和融合模型具有巨大的潜力,并且可以扩展到训练数据有限的其他医学成像应用,以推广原始模型并增强性能。